多模态提示工程:让AI理解更全面、更深入

引言

背景:从“单模态孤岛”到“多模态交互”的AI革命

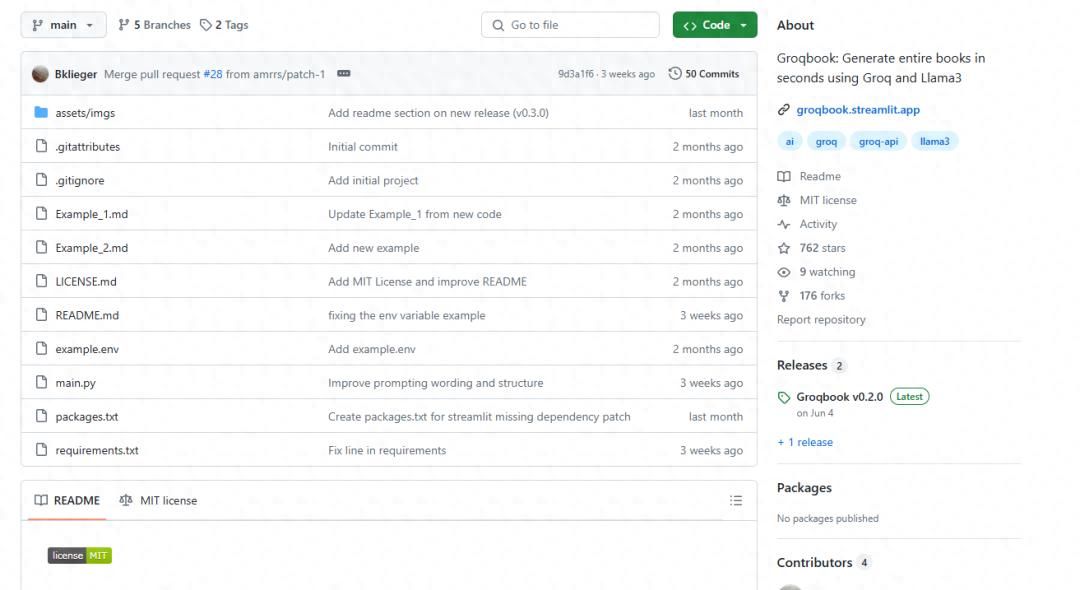

2023年3月,OpenAI发布GPT-4,首次公开支持图像输入;同年12月,Google Gemini Pro宣布“原生支持文本、图像、音频、视频、代码的理解与生成”;2024年,Anthropic Claude 3、Meta Llama 3等模型相继跟进——多模态能力已成为AI大模型的核心竞争力。

这一转变背后,是人类认知方式的启示:我们从未仅依赖单一感官理解世界。看到一张“雨天咖啡馆”的照片时,大脑会自动关联“雨声”的听觉记忆、“咖啡香”的嗅觉想象、“温暖氛围”的情感体验,这种跨感官的信息融合,正是人类认知的底层逻辑。AI要实现真正的“智能”,必然需要突破“文本仅能理解文本、图像仅能理解图像”的单模态孤岛,走向多模态融合。

但多模态能力的释放,并非简单将不同模态数据“喂给”模型即可。例如,给GPT-4V输入一张复杂电路图并提问“这个电路的核心故障点可能在哪里”,若仅输入图像而无任何文本提示,模型可能返回泛泛而谈的描述;若补充“请结合电路原理分析电容C3与电阻R5的连接关系,判断是否存在短路风险”,则能引导模型聚焦关键元件,输出精准结论。这就是多模态提示工程的价值——通过精心设计的提示,让AI“听懂”不同模态数据的“语言”,并将它们有机融合,实现更全面、更深入的理解。

核心问题:多模态提示工程,究竟在解决什么?

多模态提示工程(Multimodal Prompt Engineering)是指针对多模态AI模型,通过设计包含文本、图像、音频等多种模态信息的提示,引导模型完成跨模态理解、推理或生成任务的技术。与传统单模态提示工程(如纯文本提示)相比,它面临三个独特挑战:

模态“语言不通”:文本是离散符号序列(如“红色”),图像是像素矩阵(如RGB值),音频是波形信号(如频率/振幅),不同模态的“语法”和“语义”差异巨大。如何让提示成为“翻译官”,帮助模型建立模态间的关联?

信息“过载与缺失”:多模态数据常包含冗余信息(如图像中的背景噪声)和关键缺失(如医学影像中肉眼不可见的病灶)。如何通过提示“过滤噪声、补充上下文”,引导模型已关注核心信息?

推理“跨模态跳跃”:复杂任务(如“根据历史照片和新闻报道,还原某事件的时间线”)需要模型在不同模态间多次跳转推理。如何设计提示让模型“按步骤思考”,避免推理断层?

这些问题的本质,是如何通过提示优化多模态数据的“输入-理解-输出”链路。本文将从基础概念出发,深入剖析多模态提示工程的技术原理、设计策略、实践案例,并探讨其未来发展方向,帮助读者掌握让AI“打通多感官”的核心方法。

文章脉络:从原理到实践的完整指南

本文将围绕以下脉络展开:

基础概念:明确多模态、提示工程、多模态提示工程的定义,对比单模态与多模态提示的差异,梳理多模态AI与提示工程的发展历程。

核心原理:解析多模态提示的技术基础,包括模态融合机制、提示与模型交互原理、跨模态对齐技术,并结合主流模型(如GPT-4V、Gemini)的架构细节展开。

设计策略:总结多模态提示的设计原则、关键技术(如模态标识、跨模态引用),并提供不同任务(图像描述、视觉问答、跨模态推理等)的提示模板与示例。

实践案例:通过计算机视觉、医疗健康、自动驾驶等领域的真实案例,展示多模态提示工程的应用方法与效果对比。

挑战与未来:分析当前多模态提示工程面临的技术瓶颈(如模态异质性、语义鸿沟),并展望自适应提示、多模态微调等未来趋势。

无论你是AI应用开发者、研究者,还是对多模态交互感兴趣的技术爱好者,本文都将为你提供从“理解”到“落地”的完整知识体系。

一、基础概念:多模态提示工程的核心定义与发展

1.1 从“模态”到“多模态”:信息的表现形式与融合

1.1.1 什么是“模态”?

“模态”(Modality)是信息的表现形式,源于人类感知世界的方式——我们通过视觉(图像、视频)、听觉(音频、语音)、触觉(温度、压力)等感官获取信息,每种感官对应一种“模态”。在AI领域,模态被泛化为数据的类型或载体,常见模态包括:

文本模态:离散符号序列,如自然语言句子、代码片段、表格数据(本质是结构化文本)。

视觉模态:连续像素/向量数据,如图像(静态视觉)、视频(动态视觉,含时间维度)、3D点云(空间视觉)。

听觉模态:声波信号,如语音(含语义的音频)、环境音(如汽车鸣笛、雨声)、音乐(含旋律/节奏的音频)。

其他模态:触觉(如压力传感器数据)、嗅觉(如气体传感器数据)、传感器数据(如雷达、LiDAR信号)等。

1.1.2 什么是“多模态”?

“多模态”(Multimodal)指同时涉及两种或以上模态的信息处理。例如:

社交媒体帖子(文本+图像)、视频会议(视频+音频+文本字幕)、自动驾驶系统(摄像头图像+雷达信号+激光雷达点云)。

多模态数据的核心特点是信息互补性:不同模态从不同角度描述同一事物,共同构成完整认知。例如,“火灾现场”的图像能展示烟雾和火焰的视觉特征,音频能传递警报声和人群呼喊,文本报道能补充火灾原因和伤亡情况——单独依赖任一模态,都可能导致理解偏差(如图像可能被误判为“舞台特效”,音频可能被误判为“电影音效”)。

1.1.3 多模态AI:从“单任务处理”到“通用理解”

多模态AI是指能接收、处理、输出多模态数据的人工智能系统。其发展可分为三个阶段:

| 阶段 | 时间 | 技术特点 | 代表模型 |

|---|---|---|---|

| 早期融合 | 2010-2018 | 针对特定任务设计融合规则(如特征拼接),模态间交互弱 | VQA(视觉问答,2015)、ImageCaptioning(图像描述,2017) |

| 深度融合 | 2018-2022 | 基于注意力机制实现模态间动态交互,支持跨模态理解 | CLIP(2021,图文对齐)、ALBEF(2021,图文双向融合) |

| 通用融合 | 2022至今 | 大语言模型(LLM)为核心,支持文本、图像、音频等多模态统一理解与生成 | GPT-4V(2023)、Gemini(2023)、Claude 3(2024) |

通用融合阶段的突破在于:模型不再依赖“任务专用架构”,而是通过“统一编码器”将不同模态数据映射到同一语义空间,再通过“提示”引导模型完成各类任务。例如,GPT-4V可接收“图像+文本”输入,既能回答“图中有几只猫”(视觉问答),也能生成“根据图中场景写一首诗”(跨模态生成)——这一能力的实现,离不开多模态提示工程的支持。

1.2 提示工程:从“指令”到“对话”的AI引导艺术

1.2.1 提示工程的定义与核心价值

“提示工程”(Prompt Engineering)是指通过设计输入文本(或其他模态信息),引导AI模型输出期望结果的技术。其本质是**“不修改模型参数,仅优化输入”的模型调优方法**。

在单模态(如纯文本)场景中,提示工程已被证明能显著提升模型效果:例如,给GPT-3输入“写一篇关于环保的文章”,输出可能泛泛而谈;而补充“目标读者是中学生,用3个生活案例(如垃圾分类、节水、低碳出行)说明环保的重要性,语言口语化”,则能得到更精准的内容。

1.2.2 单模态提示 vs 多模态提示:差异与挑战

多模态提示工程是提示工程在多模态场景的延伸,但与单模态提示存在本质区别:

| 维度 | 单模态提示(以文本为例) | 多模态提示 |

|---|---|---|

| 输入形式 | 仅文本(离散符号) | 文本+图像/音频/视频等(混合离散+连续数据) |

暂无评论内容