搜索领域新宠儿:全文检索深度剖析

关键词:全文检索、倒排索引、分词算法、查询处理、相关性排序、搜索引擎、信息检索

摘要:本文深入探讨全文检索技术的核心原理和实现细节。从基础的倒排索引结构出发,详细分析分词算法、查询处理流程和相关性排序机制。通过Python代码示例展示核心算法实现,并结合数学模型解释相关性评分公式。文章还涵盖实际应用场景、工具推荐以及未来发展趋势,为开发者提供全面的全文检索技术指南。

1. 背景介绍

1.1 目的和范围

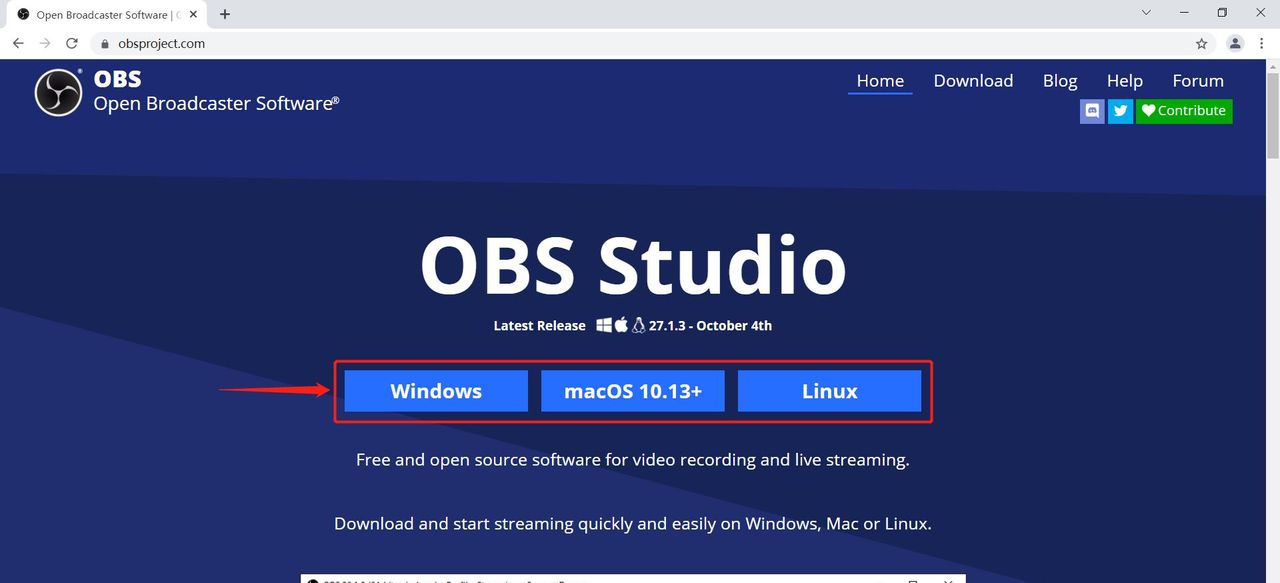

本文旨在系统性地介绍全文检索技术的核心原理、实现方法和最佳实践。内容涵盖从基础概念到高级算法,从理论模型到实际应用的全方位解析。

1.2 预期读者

搜索相关领域的开发工程师

对信息检索技术感兴趣的研究人员

需要构建搜索功能的全栈开发者

希望深入理解搜索引擎原理的技术爱好者

1.3 文档结构概述

文章首先介绍全文检索的基本概念和核心组件,然后深入解析关键技术原理,接着通过代码示例展示具体实现,最后讨论应用场景和未来趋势。

1.4 术语表

1.4.1 核心术语定义

全文检索(Full-Text Search):在文本数据集合中快速查找包含特定词语或短语的文档的技术

倒排索引(Inverted Index):将文档中的词语映射到包含该词语的文档列表的数据结构

分词(Tokenization):将连续文本分割为有意义的词语单元的过程

1.4.2 相关概念解释

词项(Term):索引和搜索的基本单元,通常是经过标准化处理的词语

文档(Document):检索的基本单位,可以是网页、文章或任何包含文本的数据单元

相关性(Relevance):衡量查询与文档匹配程度的指标

1.4.3 缩略词列表

TF-IDF:词频-逆文档频率(Term Frequency-Inverse Document Frequency)

BM25:Okapi BM25排名算法

NLP:自然语言处理(Natural Language Processing)

2. 核心概念与联系

全文检索系统的核心架构如下图所示:

2.1 倒排索引结构

倒排索引是全文检索的核心数据结构,它将文档中的词项映射到包含该词项的文档列表。基本结构如下:

"apple" -> [doc1, doc3, doc5]

"banana" -> [doc2, doc4]

"orange" -> [doc1, doc2, doc5]

2.2 全文检索流程

索引阶段:

文档采集

文本预处理

分词和词项标准化

构建倒排索引

查询阶段:

查询解析

查询扩展和重写

索引检索

结果排序

结果呈现

3. 核心算法原理 & 具体操作步骤

3.1 倒排索引构建算法

import re

from collections import defaultdict

def build_inverted_index(documents):

"""

构建倒排索引的简单实现

:param documents: 文档字典,格式为 {doc_id: text}

:return: 倒排索引字典

"""

inverted_index = defaultdict(list)

for doc_id, text in documents.items():

# 简单的分词处理

words = re.findall(r'w+', text.lower())

for word in set(words): # 使用set去除重复词项

inverted_index[word].append(doc_id)

return dict(inverted_index)

# 示例文档集合

docs = {

1: "Apple orange apple juice",

2: "Banana orange smoothie",

3: "Apple pie recipe",

4: "Banana bread recipe",

5: "Orange juice and apple"

}

index = build_inverted_index(docs)

print(index)

3.2 布尔查询处理算法

def boolean_search(query, inverted_index):

"""

布尔查询处理实现(支持AND, OR, NOT)

:param query: 查询字符串,如 "apple AND orange"

:param inverted_index: 倒排索引

:return: 匹配的文档ID列表

"""

# 简单的查询解析

tokens = query.lower().split()

stack = []

operators = []

# 处理查询中的运算符和操作数

for token in tokens:

if token in ('and', 'or', 'not'):

operators.append(token)

else:

stack.append(set(inverted_index.get(token, [])))

# 如果没有运算符,返回第一个词项的结果

if not operators:

return list(stack[0]) if stack else []

# 处理运算符

result = stack[0]

for i, op in enumerate(operators):

if op == 'and':

result = result & stack[i+1]

elif op == 'or':

result = result | stack[i+1]

elif op == 'not':

result = result - stack[i+1]

return list(result)

# 示例查询

query = "apple AND orange"

results = boolean_search(query, index)

print(f"Results for '{

query}': {

results}")

4. 数学模型和公式 & 详细讲解 & 举例说明

4.1 TF-IDF 模型

TF-IDF (Term Frequency-Inverse Document Frequency) 是衡量词项在文档中重要性的经典算法。

tf-idf ( t , d , D ) = tf ( t , d ) × idf ( t , D ) ext{tf-idf}(t,d,D) = ext{tf}(t,d) imes ext{idf}(t,D) tf-idf(t,d,D)=tf(t,d)×idf(t,D)

其中:

$ ext{tf}(t,d) $ 是词项 $ t $ 在文档 $ d $ 中的词频

$ ext{idf}(t,D) $ 是词项 $ t $ 在整个文档集合 $ D $ 中的逆文档频率

idf ( t , D ) = log N ∣ { d ∈ D : t ∈ d } ∣ ext{idf}(t,D) = log frac{N}{|{d in D: t in d}|} idf(t,D)=log∣{

d∈D:t∈d}∣N

其中 $ N $ 是文档集合中的文档总数。

4.2 BM25 排名算法

BM25 是更先进的排名函数,考虑了文档长度和词项频率的非线性关系。

BM25 ( D , Q ) = ∑ i = 1 n IDF ( q i ) ⋅ f ( q i , D ) ⋅ ( k 1 + 1 ) f ( q i , D ) + k 1 ⋅ ( 1 − b + b ⋅ ∣ D ∣ avgdl ) ext{BM25}(D,Q) = sum_{i=1}^{n} ext{IDF}(q_i) cdot frac{f(q_i, D) cdot (k_1 + 1)}{f(q_i, D) + k_1 cdot (1 – b + b cdot frac{|D|}{ ext{avgdl}})} BM25(D,Q)=i=1∑nIDF(qi)⋅f(qi,D)+k1⋅(1−b+b⋅avgdl∣D∣)f(qi,D)⋅(k1+1)

其中:

$ Q $ 是查询,包含词项 $ q_1 $ 到 $ q_n $

$ f(q_i, D) $ 是词项 $ q_i $ 在文档 $ D $ 中的词频

$ |D| $ 是文档 $ D $ 的长度(词项数)

$ ext{avgdl} $ 是文档集合的平均长度

$ k_1 $ 和 $ b $ 是自由参数,通常 $ k_1 in [1.2, 2.0] , , , b = 0.75 $

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

# 创建Python虚拟环境

python -m venv search_env

source search_env/bin/activate # Linux/Mac

search_envScriptsactivate # Windows

# 安装必要库

pip install numpy nltk scikit-learn

5.2 基于TF-IDF的检索系统实现

import math

from collections import defaultdict

import nltk

from nltk.tokenize import word_tokenize

from nltk.corpus import stopwords

nltk.download('punkt')

nltk.download('stopwords')

class SimpleSearchEngine:

def __init__(self):

self.documents = {

}

self.inverted_index = defaultdict(dict)

self.doc_lengths = {

}

self.avg_doc_length = 0

self.stop_words = set(stopwords.words('english'))

def add_document(self, doc_id, text):

"""添加文档到搜索引擎"""

self.documents[doc_id] = text

# 分词和处理

tokens = word_tokenize(text.lower())

tokens = [t for t in tokens if t.isalpha() and t not in self.stop_words]

# 更新倒排索引和文档长度

self.doc_lengths[doc_id] = len(tokens)

term_freq = defaultdict(int)

for token in tokens:

term_freq[token] += 1

for term, freq in term_freq.items():

self.inverted_index[term][doc_id] = freq

# 更新平均文档长度

total_length = sum(self.doc_lengths.values())

self.avg_doc_length = total_length / len(self.documents)

def tf_idf_score(self, query):

"""计算TF-IDF相关性分数"""

query_terms = word_tokenize(query.lower())

query_terms = [t for t in query_terms if t.isalpha() and t not in self.stop_words]

scores = defaultdict(float)

N = len(self.documents)

for term in query_terms:

if term not in self.inverted_index:

continue

# 计算IDF

df = len(self.inverted_index[term])

idf = math.log(N / df)

# 计算TF-IDF

for doc_id, tf in self.inverted_index[term].items():

tf_idf = (1 + math.log(tf)) * idf

scores[doc_id] += tf_idf

return sorted(scores.items(), key=lambda x: x[1], reverse=True)

def bm25_score(self, query, k1=1.5, b=0.75):

"""计算BM25相关性分数"""

query_terms = word_tokenize(query.lower())

query_terms = [t for t in query_terms if t.isalpha() and t not in self.stop_words]

scores = defaultdict(float)

N = len(self.documents)

for term in query_terms:

if term not in self.inverted_index:

continue

# 计算IDF

df = len(self.inverted_index[term])

idf = math.log((N - df + 0.5) / (df + 0.5) + 1)

# 计算BM25组件

for doc_id, tf in self.inverted_index[term].items():

doc_length = self.doc_lengths[doc_id]

numerator = tf * (k1 + 1)

denominator = tf + k1 * (1 - b + b * (doc_length / self.avg_doc_length))

scores[doc_id] += idf * (numerator / denominator)

return sorted(scores.items(), key=lambda x: x[1], reverse=True)

# 使用示例

engine = SimpleSearchEngine()

engine.add_document(1, "Apple releases new iPhone with advanced camera features")

engine.add_document(2, "Samsung unveils new Galaxy smartphone with 108MP camera")

engine.add_document(3, "Camera technology advancements in modern smartphones")

engine.add_document(4, "Apple and Samsung dominate the smartphone market")

query = "Apple camera"

print("TF-IDF Scores:", engine.tf_idf_score(query))

print("BM25 Scores:", engine.bm25_score(query))

5.3 代码解读与分析

文档处理:

使用NLTK进行分词和停用词过滤

计算每个词项在文档中的频率

构建倒排索引结构

TF-IDF实现:

词频(TF)使用对数缩放:$ 1 + log( ext{tf}) $

逆文档频率(IDF)使用标准对数公式

最终分数是查询中所有词项的TF-IDF之和

BM25实现:

使用改进的IDF计算

考虑了文档长度归一化

参数k1控制词频饱和度,b控制长度归一化程度

6. 实际应用场景

6.1 企业文档搜索

公司内部知识库检索

合同和法律文档搜索

技术文档和API参考搜索

6.2 电子商务

产品搜索和过滤

商品属性检索

多语言搜索支持

6.3 内容管理系统

新闻网站文章检索

博客平台内容搜索

多媒体内容元数据搜索

6.4 专业领域搜索

医学文献检索

专利数据库搜索

学术论文检索系统

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

《信息检索导论》- Christopher D. Manning

《搜索引擎:信息检索实践》- Bruce Croft

《相关性:信息科学与认知科学视角》- Cosijn & Ingwersen

7.1.2 在线课程

斯坦福大学”信息检索与网页搜索”课程

Coursera上的”文本检索与搜索引擎”专项课程

Udemy的”Elasticsearch完整指南”

7.1.3 技术博客和网站

Elastic官方博客

Lucene/Solr官方文档

Google Research的搜索技术博客

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

JetBrains IntelliJ IDEA (支持Elasticsearch插件)

VS Code (有丰富的搜索相关扩展)

Eclipse (适合Lucene开发)

7.2.2 调试和性能分析工具

Elasticsearch Head插件

Kibana开发工具

Solr Admin界面

7.2.3 相关框架和库

Apache Lucene (Java)

Elasticsearch (分布式搜索)

Solr (企业搜索平台)

Whoosh (Python)

Tantivy (Rust)

7.3 相关论文著作推荐

7.3.1 经典论文

“The Anatomy of a Large-Scale Hypertextual Web Search Engine” – Brin & Page (Google)

“Probabilistic Models of Information Retrieval” – Robertson & Jones

“A Probabilistic Approach to Information Retrieval” – Ponte & Croft

7.3.2 最新研究成果

BERT在信息检索中的应用

神经信息检索模型

多模态搜索技术

7.3.3 应用案例分析

Wikipedia搜索架构

Amazon产品搜索系统

LinkedIn人才搜索技术

8. 总结:未来发展趋势与挑战

8.1 发展趋势

神经搜索技术:基于深度学习的语义搜索逐渐成熟

多模态搜索:结合文本、图像、视频等多种媒体类型的统一搜索

实时搜索:对流式数据的即时索引和检索

个性化搜索:基于用户画像和行为数据的个性化结果排序

边缘搜索:在边缘设备上实现轻量级搜索功能

8.2 技术挑战

语义理解:准确理解查询意图和文档含义

多语言处理:跨语言搜索和混合语言查询

可解释性:让用户理解为什么特定结果被返回

偏见和公平性:避免搜索结果中的偏见和不公平

隐私保护:在保护用户隐私的同时提供精准搜索

9. 附录:常见问题与解答

Q1: 倒排索引和正排索引有什么区别?

A1: 正排索引是从文档到词项的映射(文档→词项列表),而倒排索引是从词项到文档的映射(词项→文档列表)。倒排索引更适合搜索场景,因为可以快速找到包含特定词项的文档。

Q2: 为什么BM25比TF-IDF更好?

A2: BM25考虑了文档长度归一化和词频的非线性增长,能更好地处理长文档和短文档的差异,以及高频词项的饱和问题,通常能提供更相关的排序结果。

Q3: 如何处理中文分词的特殊性?

A3: 中文分词需要专门的算法和词典,常用方法包括:

基于词典的最大匹配法

基于统计的HMM/CRF模型

基于深度学习的BiLSTM-CRF模型

使用专业分词工具如jieba、HanLP等

Q4: 如何提高搜索系统的性能?

A4: 可以从多个方面优化:

索引优化:分片、压缩、缓存

查询优化:布尔查询简化、缓存热门查询

硬件优化:SSD、内存分配

算法优化:近似搜索、提前终止

10. 扩展阅读 & 参考资料

Apache Lucene官方文档

Elasticsearch: The Definitive Guide

Solr官方参考指南

Google搜索质量评估指南

微软Bing搜索技术博客

暂无评论内容