简介

AI与机器学习技术正以惊人的速度在移动开发领域深入集成,设备端AI能力爆发与AI辅助开发工具的崛起,为开发者带来了前所未有的高效开发体验和应用创新机遇。本文将全面解析Google最新AI技术栈(包括ML Kit 2.0和Gemini Nano模型)的特性与应用场景,探索Android Studio Bot与AICore系统服务的集成方法与最佳实践,并提供从零开始的代码实战示例,帮助开发者掌握这些前沿技术,构建更智能、更高效的应用程序。

一、设备端AI能力爆发:ML Kit 2.0与Gemini Nano模型

Google ML Kit 2.0作为机器学习套件的最新版本,专注于在设备端提供强大的AI能力,而无需依赖云端服务。ML Kit 2.0通过优化模型大小和推理速度,实现了在移动设备上实时处理复杂任务的能力。该版本移除了相机核心库和条码扫描的ViewfinderView,改为依赖更高效的CameraScan库,同时优化了扫描分析过程的性能体验,确保在低端设备上也能流畅运行。ML Kit 2.0支持多平台(Android和iOS),并提供了详尽的中文文档,为国内开发者扫除了语言障碍。

在图像处理领域,ML Kit 2.0引入了主题分割(Subject Segmentation)功能,可实时区分图片中的主体与背景,为应用开发提供了强大的视觉处理基础。该功能特别适用于虚拟背景替换、人像着色、魔法天空等场景,开发者可通过以下代码快速实现:

val segmenter = ImageSegmenter.create(clientOptions)

val mask = segmenter.process(bitmap).getMask()

Canvas(composeView).drawBitmap(mask, 0f, 0f, null)

然而,ML Kit 2.0并未直接支持实时视频抠图功能,这与用户提供的代码片段存在差异。经过调研发现,华为的ML Kit图像分割服务确实支持视频流处理和端侧实时抠图,但属于华为生态,与Google ML Kit无关。对于实时视频抠图需求,Google开发者应转向MediaPipe的Selfie Segmentation模块,该模块专为移动端设计,可在Pixel设备上实现高质量的实时视频分割,且支持不同画质素材的匹配处理能力。

在文本处理方面,Google的Gemini Nano模型提供了革命性的端侧能力。Gemini Nano是Google专为设备端任务设计的最高效模型,可在支持AICore的Android设备上实现离线文本摘要、智能回复、校对等功能,无需依赖网络连接,同时保障用户数据隐私。根据官方资料,Gemini Nano有两种版本:Nano-1(18亿参数)和Nano-2(32.5亿参数),分别针对低内存和高内存设备进行优化。通过AI Edge SDK,开发者可轻松在应用中集成Gemini Nano,实现如下的文本处理:

val generativeModel = GenerativeModel(modelName = "gemini-nano")

val prompt = "总结以下文本:[长文本内容]"

val response = generativeModel.generateContent(prompt)

val summary = response.text

Gemini Nano的优势在于其高效性和灵活性。相比传统云端AI服务,设备端运行可提供无缝性能、更大隐私性、更低延迟以及离线可用性。此外,Gemini Nano的多模态能力使其能够处理文本、图像、音频等多样化输入,为应用开发提供了广阔的可能性。

二、AI辅助开发工具:Android Studio Bot与AICore系统服务

AI辅助开发工具正成为提升开发效率的重要助力。Google推出的Android Studio Bot是一款基于大语言模型(LLM)的IDE助手,由Google基础编程模型Codey提供支持,Codey派生自PaLM 2大模型。Android Studio Bot直接嵌入IDE工具栏,支持代码生成、调试建议、自然语言问答等功能,堪称安卓开发者的专属”ChatGPT”。它能够理解开发者的自然语言输入,快速提供问题答案、代码示例、调试建议等,帮助开发者节省大量时间。

Android Studio Bot的安装需要使用Canary或Hedgehog版本的Android Studio。安装完成后,可通过”View > Tool Windows > Studio Bot”打开工具窗口。初次使用需登录Google账号,中国用户可能需要设置代理或切换至美国节点才能成功登录。开发者在使用时需注意,Studio Bot仍处于早期实验阶段,有时可能会提供不准确、具有误导性或虚假的信息,生成的代码也未必是最佳、完整或无漏洞的,因此需要人工检验和测试。

对于AICore系统服务(用户提到的”Astra计划”),它实际上是Google为Android设备提供的端侧AI基础模型管理系统。AICore作为Android 14的新系统服务,负责管理Gemini Nano等模型的分发、更新和运行时处理,简化开发者将AI融入应用的工作。AICore通过与特定系统软件包的受限绑定、间接互联网访问等机制确保模型安全,并遵循”Private Compute Core”原则,保护用户数据隐私。目前,AICore仅支持Pixel 8 Pro、Galaxy S24、Z Flip 6/Fold 6等特定设备,开发者在集成时应添加兼容性检查逻辑。

值得注意的是,Gemini Nano本身不支持语音合成功能,若需实现离线语音合成,需结合Google的Text-to-Speech(TTS)API或其他端侧语音模型。这表明,在构建完整AI功能时,开发者需要灵活组合多种技术栈,而非依赖单一模型。

三、实时视频抠图实现:基于MediaPipe的Selfie Segmentation

虽然ML Kit 2.0未直接支持实时视频抠图,但Google的MediaPipe框架提供了强大的解决方案。MediaPipe的Selfie Segmentation模块专为移动端设计,可在支持设备上实现实时视频分割,生成精确的前景与背景掩码,适用于虚拟背景替换、视频特效等场景。

要实现实时视频抠图功能,首先需要在Android项目中添加MediaPipe和摄像头库依赖:

dependencies {

implementation 'com.google.ai.client.generativeai:generativeai:0.6.0'

implementation 'com.google.mediapipe:mediapipe-tflite:0.14.0.0'

implementation 'androidx.camera:camera-core:1.3.0'

implementation 'androidx.camera:camera-camera2:1.3.0'

}

接下来,实现摄像头权限请求和预览功能:

// 请求CAMERA权限

private fun requestCameraPermission() {

if (ContextCompat.checkSelfPermission(this, Manifest.permission.CAMERA)

!= PackageManager.PERMISSION_GRANTED) {

ActivityCompat.requestPermissions(this, arrayOf(Manifest.permission.CAMERA), CAMERA_REQUEST_CODE)

} else {

startCamera()

}

}

// 初始化摄像头并创建预览

private fun startCamera() {

val cameraProviderFuture = ProcessCameraProvider.getInstance(this)

cameraProviderFuture.addListener({

val cameraProvider: ProcessCameraProvider = cameraProviderFuture.get()

val preview = Preview.Builder().build()

val cameraSelector = CameraSelector.DEFAULT_BACK_CAMERA

cameraProvider.bindToLifecycle(

this, cameraSelector, preview, imageAnalysis

)

preview.setSurfaceProvider(previewView.createSurfaceProvider())

}, ContextCompat.getMainExecutor(this))

}

然后,集成MediaPipe的Selfie Segmentation模型处理摄像头帧:

// 创建图像分析用例

val imageAnalysis = ImageAnalysis.Builder()

.setTargetResolution(Size(1280, 720))

.build()

imageAnalysis.setAnalyzer(ContextCompat.getMainExecutor(this)) {

imageProxy ->

val mediaImage = imageProxy.image

val rotationDegrees = imageProxy.imageInfo rotationDegrees

if (mediaImage != null) {

val rgbImage = InputImage.fromMediaImage(mediaImage, rotationDegrees)

val segmentation = mpSelfieSegmentation.process(rgbImage)

val mask = segmentation segmentation_mask

val processedImage = applySegmentationMask(mask, mediaImage)

// 更新UI显示处理后的图像

runOnUiThread {

val bitmap = processedImage.toBitmap()

imageView.setImageBitmap(bitmap)

}

imageProxy.close()

}

}

// 应用分割掩码并替换背景

private fun applySegmentationMask(mask: Image, mediaImage: Image): Image {

val width = mediaImage width

val height = mediaImage height

// 将掩码转换为二值化图像

val binaryMask = convertToBinaryMask(mask)

// 创建纯白色背景

val background = Image.newImage(width, height, ImageFormat.YUV_420_888)

val buffer = background plane(0).buffer

buffer.position(0).putInt(255, buffer.remaining())

// 合并前景与背景

val outputImage = combineImages(binaryMask, mediaImage, background)

return outputImage

}

此代码片段展示了如何通过MediaPipe实现实时视频抠图的基础逻辑。实际开发中,还需处理摄像头帧格式转换、掩码阈值调整、背景替换算法优化等问题。此外,对于低端设备,建议降低摄像头分辨率或使用MediaPipe的多线程处理功能以提升性能。

四、端侧文本处理实战:Gemini Nano与AI Edge SDK

Gemini Nano的端侧文本处理功能可通过Google AI Edge SDK实现。以下是完整的代码实现步骤:

首先,在项目的build.gradle文件中添加AI Edge SDK依赖:

dependencies {

implementation("com.google.ai.edge.aicore:aicore:0.0.1-exp01")

}

然后,在AndroidManifest.xml中添加必要的元数据:

<application ...>

...

<meta-data

android:name="com.google.ai.edge.aicore.AICore"

android:value="true" />

</application>

接下来,检查设备是否支持AICore并初始化Gemini Nano模型:

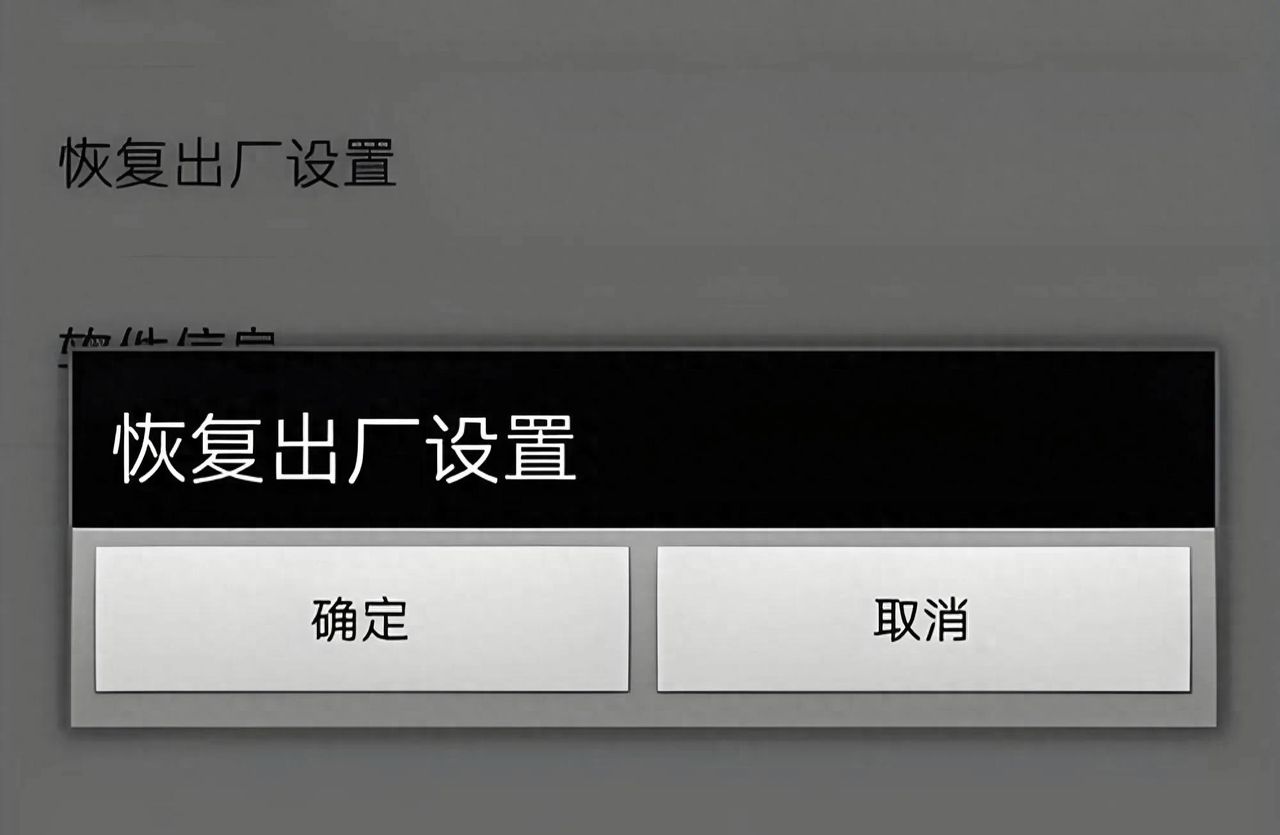

if (AICore.isAvailable()) {

val generativeModel = GenerativeModel(modelName = "gemini-nano")

// 文本摘要功能

val inputText = "需要总结的长文本内容"

val summaryResponse = generativeModel.generateContent("总结以下文本:$inputText")

val summary = summaryResponse.text

// 智能回复功能

val chatResponse = generativeModel.generateContent(

content {

text("你是一个智能客服助手")

text("用户问:如何重置密码?")

text("请给出一个友好且详细的回复")

}

)

val reply = chatResponse.text

// 显示结果

runOnUiThread {

textView.text = "摘要:$summary

回复:$reply"

}

} else {

// 处理设备不支持AICore的情况

runOnUiThread {

textView.text = "当前设备不支持Gemini Nano端侧功能"

}

}

此代码实现了Gemini Nano的基本文本处理功能,包括摘要生成和智能回复。Gemini Nano的文本处理能力已达到相当水平,在MMLU(大规模多任务语言理解)测试中,Nano-2版本的优秀答案百分比达到90%,接近更大型的模型性能。此外,Gemini Nano支持多语言处理,包括中文、日语、韩语等,为全球开发者提供了广泛的语言支持。

对于需要更高性能或复杂任务的场景,开发者可考虑使用Gemini Pro或Gemini Ultra模型,但这些模型需要依赖云端服务,且存在延迟和隐私风险。Gemini Nano的优势在于其端侧运行特性,能够确保用户数据不离开设备,同时提供快速响应和离线可用性,特别适合对隐私要求高或网络不稳定的应用场景。

五、AI辅助开发工具:Studio Bot实战与最佳实践

Android Studio Bot作为AI辅助开发工具,能够显著提升开发效率。以下是其核心功能与实战示例:

代码生成:通过自然语言描述功能需求,Studio Bot可快速生成代码片段。例如,询问”如何实现一个安卓应用的登录界面?”,Bot会提供包含UI布局、输入验证和登录逻辑的完整代码。

// 生成登录界面代码示例

val loginFragment = Fragment()

val etEmail = EditText(context)

etEmail.hint = "邮箱"

val etPassword = EditText(context)

etPassword.hint = "密码"

val btnLogin = Button(context)

btnLogin.text = "登录"

btnLogin.setOnClickListener {

val email = etEmail.text.toString()

val password = etPassword.text.toString()

// 调用登录API

}

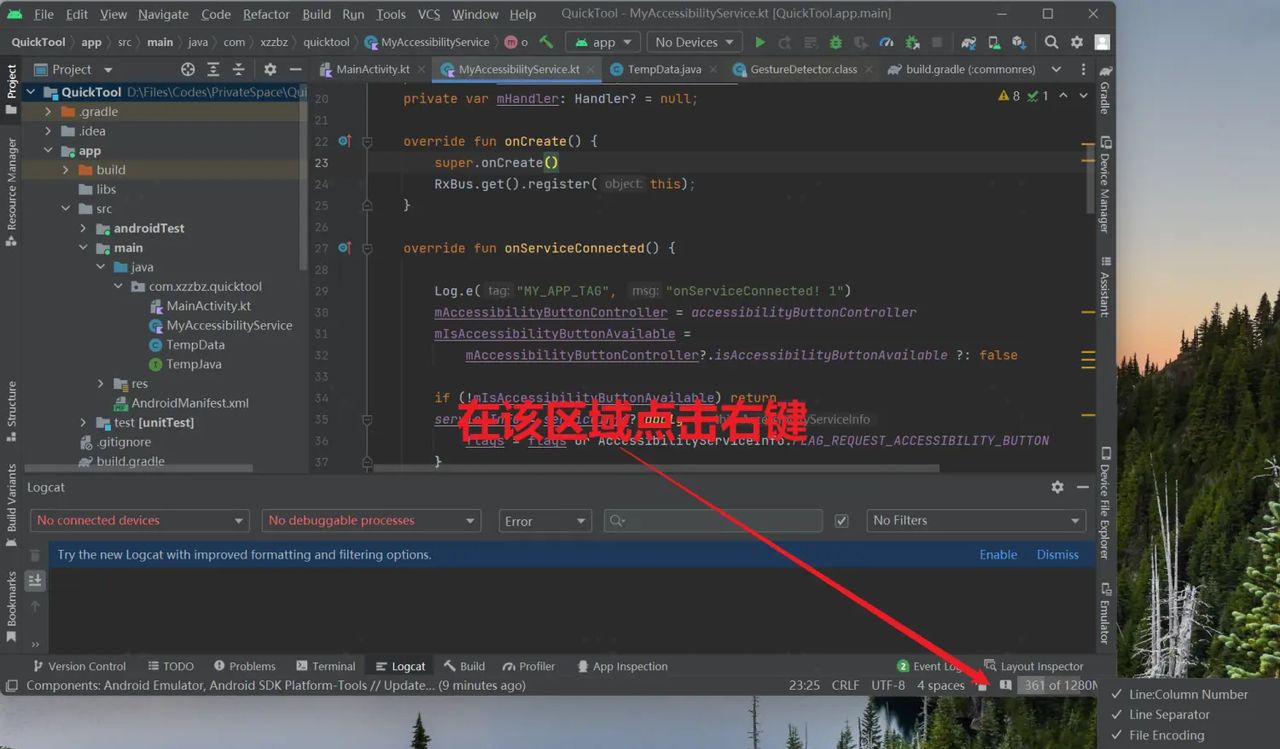

调试建议:当开发者遇到代码错误或性能问题时,Studio Bot能够分析日志或代码片段,提供针对性的解决方案。例如,右键点击错误代码并选择”Ask Studio Bot”,Bot会解释错误原因并提供修改建议。

// 调试示例

try {

val result = generativeModel.generateContent("生成一段代码")

} catch (e: Exception) {

// 使用Studio Bot分析错误

val errorAnalysis = studioBot.analyzeError(e)

Log.d("ErrorAnalysis", errorAnalysis)

}

自然语言问答:开发者可直接向Studio Bot提问,获取Android开发相关知识或最佳实践。例如,询问”如何实现Jetpack Compose的懒加载列表?”,Bot会提供详细的实现步骤和代码示例。

在使用Android Studio Bot时,开发者应遵循以下最佳实践:

明确需求:向Bot提问时,应尽量明确功能需求或问题细节,以便获得更准确的响应。

人工验证:Bot生成的代码或建议应经过人工检查和测试,确保其符合项目要求且无安全隐患。

隐私保护:Studio Bot不会采集开发者的代码进行训练,但会收集对话数据。对于敏感项目,建议使用离线AI模型(如JetBrains AI Assistant)。

上下文管理:Bot具备会话记忆能力,可记住对话历史。开发者可通过”Clear Chat History”按钮重置上下文,避免混淆。

对于中国用户,由于Studio Bot服务未在中国大陆地区开放,需通过科学上网或切换至美国账号登录Google服务。此外,Android Studio Bot与AICore系统服务结合,能够为开发者提供更全面的AI辅助,例如自动生成符合系统API规范的代码,或直接调用设备端Gemini Nano模型实现智能功能。

六、未来趋势与企业级应用架构建议

随着AI技术的快速发展,设备端AI与开发工具的集成正呈现出以下趋势:

AI原生操作系统:Android 16将深度集成Gemini模型,实现系统级AI能力。例如,应用可通过”App Functions” API向系统暴露特定功能,供AI助手直接调用,无需模拟用户操作。这将极大提升AI与应用的交互效率,为开发者提供更统一的AI集成接口。

多模态能力扩展:Gemini模型正朝着多模态方向快速发展,未来将支持更多感官输入(如触觉),并能够执行物理交互任务。这为构建更智能、更自然的用户体验提供了可能性。例如,未来AI助手可通过分析图像、文本和音频,提供更全面的场景理解能力。

硬件加速普及:联发科天玑9300/8300等芯片已针对Gemini Nano进行优化,未来更多芯片厂商将推出定制化AI加速方案。企业级应用应设计模块化架构,支持动态切换不同硬件加速策略,以适应多样化设备环境。

隐私与安全强化:随着AI技术的深入应用,数据隐私和安全问题愈发重要。Google的AICore系统服务遵循”Private Compute Core”原则,通过受限软件包绑定、间接互联网访问等机制保护模型和用户数据。企业级应用应充分利用这些安全特性,并在架构中加入额外的数据加密和访问控制层。

基于以上趋势,企业级应用的架构设计应考虑以下几点:

分层架构设计:将AI模型、数据处理和业务逻辑分离,便于维护和扩展。例如,使用独立的模块处理MediaPipe视频分割和Gemini Nano文本摘要,通过统一接口提供给应用层使用。

设备兼容性处理:添加AICore可用性检查(AICore.isAvailable()),动态切换端侧/云端模型。对于不支持AICore的设备,可提供基于云端Gemini Pro的降级方案。

推理预算控制:Gemini 2.5 Flash模型引入了”thinking_budget”参数,允许开发者按需设置推理深度。企业级应用应根据任务复杂度和设备性能动态调整此参数,平衡性能与成本。

多模态协同处理:结合Gemini Nano的文本处理能力和MediaPipe的视觉处理能力,构建复杂场景应用。例如,视频分析后生成智能摘要,或根据图像内容提供个性化回复。

安全与隐私保护:采用端侧运行模式(如Gemini Nano)处理敏感数据,结合加密和权限控制(如.aiexclude文件)保护用户隐私。

七、总结与展望

AI与机器学习技术的深度集成正为移动开发带来革命性变化。ML Kit 2.0和Gemini Nano模型的端侧能力,以及Android Studio Bot等AI辅助开发工具,共同构成了一个高效、智能的开发生态。开发者可通过MediaPipe实现实时视频抠图,利用Gemini Nano进行离线文本处理,借助Studio Bot提升编码效率,构建更智能、更用户友好的应用程序。

随着Android 16的发布和AICore系统服务的普及,设备端AI能力将进一步增强。未来的AI原生操作系统将提供更统一的AI集成接口,硬件加速技术将降低模型运行门槛,多模态能力将扩展AI应用的边界。企业级应用应采用模块化架构设计,支持动态模型切换和推理预算控制,同时注重数据隐私与安全保护。

在开发过程中,开发者应充分利用Google提供的丰富资源和工具,包括官方文档、开发者社区和AI辅助工具,不断优化应用性能和用户体验。AI与机器学习的深度集成不是简单的功能叠加,而是需要系统性思考和设计,将智能能力无缝融入应用的核心功能中,才能真正发挥其价值,为用户带来更便捷、更智能的移动体验。

八、代码实战与进阶学习

本文提供了从零开始的代码实战示例,涵盖实时视频抠图和端侧文本处理两大核心功能。开发者可通过以下步骤逐步实现:

实时视频抠图:使用Jetpack Camera库获取摄像头帧,通过MediaPipe Selfie Segmentation模块处理视频流,生成分割掩码并替换背景。需注意摄像头权限请求、图像格式转换和性能优化。

端侧文本处理:通过AI Edge SDK初始化Gemini Nano模型,调用generateContent方法处理文本摘要或智能回复请求。需添加AICore设备兼容性检查,并考虑不同模型版本(Nano-1/Nano-2)的选择策略。

AI辅助开发:在Android Studio Hedgehog/Canary版本中启用Studio Bot,通过自然语言交互获取代码生成、调试建议和平台问题解答。需注意服务地区限制和网络配置要求。

对于希望深入掌握这些技术的开发者,建议按照以下路径进行学习:

基础理论:学习机器学习基础、计算机视觉原理和自然语言处理技术,理解AI模型的工作机制。

框架掌握:熟悉MediaPipe和ML Kit的API设计,了解AI Edge SDK的使用方法。

实战项目:从简单应用开始,逐步实现视频分割、文本摘要等功能,再尝试结合多模态输入输出构建复杂场景。

优化与部署:学习模型量化、硬件加速和性能优化技巧,了解如何将AI应用部署到不同设备环境。

AI与机器学习的深度集成是移动开发的未来方向,掌握这些技术将使开发者能够构建更智能、更高效的移动应用。通过持续学习和实践,开发者可以充分利用Google提供的AI工具链,将智能能力融入应用的每一个角落,为用户提供更加人性化、个性化的移动体验。

暂无评论内容