大数据领域Spark Streaming实时数据处理实战

关键词:Spark Streaming、实时数据处理、大数据、分布式计算、微批处理、容错机制、Kafka集成

摘要:

本文深入解析Apache Spark生态中的核心组件Spark Streaming,系统阐述其实时数据处理的核心原理、架构设计与实战应用。通过对比传统实时处理框架,揭示Spark Streaming基于微批处理的独特优势;结合数学模型与代码示例,详细讲解窗口操作、状态管理、容错机制等关键技术;通过完整的Kafka集成实战案例,演示从环境搭建到代码实现的全流程;最后探讨Spark Streaming在电商、金融、日志监控等领域的典型应用场景,以及未来在流批统一架构下的发展趋势。本文适合大数据开发工程师、数据架构师及相关技术爱好者,旨在为读者提供从理论到实践的全方位指导。

1. 背景介绍

1.1 目的和范围

随着物联网、移动互联网的普及,企业每天产生PB级的实时数据流,传统批量处理框架(如Hadoop MapReduce)已无法满足秒级甚至毫秒级的低延迟处理需求。Spark Streaming作为Apache Spark生态中面向实时计算的核心组件,通过将实时数据流分割为微小批次(Micro-Batch),结合Spark的分布式计算能力,实现了高吞吐量、容错性强的实时数据处理。

本文将从技术原理、核心架构、算法实现、实战案例四个维度展开,覆盖Spark Streaming的基础概念、高级特性(如窗口操作、状态管理、容错机制)、与Kafka/Pulsar等消息队列的集成方案,以及在生产环境中的性能优化策略。

1.2 预期读者

大数据开发工程师:掌握Spark Streaming核心API与最佳实践

数据架构师:理解Spark Streaming在实时数据处理体系中的定位与适用场景

技术管理者:评估Spark Streaming与Flink、Kafka Streams等框架的技术选型

高校师生与技术爱好者:构建实时流处理的理论知识体系

1.3 文档结构概述

核心概念:解析DStream、微批处理、容错机制等基础原理

技术架构:对比流处理框架,绘制Spark Streaming运行时架构图

算法实现:通过Python/Scala代码演示窗口操作与状态管理

实战案例:完整实现Kafka到Kafka的实时词频统计系统

应用场景:总结电商、金融、日志监控等领域的典型应用

优化与挑战:探讨背压机制、Checkpoint调优、流批统一趋势

1.4 术语表

1.4.1 核心术语定义

DStream (Discretized Stream):离散化数据流,Spark Streaming的基本抽象,本质是RDD序列

Micro-Batch:将实时数据流分割为毫秒级或秒级的小批次,每个批次作为RDD处理

Checkpoint:容错机制,定期保存作业元数据与中间状态,用于故障恢复

Watermark:处理乱序事件的时间机制,定义事件时间的延迟容忍窗口

背压 (Backpressure):自动调节数据摄入速率,避免处理系统过载

1.4.2 相关概念解释

事件时间 (Event Time):数据生成的实际时间,区别于处理时间(Processing Time)

端到端延迟 (End-to-End Latency):数据从产生到处理完成的时间间隔

吞吐量 (Throughput):系统单位时间内处理的数据量,单位为Records/Second

** Exactly-Once 语义**:保证每条数据仅被处理一次,Spark Streaming通过WAL实现At-Least-Once

1.4.3 缩略词列表

| 缩写 | 全称 | 说明 |

|---|---|---|

| RDD | Resilient Distributed Dataset | Spark分布式数据集抽象 |

| DAG | Directed Acyclic Graph | 有向无环图,任务调度模型 |

| WAL | Write-Ahead Log | 预写日志,保证容错性 |

| YARN | Yet Another Resource Negotiator | 集群资源管理器 |

2. 核心概念与联系

2.1 Spark Streaming核心架构原理

Spark Streaming采用**微批处理(Micro-Batch)**架构,将实时输入数据流按时间切片(如1秒)分割为多个DStream,每个DStream由一系列RDD组成。每个RDD代表一个时间片内的数据,通过Spark Core的DAG调度器和任务执行引擎进行分布式处理。

2.1.1 架构示意图

graph TD

A[数据源] --> B{输入格式}

B --> C[Kafka/Pulsar/Flume]

B --> D[文件系统/Socket]

C --> E[Receiver输入]

D --> F[Direct输入]

E --> G[DStream生成]

F --> G

G --> H[转换操作:map/filter/window]

H --> I[输出操作:print/saveAsKafka]

I --> J[结果存储]

K[Checkpoint机制] --> G

K --> I

L[Driver节点] --> K

L --> H

M[Executor节点] --> H

M --> I

2.1.2 与Flink的架构对比

| 特性 | Spark Streaming | Flink |

|---|---|---|

| 处理模型 | 微批处理(Micro-Batch) | 事件驱动(Event-Driven) |

| 延迟 | 亚秒级(100ms+) | 毫秒级(1ms-10ms) |

| 吞吐量 | 高(适合批量优化场景) | 中高(平衡延迟与吞吐量) |

| 时间语义 | 处理时间为主 | 支持事件时间+Watermark |

| 状态后端 | 内存/磁盘Checkpoint | RocksDB/内存哈希表 |

2.2 DStream核心操作解析

2.2.1 基础转换操作

map(func):对DStream中的每个元素应用函数,返回新的DStream

filter(func):保留满足条件的元素

flatMap(func):先映射再展开,常用于分词操作

union(otherDStream):合并两个DStream的元素

2.2.2 窗口操作(Window Operations)

窗口操作通过定义滑动窗口的大小(Window Length)和滑动间隔(Slide Interval),对窗口内的数据流进行聚合:

滑动窗口(Sliding Window):window(windowDuration, slideDuration)

会话窗口(Session Window):通过windowBySession按事件间隔分组(需Spark 3.0+)

2.2.3 状态管理

当处理需要跨批次的聚合(如累计计数),需使用状态管理API:

updateStateByKey(func):对每个Key的状态进行更新

mapWithState(stateFunc):更高效的状态访问方式(需启用Checkpoint)

3. 核心算法原理 & 具体操作步骤

3.1 窗口操作算法实现(Python示例)

3.1.1 滑动窗口词频统计

from pyspark.streaming import StreamingContext

from pyspark.streaming.kafka import KafkaUtils

# 初始化Spark StreamingContext,批处理间隔5秒

ssc = StreamingContext(spark.sparkContext, batchDuration=Seconds(5))

# 从Kafka读取数据,topic为"input-topic"

kafkaParams = {

"bootstrap.servers": "localhost:9092", "group.id": "wordcount-group"}

directKafkaStream = KafkaUtils.createDirectStream(

ssc, ["input-topic"], kafkaParams

)

# 提取消息内容并分词

lines = directKafkaStream.map(lambda x: x[1])

words = lines.flatMap(lambda line: line.split(" "))

# 定义滑动窗口:窗口长度30秒,滑动间隔10秒

windowedWords = words.window(

windowDuration=Seconds(30), slideDuration=Seconds(10)

)

# 词频统计

wordCounts = windowedWords.map(lambda word: (word, 1)).reduceByKey(lambda a, b: a + b)

wordCounts.pprint()

ssc.start()

ssc.awaitTermination()

3.1.2 窗口操作核心逻辑解析

窗口划分:根据windowDuration将数据流划分为时间窗口,每个窗口包含多个批处理数据

RDD转换:窗口内的RDD通过union操作合并为一个大RDD,再执行聚合操作

滑动机制:slideDuration决定窗口滑动的步长,支持非等长窗口(需自定义逻辑)

3.2 状态管理算法实现

3.2.1 累计计数(使用updateStateByKey)

# 定义状态更新函数:累加当前批次值与历史状态

def updateFunc(new_values, last_state):

return sum(new_values) + (last_state or 0)

# 初始化状态,设置Checkpoint目录

ssc.checkpoint("hdfs://checkpoint/")

# 对每个Key的状态进行更新

stateDStream = words.map(lambda word: (word, 1)).updateStateByKey(updateFunc)

stateDStream.pprint()

3.2.2 状态后端优化

内存存储:默认将状态存于Executor内存,适合小状态场景

Tachyon存储:将大状态存于分布式文件系统,减少内存压力

状态TTL:通过StateTtlConfig设置状态过期时间,避免状态无限增长

4. 数学模型和公式 & 详细讲解

4.1 吞吐量与延迟模型

4.1.1 基本公式

批次处理时间(Batch Processing Time, Tp):处理单个批次数据的时间

批次间隔(Batch Interval, Tb):用户定义的批处理时间切片

系统延迟(Latency, L):L = Tp(理想情况),实际需考虑队列等待时间

当Tp > Tb时,系统将出现背压,导致延迟累积。优化目标是使Tp ≤ Tb,并最大化吞吐量Throughput = 数据量 / Tb。

4.1.2 背压机制公式

背压算法通过动态调整数据摄入速率R,使Tp = Tb:

R = 平均处理速率 目标处理速率 × 当前摄入速率 R = frac{ ext{平均处理速率}}{ ext{目标处理速率}} imes ext{当前摄入速率} R=目标处理速率平均处理速率×当前摄入速率

Spark Streaming通过监控最近100个批次的处理时间,自动计算并调整Kafka的fetch批次大小。

4.2 容错机制数学模型

4.2.1 Checkpoint间隔优化

设Checkpoint写入时间为Tc,处理时间为Tp,批次间隔为Tb,则需满足:

T c + T p ≤ T b Tc + Tp ≤ Tb Tc+Tp≤Tb

实际中通过监控Tc动态调整Checkpoint间隔,避免Checkpoint成为性能瓶颈。

4.2.2 数据可靠性公式

Spark Streaming通过WAL保证At-Least-Once语义,数据丢失概率P与Executor失败频率f、Checkpoint间隔Tc相关:

P ≈ f × T c 2 P ≈ f imes frac{Tc}{2} P≈f×2Tc

通过缩短Tc可降低丢失概率,但会增加I/O开销。

5. 项目实战:Kafka集成实时词频统计系统

5.1 开发环境搭建

5.1.1 软件版本

Spark 3.3.0(Scala 2.12)

Kafka 3.2.0

Python 3.8

Zookeeper 3.8.0

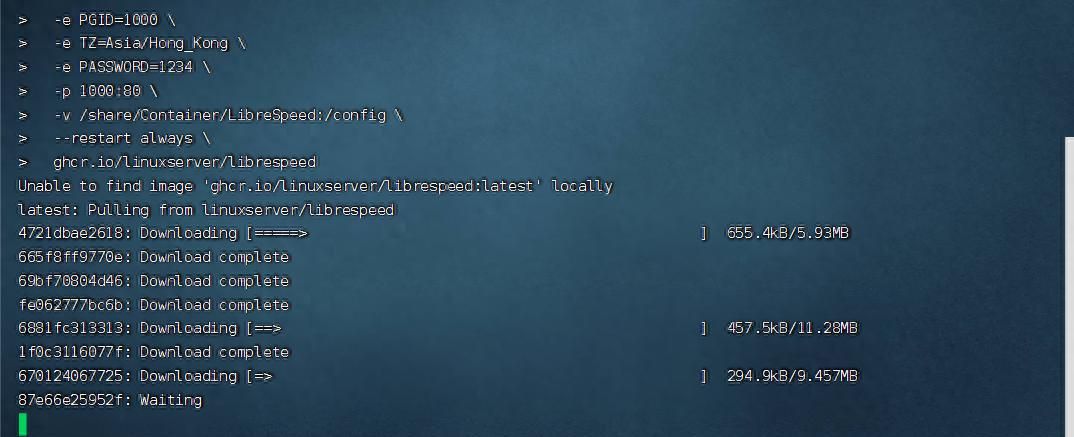

5.1.2 环境配置步骤

下载Spark:

wget https://downloads.apache.org/spark/spark-3.3.0/spark-3.3.0-bin-hadoop3.tgz

tar -xzf spark-3.3.0-bin-hadoop3.tgz

export SPARK_HOME=/path/to/spark

启动Zookeeper与Kafka:

# Zookeeper

bin/zookeeper-server-start.sh config/zookeeper.properties

# Kafka Broker

bin/kafka-server-start.sh config/server.properties

# 创建topic

bin/kafka-topics.sh --create --topic input-topic --bootstrap-server localhost:9092 --partitions 4 --replication-factor 1

安装Python依赖:

pip install pyspark kafka-python

5.2 源代码详细实现(Scala版本)

5.2.1 主程序逻辑

import org.apache.spark.SparkConf

import org.apache.spark.streaming.{

Seconds, StreamingContext}

import org.apache.spark.streaming.kafka010.{

ConsumerStrategies, KafkaUtils, LocationStrategies}

object KafkaWordCount {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("KafkaWordCount").setMaster("local[4]")

val ssc = new StreamingContext(conf, Seconds(5))

// Kafka配置

val kafkaParams = Map(

"bootstrap.servers" -> "localhost:9092",

"group.id" -> "wordcount-group",

"key.deserializer" -> classOf[org.apache.kafka.common.serialization.StringDeserializer],

"value.deserializer" -> classOf[org.apache.kafka.common.serialization.StringDeserializer]

)

val topics = Set("input-topic")

// 读取Kafka数据,使用Direct API(更高效的offset管理)

val kafkaStream = KafkaUtils.createDirectStream[String, String](

ssc,

LocationStrategies.PreferConsistent,

ConsumerStrategies.Subscribe[String, String](topics, kafkaParams)

)

// 提取消息内容并分词

val lines = kafkaStream.map(_.value())

val words = lines.flatMap(_.split(" "))

// 词频统计,使用滑动窗口(窗口1分钟,滑动30秒)

val wordCounts = words.map(word => (word, 1))

.reduceByKeyAndWindow((a: Int, b: Int) => a + b, Seconds(60), Seconds(30))

// 输出结果到控制台

wordCounts.print()

// 启动Checkpoint机制(可选,用于容错)

ssc.checkpoint("hdfs://namenode:8020/checkpoint/spark-streaming")

ssc.start()

ssc.awaitTermination()

}

}

5.2.2 关键代码解析

Kafka Direct API:

避免使用Receiver API(需WAL,增加延迟)

直接从Kafka分区读取数据,支持精确的offset管理

窗口操作参数:

reduceByKeyAndWindow比普通reduceByKey多两个参数:窗口长度和滑动间隔

内部实现为增量计算,仅处理进入/离开窗口的元素,提升效率

Checkpoint配置:

定期将元数据(如offset、聚合状态)写入HDFS

故障恢复时从最新Checkpoint重启,避免数据丢失

5.3 代码解读与分析

5.3.1 性能优化点

并行度设置:local[4]指定4个Executor线程,匹配Kafka topic的4个分区,充分利用并行处理能力

序列化优化:使用Kafka原生反序列化器(而非Java序列化),减少数据传输开销

背压启用:Spark 2.0+默认启用背压,通过spark.streaming.backpressure.enabled配置

5.3.2 容错测试步骤

手动停止某个Executor进程

Spark Driver检测到失败,从最近的Checkpoint恢复

验证恢复后的数据是否正确,确认offset重新定位到Checkpoint记录位置

6. 实际应用场景

6.1 电商实时推荐系统

场景描述:实时分析用户浏览、点击、购买行为,动态调整推荐列表

Spark Streaming应用:

从Kafka消费用户行为日志(事件时间戳、商品ID、用户ID)

使用滑动窗口计算商品实时点击量(窗口长度10分钟,滑动间隔1分钟)

通过updateStateByKey维护用户浏览历史状态

结合协同过滤算法,生成实时推荐结果并写入Redis

6.2 实时日志监控与异常检测

场景描述:监控分布式系统日志,实时检测异常访问模式

技术实现:

从Flume收集各节点日志,通过Kafka传输到Spark Streaming

使用mapWithState跟踪每个IP的请求频率

定义异常规则:如单个IP每分钟请求超过100次触发警报

结果输出到Elasticsearch,供Kibana可视化

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

《High Performance Spark》

深入讲解Spark性能优化,包括Streaming模块调优

《Spark Streaming in Action》

实战导向,覆盖从基础到高级特性的完整案例

《流计算:技术、框架与实践》

对比Spark Streaming、Flink、Storm等框架,适合架构选型参考

7.1.2 在线课程

Coursera《Apache Spark for Real-Time Big Data Processing》

包含Spark Streaming核心概念与Kafka集成实战

Udemy《Spark Streaming and Structured Streaming Masterclass》

重点讲解Structured Streaming与传统Streaming的差异

7.1.3 技术博客和网站

Apache Spark官方文档

最权威的API参考与最佳实践指南

Databricks Blog

提供Spark最新特性解析与生产环境案例

美团技术团队博客

大量国内大厂Spark Streaming优化经验分享

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

IntelliJ IDEA

支持Scala/Java开发,集成Spark调试插件

PyCharm

最佳Python开发体验,支持PySpark调试

VS Code

通过Spark插件实现轻量级开发,适合快速原型验证

7.2.2 调试和性能分析工具

Spark Web UI

监控批次处理时间、吞吐量、GC情况

Grafana + Prometheus

自定义指标监控,如Kafka消费滞后量、Checkpoint耗时

JProfiler

深入分析Executor内存占用与线程状态

7.2.3 相关框架和库

消息队列:Kafka(高吞吐量)、Pulsar(多租户支持)

数据存储:Redis(实时结果缓存)、HBase(海量状态存储)

流批统一:Spark Structured Streaming(基于DataFrame/Dataset的高层API)

7.3 相关论文著作推荐

7.3.1 经典论文

《Spark Streaming:当容错遇见流处理》

解析Spark Streaming容错机制与微批处理架构设计

《S4与Storm:流处理系统对比》

早期流处理框架对比,奠定微批与事件驱动架构基础

7.3.2 最新研究成果

《流批统一架构下的资源调度优化》

探讨Spark 3.0+中Structured Streaming如何统一流批处理语义

《基于机器学习的流处理背压策略》

提出动态调整批次大小的智能算法,提升系统稳定性

7.3.3 应用案例分析

《Netflix实时数据处理平台架构》

大规模场景下Spark Streaming与Flink的混合使用经验

《阿里双11实时计算实践》

高并发场景下的延迟优化与容错方案

8. 总结:未来发展趋势与挑战

8.1 流批统一架构普及

Spark 2.0推出的Structured Streaming通过将流视为无限增长的表,实现了流处理与批处理API的统一。未来趋势是逐步弃用传统Spark Streaming API,转向更简洁的Structured Streaming,支持事件时间处理、Exactly-Once语义(需Kafka 0.11+)及更丰富的SQL支持。

8.2 低延迟与高吞吐量平衡

尽管Spark Streaming在吞吐量上表现优异,但在金融交易、实时游戏等对延迟敏感的场景中,仍需向Flink等事件驱动框架学习。未来可能引入更细粒度的调度机制(如毫秒级批次),结合增量处理算法减少延迟。

8.3 状态管理与容错优化

随着实时计算复杂度提升,状态数据量可能达到TB级,传统内存存储面临瓶颈。需进一步优化状态后端(如集成RocksDB),结合分层存储(内存+SSD+HDD)降低成本,同时提升Checkpoint效率。

8.4 多云与边缘计算支持

在边缘计算场景中,设备资源有限,需轻量化的Spark Streaming部署方案。未来可能推出边缘节点专用运行时,支持离线/在线混合处理,结合5G网络实现端云协同的实时计算。

9. 附录:常见问题与解答

Q1:Spark Streaming如何处理乱序事件?

A:传统Spark Streaming基于处理时间,对乱序事件支持有限。建议迁移至Structured Streaming,通过withWatermark设置事件时间延迟阈值,自动处理迟到数据。

Q2:背压机制不生效怎么办?

A:检查spark.streaming.backpressure.enabled是否为true,确保Kafka消费者使用Direct API。通过Spark Web UI监控最近批次的处理时间,若持续高于批次间隔,可能需要增加Executor资源或优化计算逻辑。

Q3:状态存储导致内存溢出如何解决?

A:1. 使用mapWithState替代updateStateByKey,减少状态访问开销;2. 启用状态TTL(StateTtlConfig),定期清理过期状态;3. 将大状态存储到HDFS或Alluxio等外部存储。

Q4:如何实现Exactly-Once语义?

A:Spark Streaming原生支持At-Least-Once,若需Exactly-Once,需结合Kafka的事务性写入(Kafka 0.11+),通过KafkaUtils.createDirectStream配合WAL实现端到端一致性。

10. 扩展阅读 & 参考资料

Apache Spark官方文档 – Spark Streaming

Kafka与Spark Streaming集成指南

Spark Streaming性能调优手册

通过本文的系统讲解,读者应能全面掌握Spark Streaming的核心原理、实战技巧及生产环境优化策略。在实际应用中,需根据具体场景选择合适的处理模型(微批vs事件驱动),并结合Structured Streaming等新技术趋势,构建高效可靠的实时数据处理平台。

暂无评论内容