AI作画:在AI人工智能浪潮中绽放光芒

关键词:AI作画、生成对抗网络、扩散模型、计算机视觉、深度学习、艺术创作、人工智能应用

摘要:本文深入探讨AI作画技术的原理、发展和应用。我们将从基础概念出发,详细解析生成对抗网络(GAN)和扩散模型(Diffusion Models)等核心技术,通过数学模型和代码实现展示AI如何学习艺术创作。文章还将探讨AI作画在实际场景中的应用,分析当前面临的挑战和未来发展趋势,为读者提供全面的技术视角和应用前景。

1. 背景介绍

1.1 目的和范围

本文旨在全面介绍AI作画技术的发展现状、核心原理和实际应用。我们将深入探讨AI作画的技术基础,包括生成模型、神经网络架构和训练方法,同时分析这一技术在艺术创作、设计行业和娱乐产业中的应用前景。

1.2 预期读者

本文适合对人工智能、计算机视觉和数字艺术感兴趣的读者,包括但不限于:

AI研究人员和工程师

数字艺术家和设计师

计算机科学专业学生

科技爱好者和艺术从业者

1.3 文档结构概述

文章首先介绍AI作画的基本概念和发展历程,然后深入解析核心技术原理,包括GAN和扩散模型。接着通过代码实例展示AI作画的实现过程,探讨实际应用场景,最后讨论未来发展趋势和面临的挑战。

1.4 术语表

1.4.1 核心术语定义

AI作画:利用人工智能算法自动生成视觉艺术作品的技术

生成对抗网络(GAN):由生成器和判别器组成的对抗性神经网络架构

扩散模型:通过逐步去噪过程生成高质量图像的深度学习模型

潜在空间:高维数据在神经网络中被编码的低维表示空间

风格迁移:将一种艺术风格应用到另一幅图像上的技术

1.4.2 相关概念解释

计算机视觉:使计算机能够从图像或视频中获取信息的技术

深度学习:基于多层神经网络的机器学习方法

神经网络:模仿生物神经元连接方式的计算模型

卷积神经网络(CNN):专门用于处理网格状数据(如图像)的神经网络

1.4.3 缩略词列表

AI:人工智能(Artificial Intelligence)

GAN:生成对抗网络(Generative Adversarial Network)

CNN:卷积神经网络(Convolutional Neural Network)

VAE:变分自编码器(Variational Autoencoder)

CLIP:对比语言-图像预训练(Contrastive Language-Image Pretraining)

2. 核心概念与联系

AI作画技术的核心在于生成模型,它通过学习大量艺术作品的数据分布,能够创造出新的视觉内容。现代AI作画系统通常结合了多种技术:

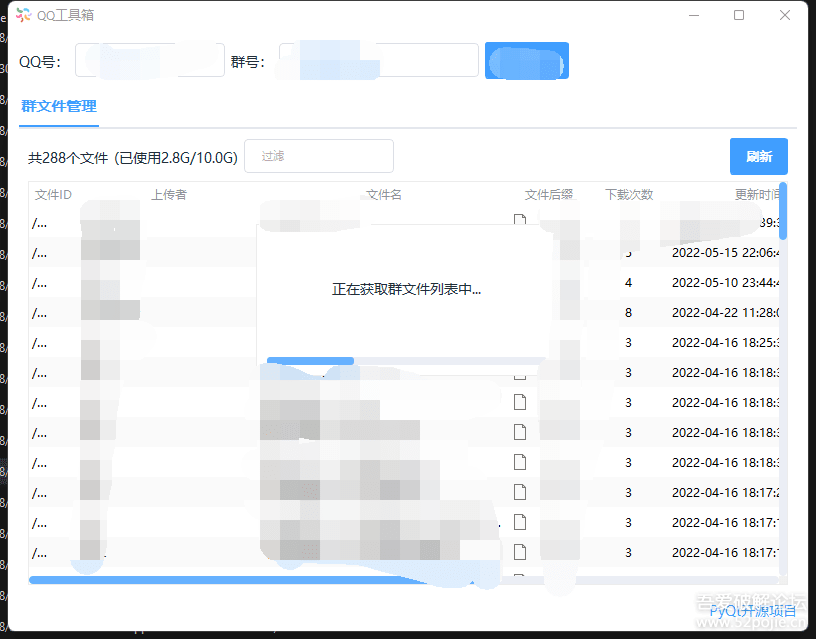

上图展示了典型的AI作画系统架构。文本描述首先被编码为潜在表示,然后生成模型根据这些表示创建图像,最后经过后处理输出最终结果。

2.1 生成对抗网络(GAN)

GAN由两个相互竞争的神经网络组成:

生成器(Generator):试图创建逼真的图像

判别器(Discriminator):试图区分真实图像和生成图像

这种对抗训练过程促使生成器不断提高生成质量。

2.2 扩散模型

扩散模型通过两个过程工作:

正向扩散:逐步向图像添加噪声

反向扩散:学习如何从噪声中重建原始图像

这种模型能够生成极高分辨率和质量的图像。

2.3 文本-图像对齐

现代AI作画系统如DALL-E和Stable Diffusion使用CLIP等模型将文本描述与图像内容对齐,确保生成的图像符合文字描述。

3. 核心算法原理 & 具体操作步骤

3.1 GAN的基本实现

以下是使用PyTorch实现简单GAN的代码框架:

import torch

import torch.nn as nn

# 生成器定义

class Generator(nn.Module):

def __init__(self, latent_dim, img_shape):

super().__init__()

self.model = nn.Sequential(

nn.Linear(latent_dim, 128),

nn.LeakyReLU(0.2),

nn.Linear(128, 256),

nn.BatchNorm1d(256),

nn.LeakyReLU(0.2),

nn.Linear(256, 512),

nn.BatchNorm1d(512),

nn.LeakyReLU(0.2),

nn.Linear(512, int(torch.prod(torch.tensor(img_shape)))),

nn.Tanh()

)

self.img_shape = img_shape

def forward(self, z):

img = self.model(z)

return img.view(img.size(0), *self.img_shape)

# 判别器定义

class Discriminator(nn.Module):

def __init__(self, img_shape):

super().__init__()

self.model = nn.Sequential(

nn.Linear(int(torch.prod(torch.tensor(img_shape))), 512),

nn.LeakyReLU(0.2),

nn.Linear(512, 256),

nn.LeakyReLU(0.2),

nn.Linear(256, 1),

nn.Sigmoid()

)

def forward(self, img):

img_flat = img.view(img.size(0), -1)

validity = self.model(img_flat)

return validity

3.2 扩散模型的实现步骤

扩散模型的关键步骤如下:

定义噪声调度:

def linear_beta_schedule(timesteps):

beta_start = 0.0001

beta_end = 0.02

return torch.linspace(beta_start, beta_end, timesteps)

timesteps = 1000

betas = linear_beta_schedule(timesteps)

alphas = 1. - betas

alphas_cumprod = torch.cumprod(alphas, axis=0)

正向扩散过程:

def q_sample(x_start, t, noise=None):

if noise is None:

noise = torch.randn_like(x_start)

sqrt_alphas_cumprod_t = extract(sqrt_alphas_cumprod, t, x_start.shape)

sqrt_one_minus_alphas_cumprod_t = extract(sqrt_one_minus_alphas_cumprod, t, x_start.shape)

return sqrt_alphas_cumprod_t * x_start + sqrt_one_minus_alphas_cumprod_t * noise

定义UNet模型用于预测噪声:

class UNet(nn.Module):

def __init__(self, dim=16, dim_mults=(1, 2, 4, 8)):

super().__init__()

dims = [3, *map(lambda m: dim * m, dim_mults)]

in_out = list(zip(dims[:-1], dims[1:]))

self.downs = nn.ModuleList([])

self.ups = nn.ModuleList([])

for ind, (dim_in, dim_out) in enumerate(in_out):

self.downs.append(nn.ModuleList([

nn.Conv2d(dim_in, dim_out, 3, padding=1),

nn.SiLU(),

nn.Conv2d(dim_out, dim_out, 3, padding=1),

nn.SiLU(),

nn.MaxPool2d(2)

]))

mid_dim = dims[-1]

self.mid_block = nn.Sequential(

nn.Conv2d(mid_dim, mid_dim, 3, padding=1),

nn.SiLU(),

nn.Conv2d(mid_dim, mid_dim, 3, padding=1),

nn.SiLU()

)

for ind, (dim_in, dim_out) in enumerate(reversed(in_out[1:])):

self.ups.append(nn.ModuleList([

nn.ConvTranspose2d(dim_out * 2, dim_in, 3, padding=1),

nn.SiLU(),

nn.ConvTranspose2d(dim_in, dim_in, 3, padding=1),

nn.SiLU(),

nn.Upsample(scale_factor=2)

]))

self.final_conv = nn.Conv2d(dim, 3, 1)

def forward(self, x):

h = []

for conv1, act1, conv2, act2, downsample in self.downs:

x = conv1(x)

x = act1(x)

x = conv2(x)

x = act2(x)

h.append(x)

x = downsample(x)

x = self.mid_block(x)

for conv1, act1, conv2, act2, upsample in self.ups:

x = torch.cat((x, h.pop()), dim=1)

x = conv1(x)

x = act1(x)

x = conv2(x)

x = act2(x)

x = upsample(x)

return self.final_conv(x)

4. 数学模型和公式 & 详细讲解 & 举例说明

4.1 GAN的数学原理

GAN的目标函数可以表示为min-max游戏:

min G max D V ( D , G ) = E x ∼ p d a t a ( x ) [ log D ( x ) ] + E z ∼ p z ( z ) [ log ( 1 − D ( G ( z ) ) ) ] min_G max_D V(D,G) = mathbb{E}_{xsim p_{data}(x)}[log D(x)] + mathbb{E}_{zsim p_z(z)}[log(1-D(G(z)))] GminDmaxV(D,G)=Ex∼pdata(x)[logD(x)]+Ez∼pz(z)[log(1−D(G(z)))]

其中:

D ( x ) D(x) D(x)是判别器对真实数据x的判断

G ( z ) G(z) G(z)是生成器从噪声z生成的样本

p d a t a p_{data} pdata是真实数据分布

p z p_z pz是噪声分布

4.2 扩散模型的数学基础

扩散模型基于马尔可夫链,正向过程逐步添加噪声:

q ( x t ∣ x t − 1 ) = N ( x t ; 1 − β t x t − 1 , β t I ) q(x_t|x_{t-1}) = mathcal{N}(x_t; sqrt{1-eta_t}x_{t-1}, eta_tmathbf{I}) q(xt∣xt−1)=N(xt;1−βt

xt−1,βtI)

反向过程学习去噪:

p θ ( x t − 1 ∣ x t ) = N ( x t − 1 ; μ θ ( x t , t ) , Σ θ ( x t , t ) ) p_ heta(x_{t-1}|x_t) = mathcal{N}(x_{t-1}; mu_ heta(x_t,t), Sigma_ heta(x_t,t)) pθ(xt−1∣xt)=N(xt−1;μθ(xt,t),Σθ(xt,t))

训练目标是最小化:

E t , x 0 , ϵ [ ∥ ϵ − ϵ θ ( x t , t ) ∥ 2 ] mathbb{E}_{t,x_0,epsilon}left[|epsilon – epsilon_ heta(x_t,t)|^2

ight] Et,x0,ϵ[∥ϵ−ϵθ(xt,t)∥2]

其中 ϵ θ epsilon_ heta ϵθ是网络预测的噪声。

4.3 潜在扩散模型

Stable Diffusion等模型在潜在空间中进行扩散:

编码器将图像压缩到潜在空间: z = E ( x ) z = mathcal{E}(x) z=E(x)

在潜在空间进行扩散过程

解码器将潜在表示重建为图像: x ^ = D ( z ) hat{x} = mathcal{D}(z) x^=D(z)

这样大大降低了计算复杂度。

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

推荐使用以下环境进行AI作画开发:

conda create -n ai_art python=3.8

conda activate ai_art

pip install torch torchvision torchaudio

pip install diffusers transformers accelerate

pip install matplotlib numpy Pillow

5.2 使用Stable Diffusion生成图像

以下是使用Hugging Face的diffusers库生成图像的完整代码:

import torch

from diffusers import StableDiffusionPipeline

from PIL import Image

# 加载预训练模型

model_id = "runwayml/stable-diffusion-v1-5"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to("cuda")

# 生成图像

prompt = "a beautiful sunset over mountains, digital art, highly detailed"

negative_prompt = "blurry, low quality, distorted"

# 生成多张图像

images = pipe(

prompt=prompt,

negative_prompt=negative_prompt,

height=512,

width=512,

num_images_per_prompt=4,

num_inference_steps=50,

guidance_scale=7.5

).images

# 保存结果

for i, img in enumerate(images):

img.save(f"generated_image_{

i}.png")

5.3 代码解读与分析

模型加载:从Hugging Face加载预训练的Stable Diffusion模型,使用半精度浮点数(float16)减少内存占用

提示词工程:

prompt描述想要生成的内容

negative_prompt指定要避免的特征

生成参数:

height和width控制输出分辨率

num_images_per_prompt控制生成数量

num_inference_steps决定去噪步骤数

guidance_scale控制文本提示的影响强度

结果保存:将生成的PIL图像保存为文件

6. 实际应用场景

AI作画技术已经在多个领域展现出巨大潜力:

6.1 数字艺术创作

艺术家使用AI作为创意工具,快速生成概念草图

结合传统艺术技巧和AI生成,创造混合艺术作品

生成独特风格的艺术作品供展览和收藏

6.2 游戏开发

快速生成游戏角色、场景和道具的概念设计

创建多样化的NPC角色和敌人

生成环境纹理和材质

6.3 广告和营销

根据产品描述自动生成广告图像

创建个性化的营销素材

快速制作产品原型可视化

6.4 影视和动画

预可视化场景和角色设计

生成背景和概念艺术

创建分镜和故事板

6.5 教育和研究

可视化复杂概念和科学理论

生成历史场景的重建

创建教学辅助材料

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

《生成深度学习》- David Foster

《深度学习》- Ian Goodfellow等

《计算机视觉:算法与应用》- Richard Szeliski

7.1.2 在线课程

Coursera: Deep Learning Specialization (Andrew Ng)

Fast.ai: Practical Deep Learning for Coders

Udacity: AI Programming with Python

7.1.3 技术博客和网站

Hugging Face博客

Distill.pub

Google AI Blog

arXiv上的最新论文

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

Jupyter Notebook/Lab

VS Code with Python扩展

PyCharm Professional

7.2.2 调试和性能分析工具

PyTorch Profiler

TensorBoard

Weights & Biases

7.2.3 相关框架和库

PyTorch/TensorFlow

Diffusers

Transformers

KerasCV

7.3 相关论文著作推荐

7.3.1 经典论文

“Generative Adversarial Networks” (Goodfellow et al., 2014)

“Denoising Diffusion Probabilistic Models” (Ho et al., 2020)

“High-Resolution Image Synthesis with Latent Diffusion Models” (Rombach et al., 2022)

7.3.2 最新研究成果

Stable Diffusion系列论文

DALL-E 2和3的技术报告

Imagen和Parti的技术细节

7.3.3 应用案例分析

AI在数字艺术中的应用研究

生成模型在创意产业中的商业应用

AI辅助设计的工作流程优化

8. 总结:未来发展趋势与挑战

8.1 未来发展趋势

更高分辨率和质量:模型将能生成更高分辨率、更逼真的图像

多模态融合:结合文本、图像、音频和视频的跨模态生成

实时生成:减少推理时间,实现交互式创作

个性化风格:更好地理解和模仿特定艺术家的风格

3D内容生成:从2D图像生成扩展到3D模型和场景创建

8.2 面临挑战

版权和伦理问题:训练数据的使用权和生成内容的版权归属

偏见和公平性:模型中可能存在的社会和文化偏见

计算资源需求:训练和运行大型模型的高成本

可控性和可预测性:精确控制生成内容的细节仍具挑战

评估标准:缺乏客观评估生成艺术质量的统一标准

9. 附录:常见问题与解答

Q1: AI作画会取代人类艺术家吗?

A: AI更可能成为艺术家的工具而非替代品。它可以帮助艺术家快速探索创意,但真正的艺术创作仍然需要人类的情感、意图和审美判断。

Q2: 如何避免AI生成图像的版权问题?

A: 建议使用明确允许商业使用的模型(如Stable Diffusion),或使用自己训练的数据集。对于商业应用,应仔细阅读模型许可证。

Q3: 为什么我的AI生成的图像质量不高?

A: 可能原因包括:提示词不够具体、模型选择不当、参数设置不合理(如steps太少)、硬件限制等。尝试优化提示词、增加推理步骤或使用更强大的模型。

Q4: 训练自己的AI作画模型需要多少数据?

A: 这取决于模型大小和任务复杂度。微调现有模型可能只需几千张图像,而从零训练高质量模型可能需要数百万张精心筛选的图像。

Q5: AI作画中最耗资源的环节是什么?

A: 训练大型扩散模型需要大量GPU资源,可能需要数百甚至数千GPU小时。推理阶段相对较轻量,但生成高分辨率图像仍需要强大显卡。

10. 扩展阅读 & 参考资料

Goodfellow, I., et al. (2014). “Generative Adversarial Networks.” arXiv:1406.2661

Ho, J., et al. (2020). “Denoising Diffusion Probabilistic Models.” arXiv:2006.11239

Rombach, R., et al. (2022). “High-Resolution Image Synthesis with Latent Diffusion Models.” CVPR

OpenAI (2021). “DALL·E: Creating Images from Text.” OpenAI Blog

Stability AI (2022). “Stable Diffusion Public Release.” Stability.Ai

通过本文的全面介绍,我们看到了AI作画技术的强大潜力和广泛应用前景。随着技术的不断进步,AI将在艺术创作和视觉内容生成领域发挥越来越重要的作用,为人类创造力提供新的工具和可能性。

暂无评论内容