大模型压缩是解决其参数量庞大、部署成本高、推理效率低等问题的关键技术,通过减少模型规模的同时尽量保留性能,使其能在终端设备或资源有限的环境中应用。

一、大模型压缩的技术背景与目标

背景:GPT-4 参数量达万亿级,即使是 BERT-base 也有 1.1 亿参数,庞大的模型对硬件算力、存储和能耗提出极高要求,难以直接部署在边缘设备(如手机、嵌入式系统)或进行实时推理。

核心目标:

减少参数量:降低模型存储占用(如从 GB 级压缩到 MB 级)。

提升推理效率:减少计算量(如 FLOPs),加快推理速度。

保持模型性能:压缩后的模型精度损失需控制在可接受范围内(如 Top-1 准确率下降 < 2%)。

适配下游场景:支持多硬件平台(CPU、GPU、TPU、NPU 等)的高效部署。

二、大模型压缩的核心技术方法

1. 模型剪枝(Model Pruning)

通过移除冗余连接或参数,减少模型规模,分为结构化剪枝和非结构化剪枝。

非结构化剪枝(Unstructured Pruning):

原理:按权重绝对值大小剔除接近 0 的参数(如 L1/L2 范数筛选),保留关键连接。

示例:对 BERT 的 Attention 矩阵进行稀疏化,剔除 40% 参数后精度损失 < 1%。

优势:压缩率高(可达 90% 参数量减少),但需专用稀疏矩阵加速库(如 Sparsity AI)支持,否则推理速度提升有限。

结构化剪枝(Structured Pruning):

原理:以 “层、通道、神经元” 为单位删除,保持模型结构规整,无需特殊硬件支持。

典型方法:

通道剪枝(Channel Pruning):删除卷积层或 Transformer 层中不重要的通道(如 BERT 中剪枝 12 层 Transformer 的部分隐藏层通道)。

神经元剪枝(Neuron Pruning):剔除 Transformer 块中冗余的神经元(如 GPT 模型中剪枝 FFN 层的神经元)。

优势:可直接用现有推理框架部署,如剪枝后的 ResNet-50 在移动端推理速度提升 30%,参数量减少 40%。

2. 量化(Quantization)

将高精度浮点参数(如 FP32)转换为低精度表示(如 INT8、INT4),减少存储和计算开销。

常见量化方案:

INT8 量化:无需复杂校准,通用且高效,如 LLaMA 模型从 FP16 量化到 INT8 后,推理速度提升 2 倍,精度损失可忽略。

INT4 量化(LLM.int8 ()/QLoRA):通过混合精度量化(部分敏感层保持 FP16,其余转 INT4),在 LLM 中实现 “无损压缩”,如 7B 参数模型量化后仅需 3GB 显存,推理速度接近 FP16。

二值化(Binarization):将参数压缩为 + 1/-1,参数量减少 32 倍,但精度损失较大,主要用于轻量级模型(如 MobileBERT)。

工具支持:NVIDIA TensorRT、Intel Neural Compressor 等可自动实现量化,适配 GPU/CPU 加速。

3. 知识蒸馏(Knowledge Distillation, KD)

用大模型(教师模型)指导小模型(学生模型)学习,使小模型逼近大模型的性能。

核心策略:

软标签蒸馏:让学生模型学习教师模型的输出概率分布(如 BERT-large 蒸馏到 BERT-base,精度保留 95% 以上)。

中间层蒸馏:迁移教师模型的隐藏层特征(如 Transformer 的 Attention 分布),提升学生模型泛化能力。

典型案例:

DistilBERT:参数量减少 40%,推理速度提升 60%,保留 BERT-base 97% 的性能。

LLM 蒸馏:将万亿参数大模型蒸馏到 10 亿参数小模型,在问答任务上准确率接近大模型的 85%。

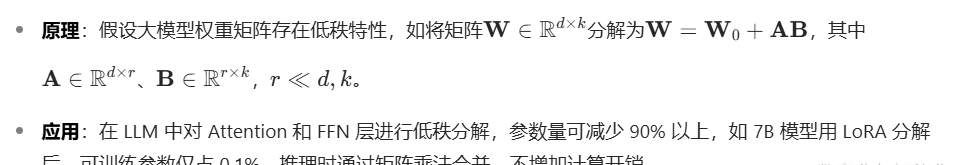

4. 低秩分解(Low-Rank Approximation)

将高维矩阵分解为低秩矩阵的乘积,减少参数量,典型方法如 LoRA(大模型微调中常用的低参微调技术,也可用于压缩)。

5. 模型架构优化与设计

从底层架构出发设计更高效的模型,而非直接压缩现有大模型。

典型方向:

稀疏激活架构:如 GShard、Switch Transformers,通过 MoE(混合专家)机制,让每个输入仅激活部分专家网络,减少实际计算量(如参数量 100B 的 MoE 模型,推理时仅需计算 10B 参数)。

轻量级模型结构:借鉴移动端架构设计,如用深度可分离卷积替代全连接层(如 MobileBERT),或优化 Transformer 结构(如 ALBERT 通过参数共享减少冗余)。

动态推理路径:根据输入复杂度自适应调整计算路径,如简单样本用浅层网络,复杂样本用深层网络(如 Dynamic BERT)。

三、大模型压缩的挑战与解决方案

挑战 1:压缩与精度的平衡

问题:过度压缩可能导致模型 “遗忘” 关键知识,如量化到 INT4 时,复杂推理任务(如数学解题)精度下降明显。

解决方案:

混合精度策略:对关键层(如 Attention 的 query、key 矩阵)保持高精度,非关键层用低精度量化。

动态压缩:根据任务难度自适应调整压缩率,如简单分类任务用 INT8,复杂生成任务用 INT16。

挑战 2:硬件适配与推理加速

问题:压缩后的模型可能无法被现有硬件高效支持(如非结构化剪枝需稀疏计算硬件,移动端 NPU 对低精度算子支持不足)。

解决方案:

硬件 – 算法协同设计:如 NVIDIA GPU 对 INT8/INT4 的 Tensor Core 加速,Google TPU 支持稀疏矩阵运算。

模型编译优化:通过 TVM、MLIR 等编译器将压缩模型转换为硬件特定的指令集,提升执行效率。

挑战 3:长序列与生成任务的压缩难度

问题:LLM 的生成任务依赖长距离依赖建模,压缩后容易出现生成流畅度下降、语义偏差等问题。

解决方案:

针对性蒸馏:在蒸馏时增加生成任务的损失函数(如交叉熵 + 困惑度损失),保留生成能力。

参数高效微调结合压缩:先通过 LoRA 等技术微调保留任务知识,再进行量化压缩,如 QLoRA 在微调同时完成 INT4 量化,减少精度损失。

四、大模型压缩的发展趋势

自动化压缩工具链:如 Hugging Face 的 Transformers 压缩库、微软的 NNI,支持 “一键压缩”,自动搜索最优剪枝 / 量化策略。

与参数高效微调结合:压缩与微调同步进行,如在 LoRA 微调过程中完成模型量化,减少多次训练开销。

边缘设备专用压缩方案:针对手机、IoT 设备,开发 “感知硬件的压缩算法”,如根据 CPU 算力动态调整模型复杂度(如苹果的 On-device LLM 压缩技术)。

多模态模型压缩:针对文生图、视频理解等多模态大模型,开发跨模态知识蒸馏与结构化剪枝方法,如 Stable Diffusion 压缩后可在消费级 GPU 上实时生成图像。

五、典型应用案例

LLM 压缩落地:

Mistral 7B:通过 INT8 量化后,可在消费级 GPU(如 RTX 3090)上部署,推理速度达 20 tokens/s。

ChatGLM-6B:采用模型并行 + 量化技术,在单张 RTX 3060(12GB 显存)上实现对话推理。

移动端 NLP 模型:

MobileBERT:在 Android 手机上进行文本分类任务,推理延迟 < 50ms,精度接近 BERT-base。

多模态模型压缩:

Stable Diffusion v1.5:通过通道剪枝 + INT8 量化,模型体积从 4GB 压缩到 1.5GB,在 MacBook M1 上生成图像时间从 15s 缩短到 5s。

大模型压缩已从 “牺牲精度换效率” 转向 “智能平衡”,通过剪枝、量化、蒸馏、架构优化等技术的融合,结合硬件加速与自动化工具,正逐步实现大模型在终端设备的轻量化部署。未来,随着 AI 芯片与压缩算法的协同发展,万亿参数模型有望在消费级设备上实现 “本地推理”,推动 AI 应用的普及。

暂无评论内容