Google Cloud 监控与日志:使用Stackdriver实现运维可视化

关键词:Google Cloud Platform (GCP)、Stackdriver、Cloud Monitoring、Cloud Logging、运维可视化、指标监控、日志分析

摘要:本文深入解析如何利用Google Cloud的Stackdriver(现整合为Google Cloud Monitoring和Cloud Logging)构建高效的运维监控体系。通过分步讲解核心概念、技术原理、实战案例及最佳实践,展示如何实现基础设施与应用的全链路监控、日志管理及可视化分析,帮助运维与开发团队提升故障排查效率、优化资源利用率并保障系统稳定性。

1. 背景介绍

1.1 目的和范围

随着云计算的普及,企业对基础设施和应用的监控需求日益复杂。Google Cloud的Stackdriver提供了一套集成的监控与日志解决方案,帮助用户实时洞察系统状态、快速定位故障并优化性能。本文将涵盖以下内容:

Stackdriver核心组件(Cloud Monitoring、Cloud Logging)的技术原理

从指标采集到日志分析的全流程操作指南

基于Python的实战案例与可视化仪表盘搭建

典型应用场景与最佳实践

1.2 预期读者

本文适合以下人群:

负责GCP环境运维的DevOps工程师

希望优化应用性能的开发人员

已关注云计算监控最佳实践的技术管理者

1.3 文档结构概述

全文分为核心概念、技术原理、实战操作、应用场景等模块,通过理论结合实践的方式,逐步讲解如何利用Stackdriver实现运维可视化。关键技术点包含指标体系设计、日志结构化处理、警报策略配置及数据可视化。

1.4 术语表

1.4.1 核心术语定义

Stackdriver:Google Cloud提供的云端监控与日志服务,现整合为Cloud Monitoring和Cloud Logging,支持基础设施、应用及第三方服务的监控。

指标(Metric):反映系统状态的量化数据,如CPU使用率、请求延迟、错误率等。

日志(Log):系统运行时产生的事件记录,包含文本、结构化数据或二进制信息。

仪表盘(Dashboard):通过可视化图表展示监控指标的界面,支持自定义布局与实时更新。

警报策略(Alert Policy):基于指标阈值或日志模式设置的自动通知规则,用于触发故障预警。

1.4.2 相关概念解释

时间序列数据(Time Series Data):按时间顺序记录的一系列数据点,是监控指标的存储形式。

标签(Label):用于标识资源属性的键值对,如project=my-project、region=us-central1,支持指标与日志的过滤和分组。

日志路由器(Log Router):将日志路由到不同目的地(如Cloud Storage、BigQuery、Pub/Sub)的配置规则,用于日志的分级处理。

1.4.3 缩略词列表

| 缩写 | 全称 |

|---|---|

| GCP | Google Cloud Platform |

| VM | Virtual Machine |

| HTTP | Hypertext Transfer Protocol |

| API | Application Programming Interface |

| SDK | Software Development Kit |

2. 核心概念与联系

2.1 Stackdriver架构解析

Stackdriver由两大核心服务组成:Cloud Monitoring(监控服务)和Cloud Logging(日志服务),二者通过统一的控制台和API实现数据联动。下图展示了其核心架构:

2.1.1 Cloud Monitoring核心功能

指标采集:自动收集GCP资源(VM、Cloud SQL、Kubernetes)的基础指标,支持自定义应用指标(如业务API调用量)。

警报管理:通过阈值规则或机器学习算法检测异常,支持邮件、Slack、PagerDuty等通知渠道。

可视化分析:提供预定义仪表盘和自定义图表,支持时间序列对比、聚合计算(如平均值、百分位数)。

2.1.2 Cloud Logging核心功能

日志收集:统一管理GCP服务、自定义应用及第三方工具(如Docker、NGINX)的日志。

日志查询:支持SQL-like语法过滤日志,提取关键信息(如错误堆栈、请求参数)。

日志路由:根据日志级别(INFO、ERROR)或标签将日志路由到不同存储或分析平台,例如将ERROR日志发送到BigQuery进行深度分析。

2.2 指标与日志的联动关系

监控指标与日志是运维可视化的两大核心数据源:

指标适合展示趋势性数据(如CPU使用率随时间变化),用于快速判断系统整体状态。

日志提供详细事件记录(如请求参数、错误详情),用于故障根因分析。

通过标签关联(如为同一VM实例的指标和日志添加相同instance_id标签),可实现“指标发现异常→日志定位具体事件”的闭环排查流程。

3. 核心算法原理 & 具体操作步骤

3.1 指标采集与处理原理

3.1.1 指标类型

Cloud Monitoring支持三种指标类型:

GCP内置指标:如compute.googleapis.com/instance/cpu/utilization(VM CPU使用率),由GCP自动生成。

自定义指标:通过API或SDK上报的应用级指标,例如app.googleapis.com/api/request_latency。

衍生指标:基于现有指标计算的新指标,如通过rate(metric.count, 60s)计算每分钟请求速率。

3.1.2 数据聚合算法

时间序列数据在存储时会按时间窗口聚合,常用算法包括:

平均值(Mean): Mean = ∑ i = 1 n x i n ext{Mean} = frac{sum_{i=1}^n x_i}{n} Mean=n∑i=1nxi

百分位数(Percentile):如95%延迟(P95)表示95%的请求延迟低于该值,计算公式为排序后取第0.95×n个数据点。

累计值(Cumulative):指标在一段时间内的累加值,如总请求数,通过delta(metric.cumulative, 60s)转换为速率。

3.1.3 自定义指标上报(Python示例)

使用GCP Python SDK上报应用自定义指标:

from google.cloud import monitoring_v3

from google.protobuf import timestamp_pb2

def report_custom_metric(project_id, instance_id, metric_name, value):

client = monitoring_v3.MetricServiceClient()

project_name = f"projects/{

project_id}"

# 定义指标类型

metric_type = f"custom.googleapis.com/{

metric_name}"

# 定义时间戳

now = timestamp_pb2.Timestamp()

now.GetCurrentTime()

# 定义资源标签

resource = monitoring_v3.Resource(

type="gce_instance",

labels={

"instance_id": instance_id,

"zone": "us-central1-a"

}

)

# 创建时间序列数据点

point = monitoring_v3.Point(

interval=monitoring_v3.TimeInterval(

start_time=now,

end_time=now

),

value=monitoring_v3.TypedValue(double_value=value)

)

# 上报指标

client.create_time_series(

name=project_name,

time_series=[{

"metric": {

"type": metric_type},

"resource": resource,

"points": [point]

}]

)

# 使用示例:上报API请求延迟

report_custom_metric(

project_id="my-project",

instance_id="vm-123",

metric_name="api_latency_ms",

value=50.2

)

3.2 日志结构化处理与查询

3.2.1 日志结构化原理

Cloud Logging支持将非结构化日志(如JSON格式)转换为结构化数据,便于查询和分析。核心步骤:

日志摄入:通过GCP SDK、API或代理(如Fluentd)将日志发送到Cloud Logging。

字段提取:使用日志路由器的jsonPayload字段解析JSON日志,或通过正则表达式提取关键信息(如HTTP状态码)。

标签关联:为日志添加自定义标签(如environment=prod、service=user-service),便于后续过滤。

3.2.2 日志查询语法(LogQL)

LogQL是Cloud Logging的查询语言,支持类似SQL的语法。示例:

查询ERROR级别的日志并包含“database connection failed”关键词:

logName="projects/my-project/logs/app_log"

severity=ERROR

textPayload:"database connection failed"

统计过去1小时内各服务的错误次数:

severity=ERROR

| groupBy [service], count()

| orderBy count() desc

3.2.3 日志路由配置(控制台操作)

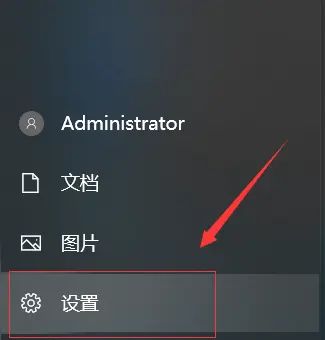

进入GCP控制台→Cloud Logging→日志路由器。

点击“创建日志路由器”,设置过滤条件(如severity>=ERROR)。

选择目标(如BigQuery数据集、Cloud Storage存储桶),完成路由规则配置。

4. 数学模型和公式 & 详细讲解 & 举例说明

4.1 警报策略的阈值计算模型

警报策略通常基于指标的阈值判断,常用模型包括:

4.1.1 固定阈值模型

直接设置绝对阈值,如“CPU使用率>80%持续5分钟”。数学表达式为:

Alert = { 触发 Mean ( X t ) > T 且持续时间 ≥ Δ t 正常 否则 ext{Alert} = egin{cases} ext{触发} & ext{Mean}(X_t) > T ext{ 且持续时间} geq Delta t \ ext{正常} & ext{否则} end{cases} Alert={

触发正常Mean(Xt)>T 且持续时间≥Δt否则

其中, X t X_t Xt为时间窗口内的指标数据, T T T为阈值, Δ t Delta t Δt为持续时间。

举例:当VM的CPU使用率连续5分钟超过80%时触发警报。

4.1.2 动态阈值模型(基于标准差)

通过历史数据计算均值 μ mu μ和标准差 σ sigma σ,设置动态阈值 μ + k σ mu + ksigma μ+kσ,其中 k k k为置信系数(通常取2或3)。公式:

Upper Threshold = μ + k σ ext{Upper Threshold} = mu + ksigma Upper Threshold=μ+kσ

Lower Threshold = μ − k σ ext{Lower Threshold} = mu – ksigma Lower Threshold=μ−kσ

举例:某API的响应时间均值为50ms,标准差10ms,设置3σ上限为80ms,当响应时间持续超过80ms时触发警报。

4.1.3 基于机器学习的异常检测

使用时间序列预测模型(如Prophet、ARIMA)预测指标的正常范围,当实际值超出预测区间时触发警报。数学上通过计算预测值 y ^ t hat{y}_t y^t和置信区间 [ y ^ t − CI , y ^ t + CI ] [hat{y}_t – ext{CI}, hat{y}_t + ext{CI}] [y^t−CI,y^t+CI]实现。

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

5.1.1 所需工具

GCP账号:具备Cloud Monitoring和Cloud Logging访问权限。

Python环境:3.7+版本,安装GCP SDK:

pip install google-cloud-monitoring google-cloud-logging

IDE:推荐PyCharm或VS Code,支持GCP插件。

5.1.2 认证配置

通过服务账号认证:

在GCP控制台创建服务账号,下载JSON密钥文件。

设置环境变量:

export GOOGLE_APPLICATION_CREDENTIALS="/path/to/key.json"

5.2 源代码详细实现和代码解读

5.2.1 案例场景:微服务监控系统

实现一个Python微服务,包含以下功能:

上报自定义指标(请求量、响应时间)

记录结构化日志(请求详情、错误信息)

通过Cloud Monitoring仪表盘展示关键指标

5.2.2 核心代码实现

5.2.2.1 指标上报模块(metrics.py)

from google.cloud import monitoring_v3

import time

class MetricReporter:

def __init__(self, project_id, service_name):

self.project_id = project_id

self.service_name = service_name

self.client = monitoring_v3.MetricServiceClient()

self.project_name = f"projects/{

project_id}"

# 定义指标类型

self.request_count_metric = "custom.googleapis.com/service/request_count"

self.latency_metric = "custom.googleapis.com/service/request_latency_ms"

def report_request_metric(self, instance_id, count, latency):

now = monitoring_v3.Timestamp()

now.GetCurrentTime()

# 定义资源标签(以GCE实例为例)

resource = monitoring_v3.Resource(

type="gce_instance",

labels={

"instance_id": instance_id,

"zone": "us-central1-a"

}

)

# 上报请求计数指标

point_count = monitoring_v3.Point(

interval=monitoring_v3.TimeInterval(

start_time=now,

end_time=now

),

value=monitoring_v3.TypedValue(int64_value=count)

)

# 上报延迟指标

point_latency = monitoring_v3.Point(

interval=monitoring_v3.TimeInterval(

start_time=now,

end_time=now

),

value=monitoring_v3.TypedValue(double_value=latency)

)

# 批量创建时间序列

self.client.create_time_series(

name=self.project_name,

time_series=[

{

"metric": {

"type": self.request_count_metric},

"resource": resource,

"points": [point_count]

},

{

"metric": {

"type": self.latency_metric},

"resource": resource,

"points": [point_latency]

}

]

)

5.2.2.2 日志记录模块(logger.py)

import google.cloud.logging

from google.cloud.logging.handlers import StructuredLogHandler

import logging

class StructuredLogger:

def __init__(self, project_id, service_name):

self.client = google.cloud.logging.Client(project=project_id)

self.logger = self.client.logger(service_name)

self.handler = StructuredLogHandler()

# 配置Python原生logger

self.python_logger = logging.getLogger(service_name)

self.python_logger.setLevel(logging.INFO)

self.python_logger.addHandler(self.handler)

def log_request(self, request_id, method, path, status_code, instance_id):

# 结构化日志数据

log_entry = {

"request_id": request_id,

"method": method,

"path": path,

"status_code": status_code,

"service": self.service_name,

"instance_id": instance_id,

"severity": "INFO" if status_code < 400 else "ERROR"

}

self.logger.log_struct(log_entry)

def log_error(self, error_message, instance_id, stack_trace):

log_entry = {

"message": error_message,

"stack_trace": stack_trace,

"service": self.service_name,

"instance_id": instance_id,

"severity": "ERROR"

}

self.logger.log_struct(log_entry)

self.python_logger.error(error_message, exc_info=stack_trace)

5.2.2.3 微服务主程序(main.py)

from flask import Flask, request, jsonify

import uuid

import time

from metrics import MetricReporter

from logger import StructuredLogger

app = Flask(__name__)

project_id = "my-project"

service_name = "user-service"

instance_id = "vm-123" # 动态获取实例ID(实际中通过元数据服务器获取)

# 初始化监控和日志客户端

metric_reporter = MetricReporter(project_id, service_name)

structured_logger = StructuredLogger(project_id, service_name)

@app.route("/api/user", methods=["GET"])

def get_user():

request_id = str(uuid.uuid4())

start_time = time.time()

try:

# 模拟业务逻辑

if request.args.get("error"):

raise ValueError("Invalid user ID")

response = {

"user_id": "123", "name": "John Doe"}

status_code = 200

except Exception as e:

status_code = 500

structured_logger.log_error(

error_message=str(e),

instance_id=instance_id,

stack_trace=repr(e.__traceback__)

)

latency = (time.time() - start_time) * 1000 # 转换为毫秒

metric_reporter.report_request_metric(

instance_id=instance_id,

count=1,

latency=latency

)

structured_logger.log_request(

request_id=request_id,

method=request.method,

path=request.path,

status_code=status_code,

instance_id=instance_id

)

return jsonify(response), status_code

if __name__ == "__main__":

app.run(host="0.0.0.0", port=8080)

5.3 代码解读与分析

指标上报逻辑:每次请求处理后,通过MetricReporter上报请求计数和延迟指标,标签instance_id和zone确保指标与具体资源关联。

结构化日志:使用StructuredLogHandler将日志转换为JSON格式,包含请求ID、状态码等关键信息,便于后续查询和分析。

异常处理:捕获业务异常并记录详细错误日志,包含堆栈跟踪,帮助快速定位代码问题。

6. 实际应用场景

6.1 基础设施监控

场景:监控GCP虚拟机(VM)、Cloud SQL数据库、Kubernetes集群的CPU、内存、网络IO等基础指标。

实现:通过Cloud Monitoring预定义仪表盘查看资源利用率,设置警报策略(如内存使用率>90%触发通知)。

6.2 分布式系统故障排查

场景:微服务架构中,某API响应时间突然升高,通过监控指标发现某实例CPU使用率异常,结合该实例的日志定位到数据库连接池耗尽问题。

操作:

在Cloud Monitoring中按service=user-service过滤指标,发现request_latency_ms的P95值超过阈值。

通过标签instance_id=vm-123关联到具体实例,查看Cloud Logging中该实例的ERROR日志,发现“SQL connection timeout”错误。

6.3 日志驱动的安全分析

场景:检测登录日志中的异常IP访问模式,通过日志路由器将severity=INFO且包含“login”关键词的日志路由到BigQuery,使用SQL分析高频登录失败的IP地址。

查询示例:

SELECT

jsonPayload.remote_ip,

COUNT(*) AS failed_attempts

FROM `my-project.logs.auth_log`

WHERE

severity=ERROR

AND jsonPayload.message="Login failed"

GROUP BY jsonPayload.remote_ip

HAVING failed_attempts > 100

6.4 成本优化与资源调度

场景:通过监控闲置资源(如长期低CPU使用率的VM),结合日志中的资源使用记录,自动触发缩容操作或迁移到更低配置的实例。

策略:设置“CPU使用率<10%持续24小时”的警报,联动Cloud Scheduler执行脚本释放资源。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

《Google Cloud Platform in Action》:涵盖GCP核心服务,包括监控与日志的实战指南。

《Observability in Action》:讲解如何通过指标、日志、追踪实现系统可观测性,适用于分布式系统。

7.1.2 在线课程

Coursera – Google Cloud Professional Cloud Architect:包含监控与运维模块,官方认证课程。

Pluralsight – Google Cloud Monitoring and Logging Essentials:专注于Stackdriver的深度应用。

7.1.3 技术博客和网站

Google Cloud官方博客:获取最新功能更新和最佳实践。

Cloud Monitoring文档:官方技术文档,包含API参考和配置指南。

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

Cloud Shell:GCP内置的Web IDE,预装GCP SDK,支持快速访问监控与日志服务。

PyCharm/VS Code:通过插件支持GCP认证和代码补全,提升开发效率。

7.2.2 调试和性能分析工具

Stackdriver Debugger:实时查看应用代码变量状态,无需重启服务,支持Java、Python等语言。

Stackdriver Profiler:分析CPU和内存使用情况,定位性能瓶颈,生成火焰图和调用栈。

7.2.3 相关框架和库

Google Cloud Client Libraries:支持多种编程语言(Python、Java、Node.js),简化监控与日志API的调用。

Fluentd:开源日志收集工具,通过插件支持GCP Logging,适用于混合云环境的日志聚合。

7.3 相关论文著作推荐

7.3.1 经典论文

《The Datacenter as a Computer》:探讨大规模数据中心的监控与管理,提出分布式系统设计原则。

《SRE: Google’s Practical Guide to Reliable and Scalable Systems》:运维工程圣经,包含监控指标设计(如SLI/SLO/SLA)的最佳实践。

7.3.2 最新研究成果

Google Cloud官方技术报告:《Modern Observability with Cloud Monitoring》,讲解如何利用AI驱动的异常检测提升监控效率。

7.3.3 应用案例分析

Spotify使用Stackdriver监控微服务架构:案例分析分布式系统中的监控挑战与解决方案。

8. 总结:未来发展趋势与挑战

8.1 发展趋势

AI驱动的智能监控:利用机器学习自动识别异常模式(如季节性波动、突发流量),减少人工阈值配置成本。

全链路追踪整合:结合Cloud Trace实现从用户请求到后端服务的全链路监控,打通指标、日志与追踪数据。

Serverless监控深化:针对Cloud Functions、Cloud Run等无服务器架构,提供更细粒度的执行环境监控(如冷启动时间、并发数限制)。

8.2 挑战与应对

多云环境统一监控:企业采用多云策略时,需解决不同云厂商监控数据的整合问题,建议通过OpenTelemetry标准实现跨平台指标和日志的统一采集。

日志规模爆炸:随着微服务和物联网设备的普及,日志量呈指数级增长,需通过日志分级存储(如将低频访问的历史日志归档到Cloud Storage)和智能过滤(仅保留高价值日志)优化成本。

实时性要求提升:关键业务需要亚秒级的监控延迟,需利用Cloud Monitoring的实时指标流处理能力和日志实时路由功能。

9. 附录:常见问题与解答

Q1:如何减少监控指标的上报延迟?

A:确保GCP SDK版本为最新,使用批量上报接口(如create_time_series支持一次上传多个指标),并将客户端与被监控资源部署在同区域以降低网络延迟。

Q2:日志查询时中文日志乱码如何处理?

A:Cloud Logging自动处理UTF-8编码日志,乱码通常是由于日志生成时未正确设置编码格式。建议在应用中使用utf-8编码记录日志,避免二进制数据直接写入文本日志。

Q3:自定义指标的存储期限是多久?

A:默认情况下,自定义指标的存储期限为30天,可通过GCP控制台的“指标保留策略”调整,最长支持635天(约1.7年)。

Q4:如何监控本地数据中心与GCP混合部署的环境?

A:使用OpenCensus或OpenTelemetry收集本地指标和日志,通过GCP SDK或Pub/Sub发送到Cloud Monitoring和Cloud Logging,确保标签格式与GCP资源统一。

10. 扩展阅读 & 参考资料

Google Cloud Monitoring官方文档

Google Cloud Logging官方文档

OpenTelemetry官网

Stackdriver API参考

通过以上实践,企业可构建覆盖“监控数据采集→分析处理→可视化展示→自动化响应”的完整运维体系,实现从被动故障处理到主动性能优化的转型。Stackdriver的深度整合能力与灵活扩展特性,使其成为GCP环境下运维可视化的核心工具,助力企业提升系统可靠性与开发效率。

暂无评论内容