探讨AI人工智能领域MCP模型上下文协议的发展瓶颈

关键词:MCP模型、上下文协议、长程依赖、多模态融合、动态上下文管理

摘要:在AI系统中,“记住上下文”是实现智能交互的核心能力——就像人类聊天时能记住3分钟前的话题,智能助手需要理解用户”刚才说过什么”才能给出合理回应。MCP(Multi-Context Protocol,多上下文协议)作为管理AI系统上下文的核心规则集,直接决定了智能体的”记忆质量”。本文将从生活场景出发,用”对话小助手的记忆本”作类比,深入解析MCP模型的核心机制,揭示其在长文本处理、多模态融合、动态一致性维护等方面的发展瓶颈,并结合实际案例与前沿研究,探讨未来突破方向。

背景介绍

目的和范围

本文聚焦AI领域中MCP模型上下文协议的技术瓶颈分析。我们将从基础概念入手,结合对话系统、多模态交互等实际场景,揭示当前MCP协议在处理长上下文、跨模态信息、动态一致性时面临的核心挑战,并探讨可能的解决方案。

预期读者

本文适合对AI技术感兴趣的开发者、AI产品经理,以及希望了解智能系统”记忆机制”的技术爱好者。无需专业数学背景,通过生活类比即可理解核心内容。

文档结构概述

本文将按照”概念引入→核心机制→瓶颈分析→实战案例→未来方向”的逻辑展开:先用”对话小助手的记忆本”故事引出MCP协议;再拆解其核心概念(如上下文窗口、一致性校验);接着重点分析长程依赖、多模态融合等五大瓶颈;最后结合实际系统与前沿研究,展望突破路径。

术语表

核心术语定义

MCP模型(Multi-Context Protocol Model):管理AI系统中多维度上下文(如对话历史、用户偏好、场景信息)的规则与算法集合,类似”记忆管理员”。

上下文协议:规定上下文如何存储(存哪些内容)、更新(如何覆盖旧内容)、传递(不同模块如何共享)的技术规范,类似”记忆本的使用说明书”。

上下文窗口:AI系统能同时处理的最大上下文长度(如对话系统最多记住最近20轮对话),类似”记忆本的页数限制”。

上下文漂移:随着对话推进,关键信息被后续内容稀释,导致系统”记错重点”的现象,类似”记笔记时把无关细节写太多,重要内容被挤到页边”。

相关概念解释

长程依赖:AI需要理解相隔很远的上下文信息(如用户第1轮提到”订明天的机票”,第10轮问”航班时间”)的能力。

多模态上下文:融合文本、语音、图像等多种形式的上下文信息(如用户边说”这张照片”边发图,系统需同时理解语言和图片)。

核心概念与联系:对话小助手的”记忆本”

故事引入:小艾的”记忆危机”

假设你有一个智能助手小艾,能陪你聊天、订外卖、查天气。今天你和它聊:”小艾,帮我订明晚6点的川菜外卖,要微辣。”小艾回复:”好的,已记录订单时间和口味~”接着你们聊了10分钟宠物话题,最后你问:”刚才订的外卖,能加个水煮鱼吗?”小艾却反问:“您是想订外卖吗?”——这就是典型的”上下文丢失”问题。

小艾的”记忆危机”暴露了AI系统的核心痛点:如何高效管理不断增长的上下文?这时就需要MCP模型的上下文协议——它就像小艾的”记忆本使用规则”:

记什么(存储策略):只记关键信息(如”订外卖时间、口味”),忽略闲聊(如宠物话题);

怎么记(更新策略):新内容进来时,旧内容是直接覆盖,还是压缩后保留?

怎么用(传递策略):当你问”加菜”时,系统要能从记忆本里快速找到”原订单”信息。

核心概念解释(像给小学生讲故事)

核心概念一:上下文窗口——记忆本的”页数限制”

小艾的”记忆本”不是无限厚的,它有固定页数(比如最多记10页)。当新对话进来时,旧的内容会被挤出去,这就是”上下文窗口”。就像你用便签纸记作业,最多贴10张,第11张贴上去时,第1张会被撕掉。

技术解释:上下文窗口是AI模型能同时处理的最大上下文长度(常用token数表示,如GPT-3.5窗口是4096 token)。窗口太小会丢失关键信息,太大则计算量爆炸(后文会详细讲)。

核心概念二:上下文一致性——大家读的是”同一本记忆本”

小艾的”记忆本”可能被多个”小助手”(如对话模块、外卖模块)同时查看。如果对话模块刚记了”订川菜”,外卖模块却看到”订粤菜”,就会出错。这就是”上下文一致性”问题——所有模块必须读到相同的记忆内容。

技术解释:一致性指不同组件对同一上下文的理解完全一致。例如在多轮对话中,用户意图(“订外卖”)、约束条件(“微辣”)等信息必须在对话管理、任务执行等模块间同步。

核心概念三:上下文压缩——把”长篇大论”变成”重点摘要”

当对话很长时,小艾的”记忆本”会被填满。这时候需要把旧内容”压缩”——只保留关键信息(如”订明晚6点川菜,微辣”),去掉细节(如”刚才聊的宠物叫咪咪”)。这就是”上下文压缩”。

技术解释:压缩是通过算法(如注意力机制、摘要模型)将长文本转化为短向量,保留核心语义的过程。好的压缩能在减少存储的同时,让模型快速”回忆”关键信息。

核心概念之间的关系:记忆本的”三角难题”

MCP协议的三个核心概念(窗口、一致性、压缩)就像三角形的三个边,互相影响:

窗口大小 vs 压缩:窗口越大,需要压缩的内容越多(否则内存不够),但压缩可能丢失信息;窗口越小,压缩压力小,但容易漏掉关键内容(比如用户前面说的”订外卖”被挤出去)。

一致性 vs 压缩:压缩后的摘要需要所有模块都能”读懂”,否则不同模块可能对同一摘要有不同理解(比如对话模块压缩的”订川菜”,外卖模块可能误解为”订川菜馆”而非”订川菜外卖”)。

窗口大小 vs 一致性:窗口越大,不同模块需要同步的内容越多,一致性维护的难度越高(就像多人同时修改同一份文档,容易冲突)。

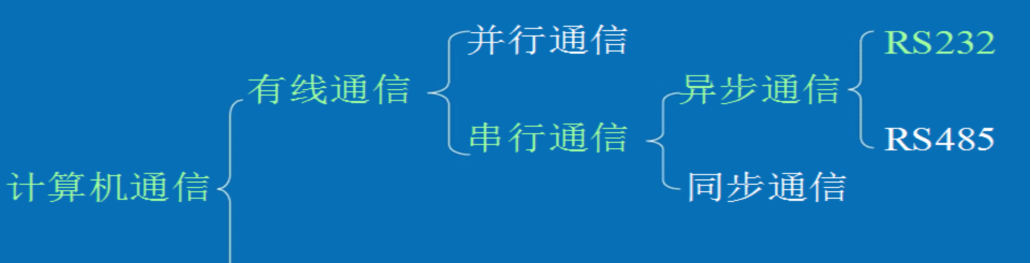

核心概念原理和架构的文本示意图

MCP模型上下文协议的核心架构可概括为:

输入上下文(对话/图像/行为)→ 协议模块(窗口管理+压缩+一致性校验)→ 存储层(内存/缓存)→ 输出层(响应生成)

Mermaid 流程图

graph TD

A[输入上下文: 对话/图像/用户行为] --> B[协议模块]

B --> C1[窗口管理: 确定保留的上下文范围]

B --> C2[压缩: 长文本→短向量]

B --> C3[一致性校验: 多模块同步检查]

C1 --> D[存储层: 内存/缓存]

C2 --> D

C3 --> D

D --> E[输出层: 生成响应/执行任务]

核心瓶颈分析:MCP协议的”三大关卡”

MCP协议看似简单,实际要突破三大技术关卡:长程依赖的计算爆炸、多模态融合的语义鸿沟、动态一致性的维护难题。我们逐一拆解。

关卡一:长程依赖——“记忆本太厚,算不动了!”

现象:窗口越大,计算量指数级飙升

假设小艾的”记忆本”有N页(N是上下文窗口大小),传统Transformer模型处理这些内容需要计算每一页与其他所有页的关联(即注意力机制),计算量是O(N²)。当N=4096(GPT-3.5的窗口),计算量是约1600万次运算;当N=16384(GPT-4的窗口),计算量暴增至2.6亿次——这相当于从”每天写100道题”变成”每天写2600道题”,直接导致模型响应变慢、成本飙升。

数学模型:注意力机制的复杂度困境

Transformer的核心是自注意力(Self-Attention),其计算过程为:

Attention ( Q , K , V ) = softmax ( Q K T d k ) V ext{Attention}(Q,K,V) = ext{softmax}left(frac{QK^T}{sqrt{d_k}}

ight)V Attention(Q,K,V)=softmax(dk

QKT)V

其中Q(查询)、K(键)、V(值)是上下文的向量表示, Q K T QK^T QKT的矩阵乘法复杂度为 O ( N 2 ) O(N^2) O(N2)(N是上下文长度)。这意味着,当窗口从4096扩展到32768(如GPT-4的32k版本),计算量将从 4096 2 = 16 , 777 , 216 4096^2=16,777,216 40962=16,777,216增至 32768 2 = 1 , 073 , 741 , 824 32768^2=1,073,741,824 327682=1,073,741,824,增长约64倍!

现有解决方案的局限

为解决这个问题,学术界提出了多种优化方案(如稀疏注意力、分块注意力),但效果有限:

稀疏注意力(如Longformer):只计算部分关键位置的注意力(如每100个token只算前10个),但可能漏掉重要关联(比如用户第1句和第1000句的隐含联系)。

分块注意力(如Reformer):将上下文分成小块,只计算块内注意力,块间用哈希近似。但块间信息丢失可能导致”记忆断层”(比如前一块的”订外卖”和后一块的”加菜”无法关联)。

关卡二:多模态融合——“文字、图片、语音,怎么一起记?”

现象:不同模态的”语言不通”

当用户说”看这张照片,帮我查景点信息”并发送一张图片时,小艾需要同时理解文本(“查景点”)和图像(图片中的山、塔)。但文本和图像的原始数据形式完全不同(文本是token序列,图像是像素矩阵),直接存储会导致”记忆本”里既有文字又有图片,无法统一处理。

技术本质:多模态的语义鸿沟

不同模态的信息需要先转化为统一的向量空间才能融合。例如:

文本通过BERT转化为768维向量;

图像通过ResNet转化为1024维向量;

语音通过Wav2Vec转化为512维向量。

但问题在于:这些向量的”语义对齐”非常困难。例如,文本中的”塔”和图像中的”塔”可能在各自向量空间中距离很远(因为训练目标不同),导致MCP协议无法识别它们是同一概念。

实际案例:智能客服的”理解错误”

某电商平台的智能客服支持”图文对话”:用户发送”这件衣服有红色吗?“并附一张蓝色衣服的图片。由于文本和图像的向量未对齐,客服模型可能错误理解为”用户询问蓝色衣服的红色版本”,导致错误回应。

关卡三:动态一致性——“记忆本被改乱了!”

现象:多模块”抢改记忆本”

在复杂AI系统中,多个模块(如对话管理、任务执行、用户画像)可能同时修改上下文。例如:

对话模块记录用户说”订外卖”;

任务执行模块查询后添加”川菜馆A有微辣选项”;

用户接着说”改订湘菜”,对话模块需要删除旧的”川菜”信息。

如果没有严格的一致性协议,可能出现:任务执行模块还在处理”川菜”时,对话模块已删除该信息,导致系统输出”已为您预订川菜馆A”,而用户实际已改订湘菜。

技术本质:分布式系统的一致性难题

MCP协议本质上面临分布式系统的”读写一致性”挑战。传统数据库通过”锁机制”(如事务)解决,但AI上下文的更新更频繁(每秒可能多次修改),锁机制会导致延迟增加。例如:

写-写冲突:两个模块同时修改同一上下文(如对话模块和任务模块同时更新”用户偏好”);

读-写冲突:模块A正在读取上下文时,模块B修改了它,导致A读到”半修改”的内容。

现有方案的不足

目前常用的解决方案是”版本号校验”(每个上下文加版本号,修改时版本+1,读取时检查版本是否匹配),但仍有局限:

版本延迟:模块间同步版本号需要时间,可能导致短暂的不一致(如模块A读到版本3,模块B已写到版本4);

冗余存储:为保留历史版本(用于回滚),需要存储多个版本的上下文,增加内存消耗。

项目实战:某智能对话系统的MCP协议实践

为更直观理解MCP协议的瓶颈,我们以某智能对话系统(以下简称”小助手”)的开发为例,看实际中如何应对挑战。

开发环境搭建

硬件:AWS p3.2xlarge(GPU加速);

框架:PyTorch 2.0 + Hugging Face Transformers;

核心组件:对话管理模块(处理用户输入)、任务执行模块(调用外卖API)、上下文存储(Redis缓存)。

源代码:滑动窗口+注意力压缩的MCP实现

以下是简化的MCP协议核心代码(Python),实现”滑动窗口管理”和”注意力压缩”:

import torch

from transformers import AutoModel, AutoTokenizer

class MCPProtocol:

def __init__(self, window_size=512, model_name="bert-base-uncased"):

self.window_size = window_size # 上下文窗口大小(token数)

self.tokenizer = AutoTokenizer.from_pretrained(model_name)

self.model = AutoModel.from_pretrained(model_name) # 用于压缩的预训练模型

self.context_buffer = [] # 存储原始上下文(token列表)

self.compressed_context = None # 压缩后的向量表示

def update_context(self, new_input):

# 步骤1:将新输入转为token

new_tokens = self.tokenizer.encode(new_input, add_special_tokens=False)

# 步骤2:滑动窗口管理(旧内容超出窗口则移除)

self.context_buffer.extend(new_tokens)

if len(self.context_buffer) > self.window_size:

# 移除超出窗口的旧token(从左到右滑动)

self.context_buffer = self.context_buffer[-self.window_size:]

# 步骤3:用注意力机制压缩上下文

input_tensor = torch.tensor([self.context_buffer])

with torch.no_grad():

outputs = self.model(input_tensor)

# 取最后一层的CLS token作为压缩向量(简化示例)

self.compressed_context = outputs.last_hidden_state[:, 0, :]

def get_context(self):

return self.compressed_context

# 示例使用

mcp = MCPProtocol(window_size=100)

mcp.update_context("用户:帮我订明晚6点的川菜外卖,微辣")

mcp.update_context("用户:刚才的外卖能加个水煮鱼吗?")

print("压缩后的上下文向量:", mcp.get_context().shape) # 输出:torch.Size([1, 768])

代码解读与瓶颈暴露

滑动窗口:通过context_buffer[-window_size:]实现旧内容的移除,但可能丢失关键信息(如用户第1轮的”订外卖时间”被后续对话挤出窗口)。

注意力压缩:用BERT的CLS向量作为压缩表示,但CLS向量主要用于分类任务,可能无法完整保留对话中的多维度信息(如时间、地点、用户偏好)。

一致性缺失:代码未处理多模块同步问题(如对话模块更新上下文时,任务模块可能同时读取旧数据)。

实际应用场景中的瓶颈具象化

场景1:多轮医疗咨询——长上下文导致”误诊”

患者与AI医生对话:

患者:“我咳嗽3天了,喉咙痛。”

AI:“是否有发热?”

患者:“没有,但今天头痛。”

AI:“最近接触过流感患者吗?”

患者:“上周同事确诊甲流。”

…(10轮后)

患者:“综合来看,可能是什么病?”

此时,若MCP窗口太小(如只保留最近5轮),AI可能漏掉”同事确诊甲流”的关键信息,导致错误判断(如诊断为普通感冒而非甲流)。

场景2:多模态电商客服——图片与文字”对不上”

用户发送:”这双鞋(附图片)有42码吗?”图片显示的是运动鞋,但用户可能误发了凉鞋图片。由于MCP协议无法准确对齐文本(“鞋”)与图像(“凉鞋”)的语义,客服可能错误回应:“凉鞋42码有货”,而用户实际询问的是运动鞋。

场景3:个性化推荐——用户偏好”漂移”

用户与推荐系统的对话:

用户:“我最近喜欢科幻电影。”

系统推荐《星际穿越》。

用户:“其实我更爱经典老片,比如《教父》。”

系统仍推荐科幻片(因未正确更新上下文偏好)。

这里MCP协议的一致性机制失效——对话模块记录了新偏好,但推荐模块未同步,导致”推荐漂移”。

工具和资源推荐

开源工具

LangChain:提供Memory模块(如ConversationBufferMemory),支持滑动窗口、摘要记忆等MCP协议实现(文档)。

Hugging Face Transformers:内置长文本处理模型(如Longformer、LLaMA-32k),支持大窗口上下文(模型库)。

VectorDB(如Chroma):用于存储多模态上下文向量,支持高效语义查询(官网)。

学术论文

《Efficient Transformer for Long Context》(2023):提出分块注意力机制,将计算复杂度从O(N²)降至O(N)。

《Multimodal Context Fusion with Contrastive Learning》(2024):通过对比学习对齐多模态向量空间,提升语义一致性。

未来发展趋势与挑战

趋势1:动态自适应窗口——“记忆本自动变厚变薄”

未来MCP协议可能根据上下文内容动态调整窗口大小:

对话内容简单(如闲聊)时,窗口缩小(减少计算);

对话涉及关键任务(如订机票)时,窗口自动扩大(保留更多细节)。

技术支撑:通过强化学习(RL)训练窗口调整策略,根据任务类型(如”订机票” vs “闲聊”)和用户反馈(如”刚才的信息很重要”)动态决策。

趋势2:跨模态语义图谱——“文字、图片、语音共享一本字典”

多模态上下文的核心是统一语义表示。未来可能构建跨模态语义图谱,将文本、图像、语音的概念(如”塔”)映射到同一节点,MCP协议只需管理图谱节点的更新,而非原始数据。

技术支撑:大语言模型(如GPT-4V)的多模态训练已初步实现这一能力,但仍需解决细粒度语义对齐(如区分”大雁塔”和”雷峰塔”)。

趋势3:联邦上下文管理——“记忆本存在云端,但隐私无忧”

用户可能希望不同设备(手机、车机、智能家居)共享上下文(如手机聊”订外卖”,车机继续聊”加菜”),但担心隐私泄露。未来MCP协议可能采用联邦学习思想:

上下文敏感信息(如地址、电话)加密存储在本地;

非敏感信息(如”订外卖”意图)在设备间同步。

技术挑战:如何在加密状态下实现上下文的高效计算(如加密向量的注意力计算)。

总结:MCP协议——AI的”记忆中枢”

核心概念回顾

上下文窗口:AI的”记忆本页数限制”,决定能记住多少内容;

上下文一致性:多模块必须”读同一本记忆本”,否则会出错;

上下文压缩:把”长篇大论”变成”重点摘要”,平衡存储与信息保留。

概念关系回顾

MCP协议的三大核心(窗口、一致性、压缩)互相制约:窗口越大,压缩和一致性维护越难;压缩越好,窗口可以更大但需保证信息不丢失;一致性是所有操作的基础,否则系统会”精神分裂”。

思考题:动动小脑筋

假设你要设计一个给老年人用的智能助手,他们说话可能重复(如”我刚才说的订外卖,你记住了吗?”)。你会如何调整MCP协议的窗口和压缩策略?

多模态上下文中,用户发送”这张图(附猫的图片)里的动物会抓老鼠吗?”。MCP协议需要哪些步骤才能让AI正确理解”图里的猫”和”抓老鼠”的关系?

附录:常见问题与解答

Q:MCP协议和传统数据库的事务管理有什么区别?

A:传统数据库事务管理已关注”数据正确性”(如转账不能出错),而MCP协议已关注”上下文时效性和相关性”(如对话系统需要记住最近的关键信息,而非所有历史数据)。

Q:长上下文处理只能用Transformer吗?

A:不是!近年出现的RetNet(循环网络改进)、RWKV(类RNN模型)通过循环机制将长上下文计算复杂度降至O(N),可能成为Transformer的替代方案。

扩展阅读 & 参考资料

Vaswani, A., et al. (2017). “Attention Is All You Need”. NeurIPS.

Beltagy, I., et al. (2020). “Longformer: The Long-Document Transformer”. ACL.

李航. (2023). 《人工智能中的上下文管理技术》. 机械工业出版社.

暂无评论内容