是什么

Docker启动后,会产生一个名为docker0的虚拟网卡。

# ifconfig

docker0: flags=4099<UP,BROADCAST,MULTICAST> mtu 1500

inet 172.17.0.1 netmask 255.255.0.0 broadcast 172.17.255.255

inet6 fe80::42:28ff:fe21:1dcb prefixlen 64 scopeid 0x20<link>

ether 02:42:28:21:1d:cb txqueuelen 0 (Ethernet)

RX packets 2105 bytes 975889 (953.0 KiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 2205 bytes 583182 (569.5 KiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

......当安装了docker之后,默认会自动创建三个网络:bridge、host、none

查看docker网络模式:

[root@localhost ~]# docker network ls

NETWORK ID NAME DRIVER SCOPE

0c50f04c22f3 bridge bridge local

39dda2d8738a host host local

48e124df970f none null local常用基本命令

[root@localhost ~]# docker network --help

Usage: docker network COMMAND

Manage networks

Commands:

connect Connect a container to a network

create Create a network

disconnect Disconnect a container from a network

inspect Display detailed information on one or more networks

ls List networks

prune Remove all unused networks

rm Remove one or more networks

Run 'docker network COMMAND --help' for more information on a command.能干嘛

容器间的互联和通信以及端口映射。

容器IP变动时候可以通过服务名直接网络通信而不受影响。

网络模式

|

网络模式 |

简介 |

指定方式 |

|

bridge |

为每一个容器分配、配置IP等,并将容器连接到一个 docker0 虚拟网桥,默认为该模式 |

使用 –network bridge 指定,默认使用docker0 |

|

host |

容器将不会虚拟出自己的网卡,配置自己的IP等,而是使用宿主机的IP和端口 |

使用 –network host 指定 |

|

none |

容器有独立的 network namespace,但并没有对其进行任何网络设置,如分配 veth pair 和网桥连接,IP等。 |

使用 –network none 指定 |

|

container |

新创建的容器不会创建自己的网卡和配置自己的IP,而是和一个指定的容器共享IP、端口范围等。 |

使用 –network container:NAME或者容器ID指定 |

容器实例内默认网络IP产生规则:

使用同一个镜像启动两个容器 u1 和 u2,可以看到u1 IP为 172.17.0.2, u2 IP为 172.17.0.3,此时删除 u2 容器,重新启动一个 u3 看到 IP为 172.17.0.3 ,原本属于 u2 的IP重新落到了u3上,由此得出结论,docker容器内部的IP是有可能会发生改变的。

案例说明

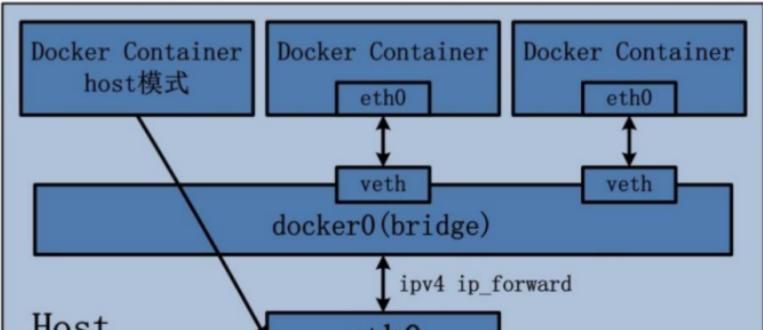

bridge

是什么?

Docker 服务默认会创建一个 docker0 网桥(其上有一个 docker0 内部接口),该桥接网络的名称为docker0,它在内核层连通了其他的物理或虚拟网卡,这就将所有容器和本地主机都放到同一个物理网络。Docker 默认指定了 docker0 接口 的 IP 地址和子网掩码,让主机和容器之间可以通过网桥相互通信。

查看 bridge 网络的详细信息,并通过 grep 获取名称项:

[root@localhost ~]# docker network inspect bridge |grep name

"com.docker.network.bridge.name": "docker0",

[root@localhost ~]# ifconfig |grep docker0

docker0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500案例

说明

1 Docker使用Linux桥接,在宿主机虚拟一个Docker容器网桥(docker0),Docker启动一个容器时会根据Docker网桥的网段分配给容器一个IP地址,称为Container-IP,同时Docker网桥是每个容器的默认网关。由于在同一宿主机内的容器都接入同一个网桥,这样容器之间就能够通过容器的Container-IP直接通信。

2 docker run 的时候,没有指定network的话默认使用的网桥模式就是bridge,使用的就是docker0。在宿主机ifconfig,就可以看到docker0和自己create的network(后面讲)eth0,eth1,eth2……代表网卡一,网卡二,网卡三……,lo代表127.0.0.1,即localhost,inet addr用来表明网卡的IP地址

3 网桥docker0创建一对对等虚拟设备接口一个叫veth,另一个叫eth0,成对匹配。

3.1 整个宿主机的网桥模式都是docker0,类似一个交换机有一堆接口,每个接口叫veth,在本地主机和容器内分别创建一个虚拟接口,并让他们彼此联通(这样一对接口叫veth pair);

3.2 每个容器实例内部也有一块网卡,每个接口叫eth0;

3.3 docker0上面的每个veth匹配某个容器实例内部的eth0,两两配对,一 一匹配。

通过上述,将宿主机上的所有容器都连接到这个内部网络上,两个容器在同一个网络下,会从这个网关下各自拿到分配的ip,此时两个容器的网络是互通的。

启动两个容器:

[root@localhost ~]# docker run -d -p 8081:8080 --name tomcat81 billygoo/tomcat8-jdk8

[root@localhost ~]# docker run -d -p 8082:8080 --name tomcat82 billygoo/tomcat8-jdk8查看宿主机网卡信息:

[root@localhost ~]# ip addr|tail -n 8

18: veth2348854@if17: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue master docker0 state UP group default

link/ether b2:6c:f4:38:ef:a1 brd ff:ff:ff:ff:ff:ff link-netnsid 0

inet6 fe80::b06c:f4ff:fe38:efa1/64 scope link

valid_lft forever preferred_lft forever

20: vetha2ead6f@if19: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue master docker0 state UP group default

link/ether 5e:89:03:49:e9:c7 brd ff:ff:ff:ff:ff:ff link-netnsid 1

inet6 fe80::5c89:3ff:fe49:e9c7/64 scope link

valid_lft forever preferred_lft forever

18->17:宿主机上的 18: veth2348854 指向的是 容器内的 if17

20->19:宿主机上的 20: vetha2ead6f 指向的是 容器内的 if19

在 tomcat81 容器内部查看网卡信息:

[root@localhost ~]# docker exec -it tomcat81 bash

root@9f6d32d9ee91:/usr/local/tomcat# ip addr

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

17: eth0@if18: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue state UP group default

link/ether 02:42:ac:11:00:02 brd ff:ff:ff:ff:ff:ff link-netnsid 0

inet 172.17.0.2/16 brd 172.17.255.255 scope global eth0

valid_lft forever preferred_lft forever17->18:tomcat81 容器内的17号网卡 17: eth0 指向的是宿主机的if18号网卡。

在 tomcat82 容器内部查看网卡信息:

[root@localhost ~]# docker exec -it tomcat82 bash

root@8597dfbc4c2f:/usr/local/tomcat#

root@8597dfbc4c2f:/usr/local/tomcat# ip addr

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

19: eth0@if20: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue state UP group default

link/ether 02:42:ac:11:00:03 brd ff:ff:ff:ff:ff:ff link-netnsid 0

inet 172.17.0.3/16 brd 172.17.255.255 scope global eth0

valid_lft forever preferred_lft forever19->20:tomcat82 容器内的19号网卡 19: eth0 指向的是宿主机的if20号网卡。

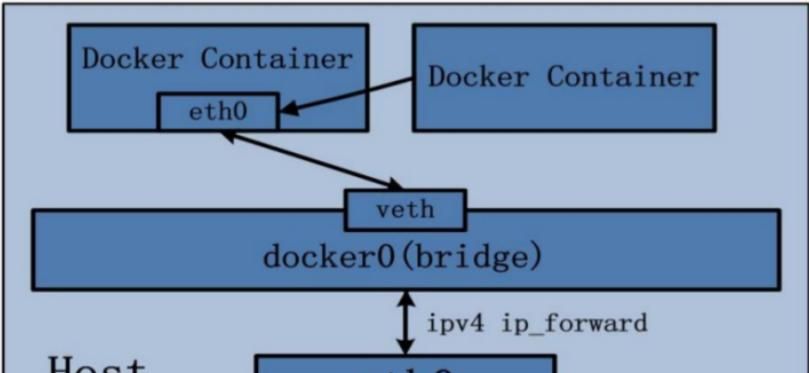

host

是什么

直接使用宿主机的 IP 地址与外界进行通信,不再需要额外进行NAT 转换。

案例

容器将不会获得一个独立的Network Namespace, 而是和宿主机共用一个Network Namespace。容器将不会虚拟出自己的网卡而是使用宿主机的IP和端口。

代码:

有警告信息:

当指定网络为 host时,如果指定了 -p 会有警告信息,但不影响使用。

[root@localhost ~]# docker run -d -p 8083:8080 --network host --name tomcat83 billygoo/tomcat8-jdk8

WARNING: Published ports are discarded when using host network mode

37097d7a5b11b29e3d653d3bb7229af8b183abbf2859d2314c00eb1b240c1698d正确写法:移除 -p

[root@localhost ~]# docker run -d --network host --name tomcat83 billygoo/tomcat8-jdk8

63ea58787842bd1739731e190f6858ff28c6622fba11f764a6087002418773aa看一下 tomcat83 容器的网络信息:

[root@localhost ~]# docker inspect tomcat83 | tail -n 20

"Networks": {

"host": {

"IPAMConfig": null,

"Links": null,

"Aliases": null,

"NetworkID": "39dda2d8738a6b97929a7b6e92b73ac0baaa33f648051d5c24c967803b48f125",

"EndpointID": "86dd29b7e086d1ea03051a80f3e775913854e80a139c9620f33b3c5eaa75164a",

"Gateway": "",

"IPAddress": "",

"IPPrefixLen": 0,

"IPv6Gateway": "",

"GlobalIPv6Address": "",

"GlobalIPv6PrefixLen": 0,

"MacAddress": "",

"DriverOpts": null

}

}

}

}

]

Gateway 和 IPAddress 都为空,没有IP。

那没有-p的端口映射了,怎么访问tomcat83呢?

使用宿主机IP访问,相当于就是宿主机直接装了一个tomcat,访问地址:http://宿主机IP:8080

在宿主机里面用默认的火狐浏览器访问容器内的tomcat83看到访问成功,由于说明此时容器的IP借用主机的,所以容器共享宿主机网络IP,这样的好处是外部主机与容器可以直接通信。

none

是什么

禁用网络功能,只有 lo 标识(就是127.0.0.1标识本地回环)

案例

[root@localhost ~]# docker run -d -p 8084:8080 --network none --name tomcat84 billygoo/tomcat8-jdk8查看网络:

[root@localhost ~]# docker exec -it tomcat84 bash

root@f405cf98e4ca:/usr/local/tomcat# ip addr

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

container

是什么

container⽹络模式

新建的容器和已经存在的一个容器共享一个网络ip配置而不是和宿主机共享。新创建的容器不会创建自己的网卡,配置自己的IP,而是和一个指定的容器共享IP、端口范围等。同样,两个容器除了网络方面,其他的如文件系统、进程列表等还是隔离的。

错误案例演示

第一启动 tomcat85 容器,

再启动 tomcat86 容器,指定网络和 tomcat85 容器共享,但此时出错了,由于由于是和 tomcat85 容器共享网络,而 tomcat85 容器里8080已经启动了,tomcat86还要使用8080端口就无法使用了,端口已经占用,此案例失败。

[root@localhost ~]# docker run -d -p 8085:8080 --name tomcat85 billygoo/tomcat8-jdk8

3167398a54ad9f1fcce7fac6cd06e5a231d30312e5afced85921993378179675

[root@localhost ~]#

[root@localhost ~]# docker run -d -p 8086:8080 --network container:tomcat85 --name tomcat86 billygoo/tomcat8-jdk8

docker: Error response from daemon: conflicting options: port publishing and the container type network mode.

See 'docker run --help'.

正确案例演示

使用另一个镜像来演示:

Alpine Linux 是一款独立的、非商业的通用 Linux 发行版,专为追求安全性、简单性和资源效率的用户而设计。 可能许多人没听说过这个 Linux 发行版本,但是常常用 Docker 的朋友可能都用过,由于他小,简单,安全而著称,所以作为基础镜像是超级好的一个选择,可谓是麻雀虽小但五脏俱全,镜像超级小巧,不到 6M的大小,所以特别适合容器打包。

[root@localhost ~]# docker run -it --name alpine1 alpine /bin/sh

/ # ip addr

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

27: eth0@if28: <BROADCAST,MULTICAST,UP,LOWER_UP,M-DOWN> mtu 1500 qdisc noqueue state UP

link/ether 02:42:ac:11:00:05 brd ff:ff:ff:ff:ff:ff

inet 172.17.0.5/16 brd 172.17.255.255 scope global eth0

valid_lft forever preferred_lft forever

/ #

alpine1 容器的 27: eth0 指向的宿主机的 if28

[root@localhost ~]# docker run -it --network container:alpine1 --name alpine2 alpine /bin/sh

/ # ip addr

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

27: eth0@if28: <BROADCAST,MULTICAST,UP,LOWER_UP,M-DOWN> mtu 1500 qdisc noqueue state UP

link/ether 02:42:ac:11:00:05 brd ff:ff:ff:ff:ff:ff

inet 172.17.0.5/16 brd 172.17.255.255 scope global eth0

valid_lft forever preferred_lft forever

/ #

alpine2 容器也是 27: eth0 指向的宿主机的 if28

此时如果关闭 alpine1 ,则 alpine2 就只剩 lo网卡了,由于 alpine2 容器是共享的 alpine1 容器的网络。

自定义网络

过时的 link

以前可通过 link 自定义网络,但后续可能将废弃。

是什么

为什么需要自定义网络,来看下面得案例。

案例

before:没有使用自定义网络

启动两个容器 tomcat81 和 tomcat82 ,tomcat81 内部ip为172.17.0.4,tomcat82 内部ip为 172.17.0.5 ,在两个容器内部和宿主机之间,通过IP都能够相互ping通,但是通过服务名 也就是 –name 取得名字,在两个容器之间就不能够ping通,只能在宿主机分别ping通两个服务名 tomcat81 和 tomcat82

after:使用自定义网络

自定义桥接网络,自定义网络默认使用的是桥接网络bridge。

新建自定义网络 tomcat_network:

[root@localhost ~]# docker network ls

NETWORK ID NAME DRIVER SCOPE

0c50f04c22f3 bridge bridge local

39dda2d8738a host host local

48e124df970f none null local

[root@localhost ~]#

[root@localhost ~]# docker network create tomcat_network

d331f4bd8fd9b8986f615726d3d88a9b062cced7a29c68db9e73dc450d2e1e00

[root@localhost ~]#

[root@localhost ~]# docker network ls

NETWORK ID NAME DRIVER SCOPE

0c50f04c22f3 bridge bridge local

39dda2d8738a host host local

48e124df970f none null local

d331f4bd8fd9 tomcat_network bridge local新建容器时指定加入自定义网络 tomcat_network :

[root@localhost ~]# docker run -d -p 8081:8080 --network tomcat_network --name tomcat81 billygoo/tomcat8-jdk8

9e7e05d78b86aa84b8ba18a6c7a69b8e7064df0848608db79edcb66dc22e631a

[root@localhost ~]#

[root@localhost ~]# docker run -d -p 8082:8080 --network tomcat_network --name tomcat82 billygoo/tomcat8-jdk8

554e72db6ef0954d10857adbe67122666ed0346f5e4ed1501f0b0b245d604f4d再次在容器内部相互ping 域名/主机名 测试,此时可以ping通了:

[root@localhost ~]# docker exec -it tomcat81 /bin/bash

root@9e7e05d78b86:/usr/local/tomcat#

root@9e7e05d78b86:/usr/local/tomcat# ping tomcat82

PING tomcat82 (172.18.0.3) 56(84) bytes of data.

64 bytes from tomcat82.tomcat_network (172.18.0.3): icmp_seq=1 ttl=64 time=0.524 ms

64 bytes from tomcat82.tomcat_network (172.18.0.3): icmp_seq=2 ttl=64 time=0.241 ms

64 bytes from tomcat82.tomcat_network (172.18.0.3): icmp_seq=3 ttl=64 time=0.240 ms

^C

--- tomcat82 ping statistics ---

3 packets transmitted, 3 received, 0% packet loss, time 2002ms

rtt min/avg/max/mdev = 0.240/0.335/0.524/0.133 ms

root@9e7e05d78b86:/usr/local/tomcat#结论:

自定义网络本身就维护好了主机名和IP的对应关系,所以IP和域名都能通。

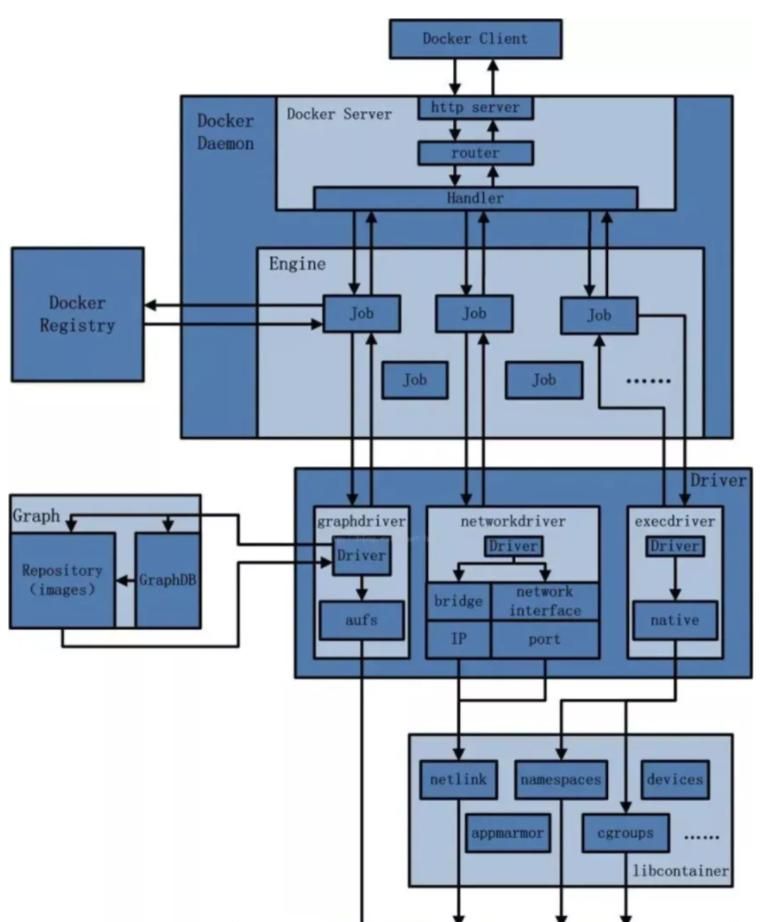

Docker 平台架构图解

整体说明

从其架构和运行流程来看,Docker 是一个 C/S 模式的架构,后端是一个松耦合架构,众多模块各司其职。

Docker 运行的基本流程为:

1. 用户是使用 Docker Client 与 Docker Daemon 建立通信,并发送请求给后者。

2. Docker Daemon 作为 Docker 架构中的主体部分,第一提供 Docker Server 的功能使其可以接受 Docker Client 的请求。

3. Docker Engine 执行 Docker 内部的一系列工作,每一项工作都是以一个 Job 的形式的存在。

4. Job 的运行过程中,当需要容器镜像时,则从 Docker Registry 中下载镜像,并通过镜像管理驱动 Graph driver将下载镜像以Graph的形式存储。

5. 当需要为 Docker 创建网络环境时,通过网络管理驱动 Network driver 创建并配置 Docker 容器网络环境。

6. 当需要限制 Docker 容器运行资源或执行用户指令等操作时,则通过 Execdriver 来完成。

7. Libcontainer是一项独立的容器管理包,Network driver以及Exec driver都是通过Libcontainer来实现具体对容器进行的操作。

整体架构

- 最新

- 最热

只看作者