Zookeeper常见面试题TOP20:大数据开发者必备

关键词:Zookeeper、分布式协调、面试题、ZAB协议、分布式锁、会话管理、Watch机制

摘要:Zookeeper作为大数据领域最常用的分布式协调工具,是Hadoop、Kafka、HBase等核心组件的“幕后管家”。本文整理了大数据开发者面试中最高频的20道Zookeeper问题,覆盖基础概念、核心原理、实战应用三大维度,用通俗易懂的语言+生活案例+代码示例,帮你彻底理解Zookeeper的底层逻辑,轻松应对面试官的“灵魂拷问”。

背景介绍

目的和范围

本文专为准备大数据岗位面试的开发者设计,聚焦Zookeeper最常考的核心知识点,覆盖从基础概念(如节点类型)到高级应用(如分布式锁实现)的全链路问题,帮你在短时间内快速掌握面试“必考点”和“易错点”。

预期读者

准备大数据开发/架构师面试的初级/中级开发者

对Zookeeper原理有初步了解,但需要系统梳理知识体系的技术人员

希望深入理解分布式协调工具底层逻辑的技术爱好者

文档结构概述

本文采用“核心概念速览→TOP20面试题深度解析→总结与扩展”的结构:

先通过3个生活案例快速回顾Zookeeper核心概念;

再逐一拆解20道高频面试题,包含原理讲解、易错点提醒、代码示例;

最后总结重点,提供扩展学习资源。

术语表(用“买奶茶”类比理解)

Zookeeper集群:像奶茶店的“中央收银系统”,多个服务器(节点)协同工作,保证即使部分机器故障,系统仍能正常运行。

ZNode:类似奶茶店的“取餐号”,每个节点存储少量数据(如取餐号对应的奶茶类型),支持临时/持久/顺序等不同“标签”。

Watch机制:像奶茶店的“叫号提醒”,用户(客户端)可以“订阅”取餐号(ZNode),当取餐号状态变化(如奶茶做好)时,系统会主动通知用户。

ZAB协议:类似奶茶店的“订单同步规则”,保证所有收银机(集群节点)的订单数据一致,即使店长(Leader)临时离开,也能快速选出新店长继续工作。

核心概念速览(用“奶茶店”故事理解)

假设你开了一家连锁奶茶店,需要解决3个问题:

如何让所有分店的菜单同步(分布式数据一致性)?

如何知道哪台收银机是主负责人(集群选主)?

如何通知顾客奶茶做好了(事件通知)?

Zookeeper就是帮你解决这些问题的“智能管理系统”:

核心概念一:ZNode(取餐号小卡片)

每个ZNode是Zookeeper中的一个“数据节点”,就像奶茶店的取餐号卡片。卡片上可以写:

持久节点:顾客离开后也不销毁(如“会员信息”);

临时节点:顾客离开(会话超时)就自动销毁(如“正在制作的奶茶订单”);

顺序节点:自动生成递增编号(如“取餐号001、002”)。

核心概念二:Watch机制(叫号器)

顾客(客户端)可以“订阅”自己的取餐号(ZNode),当取餐号状态变化(如“已做好”),系统(Zookeeper)会像叫号器一样发通知(触发Watch事件)。但要注意:Watch是“一次性”的,就像叫号器响一次后需要重新设置,否则下次状态变化不会再通知。

核心概念三:ZAB协议(店长交接班规则)

奶茶店有多个收银机(集群节点),其中一个是主店长(Leader),负责处理所有订单(写操作)。如果主店长临时离开(宕机),剩下的收银机需要按ZAB协议“投票选举”新店长,并同步所有订单数据,保证“无论谁当店长,顾客的订单都不会丢”。

Zookeeper常见面试题TOP20深度解析

问题1:Zookeeper的核心用途有哪些?(高频基础题)

常见回答误区:只说“分布式锁”“配置中心”,但说不清具体场景和原理。

正确答案(用奶茶店类比):

Zookeeper本质是“分布式协调管家”,核心用途可总结为4类:

配置管理:所有分店的菜单(配置信息)存放在Zookeeper的一个持久节点里,当菜单更新时,Zookeeper通过Watch机制通知所有分店同步更新(就像总部改了菜单,所有分店的电子屏自动刷新)。

命名服务:给分布式系统中的服务“起名字”并记录地址(如“奶茶制作服务”对应IP:192.168.1.100),其他服务通过Zookeeper快速找到它(类似“大众点评”记录店铺地址)。

分布式锁:多个分店同时申请“限量奶茶制作权”时,Zookeeper通过临时顺序节点实现“公平锁”(先到先得,类似取号排队买奶茶)。

集群管理:监控集群节点状态(如“分店是否营业”),当某个节点宕机(临时节点消失),Zookeeper通知其他节点调整任务(类似总部发现某分店关门,把订单分配给附近分店)。

问题2:Zookeeper的节点类型有几种?区别是什么?(必考题)

常见回答误区:混淆“临时/持久”和“顺序/非顺序”的组合,比如认为“临时节点不能是顺序节点”。

正确答案(表格+奶茶案例):

| 节点类型 | 特点 | 奶茶店类比 |

|---|---|---|

| 持久节点(PERSISTENT) | 客户端断开连接后仍存在,需手动删除 | 会员信息(即使顾客离开,信息仍保留) |

| 持久顺序节点(PERSISTENT_SEQUENTIAL) | 持久节点+自动生成递增编号(如/node-0000001) | 历史订单(每个订单有唯一递增编号) |

| 临时节点(EPHEMERAL) | 客户端会话失效(断开或超时)后自动删除 | 当前制作中的订单(顾客离开则取消) |

| 临时顺序节点(EPHEMERAL_SEQUENTIAL) | 临时节点+自动生成递增编号 | 排队取餐号(顾客离开则号码失效) |

关键点:临时节点的生命周期与客户端会话绑定,顺序节点的编号由父节点维护(类似奶茶店取号机,每个取号单的编号是父节点(取号机)生成的)。

问题3:Zookeeper的Watch机制是如何工作的?有什么限制?(高频原理题)

常见回答误区:认为Watch是“持续监听”,或者不知道“一次性”特性导致的问题。

正确答案(用“叫号器”类比):

Watch机制的工作流程:

客户端(顾客)调用getData(path, watch)或exists(path, watch),在某个ZNode(取餐号)上注册Watch(设置叫号提醒)。

当ZNode的数据变化(如奶茶做好)或子节点变化时,Zookeeper服务端(奶茶店系统)会向客户端发送一个事件通知(叫号器震动)。

Watch是一次性的:触发后自动销毁,若想继续监听,需重新注册(就像叫号器响一次后,需要再次点击“等待提醒”)。

限制与注意事项:

事件丢失:若客户端在事件通知到达前断开连接,可能丢失事件(类似叫号器没电了,没收到提醒)。

性能问题:大量Watch会增加服务端压力,需避免在高频变化的节点上注册过多Watch。

问题4:ZAB协议和Paxos协议有什么关系?(中高级原理题)

常见回答误区:认为ZAB是Paxos的简单实现,或不清楚两者的核心区别。

正确答案(用“班级选班长”类比):

ZAB(Zookeeper Atomic Broadcast)是Zookeeper专用的原子广播协议,设计目标是解决分布式系统的“主从数据同步”问题,而Paxos是通用的分布式一致性算法。两者的关系可以总结为:

相似点:都保证分布式系统中多数节点的数据一致性(如班级选班长,超过半数同意才生效)。

不同点:

ZAB更聚焦“主从架构”(有明确的Leader节点),而Paxos是“无主”的(所有节点平等);

ZAB包含“崩溃恢复”阶段(当Leader宕机时,快速选出新Leader并同步数据),而Paxos更关注“正常运行时的一致性”。

一句话总结:ZAB是Paxos的“定制版”,更适合Zookeeper的主从架构场景。

问题5:Zookeeper的选举机制(Leader选举)是如何工作的?(高频难点)

常见回答误区:只说“投票”,但说不清“投票比较规则”和“选举阶段”。

正确答案(分阶段+奶茶店选店长):

Zookeeper的Leader选举分为2个阶段:

阶段1:初始化选举(集群启动时)

假设奶茶店有3台收银机(节点A、B、C),初始时都没有Leader:

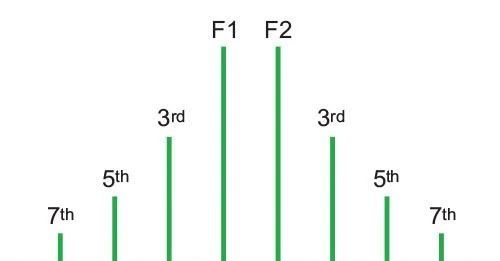

每个节点给自己投票(推荐自己当店长),投票信息包含“事务ID(ZXID)”和“服务器ID(SID)”。

节点交换投票信息,比较规则:先比较ZXID(事务ID越大,数据越新),若相同则比较SID(ID越大优先级越高)(就像选班长,成绩好(ZXID高)的优先,成绩相同则选学号大(SID大)的)。

当某个节点获得超过半数投票(如3台需要2票),则成为Leader,其他节点成为Follower。

阶段2:崩溃恢复(Leader宕机时)

假设当前Leader(A)宕机,剩下B、C:

B、C进入“LOOKING”状态,重新开始投票。

比较各自的ZXID(谁的数据更接近宕机前的Leader),选出新Leader(如B的ZXID更高,则B成为新Leader)。

新Leader与Follower同步数据(将自己的数据发给Follower,保证集群数据一致)。

关键点:ZXID是64位数字(高32位是epoch,低32位是事务计数),epoch代表选举轮次,保证新Leader的ZXID一定比旧Leader大。

问题6:Zookeeper的会话(Session)是如何管理的?超时会怎样?(高频细节题)

常见回答误区:认为会话超时时间是固定的,或不清楚“会话重连”的逻辑。

正确答案(用“顾客在奶茶店的停留时间”类比):

Zookeeper的会话管理逻辑:

客户端连接Zookeeper时,服务端分配一个唯一的SessionID,并设置超时时间(默认30秒,可配置)。

客户端通过“心跳包”(发送PING请求)保持会话活跃(就像顾客每5分钟向店员挥手,证明自己还在等待)。

若客户端超过超时时间未发送心跳(如顾客离开超过30分钟),会话失效,该客户端创建的所有临时节点自动删除(如未取的奶茶订单被取消)。

会话超时的影响:

临时节点删除:依赖这些节点的分布式锁、服务注册信息会失效(如某台服务器宕机,其注册的临时节点消失,其他节点知道它离线了)。

客户端需重新连接:会话失效后,客户端需要重新建立连接,重新注册Watch和临时节点。

问题7:Zookeeper为什么推荐集群节点数为奇数?(高频原理题)

常见回答误区:只说“节省资源”,但说不清“过半机制”的数学原理。

正确答案(用“投票游戏”数学推导):

Zookeeper集群的“过半机制”要求:任何写操作需获得超过半数节点的确认(如3台需要2台,5台需要3台)。奇数节点的优势在于:

容错能力相同,节点数更少:3台集群和4台集群的容错能力都是1台(3台最多允许1台宕机,4台也最多允许1台宕机,因为4/2+1=3,宕机2台则无法满足过半)。

避免脑裂:奇数节点更难出现“两个集群各占一半”的情况(如4台可能分裂为2+2,无法选出Leader;5台分裂为3+2,3台的集群可正常工作)。

数学公式:

假设集群有N台节点,最大允许宕机数为F,则需满足:N – F > F → F < N/2。

奇数N=2k+1 → F=k(如N=3,F=1;N=5,F=2);

偶数N=2k → F=k-1(如N=4,F=1;N=6,F=2)。

结论:奇数节点用更少的机器达到相同的容错能力(如3台≈4台,5台≈6台),更经济。

问题8:Zookeeper如何实现分布式锁?有哪些优缺点?(必考题+代码示例)

常见回答误区:只说“创建临时节点”,但说不清“公平锁”的实现细节和“羊群效应”问题。

正确答案(分步骤+代码示例):

分布式锁实现步骤(临时顺序节点方案):

客户端在锁路径(如/lock)下创建一个临时顺序节点(如/lock/node-000001)。

客户端获取/lock下所有子节点,按编号排序。

如果当前节点是最小的(如node-000001),则获得锁;否则,监听前一个节点(如node-000000)的删除事件。

释放锁时,删除当前临时节点(会话超时也会自动删除),下一个节点(node-000002)检测到前一个节点消失,触发Watch并尝试获取锁。

代码示例(伪代码):

from zkclient import ZKClient

class DistributedLock:

def __init__(self, zk, lock_path):

self.zk = zk

self.lock_path = lock_path

self.current_node = None

def acquire(self):

# 创建临时顺序节点

self.current_node = self.zk.create(f"{

self.lock_path}/node-", ephemeral=True, sequential=True)

while True:

# 获取所有子节点并排序

children = sorted(self.zk.get_children(self.lock_path))

current_index = children.index(self.current_node.split("/")[-1])

# 如果是第一个节点,获得锁

if current_index == 0:

return True

# 监听前一个节点

prev_node = f"{

self.lock_path}/{

children[current_index - 1]}"

self.zk.exists(prev_node, watch=self.watch_prev_node)

# 等待通知

self.wait()

def watch_prev_node(self, event):

# 前一个节点删除,唤醒等待

if event.type == "DELETED":

self.notify()

def release(self):

if self.current_node:

self.zk.delete(self.current_node)

优点:

公平性:按节点顺序获取锁,先到先得(类似排队取号);

自动释放:客户端宕机时,临时节点自动删除,避免死锁。

缺点:

羊群效应:大量客户端同时监听前一个节点,当前一个节点删除时,所有客户端都被唤醒(像一群羊同时冲出去),增加服务端压力。

性能问题:每次锁操作需要多次与Zookeeper交互(创建节点、获取子节点、监听),高并发下延迟较高。

问题9:Zookeeper和Eureka的区别是什么?(分布式系统必考题)

常见回答误区:只说“Zookeeper强一致性,Eureka最终一致性”,但说不清适用场景。

正确答案(表格+电商平台类比):

| 特性 | Zookeeper | Eureka |

|---|---|---|

| 一致性模型 | 强一致性(ZAB协议保证数据强一致) | 最终一致性(AP模型,允许短暂不一致) |

| 核心用途 | 分布式协调(锁、配置、选主) | 服务发现(微服务注册与发现) |

| 集群容错 | 半数存活即可(3台允许1台宕机) | 自我保护模式(允许节点不可用) |

| 客户端行为 | 依赖服务端(Watch由服务端触发) | 客户端缓存(定期拉取注册列表) |

场景对比:

Zookeeper:适合需要强一致性的场景(如分布式锁、主节点选举),但牺牲了部分可用性(集群脑裂时可能不可用)。

Eureka:适合微服务注册(允许短暂不一致,但保证服务可用),如电商大促时,个别节点注册延迟不影响整体服务。

问题10:Zookeeper的ZXID有什么作用?(中高级原理题)

常见回答误区:认为ZXID只是“事务编号”,但不清楚其“epoch+计数”的结构意义。

正确答案(用“版本号+轮次”类比):

ZXID(ZooKeeper Transaction ID)是64位的长整型,结构为:

高32位:epoch(选举轮次),每次Leader选举后递增(如店长换届,轮次+1);

低32位:事务计数,Leader任期内的事务编号(如店长任期内处理的第1、2、3个订单)。

核心作用:

数据一致性保证:ZXID越大,事务越新。Leader通过ZXID向Follower同步数据(类似“按订单时间顺序同步”)。

选举决策依据:选举时,节点优先选择ZXID大的候选者(数据更完整的节点当Leader)。

问题11:Zookeeper的节点数据量为什么限制在1MB以内?(高频细节题)

常见回答误区:认为是“设计缺陷”,但不清楚背后的性能考虑。

正确答案(用“快递包裹”类比):

Zookeeper的设计目标是“分布式协调”,而非“存储大数据”,节点数据量限制1MB的原因:

网络传输效率:Zookeeper的所有操作(如getData)需要在集群节点间同步数据,小数据量能减少网络延迟(就像寄快递,小包裹比大箱子更快)。

内存占用:Zookeeper用内存存储全量数据(便于快速访问),小数据量可降低内存压力(内存就像抽屉,只能放小物件)。

事务日志大小:每个写操作会记录事务日志,小数据量减少日志文件大小,加快恢复速度。

问题12:Zookeeper如何解决脑裂问题?(中高级场景题)

常见回答误区:认为ZAB协议能完全避免脑裂,或不清楚“过半机制”的作用。

正确答案(用“奶茶店分两个区域”类比):

脑裂(Split Brain)指集群因网络故障分裂成多个独立的子集群,每个子集群各自选Leader,导致数据不一致。Zookeeper通过“过半机制”解决:

写操作需过半节点确认:只有获得超过半数节点确认的写操作才有效(如3台集群需2台确认)。

Leader选举需过半投票:新Leader必须获得超过半数节点的投票(如3台集群需2票)。

举例:

假设5台集群因网络分裂为3台和2台的子集群:

3台子集群满足过半(3>5/2),可选举新Leader并处理写操作;

2台子集群不满足过半(2≤5/2),无法选举Leader,也无法处理写操作。

因此,只有一个子集群能正常工作,避免脑裂导致的数据不一致。

问题13:Zookeeper的Watcher和Curator的Cache有什么区别?(实战题)

常见回答误区:认为Curator Cache是Watch的简单封装,不清楚其“缓存+自动监听”的优势。

正确答案(用“天气预报”类比):

Zookeeper原生Watcher:像“单次天气预报”,需要手动注册,且触发后失效(下次变化需重新注册)。

Curator Cache:像“实时天气APP”,自动缓存节点数据/子节点列表,并持续监听变化(自动重新注册Watcher),提供更易用的API(如NodeCache监听节点数据变化,PathChildrenCache监听子节点变化)。

核心区别:

| 特性 | Zookeeper Watcher | Curator Cache |

|---|---|---|

| 监听持续性 | 一次性(触发后失效) | 自动持续监听(自动重注册) |

| 数据缓存 | 无(每次需主动获取) | 缓存最新数据(减少服务端请求) |

| 使用复杂度 | 高(需处理重注册逻辑) | 低(API封装友好) |

问题14:Zookeeper的Leader节点挂了,Follower如何同步数据?(高频原理题)

常见回答误区:认为Follower直接复制Leader的全部数据,不清楚“差异化同步”的优化。

正确答案(分阶段+“补作业”类比):

Leader宕机后,新Leader(假设是Follower B)会经历3个阶段同步数据给其他Follower(如Follower C):

差异同步(DIFF):新Leader检查Follower C的最后ZXID(如C的ZXID=100,新Leader的ZXID=150),只同步C缺失的事务(101-150)(类似补最近5次作业)。

截断同步(TRUNC):如果Follower C的ZXID比新Leader大(如C的ZXID=200,新Leader的ZXID=150),说明C的数据包含无效事务(旧Leader宕机前未提交的事务),需要截断到新Leader的ZXID(类似删除多写的5次作业)。

全量同步(SNAP):如果Follower C的数据落后太多(如ZXID差距超过阈值),新Leader直接发送全量快照(类似重新发一本完整的作业册)。

关键点:Zookeeper通过事务日志(记录所有写操作)和快照(定期数据备份)实现高效数据同步。

问题15:Zookeeper的会话超时时间(SessionTimeout)如何设置?(实战调优题)

常见回答误区:直接使用默认30秒,不考虑业务场景。

正确答案(用“奶茶制作时间”类比):

SessionTimeout的设置需结合业务的“响应时间”和“故障容忍度”:

短超时(如5秒):适合需要快速感知节点故障的场景(如实时计算任务,节点宕机后需立即重新分配任务),但可能因网络波动导致误判(如短暂延迟就认为节点宕机)。

长超时(如60秒):适合网络不稳定的环境(如跨机房集群),避免因短暂网络中断导致会话失效,但节点故障的感知会延迟(如节点宕机后1分钟才被发现)。

最佳实践:

生产环境建议设置为“心跳间隔×2~3倍”(默认心跳间隔是SessionTimeout/3);

使用Curator客户端时,可通过ExponentialBackoffRetry实现自动重连,降低超时误判的影响。

问题16:Zookeeper的ACL权限控制是如何工作的?(中高级安全题)

常见回答误区:认为ACL只能控制“读/写”,不清楚具体的权限类型。

正确答案(用“奶茶店门禁”类比):

Zookeeper的ACL(Access Control List)用于控制谁可以对ZNode执行操作,支持以下权限(CRUD+管理):

CREATE(C):创建子节点(类似允许进入后厨制作奶茶);

READ(R):读取节点数据和子节点列表(类似允许查看菜单);

WRITE(W):更新节点数据(类似允许修改菜单);

DELETE(D):删除子节点(类似允许取消订单);

ADMIN(A):设置ACL权限(类似允许设置门禁规则)。

权限模式(Scheme):

world:默认模式,所有客户端都有权限(world:anyone);

auth:通过已认证的用户权限(需先addAuth);

digest:用户名+密码(如digest:user:password,密码用SHA-1哈希);

ip:基于IP地址(如ip:192.168.1.100)。

示例:设置/config节点仅允许用户“admin:123456”读写:

# 客户端命令

setAcl /config digest:admin:$(echo -n "admin:123456" | openssl sha1 -binary | base64):rw

问题17:Zookeeper的Observer节点有什么作用?(高频扩展题)

常见回答误区:认为Observer是Follower的“别名”,不清楚其“只读不参与选举”的特性。

正确答案(用“奶茶店实习店员”类比):

Observer是Zookeeper集群的“只读节点”,作用是扩展集群读性能,同时不影响选举和写操作的效率:

不参与选举:Observer不参与Leader选举投票(类似实习店员不参与店长选举);

不参与写确认:写操作只需过半Follower确认,Observer不影响写性能;

同步数据:Observer会同步Leader的数据,提供读服务(类似实习店员可以帮顾客查菜单,但不能改菜单)。

适用场景:

读多写少的场景(如配置中心,大量客户端读取配置,少量更新);

跨机房部署(如主机房放Follower,异地机房放Observer,减少跨机房投票延迟)。

问题18:Zookeeper的“临时节点”和“持久节点”在崩溃恢复时有什么区别?(高频细节题)

常见回答误区:认为临时节点在恢复后会保留,不清楚其与会话的绑定关系。

正确答案(用“顾客是否在场”类比):

持久节点:崩溃恢复后,节点数据保留(就像顾客离开后,会员信息仍存在系统里);

临时节点:若客户端会话在崩溃时失效(如客户端宕机),恢复后临时节点会被删除(就像顾客离开奶茶店,未取的奶茶订单被取消);若客户端会话未失效(如Zookeeper集群短暂宕机,客户端重连后会话保持),临时节点保留。

关键点:临时节点的生命周期由客户端会话决定,而非Zookeeper服务器的状态。

问题19:Zookeeper的“羊群效应”是什么?如何解决?(中高级优化题)

常见回答误区:认为“羊群效应”只影响性能,不清楚具体表现和解决方案。

正确答案(用“超市促销”类比):

羊群效应(Herd Effect)指多个客户端同时监听同一个节点,当节点变化时,所有客户端被同时唤醒(像超市促销时,所有人同时冲向货架),导致服务端压力剧增。

Zookeeper中的典型场景:

分布式锁中,多个客户端监听前一个节点,当前一个节点删除时,所有客户端被唤醒(需重新获取子节点列表)。

解决方案:

临时顺序节点+监听前一个节点:每个客户端只监听前一个节点(如节点002监听001,节点003监听002),避免所有客户端监听同一个节点(就像排队时,每个人只看前面的人是否离开)。

使用Curator的InterProcessMutex:Curator的分布式锁实现已优化羊群效应,通过WaitStrategy控制客户端唤醒后的等待时间,减少同时请求。

问题20:Zookeeper的生产环境部署需要注意哪些问题?(终极实战题)

常见回答误区:只说“集群节点数为奇数”,忽略硬件、网络、监控等细节。

正确答案(分维度总结):

1. 硬件配置

CPU/内存:Zookeeper是内存数据库(数据存内存),建议分配足够内存(至少8GB),CPU选多核(处理并发请求)。

磁盘:使用SSD(事务日志和快照写入频繁),单独挂载磁盘(避免与其他服务竞争IO)。

2. 网络配置

低延迟网络:集群节点间网络延迟需<10ms(ZAB协议依赖快速通信);

防火墙规则:开放2181(客户端连接)、2888(Follower与Leader通信)、3888(选举端口)。

3. 配置调优

tickTime:默认2000ms(心跳间隔),根据SessionTimeout调整(SessionTimeout=2~20×tickTime);

initLimit:Follower初始化连接Leader的超时时间(默认10×tickTime);

syncLimit:Follower与Leader同步的超时时间(默认5×tickTime)。

4. 监控与运维

监控指标:节点状态(Leader/Follower)、请求延迟、会话数、Watch数;

日志分析:定期检查事务日志(zookeeper.out)和错误日志(zookeeper.err);

容灾演练:定期模拟Leader宕机,验证集群恢复能力。

总结:学到了什么?

核心概念回顾

ZNode:持久/临时+顺序/非顺序的四类节点,是Zookeeper的“数据单元”;

Watch机制:一次性事件通知,类似“叫号提醒”;

ZAB协议:解决主从数据同步和Leader选举,保证强一致性;

分布式锁:通过临时顺序节点实现公平锁,但需注意羊群效应。

概念关系回顾

Zookeeper的核心是“用ZAB协议管理ZNode,通过Watch机制实现事件通知,最终为分布式系统提供协调服务”(就像奶茶店用“店长规则(ZAB)管理取餐号(ZNode),通过叫号器(Watch)通知顾客,解决分店同步、排队等问题”)。

思考题:动动小脑筋

如果Zookeeper集群有5台节点,其中2台宕机,还能正常工作吗?如果是6台节点,2台宕机呢?

你能设计一个“更高效”的分布式锁方案,避免Zookeeper的羊群效应吗?(提示:可以结合Redis的特性)

为什么Zookeeper不适合存储大量数据?如果业务需要存储大配置,应该如何处理?

附录:常见问题与解答

Q:Zookeeper的客户端连接断了,重新连接后Watch还在吗?

A:不在。Watch与会话绑定,会话失效后所有Watch自动销毁,需重新注册。

Q:Zookeeper的Leader可以处理读请求吗?

A:可以。Leader和Follower都可以处理读请求(直接返回本地数据),写请求必须由Leader处理(通过ZAB协议同步到Follower)。

Q:Zookeeper的事务日志和快照有什么区别?

A:事务日志记录所有写操作(类似银行流水),用于恢复未持久化的事务;快照是某一时刻的全量数据备份(类似银行对账单),用于快速恢复大数据量。

扩展阅读 & 参考资料

官方文档:Zookeeper Documentation

经典书籍:《从Paxos到Zookeeper:分布式一致性原理与实践》(倪超 著)

工具推荐:Curator(Apache顶级项目,Zookeeper的客户端增强库)、ZooInspector(图形化Zookeeper数据查看工具)。

暂无评论内容