如何在大数据环境下有效开展A/B测试

关键词:大数据、A/B测试、实验设计、统计分析、数据质量

摘要:本文聚焦于在大数据环境下如何有效开展A/B测试。首先介绍了大数据环境下A/B测试的背景,包括目的、预期读者和文档结构。接着阐述了A/B测试的核心概念、联系及原理,通过数学模型和公式进行详细讲解,并辅以举例说明。然后提供了项目实战的具体内容,包括开发环境搭建、源代码实现与解读。还探讨了A/B测试在实际中的应用场景,推荐了相关的工具和资源。最后对未来发展趋势与挑战进行总结,并给出常见问题解答和扩展阅读参考资料,旨在为大数据环境下的A/B测试提供全面且深入的指导。

1. 背景介绍

1.1 目的和范围

在大数据时代,数据量呈爆炸式增长,企业和组织拥有了海量的数据资源。A/B测试作为一种重要的实验方法,能够帮助我们比较不同方案的效果,从而做出更科学的决策。本文章的目的在于探讨在大数据环境下如何有效地开展A/B测试,涵盖了从实验设计、数据收集与处理、统计分析到结果评估的整个流程,为读者提供全面且实用的指导。

1.2 预期读者

本文预期读者包括数据分析师、产品经理、市场营销人员以及对大数据和A/B测试感兴趣的技术人员。无论你是初学者想要了解A/B测试的基本原理,还是有一定经验的专业人士希望在大数据环境下优化A/B测试流程,都能从本文中获得有价值的信息。

1.3 文档结构概述

本文将按照以下结构进行组织:首先介绍A/B测试的核心概念与联系,包括其原理和架构;接着详细讲解核心算法原理和具体操作步骤,并结合Python源代码进行阐述;然后介绍相关的数学模型和公式,并举例说明;随后通过项目实战展示如何在实际中开展A/B测试;之后探讨A/B测试的实际应用场景;再推荐一些相关的工具和资源;最后对未来发展趋势与挑战进行总结,并提供常见问题解答和扩展阅读参考资料。

1.4 术语表

1.4.1 核心术语定义

A/B测试:一种将用户随机分为两组,分别对两组用户展示不同的方案(A组和B组),通过比较两组用户的行为数据来评估不同方案效果的实验方法。

大数据:指无法在一定时间范围内用常规软件工具进行捕捉、管理和处理的数据集合,具有海量性、高增长率和多样化的特点。

对照组:在A/B测试中,通常将使用原有方案的一组用户称为对照组,即A组。

实验组:使用新方案的一组用户称为实验组,即B组。

显著性水平:用于判断实验结果是否具有统计学意义的临界值,通常用α表示,常见取值为0.05。

功效:指在备择假设为真时,正确拒绝原假设的概率,通常用1 – β表示,其中β为第二类错误的概率。

1.4.2 相关概念解释

随机化:在A/B测试中,随机化是指将用户随机分配到对照组和实验组的过程,以确保两组用户在实验开始前具有相似的特征,从而减少实验误差。

样本量:指参与A/B测试的用户数量。样本量的大小会影响实验结果的准确性和可靠性,需要根据实验的目的和要求进行合理的计算。

统计检验:用于判断实验组和对照组之间的差异是否具有统计学意义的方法,常见的统计检验方法包括t检验、卡方检验等。

1.4.3 缩略词列表

KPI:关键绩效指标(Key Performance Indicator)

CI:置信区间(Confidence Interval)

CTR:点击率(Click-Through Rate)

2. 核心概念与联系

2.1 A/B测试的基本原理

A/B测试的基本原理是基于统计学的假设检验。我们通常会提出一个原假设 H 0 H_0 H0 和一个备择假设 H 1 H_1 H1。例如,在比较两种页面布局的转化率时,原假设 H 0 H_0 H0 可以是“两种页面布局的转化率没有差异”,备择假设 H 1 H_1 H1 可以是“两种页面布局的转化率存在差异”。

通过随机将用户分为对照组和实验组,分别对两组用户展示不同的方案,然后收集两组用户的行为数据,如点击率、转化率等。接着,使用统计检验方法对两组数据进行分析,根据分析结果判断是否拒绝原假设。如果拒绝原假设,则说明两种方案之间存在显著差异,我们可以选择效果更好的方案。

2.2 A/B测试的架构

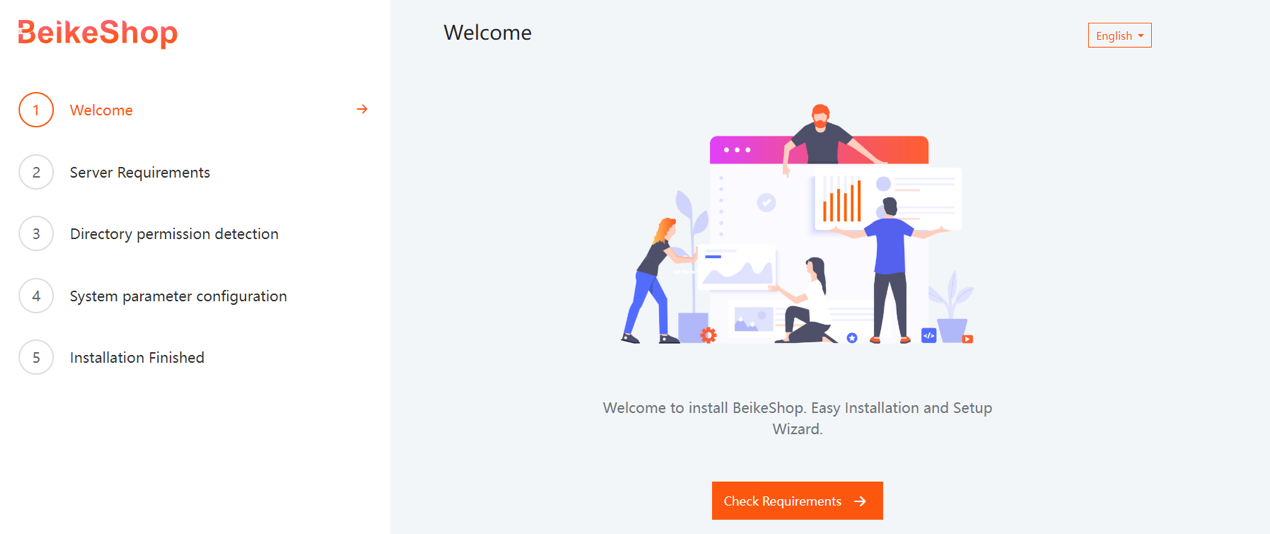

下面是一个A/B测试的基本架构示意图:

从图中可以看出,A/B测试主要包括以下几个步骤:

用户随机分配:将用户随机分配到对照组和实验组。

方案展示:分别对对照组和实验组用户展示不同的方案。

数据收集:收集两组用户的行为数据。

数据分析:使用统计检验方法对两组数据进行分析。

结果判断:根据分析结果判断是否拒绝原假设,并做出相应的决策。

2.3 核心概念之间的联系

随机化是A/B测试的基础,它确保了对照组和实验组在实验开始前具有相似的特征,从而保证了实验的公平性和可靠性。样本量的大小会影响实验的功效和显著性水平,合理的样本量可以提高实验结果的准确性。统计检验是判断实验结果是否具有统计学意义的关键步骤,通过对两组数据进行比较,我们可以确定两种方案之间的差异是否是由于随机因素引起的。

3. 核心算法原理 & 具体操作步骤

3.1 样本量计算

在开展A/B测试之前,需要确定合适的样本量。样本量的大小会影响实验的功效和显著性水平。下面是一个使用Python计算样本量的示例代码:

import scipy.stats as stats

import math

def sample_size_calculation(base_rate, mde, alpha=0.05, beta=0.2):

"""

计算A/B测试所需的样本量

:param base_rate: 对照组的基础转化率

:param mde: 最小可检测效应

:param alpha: 显著性水平

:param beta: 第二类错误的概率

:return: 每组所需的样本量

"""

z_alpha = stats.norm.ppf(1 - alpha / 2)

z_beta = stats.norm.ppf(1 - beta)

p1 = base_rate

p2 = base_rate + mde

pooled_p = (p1 + p2) / 2

sample_size = ((z_alpha * math.sqrt(2 * pooled_p * (1 - pooled_p)) + z_beta * math.sqrt(p1 * (1 - p1) + p2 * (1 - p2))) ** 2) / (mde ** 2)

return sample_size

# 示例:对照组基础转化率为0.1,最小可检测效应为0.05

base_rate = 0.1

mde = 0.05

sample_size = sample_size_calculation(base_rate, mde)

print(f"每组所需的样本量为: {

sample_size}")

3.2 随机分配用户

随机分配用户是A/B测试的重要步骤,确保对照组和实验组具有相似的特征。可以使用Python的随机数生成器来实现用户的随机分配,示例代码如下:

import random

def random_assignment(user_id, group_size):

"""

随机分配用户到对照组或实验组

:param user_id: 用户ID

:param group_size: 每组的样本量

:return: 用户所属的组('A'或'B')

"""

random.seed(user_id)

random_number = random.random()

if random_number < 0.5:

return 'A'

else:

return 'B'

# 示例:假设有10个用户

user_ids = range(10)

group_size = 5

for user_id in user_ids:

group = random_assignment(user_id, group_size)

print(f"用户ID {

user_id} 被分配到组 {

group}")

3.3 统计检验

在收集到对照组和实验组的数据后,需要进行统计检验来判断两组之间的差异是否具有统计学意义。常用的统计检验方法包括t检验和卡方检验。下面是一个使用Python进行t检验的示例代码:

import numpy as np

from scipy import stats

# 示例数据:对照组和实验组的转化率

control_group = np.array([0.1, 0.12, 0.08, 0.11, 0.09])

experimental_group = np.array([0.15, 0.16, 0.14, 0.13, 0.17])

# 进行t检验

t_statistic, p_value = stats.ttest_ind(control_group, experimental_group)

# 判断是否拒绝原假设

alpha = 0.05

if p_value < alpha:

print("拒绝原假设,两组之间存在显著差异")

else:

print("不能拒绝原假设,两组之间不存在显著差异")

4. 数学模型和公式 & 详细讲解 & 举例说明

4.1 样本量计算公式

样本量的计算公式基于统计学的原理,考虑了显著性水平、功效、基础转化率和最小可检测效应等因素。样本量计算公式如下:

n = ( z α / 2 2 p ˉ ( 1 − p ˉ ) + z β p 1 ( 1 − p 1 ) + p 2 ( 1 − p 2 ) ) 2 Δ 2 n = frac{(z_{alpha/2}sqrt{2ar{p}(1 – ar{p})} + z_{eta}sqrt{p_1(1 – p_1) + p_2(1 – p_2)})^2}{Delta^2} n=Δ2(zα/22pˉ(1−pˉ)

+zβp1(1−p1)+p2(1−p2)

)2

其中:

n n n 是每组所需的样本量。

z α / 2 z_{alpha/2} zα/2 是对应于显著性水平 α alpha α 的双侧分位数,例如当 α = 0.05 alpha = 0.05 α=0.05 时, z α / 2 = 1.96 z_{alpha/2} = 1.96 zα/2=1.96。

z β z_{eta} zβ 是对应于功效 1 − β 1 – eta 1−β 的分位数,例如当 β = 0.2 eta = 0.2 β=0.2 时, z β = 0.84 z_{eta} = 0.84 zβ=0.84。

p ˉ = p 1 + p 2 2 ar{p} = frac{p_1 + p_2}{2} pˉ=2p1+p2 是两组转化率的平均值。

p 1 p_1 p1 是对照组的基础转化率。

p 2 = p 1 + Δ p_2 = p_1 + Delta p2=p1+Δ 是实验组的转化率, Δ Delta Δ 是最小可检测效应。

4.2 t检验公式

t检验用于比较两组数据的均值是否存在显著差异。t统计量的计算公式如下:

t = x ˉ 1 − x ˉ 2 s p 1 n 1 + 1 n 2 t = frac{ar{x}_1 – ar{x}_2}{s_psqrt{frac{1}{n_1} + frac{1}{n_2}}} t=spn11+n21

xˉ1−xˉ2

其中:

x ˉ 1 ar{x}_1 xˉ1 和 x ˉ 2 ar{x}_2 xˉ2 分别是两组数据的均值。

s p s_p sp 是合并标准差,计算公式为:

s p = ( n 1 − 1 ) s 1 2 + ( n 2 − 1 ) s 2 2 n 1 + n 2 − 2 s_p = sqrt{frac{(n_1 – 1)s_1^2 + (n_2 – 1)s_2^2}{n_1 + n_2 – 2}} sp=n1+n2−2(n1−1)s12+(n2−1)s22

n 1 n_1 n1 和 n 2 n_2 n2 分别是两组数据的样本量。

s 1 2 s_1^2 s12 和 s 2 2 s_2^2 s22 分别是两组数据的方差。

4.3 举例说明

假设我们要比较两种页面布局的转化率,对照组的基础转化率 p 1 = 0.1 p_1 = 0.1 p1=0.1,我们希望能够检测到最小可检测效应 Δ = 0.05 Delta = 0.05 Δ=0.05,显著性水平 α = 0.05 alpha = 0.05 α=0.05,功效 1 − β = 0.8 1 – eta = 0.8 1−β=0.8。

首先,计算 p ˉ = 0.1 + ( 0.1 + 0.05 ) 2 = 0.125 ar{p} = frac{0.1 + (0.1 + 0.05)}{2} = 0.125 pˉ=20.1+(0.1+0.05)=0.125。

然后, z α / 2 = 1.96 z_{alpha/2} = 1.96 zα/2=1.96, z β = 0.84 z_{eta} = 0.84 zβ=0.84。

代入样本量计算公式可得:

n = ( 1.96 2 × 0.125 × ( 1 − 0.125 ) + 0.84 0.1 × ( 1 − 0.1 ) + 0.15 × ( 1 − 0.15 ) ) 2 0.0 5 2 ≈ 384 n = frac{(1.96sqrt{2 imes0.125 imes(1 – 0.125)} + 0.84sqrt{0.1 imes(1 – 0.1) + 0.15 imes(1 – 0.15)})^2}{0.05^2} approx 384 n=0.052(1.962×0.125×(1−0.125)

+0.840.1×(1−0.1)+0.15×(1−0.15)

)2≈384

即每组大约需要384个样本。

假设我们收集到了对照组和实验组的数据,对照组的转化率均值 x ˉ 1 = 0.1 ar{x}_1 = 0.1 xˉ1=0.1,样本量 n 1 = 384 n_1 = 384 n1=384,方差 s 1 2 = 0.009 s_1^2 = 0.009 s12=0.009;实验组的转化率均值 x ˉ 2 = 0.15 ar{x}_2 = 0.15 xˉ2=0.15,样本量 n 2 = 384 n_2 = 384 n2=384,方差 s 2 2 = 0.012 s_2^2 = 0.012 s22=0.012。

首先计算合并标准差:

s p = ( 384 − 1 ) × 0.009 + ( 384 − 1 ) × 0.012 384 + 384 − 2 ≈ 0.105 s_p = sqrt{frac{(384 – 1) imes0.009 + (384 – 1) imes0.012}{384 + 384 – 2}} approx 0.105 sp=384+384−2(384−1)×0.009+(384−1)×0.012

≈0.105

然后计算t统计量:

t = 0.1 − 0.15 0.105 1 384 + 1 384 ≈ − 3.83 t = frac{0.1 – 0.15}{0.105sqrt{frac{1}{384} + frac{1}{384}}} approx -3.83 t=0.1053841+3841

0.1−0.15≈−3.83

通过查t分布表或使用Python的scipy.stats库,可以得到对应的p值。假设p值小于0.05,则拒绝原假设,说明两种页面布局的转化率存在显著差异。

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

在进行A/B测试项目实战之前,需要搭建相应的开发环境。以下是一些常用的工具和库:

Python:作为主要的编程语言,建议使用Python 3.x版本。

Anaconda:一个开源的Python发行版本,包含了许多常用的科学计算库,如NumPy、Pandas、Scipy等。

Jupyter Notebook:一个交互式的开发环境,方便进行代码的编写、调试和展示。

可以按照以下步骤搭建开发环境:

下载并安装Anaconda:从Anaconda官方网站(https://www.anaconda.com/products/individual)下载适合自己操作系统的Anaconda安装包,并按照安装向导进行安装。

创建虚拟环境:打开Anaconda Prompt(Windows)或终端(Mac/Linux),输入以下命令创建一个新的虚拟环境:

conda create -n ab_testing python=3.8

激活虚拟环境:输入以下命令激活虚拟环境:

conda activate ab_testing

安装所需的库:输入以下命令安装NumPy、Pandas、Scipy等库:

conda install numpy pandas scipy matplotlib seaborn

5.2 源代码详细实现和代码解读

以下是一个完整的A/B测试项目实战代码示例,包括样本量计算、用户随机分配、数据生成、统计检验和结果可视化:

import numpy as np

import pandas as pd

import scipy.stats as stats

import matplotlib.pyplot as plt

import seaborn as sns

# 样本量计算

def sample_size_calculation(base_rate, mde, alpha=0.05, beta=0.2):

z_alpha = stats.norm.ppf(1 - alpha / 2)

z_beta = stats.norm.ppf(1 - beta)

p1 = base_rate

p2 = base_rate + mde

pooled_p = (p1 + p2) / 2

sample_size = ((z_alpha * np.sqrt(2 * pooled_p * (1 - pooled_p)) + z_beta * np.sqrt(p1 * (1 - p1) + p2 * (1 - p2))) ** 2) / (mde ** 2)

return sample_size

# 随机分配用户

def random_assignment(user_id, group_size):

np.random.seed(user_id)

random_number = np.random.random()

if random_number < 0.5:

return 'A'

else:

return 'B'

# 生成模拟数据

def generate_data(sample_size, base_rate, mde):

data = []

for i in range(sample_size * 2):

group = random_assignment(i, sample_size)

if group == 'A':

conversion = np.random.binomial(1, base_rate)

else:

conversion = np.random.binomial(1, base_rate + mde)

data.append([i, group, conversion])

df = pd.DataFrame(data, columns=['user_id', 'group', 'conversion'])

return df

# 统计检验

def ab_test(df):

control_group = df[df['group'] == 'A']['conversion']

experimental_group = df[df['group'] == 'B']['conversion']

t_statistic, p_value = stats.ttest_ind(control_group, experimental_group)

alpha = 0.05

if p_value < alpha:

result = '拒绝原假设,两组之间存在显著差异'

else:

result = '不能拒绝原假设,两组之间不存在显著差异'

return t_statistic, p_value, result

# 结果可视化

def visualize_results(df):

conversion_rates = df.groupby('group')['conversion'].mean()

sns.barplot(x=conversion_rates.index, y=conversion_rates.values)

plt.xlabel('Group')

plt.ylabel('Conversion Rate')

plt.title('A/B Test Results')

plt.show()

# 主函数

def main():

base_rate = 0.1

mde = 0.05

sample_size = sample_size_calculation(base_rate, mde)

sample_size = int(np.ceil(sample_size))

df = generate_data(sample_size, base_rate, mde)

t_statistic, p_value, result = ab_test(df)

print(f"t统计量: {

t_statistic}")

print(f"p值: {

p_value}")

print(result)

visualize_results(df)

if __name__ == "__main__":

main()

5.3 代码解读与分析

样本量计算:sample_size_calculation函数根据基础转化率、最小可检测效应、显著性水平和功效计算每组所需的样本量。

随机分配用户:random_assignment函数根据用户ID将用户随机分配到对照组或实验组。

生成模拟数据:generate_data函数根据样本量、基础转化率和最小可检测效应生成模拟的用户数据,包括用户ID、所属组和是否转化。

统计检验:ab_test函数对对照组和实验组的数据进行t检验,并根据p值判断是否拒绝原假设。

结果可视化:visualize_results函数使用Seaborn库绘制对照组和实验组的转化率柱状图,直观展示A/B测试的结果。

主函数:main函数调用上述函数完成整个A/B测试流程,包括样本量计算、数据生成、统计检验和结果可视化。

6. 实际应用场景

6.1 网站优化

在网站优化中,A/B测试可以用于比较不同的页面布局、颜色方案、按钮位置等对用户行为的影响。例如,通过A/B测试可以确定哪种页面布局能够提高用户的点击率和转化率,从而优化网站的用户体验。

6.2 产品设计

在产品设计阶段,A/B测试可以帮助产品经理评估不同的产品功能和特性对用户的吸引力。例如,比较两种不同的产品介绍方式,看哪种能够更好地吸引用户并促进购买。

6.3 市场营销

在市场营销活动中,A/B测试可以用于比较不同的广告文案、促销策略等对用户购买行为的影响。例如,测试不同的电子邮件营销内容,看哪种能够获得更高的打开率和转化率。

6.4 算法优化

在机器学习和人工智能领域,A/B测试可以用于比较不同的算法模型或参数设置的效果。例如,在推荐系统中,比较不同的推荐算法对用户点击率和购买率的影响,从而选择最优的算法。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

《精益数据分析》:介绍了如何使用数据驱动的方法进行创业和产品开发,其中包含了A/B测试的相关内容。

《Python数据分析实战》:通过实际案例介绍了如何使用Python进行数据分析,包括A/B测试的实现。

《概率论与数理统计》:作为统计学的基础书籍,对于理解A/B测试的原理和方法非常有帮助。

7.1.2 在线课程

Coursera上的“Data Science Specialization”:涵盖了数据科学的各个方面,包括A/B测试的理论和实践。

edX上的“Probability-The Science of Uncertainty and Data”:帮助学习者深入理解概率论和统计学的基础知识,为A/B测试提供理论支持。

Udemy上的“A/B Testing for Data Science”:专门针对A/B测试的课程,介绍了如何使用Python进行A/B测试的实现。

7.1.3 技术博客和网站

Medium:有许多关于数据科学和A/B测试的优秀文章,可以从中获取最新的技术和实践经验。

Towards Data Science:专注于数据科学领域的技术博客,提供了大量关于A/B测试的教程和案例分析。

Google Analytics Blog:Google官方的数据分析博客,分享了许多关于数据分析和A/B测试的最佳实践。

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

PyCharm:一款专业的Python集成开发环境,提供了丰富的代码编辑、调试和项目管理功能。

Jupyter Notebook:交互式的开发环境,适合进行数据分析和实验验证,方便代码的编写、调试和展示。

Visual Studio Code:一款轻量级的代码编辑器,支持多种编程语言和插件扩展,也可以用于Python开发。

7.2.2 调试和性能分析工具

PDB:Python自带的调试器,可以帮助开发者定位和解决代码中的问题。

cProfile:Python的性能分析工具,可以分析代码的运行时间和函数调用次数,帮助优化代码性能。

Memory Profiler:用于分析Python代码的内存使用情况,找出内存泄漏和优化内存使用的工具。

7.2.3 相关框架和库

NumPy:Python的数值计算库,提供了高效的多维数组对象和各种数学函数,是进行A/B测试数据处理的基础。

Pandas:用于数据处理和分析的库,提供了强大的数据结构和数据操作功能,方便进行数据清洗、转换和分析。

Scipy:包含了许多科学计算和统计分析的工具,如统计检验、优化算法等,在A/B测试中可以用于进行统计分析。

Matplotlib和Seaborn:用于数据可视化的库,可以绘制各种类型的图表,直观展示A/B测试的结果。

7.3 相关论文著作推荐

7.3.1 经典论文

“The Design and Analysis of Industrial Experiments” by Oscar Kempthorne:经典的实验设计和分析著作,为A/B测试提供了理论基础。

“A/B Testing: The Definitive Guide” by Dan Siroker and Pete Koomen:详细介绍了A/B测试的原理、方法和实践经验。

7.3.2 最新研究成果

在ACM SIGKDD、IEEE ICDM等数据挖掘和机器学习领域的顶级会议上,有许多关于A/B测试的最新研究成果,可以通过这些会议的官方网站获取相关论文。

《Journal of Marketing Research》、《Journal of Consumer Research》等市场营销领域的学术期刊也会发表一些关于A/B测试在市场营销中的应用和研究。

7.3.3 应用案例分析

各大科技公司的技术博客,如Google、Facebook、Amazon等,会分享他们在实际业务中进行A/B测试的应用案例和经验教训。

《Case Studies in Data Science》等书籍收集了许多实际的数据科学应用案例,其中包括A/B测试的案例分析。

8. 总结:未来发展趋势与挑战

8.1 未来发展趋势

多变量测试:随着大数据和技术的发展,未来的A/B测试可能会扩展到多变量测试,即同时测试多个因素的不同组合,以更全面地评估不同方案的效果。

实时测试:实时获取和分析数据的能力将使得A/B测试能够更加实时地进行,及时调整实验方案,提高决策的效率。

与机器学习的结合:将A/B测试与机器学习算法相结合,利用机器学习的预测能力和优化算法,更好地设计实验方案和评估实验结果。

跨平台和跨设备测试:随着移动互联网和物联网的发展,A/B测试需要考虑不同平台和设备的差异,进行跨平台和跨设备的测试。

8.2 挑战

数据质量:在大数据环境下,数据量巨大且来源复杂,数据质量问题可能会影响A/B测试的结果。如何保证数据的准确性、完整性和一致性是一个挑战。

实验设计:随着业务的复杂性增加,实验设计变得更加困难。如何合理地设计实验方案,控制实验变量,确保实验的有效性和可靠性是一个挑战。

统计分析:在大数据环境下,传统的统计分析方法可能不再适用。需要开发更高效、更准确的统计分析方法,以处理大规模的数据。

伦理和隐私问题:A/B测试涉及到用户数据的收集和使用,需要遵守相关的伦理和隐私法规。如何在保护用户隐私的前提下进行有效的A/B测试是一个挑战。

9. 附录:常见问题与解答

9.1 如何确定最小可检测效应?

最小可检测效应(MDE)是指你希望能够检测到的两组之间的最小差异。确定MDE需要考虑业务目标、成本和样本量等因素。一般来说,可以根据历史数据、行业经验或业务需求来估计MDE。例如,如果你的业务目标是提高转化率,你可以根据当前的转化率和预期的提升幅度来确定MDE。

9.2 样本量计算不准确会有什么影响?

如果样本量计算不准确,可能会导致以下问题:

样本量过小:实验的功效较低,可能无法检测到真实存在的差异,从而得出错误的结论。

样本量过大:会浪费资源和时间,增加实验的成本。

9.3 如何处理异常值?

处理异常值的方法有很多种,常见的方法包括:

删除异常值:如果异常值是由于数据录入错误或系统故障导致的,可以直接删除这些异常值。

替换异常值:可以使用均值、中位数或其他统计量来替换异常值。

转换数据:对数据进行对数变换、平方根变换等,以减少异常值的影响。

9.4 A/B测试的结果是否一定可靠?

A/B测试的结果并不一定完全可靠,因为实验结果可能受到多种因素的影响,如样本偏差、实验时间、外部环境等。为了提高实验结果的可靠性,需要确保实验设计合理、样本随机分配、数据质量可靠,并进行多次实验验证。

10. 扩展阅读 & 参考资料

《A/B Testing: The Most Powerful Way to Turn Clicks into Customers》 by Dan Siroker and Pete Koomen

《Python for Data Analysis》 by Wes McKinney

Google Analytics官方文档:https://support.google.com/analytics

各大科技公司的技术博客,如Google、Facebook、Amazon等。

ACM SIGKDD、IEEE ICDM等数据挖掘和机器学习领域的顶级会议论文。

暂无评论内容