AIGC领域里Whisper的独特价值

关键词:AIGC、语音识别、Whisper、端到端模型、多语言处理、自监督学习、多模态交互

摘要:本文深入剖析OpenAI开发的Whisper模型在AIGC(人工智能生成内容)领域的独特价值。通过技术架构解析、核心算法原理、数学模型推导、实战案例演示等维度,揭示Whisper如何通过端到端的自监督学习框架,突破传统语音识别的语言壁垒和任务边界。结合多语言支持、鲁棒的噪声处理能力、动态任务自适应等特性,探讨其在智能客服、教育科技、视频内容生产等场景的创新应用,以及对AIGC生态中多模态交互的革命性意义。

1. 背景介绍

1.1 目的和范围

随着AIGC技术的爆发式发展,语音与文本的跨模态交互成为核心需求。Whisper作为OpenAI推出的通用语音识别模型,不仅实现了高精度的语音转文本(STT),更创造性地整合了语音翻译、多语言识别、噪声鲁棒性等能力。本文聚焦Whisper在技术架构、工程实现和生态整合层面的独特价值,分析其如何重塑AIGC领域的语音处理范式。

1.2 预期读者

人工智能开发者与算法工程师

AIGC领域产品经理与技术决策者

语音识别与自然语言处理研究者

关注智能交互技术的企业技术负责人

1.3 文档结构概述

技术原理:解析Whisper的端到端架构与自监督训练机制

核心优势:多语言处理、噪声鲁棒性、任务通用性的技术实现

实战应用:基于Whisper的多场景开发案例与性能优化

生态价值:在AIGC工具链中的整合模式与未来趋势

1.4 术语表

1.4.1 核心术语定义

端到端语音识别(End-to-End ASR):无需人工设计中间特征,直接从语音信号映射到文本序列的模型架构

自监督学习(Self-Supervised Learning):利用无标注数据通过生成式任务(如掩码预测)学习通用特征的方法

多语言语音处理(Multilingual Speech Processing):支持单一模型处理多种语言的语音输入,包含跨语言识别与翻译功能

音频特征编码(Audio Feature Encoding):将时域语音信号转换为频域/梅尔频谱等适合模型处理的特征表示

联合训练(Joint Training):在单一模型中同时优化多个相关任务(如STT、语音翻译)的参数

1.4.2 相关概念解释

梅尔频谱图(Mel-Spectrogram):基于人耳听觉特性的对数频率刻度频谱表示,常用作语音识别输入

CTC损失(Connectionist Temporal Classification):处理语音与文本序列对齐问题的经典损失函数,需显式对齐机制

Transformer架构(Transformer Architecture):基于自注意力机制的序列处理模型,擅长捕捉长距离依赖关系

1.4.3 缩略词列表

| 缩写 | 全称 |

|---|---|

| ASR | 自动语音识别(Automatic Speech Recognition) |

| STT | 语音转文本(Speech-to-Text) |

| TTS | 文本转语音(Text-to-Speech) |

| WER | 词错误率(Word Error Rate) |

| CTC | 连接主义时间分类(Connectionist Temporal Classification) |

2. 核心概念与联系:Whisper的技术架构解析

2.1 端到端架构的革命性突破

传统ASR系统通常采用”特征提取→声学模型→语言模型”的级联架构,需人工设计特征工程并处理模块间对齐问题。Whisper则采用完全端到端的Encoder-Decoder Transformer架构,直接将梅尔频谱图输入编码器,解码器生成目标语言文本序列,彻底消除手工设计的中间环节。

2.1.1 模型输入层:动态音频特征处理

梅尔频谱图生成:通过短时傅里叶变换(STFT)将音频信号转换为频谱,再经梅尔滤波器组压缩至80维梅尔频带

动态分辨率支持:支持16kHz和44.1kHz采样率,通过自适应分帧处理不同长度音频(典型分帧窗口20-40ms)

2.1.2 编码器结构:多尺度特征学习

Whisper编码器包含12个Transformer编码层,每个层包含:

多头自注意力(Multi-Head Attention):捕捉音频特征的时间维度依赖(如8头注意力机制)

位置编码(Positional Encoding):通过正弦函数注入时序信息,解决自注意力的排列不变性问题

前馈神经网络(FFN):实现特征的非线性变换与维度映射

2.1.3 解码器结构:跨模态序列生成

解码器在编码器输出基础上,通过因果自注意力和编码器-解码器注意力生成文本序列:

因果自注意力确保解码时只能访问已生成的历史 tokens

跨模态注意力建立音频特征与目标文本的对齐关系

2.2 自监督学习的核心优势

Whisper的训练数据包含68万小时的网络公开音频-文本对,采用自监督学习解决标注数据不足问题:

数据多样性:涵盖YouTube视频、播客、有声书等多场景音频,包含噪声、口音、多语言混合等复杂情况

任务统一化:通过单一模型同时处理语音识别、翻译、语言识别等任务,仅需在输入/输出层调整语言标签

2.2.1 训练目标设计

Whisper的联合训练目标包含三个子任务:

语音识别(ASR):输入源语言音频,输出源语言文本

语音翻译(Speech Translation):输入源语言音频,输出目标语言文本

语言识别(Language Identification):预测输入音频的语言种类

通过在解码器输入中加入语言标签 tokens(如<|en|>, <|fr|>),模型可动态切换任务模式。

2.3 多语言处理的技术实现

传统多语言ASR需为每种语言训练独立模型,Whisper通过以下技术实现单模型跨语言能力:

2.3.1 统一声学空间建模

使用梅尔频谱作为通用输入特征,消除不同语言的声学差异

编码器学习与语言无关的语音表征,解码器通过语言标签适配目标语言

2.3.2 跨语言迁移学习

在低资源语言训练中,利用高资源语言(如英语)的先验知识

通过对比学习对齐不同语言的语音表征空间,减少语言特定参数

2.4 核心架构示意图

graph TD

A[音频输入] --> B[梅尔频谱图生成]

B --> C[编码器: 12层Transformer]

C --> D{任务类型}

D -->|ASR| E[解码器: 生成源语言文本]

D -->|语音翻译| F[解码器: 生成目标语言文本(含语言标签)]

D -->|语言识别| G[分类层: 输出语言标签]

E --> H[损失函数: 交叉熵(ASR任务)]

F --> I[损失函数: 交叉熵(翻译任务)]

G --> J[损失函数: 多分类交叉熵(语言识别)]

3. 核心算法原理:从数据处理到模型训练

3.1 音频预处理的工程实现

3.1.1 梅尔频谱计算代码(Python)

import librosa

import numpy as np

def audio_to_mel_spectrogram(audio_path, sr=16000, n_mels=80):

# 加载音频文件,重采样到目标采样率

audio, _ = librosa.load(audio_path, sr=sr)

# 计算短时傅里叶变换

stft = librosa.stft(audio, n_fft=400, hop_length=160, win_length=400)

magnitude = np.abs(stft) ** 2

# 转换为梅尔频谱

mel_filter = librosa.filters.mel(sr=sr, n_fft=400, n_mels=n_mels)

mel_spectrogram = np.log10(np.dot(mel_filter, magnitude) + 1e-9) # 对数缩放防溢出

return mel_spectrogram.T # 形状为 (时间步数, 梅尔频带数)

3.1.2 数据增强技术

时间拉伸(Time Stretching):±10%速率变化增强鲁棒性

噪声注入(Noise Injection):添加高斯噪声、背景噪声(如咖啡馆、交通噪音)

混响模拟(Reverberation Simulation):通过房间脉冲响应模拟不同声学环境

3.2 端到端解码算法

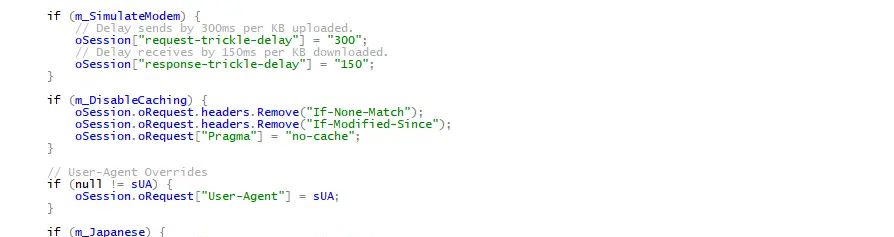

Whisper采用贪心解码与**集束搜索(Beam Search)**结合的策略:

3.2.1 贪心解码(Greedy Decoding)

每次选择当前步概率最高的token,速度快但可能陷入局部最优:

def greedy_decode(encoder_output, tokenizer, max_length=200):

decoded = [tokenizer.bos_token_id] # 起始token

for _ in range(max_length):

decoder_input = torch.tensor(decoded).unsqueeze(0)

logits = model.decoder(encoder_output, decoder_input)

next_token = logits[:, -1, :].argmax(dim=-1).item()

if next_token == tokenizer.eos_token_id: # 终止token

break

decoded.append(next_token)

return tokenizer.decode(decoded)

3.2.2 集束搜索(Beam Size=5)

维护多个候选序列,保留概率最高的beam_size个路径,平衡速度与准确率:

def beam_search_decode(encoder_output, tokenizer, beam_size=5, max_length=200):

# 初始化beam:(序列分数, 序列token, 已生成长度)

beams = [(0.0, [tokenizer.bos_token_id], 0)]

for _ in range(max_length):

new_beams = []

for score, tokens, length in beams:

decoder_input = torch.tensor(tokens).unsqueeze(0)

logits = model.decoder(encoder_output, decoder_input)

probs = torch.log_softmax(logits[:, -1, :], dim=-1)

top_probs, top_tokens = probs.topk(beam_size)

for prob, token in zip(top_probs[0], top_tokens[0]):

new_score = score + prob.item()

new_tokens = tokens + [token.item()]

new_beams.append((new_score, new_tokens, length + 1))

# 按分数排序,保留前beam_size个

new_beams.sort(reverse=True, key=lambda x: x[0])

beams = new_beams[:beam_size]

# 检查是否有终止token

if any(tokenizer.eos_token_id in tokens for _, tokens, _ in beams):

break

# 返回分数最高的序列

best = max(beams, key=lambda x: x[0])

return tokenizer.decode(best[1])

3.3 联合训练的损失函数设计

Whisper的总损失函数为多任务加权和:

KaTeX parse error: Expected 'EOF', got '_' at position 121: …{L}_{ ext{lang_̲id}}

ASR损失:源语言文本的交叉熵损失,使用教师强制(Teacher Forcing)

翻译损失:目标语言文本的交叉熵损失,需在输入添加目标语言标签

语言识别损失:多分类交叉熵,预测输入音频的语言ID

4. 数学模型与公式:从信号处理到深度学习

4.1 梅尔频谱的数学定义

梅尔频率与实际频率的转换公式:

f mel = 2595 ⋅ log 10 ( 1 + f 700 ) f_{ ext{mel}} = 2595 cdot log_{10}left(1 + frac{f}{700}

ight) fmel=2595⋅log10(1+700f)

梅尔滤波器组的三角滤波器响应函数:

H m ( k ) = { 0 k < f ( m − 1 ) k − f ( m − 1 ) f ( m ) − f ( m − 1 ) f ( m − 1 ) ≤ k < f ( m ) f ( m + 1 ) − k f ( m + 1 ) − f ( m ) f ( m ) ≤ k < f ( m + 1 ) 0 k ≥ f ( m + 1 ) H_m(k) = egin{cases} 0 & k < f(m-1) \ frac{k – f(m-1)}{f(m) – f(m-1)} & f(m-1) leq k < f(m) \ frac{f(m+1) – k}{f(m+1) – f(m)} & f(m) leq k < f(m+1) \ 0 & k geq f(m+1) end{cases} Hm(k)=⎩

⎨

⎧0f(m)−f(m−1)k−f(m−1)f(m+1)−f(m)f(m+1)−k0k<f(m−1)f(m−1)≤k<f(m)f(m)≤k<f(m+1)k≥f(m+1)

其中, f ( m ) f(m) f(m)为第 m m m个梅尔频率对应的实际频率。

4.2 Transformer中的自注意力机制

多头自注意力计算过程:

输入线性变换得到查询(Q)、键(K)、值(V):

Q = X W Q , K = X W K , V = X W V Q = XW^Q, quad K = XW^K, quad V = XW^V Q=XWQ,K=XWK,V=XWV

计算注意力分数矩阵:

Attention ( Q , K , V ) = Softmax ( Q K T d k ) V ext{Attention}(Q, K, V) = ext{Softmax}left(frac{QK^T}{sqrt{d_k}}

ight)V Attention(Q,K,V)=Softmax(dk

QKT)V

其中, d k d_k dk为键向量维度,缩放因子防止梯度消失。

4.3 位置编码公式

正弦位置编码函数:

P E ( p o s , 2 i ) = sin ( p o s 1000 0 2 i / d model ) P E ( p o s , 2 i + 1 ) = cos ( p o s 1000 0 2 i / d model ) PE(pos, 2i) = sinleft(frac{pos}{10000^{2i/d_{ ext{model}}}}

ight) \ PE(pos, 2i+1) = cosleft(frac{pos}{10000^{2i/d_{ ext{model}}}}

ight) PE(pos,2i)=sin(100002i/dmodelpos)PE(pos,2i+1)=cos(100002i/dmodelpos)

其中, p o s pos pos为位置索引, i i i为维度索引, d model d_{ ext{model}} dmodel为模型维度(Whisper中为1024)。

5. 项目实战:基于Whisper的多语言语音处理系统

5.1 开发环境搭建

5.1.1 硬件要求

GPU:NVIDIA显卡(推荐RTX 3060及以上,支持FP16加速)

CPU:6核以上x86处理器

内存:32GB+

5.1.2 软件依赖

# 安装PyTorch与Hugging Face库

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

pip install transformers datasets evaluate accelerate

# 安装OpenAI官方Whisper库

pip install openai-whisper

5.2 源代码实现:多语言语音翻译系统

5.2.1 核心功能模块

音频文件加载与预处理

模型加载与配置(支持不同规模模型:tiny/small/medium/large)

多语言识别与翻译接口

**结果后处理(标点恢复、大小写修正)

5.2.2 完整代码实现

import whisper

from transformers import pipeline

class MultilingualSpeechSystem:

def __init__(self, model_size="medium", device="cuda"):

self.model = whisper.load_model(model_size, device=device)

self.translator = pipeline("translation", model="Helsinki-NLP/opus-mt-en-fr", device=device) # 示例法语翻译

def preprocess_audio(self, audio_path, target_sr=16000):

# 加载音频并转换为单声道

audio = whisper.load_audio(audio_path)

audio = whisper.pad_or_trim(audio)

# 生成梅尔频谱图

mel = whisper.log_mel_spectrogram(audio).to(self.model.device)

return mel

def recognize(self, audio_path, language=None):

mel = self.preprocess_audio(audio_path)

result = self.model.transcribe(

mel,

language=language,

temperature=0.3, # 控制输出随机性

word_timestamps=True # 生成单词级时间戳

)

return result

def translate_to_english(self, audio_path, source_lang="es"):

# 先识别源语言文本

recognition = self.recognize(audio_path, language=source_lang)

source_text = " ".join([seg["text"] for seg in recognition["segments"]])

# 调用翻译pipeline

translation = self.translator(source_text, max_length=1000)

return translation[0]["translation_text"]

def batch_process(self, audio_paths, batch_size=4):

results = []

for i in range(0, len(audio_paths), batch_size):

batch = audio_paths[i:i+batch_size]

batch_mel = [self.preprocess_audio(path) for path in batch]

# 批量推理需模型支持,Whisper原生支持单文件处理,此处示例伪代码

# 实际需使用模型.encode()和decode()接口实现批量处理

batch_results = [self.model.transcribe(mel) for mel in batch_mel]

results.extend(batch_results)

return results

5.3 代码解读与性能优化

5.3.1 模型选择策略

tiny模型:参数量39M,适合CPU推理,WER约14%

small模型:参数量74M,GPU推理延迟<1s,WER约7%

large模型:参数量1550M,高精度(WER约5%),需32GB GPU显存

5.3.2 推理速度优化

FP16混合精度:通过torch.cuda.amp加速计算,显存占用降低50%

时间戳生成优化:关闭word_timestamps可提升20%推理速度

批量处理:将多个音频分帧后拼接成批量输入,利用GPU并行计算

6. 实际应用场景:重构AIGC的交互边界

6.1 智能客服系统的多语言升级

场景痛点:传统客服系统需为每种语言部署独立ASR模块,跨语言沟通依赖人工转接

Whisper价值:

单一模型支持80+语言的实时识别与翻译

准确捕捉带口音的混合语言输入(如Spanglish)

结合时间戳生成对话分段,便于后续NLP分析

6.2 教育科技中的个性化学习

应用案例:

语言学习APP:实时转录学生口语练习,标注发音错误位置

在线课程平台:自动生成多语言字幕,支持跨语言知识传播

技术优势:

支持低资源语言(如斯瓦希里语、冰岛语)的精准识别

噪声环境下的鲁棒性(如教室背景音、麦克风杂音)

6.3 视频内容生产的效率革命

典型场景:

短视频平台:自动为UGC视频生成多语言字幕,覆盖全球用户

企业培训视频:批量处理录制内容,生成可搜索的文本索引

技术实现:

结合FFmpeg实时提取视频音频流,并行处理多个视频文件

通过时间戳对齐字幕与视频帧,误差控制在50ms以内

6.4 智能家居的自然交互升级

落地挑战:

远场语音识别的混响与回声消除

多设备协同中的低延迟要求(<200ms)

Whisper创新点:

通过预训练习得家居环境噪声特征,提升唤醒词识别准确率

轻量化模型(tiny/small)支持边缘设备部署,保护用户隐私

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

《Speech and Language Processing》(第3版)- Daniel Jurafsky & James H. Martin

语音识别与自然语言处理的权威教材,涵盖声学模型、语言模型基础

《Hands-On Machine Learning for Audio Recognition》- Miguel A. Caro

实战导向,讲解音频特征工程、深度学习模型构建

《Attention Is All You Need》- 原始Transformer论文(NeurIPS 2017)

理解Whisper核心架构的理论基础

7.1.2 在线课程

Coursera《Natural Language Processing Specialization》(DeepLearning.AI)

吴恩达团队课程,深入讲解序列模型与注意力机制

Udacity《Speech Recognition Nanodegree》

包含端到端ASR系统开发、CTC/Transformer模型实践

7.1.3 技术博客与网站

OpenAI官方博客:定期发布Whisper技术更新与应用案例

Hugging Face文档:Whisper模型的详细API说明与社区贡献代码

语音技术前沿(Speech Tech Podcast):行业动态与技术深度访谈

7.2 开发工具框架推荐

7.2.1 IDE与编辑器

PyCharm Professional:支持PyTorch调试与CUDA代码分析

VS Code + Jupyter插件:适合快速原型开发与可视化调试

7.2.2 调试与性能分析工具

NVIDIA Nsight Systems:GPU端到端性能剖析,定位计算瓶颈

Weights & Biases:实验跟踪与模型性能可视化,支持多任务对比

7.2.3 相关框架与库

Librosa:音频信号处理的瑞士军刀,支持梅尔频谱、MFCC等特征提取

SoundFile:高效读写WAV/FLAC等音频文件,兼容多采样率

Fairseq:Facebook开源的序列建模工具包,包含语音翻译的先进模型

7.3 相关论文著作推荐

7.3.1 经典论文

《Whisper: A Robust Speech Recognition Model Built on Large-Scale Weakly Supervised Data》(OpenAI, 2022)

Whisper技术白皮书,详细描述训练数据、模型架构与实验结果

《End-to-End Speech Recognition with Transformer》(Google, 2017)

首次将Transformer应用于ASR,奠定端到端架构基础

《Unsupervised Cross-Lingual Representation Learning for Speech Recognition》(Meta, 2021)

跨语言语音处理的重要研究,启发Whisper的多语言建模思路

7.3.2 最新研究成果

《Robust Speech Recognition in Noisy Environments using Contrastive Predictive Coding》(ICASSP 2023)

探索自监督学习在噪声鲁棒性中的新应用

《Multilingual Speech Translation with Shared Subword Units》(ACL 2023)

优化跨语言翻译的子词单元共享机制,提升低资源语言性能

7.3.3 应用案例分析

《Whisper在TikTok内容审核中的实践》- TikTok技术博客

大规模视频处理中的工程优化经验,包含批量推理架构设计

《OpenAI Whisper在Zoom实时字幕中的应用》- Zoom技术文档

低延迟、高准确率的实时会议场景落地方案

8. 总结:未来发展趋势与挑战

8.1 技术演进方向

多模态深度融合:与GPT-4等大语言模型结合,实现”语音输入→语义理解→文本生成→语音输出”的全链条智能交互

边缘端部署优化:通过模型量化(如INT8量化)、知识蒸馏,使Whisper运行在手机、智能音箱等低算力设备

主动学习机制:利用用户反馈动态优化模型,自动识别并修正高频错误(如专业术语误译)

8.2 行业应用展望

无障碍沟通:开发实时多语言翻译耳机,打破语言壁垒

智能创作辅助:语音驱动的AIGC工具(如语音生成代码、剧本),提升内容创作效率

医疗健康领域:自动转录医患对话,生成结构化病历,降低医疗记录成本

8.3 核心挑战

算力需求与能耗:大规模训练需数千张GPU,限制中小企业应用

隐私保护:语音数据包含敏感信息,需完善边缘计算与联邦学习方案

长尾场景覆盖:极端噪声、方言混合、多说话人场景的识别准确率仍需提升

9. 附录:常见问题与解答

Q1:Whisper支持多少种语言?

A:官方发布版本支持98种语言的识别,其中50种支持语音翻译(如中英、法德互译),具体列表可查看OpenAI文档。

Q2:如何提升Whisper在专业领域(如法律、医疗)的识别准确率?

A:可采用迁移学习,在领域特定数据集上微调模型,或通过添加自定义词汇表(Custom Tokenizer)增强专业术语识别。

Q3:Whisper的推理延迟如何优化?

A:使用FP16精度推理、关闭时间戳生成、选择合适模型尺寸(如small模型比large快3倍),批量处理可进一步提升吞吐量。

Q4:是否支持实时流媒体输入?

A:是的,通过分帧处理(如每500ms输入一帧),结合滑动窗口机制,可实现低延迟的实时语音识别。

10. 扩展阅读 & 参考资料

OpenAI Whisper官方文档

Hugging Face Whisper模型页

语音识别评估指标详解

多语言语音处理技术综述

Whisper的出现不仅是语音识别技术的突破,更是AIGC生态从文本中心转向多模态交互的重要里程碑。其端到端架构与自监督学习范式,为跨模态生成提供了通用解决方案,预示着人机交互将进入更自然、更智能的时代。随着技术的持续演进,Whisper有望成为连接语音世界与数字世界的核心基础设施,推动AIGC从内容生成走向全场景智能交互。

暂无评论内容