一、概述

官网:https://kubernetes.io/zh-cn/docs/concepts/overview/

1.1 k8s是什么

Kubernetes 是一个可移植、可扩展的开源平台,用于管理容器化的工作负载和服务,方便进行声明式配置和自动化。Kubernetes 拥有一个庞大且快速增长的生态系统,其服务、支持和工具的使用范围广泛。

Kubernetes 这个名字源于希腊语,意为“舵手”或“飞行员”。K8s 这个缩写是因为 K 和 s 之间有 8 个字符的关系。 Google 在 2014 年开源了 Kubernetes 项目。 Kubernetes 建立在 Google 大规模运行生产工作负载十几年经验的基础上, 结合了社区中最优秀的想法和实践。

1.2 k8s 核心特性

Kubernetes 为你提供:

服务发现和负载均衡

Kubernetes 可以使用 DNS 名称或自己的 IP 地址来暴露容器。 如果进入容器的流量很大, Kubernetes 可以负载均衡并分配网络流量,从而使部署稳定。

存储编排

Kubernetes 允许你自动挂载你选择的存储系统,例如本地存储、公共云提供商等。

自动部署和回滚

你可以使用 Kubernetes 描述已部署容器的所需状态, 它可以以受控的速率将实际状态更改为期望状态。 例如,你可以自动化 Kubernetes 来为你的部署创建新容器, 删除现有容器并将它们的所有资源用于新容器。

自动完成装箱计算

你为 Kubernetes 提供许多节点组成的集群,在这个集群上运行容器化的任务。 你告诉 Kubernetes 每个容器需要多少 CPU 和内存 (RAM)。 Kubernetes 可以将这些容器按实际情况调度到你的节点上,以最佳方式利用你的资源。

自我修复

Kubernetes 将重新启动失败的容器、替换容器、杀死不响应用户定义的运行状况检查的容器, 并且在准备好服务之前不将其通告给客户端。

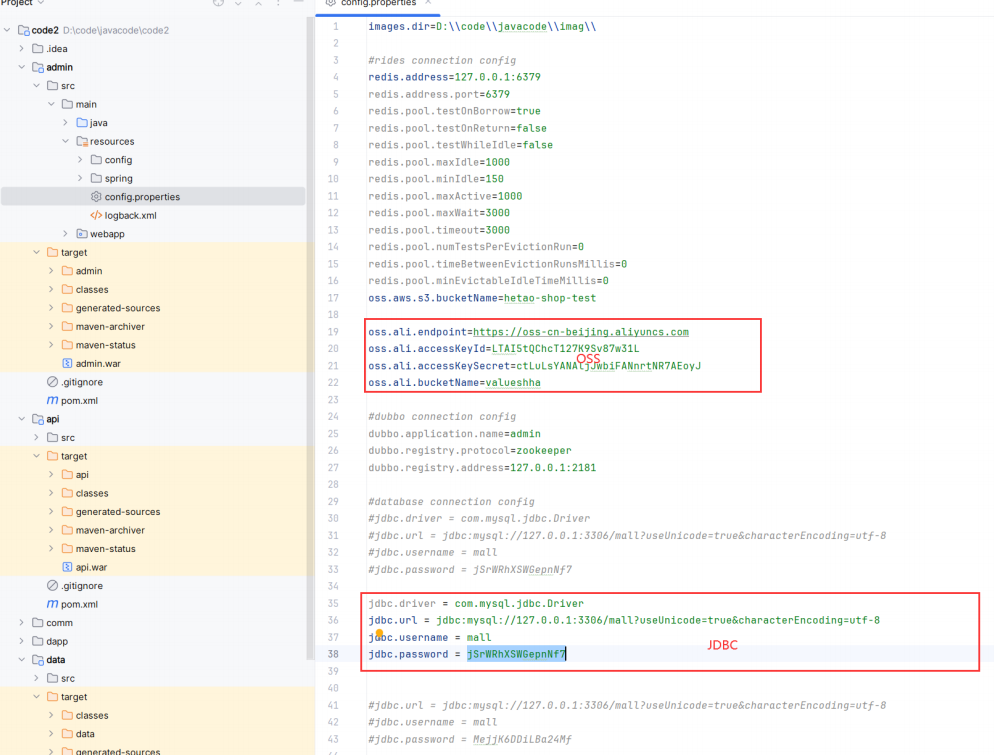

密钥与配置管理

Kubernetes 允许你存储和管理敏感信息,例如密码、OAuth 令牌和 SSH 密钥。 你可以在不重建容器镜像的情况下部署和更新密钥和应用程序配置,也无需在堆栈配置中暴露密钥。

批处理执行

除了服务外,Kubernetes 还可以管理你的批处理和 CI(持续集成)工作负载,如有需要,可以替换失败的容器。

水平扩缩

使用简单的命令、用户界面或根据 CPU 使用率自动对你的应用进行扩缩。

IPv4/IPv6 双栈

为 Pod(容器组)和 Service(服务)分配 IPv4 和 IPv6 地址。

为可扩展性设计

在不改变上游源代码的情况下为你的 Kubernetes 集群添加功能。

1.3 k8s 历史背景

传统部署时代:

早期,各个组织是在物理服务器上运行应用程序。 由于无法限制在物理服务器中运行的应用程序资源使用,因此会导致资源分配问题。 例如,如果在同一台物理服务器上运行多个应用程序, 则可能会出现一个应用程序占用大部分资源的情况,而导致其他应用程序的性能下降。 一种解决方案是将每个应用程序都运行在不同的物理服务器上, 但是当某个应用程序资源利用率不高时,剩余资源无法被分配给其他应用程序, 而且维护许多物理服务器的成本很高。

虚拟化部署时代:

因此,虚拟化技术被引入了。虚拟化技术允许你在单个物理服务器的 CPU 上运行多台虚拟机(VM)。 虚拟化能使应用程序在不同 VM 之间被彼此隔离,且能提供一定程度的安全性, 因为一个应用程序的信息不能被另一应用程序随意访问。

虚拟化技术能够更好地利用物理服务器的资源,并且因为可轻松地添加或更新应用程序, 而因此可以具有更高的可扩缩性,以及降低硬件成本等等的好处。 通过虚拟化,你可以将一组物理资源呈现为可丢弃的虚拟机集群。

每个 VM 是一台完整的计算机,在虚拟化硬件之上运行所有组件,包括其自己的操作系统。

容器部署时代:

容器类似于 VM,但是更宽松的隔离特性,使容器之间可以共享操作系统(OS)。 因此,容器比起 VM 被认为是更轻量级的。且与 VM 类似,每个容器都具有自己的文件系统、CPU、内存、进程空间等。 由于它们与基础架构分离,因此可以跨云和 OS 发行版本进行移植。

容器因具有许多优势而变得流行起来,例如:

敏捷应用程序的创建和部署:与使用 VM 镜像相比,提高了容器镜像创建的简便性和效率。

持续开发、集成和部署:通过快速简单的回滚(由于镜像不可变性), 提供可靠且频繁的容器镜像构建和部署。

关注开发与运维的分离:在构建、发布时创建应用程序容器镜像,而不是在部署时, 从而将应用程序与基础架构分离。

可观察性:不仅可以显示 OS 级别的信息和指标,还可以显示应用程序的运行状况和其他指标信号。

跨开发、测试和生产的环境一致性:在笔记本计算机上也可以和在云中运行一样的应用程序。

跨云和操作系统发行版本的可移植性:可在 Ubuntu、RHEL、CoreOS、本地、 Google Kubernetes Engine 和其他任何地方运行。

以应用程序为中心的管理:提高抽象级别,从在虚拟硬件上运行 OS 到使用逻辑资源在 OS 上运行应用程序。

松散耦合、分布式、弹性、解放的微服务:应用程序被分解成较小的独立部分, 并且可以动态部署和管理 – 而不是在一台大型单机上整体运行。

资源隔离:可预测的应用程序性能。

资源利用:高效率和高密度。

二、k8s集群安装

2.1 环境准备

| 系统版本 | 主机名 | IP | 基于服务 |

|---|---|---|---|

| centos 7.9 | bigdata101(master) | 192.168.163.101 | docker |

| bigdata102(node1) | 192.168.163.102 | ||

| bigdata103(node2) | 192.168.163.103 |

注:以上3台机器都是2C4G的虚拟机,仅供测试使用

docker部署可以参考:docker 部署

2.2 其他待检查项

#1、关闭防火墙

systemctl stop firewalld

systemctl disable firewalld

#2、关闭Selinux

setenforce 0

vim /etc/sysconfig/selinux

SELINUX=disabled #将此处改为disabled

#3、禁用swap交换分区

swapoff -a #临时禁用swap

vim /etc/fstab #打开自动挂载的配置文件,将swap配置项注释掉

#/dev/mapper/centos-swap swap swap defaults 0 0

free -m #查看下swap交换区是否都为0,如果都为0则swap关闭成功

#4、重启docker服务

systemctl daemon-reload

systemctl restart docker

#5、设置时间同步

yum install ntpdate -y

ntpdate time.windows.com2.3 安装

2.3.1 添加k8s源

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg

https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

2.3.2 查看可以安装的版本

yum list kubelet --showduplicates | sort -r

如果之前安装过k8s,先卸载旧版本

yum remove -y kubelet kubeadm kubectl 2.3.3 安装kubelet、kubeadm、kubectl

2.3.3 安装kubelet、kubeadm、kubectl

#我们使用kubeadm方式安装k8s集群(kubectl 可以只在master节点安装)

yum install -y kubelet-1.23.17-0 kubeadm-1.23.17-0 kubectl-1.23.17-0

#将kubelet加入开机自启

systemctl enable --now kubelet启动kubelet发现报错了 内容如下:

bigdata101 kubelet[11216]: E0427 11:54:04.818034 11216 server.go:302] “Failed to run kubelet” err=”failed to run Kubelet: misconfiguration: kubelet cgroup driver: “systemd” is different from docker cgroup driver: “cgroupfs””

Apr 27 11:54:04 bigdata101 systemd[1]: kubelet.service: main process exited, code=exited, status=1/FAILURE

Apr 27 11:54:04 bigdata101 systemd[1]: Unit kubelet.service entered failed state.

Apr 27 11:54:04 bigdata101 systemd[1]: kubelet.service failed.

修改kubelet 和docker cgroup都为systemd

#1. 停止 Kubelet 和 Docker 服务

sudo systemctl stop kubelet

sudo systemctl stop docker

#2. 修改 Docker 的 cgroup 驱动为 systemd

#编辑 Docker 的配置文件 /etc/docker/daemon.json,若文件不存在则创建它,添加或修改以下内容:

{

"exec-opts": ["native.cgroupdriver=systemd"]

}

#3. 重启 Docker 和 Kubelet 服务

sudo systemctl start docker

sudo systemctl start kubelet

#4. 检查 Kubelet 服务状态

sudo systemctl status kubelet

若服务正常启动,你会看到 Active: active (running) 的信息。

2.3.4 下载各个机器需要的镜像

#查看对应版本

kubeadm config images list --kubernetes-version v1.23.17 下载脚本如下:

下载脚本如下:

tee ./images.sh <<-'EOF'

#!/bin/bash

images=(

kube-apiserver:v1.23.17

kube-proxy:v1.23.17

kube-controller-manager:v1.23.17

kube-scheduler:v1.23.17

coredns:1.8.6

etcd:3.5.6-0

pause:3.6

)

for imageName in ${images[@]} ; do

docker pull registry.aliyuncs.com/google_containers/$imageName

done

EOF

chmod +x ./images.sh && ./images.sh

2.3.5 执行初始化(只在master节点执行)

kubeadm init

--apiserver-advertise-address=192.168.163.101

--control-plane-endpoint=bigdata101

--image-repository registry.aliyuncs.com/google_containers

--kubernetes-version v1.23.17

--service-cidr=10.96.0.0/12

--pod-network-cidr=10.244.0.0/16

说明:

# 在k8s-master机器上执行初始化操作(里面的第一个ip地址就是k8s-master机器的ip,改成你自己机器的,后面两个ip网段不用动)

#所有网络范围不重叠

apiserver-advertise-address =Master节点的 IP 地址。

control-plane-endpoint=master hostname

image-repository=docker镜像仓库地址。

kubernetes-version= 安装的kubernetes版本

service-cidr 和 apiserver-advertise-address 、pod-network-cidr 不能在同一个网络范围内。

不要使用 172.17.0.1/16 网段范围,因为这是 Docker 默认使用的。初始化可能比较慢。

# 可以查看kubelet日志

journalctl -xefu kubelet

#如果初始化失败,重置kubeadm

kubeadm reset

rm -rf /etc/cni/net.d $HOME/.kube/config

#清理 iptables 规则

iptables -F

iptables -X

iptables -t nat -F

iptables -t nat -X

iptables -t mangle -F

iptables -t mangle -X

iptables -P INPUT ACCEPT

iptables -P FORWARD ACCEPT

iptables -P OUTPUT ACCEPT

2.3.6 成功以后继续

#设置.kube/config

# 配置使用 kubectl 命令工具

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

export KUBECONFIG=/etc/kubernetes/admin.conf

#安装Calico网络插件

curl https://docs.projectcalico.org/archive/v3.20/manifests/calico.yaml -O

kubectl apply -f calico.yaml2.3.7 note节点加入集群

kubeadm join bigdata101:6443 --token 9igd7r.ffnwem58hpswzf8y

--discovery-token-ca-cert-hash sha256:af7a004f9c82e3f35a0b2d65eb6d9453da49fc003ca20dface2dbf2546d6d997

#可以命令重新生成令牌

kubeadm token create --print-join-command

# node节点执行kubectl命令kubectl get nodes出现下面的错误:

The connection to the server localhost:8080 was refused - did you specify the right host or port?

#在node节点配置KUBECONFIG环境变量即可

echo "export KUBECONFIG=/etc/kubernetes/kubelet.conf" >> /etc/profile

source /etc/profile2.3.8 验证

#master节点执行

kubectl get nodes

三、测试

用K8S部署Nginx

在k8s-master机器上执行

# 创建一次deployment部署

kubectl create deployment nginx --image=nginx

kubectl expose deployment nginx --port=80 --type=NodePort

# 查看Nginx的pod和service信息

kubectl get pod,svc -o wide

暂无评论内容