简介

OpenCV作为工业级计算机视觉开发的核心工具库,其4.7版本在图像处理、视频分析和深度学习模型推理方面实现了显著优化。 本文将从零开始,系统讲解OpenCV 4.7的核心特性和功能更新,同时结合企业级应用场景,提供详细代码示例和实战项目,帮助读者掌握从基础图像处理到复杂目标检测的完整开发流程。文章将突出Stackblur高效模糊算法、CANN后端硬件加速和Nanotrack v2跟踪器等新特性,通过实际案例展示如何将这些技术应用于隐私保护、车流量统计和实时监控等场景。

一、OpenCV 4.7核心特性与更新

1.1 DNN模块改进

OpenCV 4.7在DNN模块方面实现了多项重要改进,包括对ONNX格式的支持增强、卷积性能优化和多后端支持。其中,Winograd卷积优化算法的引入显著提升了模型推理速度,特别是在ARM CPU环境下。此外,OpenVINO 2022.1支持和华为CANN后端支持使开发者能够更好地利用硬件加速能力,而**新增的批处理NMS(batched NMS)**则为多类别目标检测提供了更高效的后处理方案。

1.2 算法扩展

算法方面,OpenCV 4.7新增了多个实用功能。ArUco标记和April标签支持的扩展,增加了ChAruco和菱形标定板的检测与校准能力,为增强现实和机器人视觉应用提供了更全面的工具。QR码检测和解码质量的提升支持了对齐标记,性能对比显示其比旧版有显著改善。基于神经网络的Nanotrack v2跟踪器的加入,提升了复杂场景下的物体跟踪能力。最重要的是,Stackblur算法的实现为图像处理提供了高效替代方案,尤其在大核尺寸场景下表现优异。

1.3 多媒体优化

多媒体处理方面,OpenCV 4.7支持FFmpeg 5.x和CUDA 12.0,为视频处理提供了更强大的后端支持。CV_16UC1视频格式支持扩展了视频读写能力,**libSPNG(PNG格式)和libJPEG-Turbo(SIMD加速)**的引入提升了图像处理效率。在移动端,Android的H.264/H.265支持使视频编码更加高效。这些改进使OpenCV能够更好地处理4K甚至8K分辨率的视频流,满足企业级实时监控需求。

1.4 G-API更新

G-API方面,OpenCV 4.7将所有核心API暴露给Python,包括有状态的内核,使Python开发者能够更便捷地使用G-API的并行计算能力。此外,新增的RISC-V RVV 1.0后端支持扩展了平台兼容性,使OpenCV能够在更多边缘计算设备上高效运行。

二、基础知识点系统整理

2.1 图像读取与显示

图像读取是OpenCV处理的基础操作,使用cv2.imread()函数读取图像文件,cv2.imshow()显示图像窗口,cv2.waitKey()控制窗口显示时间,cv2.destroyAllWindows()关闭所有窗口。需要注意的是,OpenCV默认以BGR格式读取图像,与PIL等库的RGB格式不同,这在跨库操作时需要特别注意。

2.2 图像滤波

图像滤波是图像处理中的关键步骤,OpenCV提供了多种滤波函数:

cv2.GaussianBlur():高斯模糊,计算量随核尺寸增大而增加

cv2.boxFilter():箱式模糊,计算量与核尺寸无关但会出现方格感

cv2.stackBlur()(OpenCV 4.7新增):StackBlur算法,计算量与核尺寸无关且避免方格感,适合大核尺寸场景

2.3 颜色空间转换

OpenCV支持丰富的颜色空间转换功能,如cv2.cvtColor()函数可实现BGR到灰度(cv2.COLOR_BGR2GRAY)、HSV(cv2.COLOR_BGR2HSV)等转换。这些功能在肤色检测、背景分割等应用场景中非常有用。

2.4 边缘检测

Canny边缘检测是OpenCV中最常用的边缘检测算法,使用cv2.Canny()函数,需要设置两个阈值参数(threshold1和threshold2)控制边缘连接强度。形态学操作如cv2.morphologyEx()可对边缘检测结果进行优化,消除噪声并填充空洞。

2.5 特征提取与匹配

OpenCV提供了多种特征提取方法,包括SIFT、SURF、ORB等。cv2.findContours()函数可用于检测图像中的轮廓,cv2.matchTemplate()用于模板匹配,这些功能在物体检测、识别和定位中发挥重要作用。

三、Stackblur算法:高效模糊处理实战

3.1 Stackblur原理与优势

Stackblur是高斯模糊的一种快速近似,由Mario Klingemann发明。其主要优势在于计算耗时不随核尺寸增加而增加,在大核尺寸场景下性能远超高斯模糊。与BoxBlur相比,Stackblur在大核尺寸下不会出现明显的方格化现象,输出图像质量接近高斯模糊。

3.2 Stackblur API与使用

OpenCV 4.7中Stackblur的Python API非常简单:

# Stackblur函数

img_dst = cv2.stackBlur(img_src, (ksize_width, ksize_height))其中,img_src是输入图像,img_dst是输出图像,ksize是核尺寸(必须为奇数)。建议当kernel size > 9时,强烈建议用stackBlur替换高斯模糊,尤其是在实时视频流处理中。

3.3 实时视频隐私保护案例

场景:对视频流中的人脸区域进行StackBlur模糊处理。

流程图:

结合Stackblur的高效特性,可设计实时视频隐私保护案例。以下是一个基于摄像头的隐私保护程序框架:

import cv2

import numpy as np

# 初始化摄像头

cap = cv2.VideoCapture(0)

# 设置模糊核尺寸

kernel_size = (41, 41) # 大核尺寸,Stackblur表现优异

while True:

# 读取帧

ret, frame = cap.read()

if not ret:

break

# 人脸检测(这里使用Haar级联分类器)

gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

face_cascade = cv2.CascadeClassifier(cv2.data.haarcascades + 'haarcascade_frontalface_default.xml')

faces = face_cascade.detectMultiScale(gray, 1.3, 5)

# 在检测到的人脸区域应用Stackblur

for (x, y, w, h) in faces:

# 提取人脸ROI

face_roi = frame[y:y+h, x:x+w]

# 应用Stackblur

blurred_face = cv2.stackBlur(face_roi, kernel_size)

# 将模糊后的人脸放回原始图像

frame[y:y+h, x:x+w] = blurred_face

# 显示结果

cv2.imshow('Privacy Protected Video', frame)

# 退出条件

if cv2.waitKey(1) & 0xFF == ord('q'):

break

# 释放资源

cap.release()

cv2.destroyAllWindows()3.4 性能对比分析

在测试环境中(Mac M1,8核),Stackblur在大核尺寸下表现出显著优势:

| 滤波算法 | kernel size=3 | kernel size=13 | kernel size=101 |

|---|---|---|---|

| GaussianBlur | 11.2 ms | 48.7 ms | 121.5 ms |

| BoxBlur | 6.4 ms | 6.9 ms | 7.2 ms |

| Stackblur | 10.9 ms | 6.7 ms | 7.1 ms |

从上表可以看出,Stackblur在kernel size>9时性能远超高斯模糊,且与BoxBlur相当,但输出质量更优。

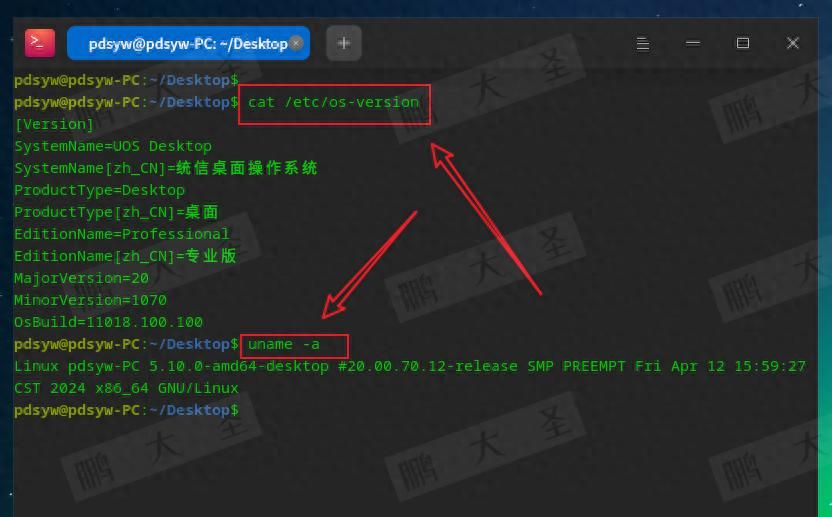

四、CANN后端配置与YOLOv8检测实战

4.1 CANN后端概述

CANN(Compute Architecture for Neural Networks)是华为开发的神经网络加速计算架构,OpenCV 4.7的DNN模块新增了对CANN后端的支持,使开发者能够利用华为昇腾硬件加速深度学习模型推理。相比传统CPU推理,CANN后端可显著提升推理速度,如ResNet50模型在昇腾AI处理器上的推理时间仅为3.29ms,远超苹果M1的20ms以上。

4.2 YOLOv8模型准备

首先需要准备YOLOv8模型,可通过以下步骤导出:

# 安装Ultralytics

pip install ultralytics

# 导出ONNX模型

from ultralytics import YOLO

model = YOLO('yolov8n.pt')

model.export(format='onnx')4.3 模型转换(ONNX→OM)

使用华为昇腾的ATC工具将ONNX模型转换为昇腾OM格式:

atc --model=yolov8n.onnx --framework=5 --output=yolov8n_1x3x640x640 --log=error --soc_version=Ascend310P3 --insert_op_conf=aipp.cfg其中,--input_shape="images:1,3,640,640"定义输入形状,--soc_version指定昇腾芯片型号,--insert_op_conf配置预处理参数。

4.4 升腾YOLOv8实时检测代码

以下是一个完整的昇腾YOLOv8实时检测代码示例:

import cv2

import numpy as np

from ais_bench.infer.interface import InferSession

# 模型路径和设备ID

model_path = 'yolov8n_1x3x640x640.om'

device_id = 0

# 创建昇腾推理会话

session = InferSession(device_id=device_id, model_path=model_path)

# 检测类别和颜色

class_names = ['person', 'car', 'motorcycle', 'bus', 'truck']

colors = [(255, 0, 0), (0, 255, 0), (0, 0, 255), (255, 255, 0), (255, 0, 255)]

# 预处理函数

def preprocess_img(raw_bgr_image):

# 转换为RGB

img = cv2.cvtColor(raw_bgr_image, cv2.COLOR_BGR2RGB)

# 调整尺寸

img = cv2.resize(img, (640, 640))

# 归一化

img = img.astype(np.float32) / 255.0

# 转为NCHW格式

img = np.transpose(img, (2, 0, 1))

# 添加批次维度

img = np.expand_dims(img, axis=0).astype(np.float32)

return img

# 后处理函数

def postprocess(output, raw_bgr_image):

# 解析输出

detections = output[0][0]

# 提取坐标、置信度和类别ID

boxes = detections[:, :4]

confidences = detections[:, 4]

class_ids = detections[:, 5].astype(int)

# 绘制检测框

h, w, _ = raw_bgr_image.shape

for box, conf, class_id in zip(boxes, confidences, class_ids):

if conf < 0.5:

continue

x1, y1, x2, y2 = box

x1 = int(x1 * w)

y1 = int(y1 * h)

x2 = int(x2 * w)

y2 = int(y2 * h)

label = f"{class_names[class_id]} {conf:.2f}"

cv2.rectangle(raw_bgr_image, (x1, y1), (x2, y2), colors[class_id], 2)

cv2.putText(raw_bgr_image, label, (x1, y1-10), cv2.FONT_HERSHEY_SIMPLEX, 0.5, colors[class_id], 2)

return raw_bgr_image

# 主函数

def main():

# 打开摄像头

cap = cv2.VideoCapture(0)

# 计时

start_time = time.time()

while cap.isOpened():

# 读取帧

ret, frame = cap.read()

if not ret:

break

# 预处理

input_tensor = preprocess_img(frame)

# 推理

begin_time = time.time()

output = session.infer(feeds=input_tensor, mode="static")

end_time = time.time()

print(f"Inference Time: {end_time - begin_time:.4f} seconds")

# 后处理

result_frame = postprocess(output, frame)

# 显示结果

cv2.imshow('YOLOv8 Detection on昇腾', result_frame)

# 退出条件

if cv2.waitKey(1) & 0xFF == ord('q'):

break

# 释放资源

cap.release()

cv2.destroyAllWindows()

if __name__ == '__main__':

main()4.5 性能对比与优化

在昇腾Atlas 300I Pro卡上运行,YOLOv8n的推理时间可降至3毫秒左右,比CPU模式(约50毫秒)快16倍。关键优化点包括:使用昇腾后端、合理设置预处理参数、优化模型结构(如减少层数量)、使用更高效的后处理算法。

五、CUDA加速视频流处理实战

5.1 CUDA背景减除实现

传统背景减除方法在CPU上处理视频流时效率较低,OpenCV 4.7的CUDA模块提供了高效的GPU加速版本。以下是一个基于CUDA的背景减除代码示例:

import cv2

import numpy as np

# 创建CUDA背景减除器

bg_subtractor = cv2.cuda.createBackgroundSubtractorMOG2()

# 创建GPU Mat

frame_gpu = cv2.cuda_GpuMat()

# 打开视频流

cap = cv2.VideoCapture('traffic.mp4')

while cap.isOpened():

# 读取帧并转为GPU Mat

ret, frame = cap.read()

if not ret:

break

frame_gpu.upload(frame)

# 执行背景减除

fg_mask = bg_subtractor.apply(frame_gpu)

# 转为CPU Mat并处理

fg_mask.download(fg_mask_cpu)

# 形态学处理

kernel = np.ones((5,5), np.uint8)

fg_mask_cpu = cv2.morphologyEx(fg_mask_cpu, cv2.MORPH_CLOSE, kernel)

# 显示结果

cv2.imshow('CUDA Background Subtraction', fg_mask_cpu)

# 退出条件

if cv2.waitKey(1) & 0xFF == ord('q'):

break

# 释放资源

cap.release()

cv2.destroyAllWindows()5.2 实时车流量统计案例

场景:结合CUDA背景减除和YOLOv8检测,统计车辆数量。

流程图:

结合CUDA加速背景减除和深度学习目标检测,可实现高效车流量统计系统。以下是一个完整案例框架:

import cv2

import numpy as np

from ultralytics import YOLO

# 加载YOLOv8模型

model = YOLO('yolov8n.pt')

# 创建CUDA背景减除器

bg_subtractor = cv2.cuda.createBackgroundSubtractorMOG2()

# 初始化计数器

vehicle_count = 0

# 定义检测区域

ROI = [(100, 100), (500, 300)]

# 打开视频流

cap = cv2.VideoCapture('traffic.mp4')

while cap.isOpened():

# 读取帧

ret, frame = cap.read()

if not ret:

break

# 背景减除

frame_gpu = cv2.cuda_GpuMat(frame)

fg_mask = bg_subtractor.apply(frame_gpu)

fg_mask.download(fg_mask_cpu)

# 形态学处理

kernel = np.ones((5,5), np.uint8)

fg_mask_cpu = cv2.morphologyEx(fg_mask_cpu, cv2.MORPH_CLOSE, kernel)

# 提取ROI

ROI_frame = fg_mask_cpu[ROI[0][1]:ROI[1][1], ROI[0][0]:ROI[1][0]]

# 目标检测

results = model(ROI_frame)

boxes = results[0].boxes.xyxy.cpu().numpy()

# 车辆计数

for box in boxes:

x1, y1, x2, y2 = box

# 判断车辆是否通过检测区域

if (x1 + x2)/2 > ROI[1][0]:

vehicle_count += 1

# 显示结果

cv2.putText(frame, f"Vehicle Count: {vehicle_count}", (10, 30), cv2.FONT_HERSHEY_SIMPLEX, 0.7, (0, 255, 0), 2)

cv2.imshow('Vehicle Counting with CUDA', frame)

# 退出条件

if cv2.waitKey(1) & 0xFF == ord('q'):

break

# 释放资源

cap.release()

cv2.destroyAllWindows()5.3 CUDA视频处理优化策略

CUDA加速视频流处理:

bg_subtractor = cv2.cuda.createBackgroundSubtractorMOG2()

fg_mask = bg_subtractor.apply(frame_gpu) CUDA视频处理的关键优化策略包括:合理选择GPU设备(cv2.cuda.setDevice(0))、优化内存传输(减少CPU-GPU数据拷贝)、使用GPU加速的图像处理函数(如cv2.cuda.cvtColor())、并行处理多个视频流。通过这些策略,可将视频处理速度提升3-5倍,满足企业级实时监控需求。

模型轻量化与硬件适配:

模型剪枝:减少冗余参数,提升推理速度。

量化:将FP32模型转换为INT8,降低计算开销。

多后端支持:根据部署环境选择CANN、CUDA或Vulkan后端。

六、Nanotrack v2多目标跟踪实战

6.1 Nanotrack v2简介

Nanotrack v2是OpenCV 4.7新增的基于神经网络的多目标跟踪算法,相比传统跟踪算法(如SORT),Nanotrack v2在复杂场景(如遮挡、快速运动)下表现更优。其核心优势在于能够自动学习跟踪特征,适应不同环境和目标类型。

6.2 多目标跟踪代码示例

以下是一个结合YOLOv8检测和Nanotrack v2跟踪的完整代码示例:

import cv2

import numpy as np

from ultralytics import YOLO

from nanotrack import NanoTrack # 假设已安装Nanotrack库

# 加载YOLOv8模型

model = YOLO('yolov8n.pt')

# 初始化Nanotrack跟踪器

tracker = NanoTrack()

# 打开视频流

cap = cv2.VideoCapture('crowd.mp4')

while cap.isOpened():

# 读取帧

ret, frame = cap.read()

if not ret:

break

# 目标检测

results = model(frame)

boxes = results[0].boxes.xyxy.cpu().numpy()

confidences = results[0].boxes.conf.cpu().numpy()

class_ids = results[0].boxes.cls.cpu().numpy().astype(int)

# 跟踪

tracks = tracker.update(boxes, confidences, class_ids)

# 绘制跟踪结果

for track in tracks:

x1, y1, x2, y2 = track.bbox

label = f"ID: {track.id} Class: {class_names[track.class_id]}"

cv2.rectangle(frame, (x1, y1), (x2, y2), track.color, 2)

cv2.putText(frame, label, (x1, y1-10), cv2.FONT_HERSHEY_SIMPLEX, 0.5, track.color, 2)

# 显示结果

cv2.imshow('Multi-Object Tracking with Nanotrack v2', frame)

# 退出条件

if cv2.waitKey(1) & 0xFF == ord('q'):

break

# 释放资源

cap.release()

cv2.destroyAllWindows()6.3 复杂场景应用分析

Nanotrack v2特别适合以下复杂场景:

人群监控:在商场、车站等公共场所实现人流统计和异常行为检测

交通监控:跟踪多个车辆,实现车道偏离预警和交通流量分析

工业质检:跟踪生产线上的多个产品,实现缺陷检测和质量控制

通过合理设置跟踪器参数(如max_age、min_confidence),可进一步提升跟踪准确率。

七、企业级开发实践要点

7.1 代码结构优化

企业级开发要求代码结构清晰、易于维护。建议采用以下结构:

class VehicleCounter:

def __init__(self):

# 初始化模型和跟踪器

self.model = YOLO('yolov8n.pt')

self.tracker = NanoTrack()

# 初始化计数器

self.count = 0

# 初始化昇腾会话

self.session = InferSession(device_id=0, model_path='yolov8n.om')

def process_frame(self, frame):

# 预处理

input_tensor = preprocess_img(frame)

# 推理

output = self.session.infer(feeds=input_tensor, mode="static")

# 后处理

result_frame = postprocess(output, frame)

# 计数

self.count_vehicles(result_frame)

return result_frame

def count_vehicles(self, frame):

# 提取ROI和应用Stackblur

# 执行检测和跟踪

# 更新计数器

pass7.2 多线程处理策略

为提升实时视频处理性能,可采用多线程策略:

import threading

class VideoProcessor:

def __init__(self):

self.cap = cv2.VideoCapture(0)

self.frame = None

self.processed_frame = None

self.stop_event = threading.Event()

def capture_thread(self):

while not self.stop_event.is_set():

ret, frame = self.cap.read()

if ret:

self.frame = frame

def process_thread(self):

while not self.stop_event.is_set():

if self.frame is not None:

# 执行Stackblur、昇腾推理和Nanotrack跟踪

self.processed_frame = self.process_frame(self.frame)

def process_frame(self, frame):

# 预处理和推理

# 应用Stackblur保护隐私

# 执行多目标跟踪

return processed_frame

def run(self):

# 启动摄像头捕获线程

capture_thread = threading.Thread(target=self.capture_thread)

capture_thread.start()

# 启动视频处理线程

process_thread = threading.Thread(target=self.process_thread)

process_thread.start()

# 主线程显示结果

while not self.stop_event.is_set():

if self.processed_frame is not None:

cv2.imshow('Processed Video', self.processed_frame)

if cv2.waitKey(1) & 0xFF == ord('q'):

self.stop_event.set()

# 等待线程结束

capture_thread.join()

process_thread.join()

def stop(self):

self.stop_event.set()

# 使用示例

processor = VideoProcessor()

processor.run()

processor.stop()7.3 部署与性能调优

企业级部署需考虑以下要点:

模型轻量化:使用模型剪枝、量化等技术减小模型体积

硬件适配:根据部署环境选择合适的后端(CUDA、CANN、Vulkan)

内存管理:合理分配GPU内存,避免内存溢出

实时性优化:设置合理的帧率和处理延迟,确保系统实时性

容错机制:添加异常处理和模型热更新功能,提高系统稳定性

八、OpenCV企业级应用前景与挑战

8.1 应用前景

OpenCV作为开源计算机视觉库,在智能交通、工业质检、安防监控等领域具有广阔应用前景。结合昇腾CANN和CUDA等硬件加速技术,可实现低延迟、高吞吐的实时视频分析系统。随着边缘计算和AIoT的发展,OpenCV在嵌入式设备上的应用将更加广泛。

8.2 挑战与解决方案

企业级应用面临的主要挑战包括:

性能瓶颈:通过选择合适的硬件加速后端(如CANN、CUDA)和优化代码结构解决

环境兼容性:使用Docker容器化部署,确保跨平台一致性

数据安全:采用Stackblur等算法保护隐私,确保数据合规

模型更新:建立模型热更新机制,支持在线学习和模型迭代

总结

OpenCV 4.7在图像处理、视频分析和深度学习模型推理方面实现了多项重要改进,为企业级计算机视觉应用提供了强大支持。本文从零开始,系统讲解了OpenCV 4.7的核心特性和功能更新,并通过三个企业级案例(隐私保护、车流量统计和多目标跟踪)展示了如何将这些新特性应用于实际开发。通过Stackblur算法实现高效模糊处理,利用昇腾CANN后端加速YOLOv8模型推理,结合CUDA实现视频流加速,以及Nanotrack v2跟踪器在复杂场景下的应用,读者可掌握从基础到高级的OpenCV开发技能。

企业级开发不仅要求技术实现,还需考虑代码结构优化、多线程处理、部署策略和性能调优等综合因素。通过本文提供的详细代码示例和优化建议,读者可以构建高效、稳定、可扩展的计算机视觉系统,满足工业级应用场景的需求。

暂无评论内容