AI生成测试用例:自动化测试的未来已来

关键词:AI测试用例生成、自动化测试、覆盖率优化、智能测试、软件质量保障

摘要:传统手动编写测试用例耗时耗力,覆盖率不足的问题一直困扰着软件测试团队。本文将带您走进”AI生成测试用例”的世界,通过生活类比、技术原理解析、实战案例演示,揭示这项技术如何像”智能出题老师”一样,自动生成高覆盖率的测试用例,大幅提升测试效率。无论是测试工程师、开发人员,还是对AI应用感兴趣的技术爱好者,都能从中理解AI如何重构自动化测试的未来。

背景介绍

目的和范围

本文旨在解答三个核心问题:

为什么传统测试用例生成方式需要被革新?

AI生成测试用例的底层逻辑是什么?

如何在实际项目中落地这项技术?

我们将覆盖从基础概念到实战应用的全链路知识,帮助读者建立完整的技术认知。

预期读者

软件测试工程师(想了解AI如何提升测试效率)

开发人员(想理解测试用例生成逻辑以优化代码)

技术管理者(想评估AI测试的投入产出比)

对AI应用感兴趣的技术爱好者

文档结构概述

本文将按照”问题背景→核心概念→技术原理→实战案例→未来趋势”的逻辑展开,通过生活故事引入,结合代码示例和数学模型,最终给出可落地的实践建议。

术语表

核心术语定义

测试用例(Test Case):验证软件功能的”考试题”,包含输入数据、操作步骤和预期结果(例如:测试登录功能时,输入”错误密码”,点击登录,预期提示”密码错误”)。

自动化测试(Automated Testing):用程序代替人工执行测试用例的”自动判卷机”(例如:用Selenium自动填写表单并验证结果)。

AI生成测试用例(AI-Generated Test Case):通过机器学习模型自动生成测试用例的”智能出题老师”(例如:AI分析登录功能代码后,自动生成”连续5次输错密码”的边界测试用例)。

相关概念解释

覆盖率(Coverage):测试用例覆盖代码逻辑的比例(就像考试题目覆盖教材章节的比例)。

边界条件(Edge Case):输入数据的极端值(例如:年龄输入”-1″或”200″)。

自然语言处理(NLP):让计算机理解人类语言的技术(AI能”阅读”需求文档,提取测试点)。

核心概念与联系

故事引入:小明的考试烦恼

小明是一名小学老师,每天要花2小时为数学考试出题。他发现两个问题:

手动出题容易漏掉”99+1″这种边界题(覆盖率不足);

每次考试题目类似,学生”背答案”就能过关(测试用例重复)。

后来,学校引进了”智能出题系统”:系统先分析数学教材的重点章节(代码逻辑),再结合往年错题(历史缺陷),自动生成”99+1″”0.1+0.2″等易错题(高价值测试用例)。小明的工作时间从2小时缩短到10分钟,学生的真实水平也被准确测出。

这个故事里,”智能出题系统”就是AI生成测试用例技术的缩影——用AI代替人工,生成更全面、更精准的测试用例。

核心概念解释(像给小学生讲故事一样)

核心概念一:测试用例——软件的”考试题”

想象你是一名”软件考官”,需要判断一个”登录功能”是否合格。你会设计哪些”考题”?

输入正确的账号密码(基础题)

输入错误的密码(常见错题)

输入空的用户名(边界题)

这些”考题”就是测试用例。传统方式需要人工设计,就像老师手动出题,容易漏掉”连续输错5次密码”这种复杂题。

核心概念二:自动化测试——测试用例的”自动判卷机”

有了”考试题”(测试用例),还需要”判卷”。传统人工判卷(手动点击测试)效率低,自动化测试就像”自动判卷机”:用程序代替人工执行测试用例,自动比较实际结果和预期结果(例如:用Selenium自动填写密码,自动检查是否弹出”密码错误”提示)。

核心概念三:AI生成测试用例——测试用例的”智能出题老师”

传统测试用例生成依赖人工经验,就像老师只能出自己熟悉的题目。AI生成测试用例则像”智能出题老师”:它能”阅读”代码(分析代码逻辑)、”学习”历史缺陷(统计过去常出错的场景)、”理解”需求文档(提取测试点),然后自动生成覆盖更全面、更精准的测试用例(例如:自动生成”用户名包含特殊符号@#”的测试用例)。

核心概念之间的关系(用小学生能理解的比喻)

三个核心概念就像”出题→考试→判卷”的完整流程:

**测试用例(出题)**是基础,没有考题就无法考试;

**自动化测试(判卷)**是执行工具,让考题能高效验证;

**AI生成测试用例(智能出题)**是优化出题环节,让考题更全面、更精准。

举个生活例子:

你想开一家奶茶店,需要测试”点单系统”是否可靠:

测试用例(出题):设计”点大杯奶茶加珍珠” “点小杯奶茶不加糖”等测试场景;

自动化测试(判卷):用程序自动模拟点单,检查系统是否正确计算价格;

AI生成测试用例(智能出题):AI分析系统代码后,发现”同时选热饮和冰饮”会导致价格计算错误,于是自动生成这个测试用例(传统人工可能漏掉)。

核心概念原理和架构的文本示意图

AI生成测试用例的核心架构可概括为”输入→分析→生成→验证”四步:

输入数据:代码(代码结构、分支逻辑)、需求文档(功能描述)、历史缺陷(过去常出错的场景);

分析模块:用自然语言处理(NLP)解析需求文档,用静态代码分析提取代码分支(例如if-else语句);

生成模块:通过机器学习模型(如GPT、强化学习)生成测试用例;

验证模块:计算覆盖率(测试用例覆盖了多少代码分支),反馈优化生成模型。

Mermaid 流程图

核心算法原理 & 具体操作步骤

AI生成测试用例的核心算法主要分为三类:基于规则的生成、基于机器学习的生成、基于强化学习的生成。我们以最常用的基于机器学习(如GPT)的生成方式为例,用Python代码演示原理。

算法原理:用大语言模型理解需求,生成测试用例

大语言模型(如GPT-3.5)能”阅读”需求文档,提取关键功能点,然后生成对应的测试用例。例如,需求文档中写”用户登录时,密码错误超过3次,账号锁定10分钟”,AI会生成以下测试用例:

输入错误密码1次→账号未锁定;

输入错误密码3次→账号锁定;

输入错误密码4次→账号已锁定(不再提示错误)。

具体操作步骤(Python代码示例)

我们用OpenAI的GPT-3.5 API实现一个简单的”需求文档→测试用例”生成工具。

步骤1:安装依赖库

pip install openai

步骤2:编写生成函数

import openai

# 设置API密钥(需替换为你自己的密钥)

openai.api_key = "your_openai_api_key"

def generate_test_cases(requirement: str) -> str:

"""

根据需求文档生成测试用例

:param requirement: 需求描述(例如:"用户登录时,密码错误超过3次,账号锁定10分钟")

:return: 生成的测试用例

"""

# 设计提示词(告诉AI要做什么)

prompt = f"""

你是一名专业的软件测试工程师。请根据以下需求文档,生成5个测试用例。

需求文档:{

requirement}

测试用例格式:测试用例编号、测试项、输入数据、操作步骤、预期结果

"""

# 调用GPT-3.5 API

response = openai.ChatCompletion.create(

model="gpt-3.5-turbo",

messages=[{

"role": "user", "content": prompt}]

)

return response.choices[0].message['content']

# 测试:输入需求,生成用例

requirement = "用户登录时,密码错误超过3次,账号锁定10分钟"

test_cases = generate_test_cases(requirement)

print(test_cases)

步骤3:运行结果示例

测试用例编号:TC001

测试项:密码错误1次,账号未锁定

输入数据:正确用户名,错误密码(如"123456")

操作步骤:输入用户名和错误密码,点击登录

预期结果:提示"密码错误",账号未锁定

测试用例编号:TC002

测试项:密码错误3次,账号锁定

输入数据:正确用户名,错误密码(如"123456")

操作步骤:连续3次输入错误密码并登录

预期结果:第3次登录后提示"账号已锁定10分钟"

...(共5个用例)

算法优化:结合代码覆盖率的反馈

上面的示例仅基于需求文档生成用例,实际中还需结合代码逻辑优化。例如,通过**静态代码分析工具(如Coverage.py)**获取代码分支(if-else语句),然后让AI优先生成覆盖未被测试的分支的用例。

数学模型和公式 & 详细讲解 & 举例说明

AI生成测试用例的核心目标是提升覆盖率,常用的数学指标是分支覆盖率(Branch Coverage),即测试用例覆盖的代码分支数占总分支数的比例。

分支覆盖率公式

分支覆盖率 = 被覆盖的分支数 总分支数 × 100 % ext{分支覆盖率} = frac{ ext{被覆盖的分支数}}{ ext{总分支数}} imes 100\% 分支覆盖率=总分支数被覆盖的分支数×100%

举例说明

假设有一个登录功能的代码逻辑如下(Python伪代码):

def login(username, password):

if check_username(username): # 分支1

if check_password(password): # 分支2

return "登录成功"

else:

return "密码错误" # 分支3

else:

return "用户不存在" # 分支4

总共有4个分支(分支1的True/False,分支2的True/False)。

如果测试用例覆盖了”用户存在且密码正确”(分支1-True,分支2-True),则覆盖2个分支,覆盖率=2/4=50%;

如果AI生成的用例覆盖了”用户存在但密码错误”(分支1-True,分支2-False)和”用户不存在”(分支1-False),则覆盖4个分支,覆盖率=4/4=100%。

如何用AI提升覆盖率?

AI可以通过**强化学习(Reinforcement Learning)**优化生成策略:每次生成用例后,计算当前覆盖率,然后调整生成策略(例如:优先生成覆盖未覆盖分支的用例)。这类似于”玩游戏通关”——AI通过”尝试→反馈→调整”,逐步覆盖所有分支。

项目实战:代码实际案例和详细解释说明

我们以一个实际的”用户注册功能”为例,演示如何用AI生成测试用例并执行自动化测试。

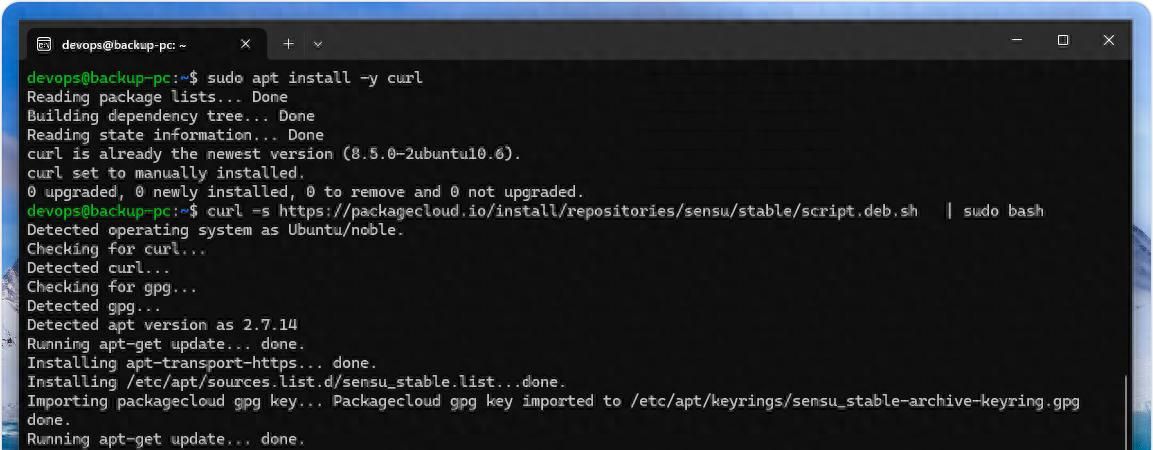

开发环境搭建

操作系统:Windows 10/macOS

工具:Python 3.9+、OpenAI API、Selenium(自动化测试工具)、Coverage.py(代码覆盖率工具)

源代码详细实现和代码解读

步骤1:编写待测试的注册功能(Flask后端)

# app.py(注册功能代码)

from flask import Flask, request, jsonify

app = Flask(__name__)

def is_valid_email(email: str) -> bool:

"""验证邮箱格式是否正确"""

return "@" in email and "." in email.split("@")[1]

def is_strong_password(password: str) -> bool:

"""验证密码是否强度足够(至少8位,包含字母和数字)"""

return len(password) >= 8 and any(c.isalpha() for c in password) and any(c.isdigit() for c in password)

@app.route('/register', methods=['POST'])

def register():

data = request.get_json()

username = data.get('username')

email = data.get('email')

password = data.get('password')

# 分支1:用户名是否为空

if not username:

return jsonify({

"code": 400, "message": "用户名不能为空"})

# 分支2:邮箱格式是否正确

if not is_valid_email(email):

return jsonify({

"code": 400, "message": "邮箱格式错误"})

# 分支3:密码强度是否足够

if not is_strong_password(password):

return jsonify({

"code": 400, "message": "密码需至少8位,包含字母和数字"})

# 所有验证通过,注册成功

return jsonify({

"code": 200, "message": "注册成功"})

if __name__ == '__main__':

app.run(debug=True)

步骤2:用AI生成测试用例

需求文档:“用户注册时,需验证用户名非空、邮箱格式正确、密码强度足够(至少8位,包含字母和数字)”。

调用之前写的generate_test_cases函数,生成的测试用例可能包括:

TC001:用户名为空,邮箱正确,密码强度足够→预期返回”用户名不能为空”;

TC002:用户名非空,邮箱错误(无@),密码强度足够→预期返回”邮箱格式错误”;

TC003:用户名非空,邮箱正确,密码过短(6位)→预期返回”密码需至少8位…”;

TC004:用户名非空,邮箱正确,密码强度足够(8位,含字母数字)→预期返回”注册成功”。

步骤3:用Selenium执行自动化测试(验证用例)

编写自动化测试脚本,调用/register接口,验证返回结果是否符合预期:

# test_register.py(自动化测试脚本)

import requests

import unittest

class TestRegister(unittest.TestCase):

def test_tc001_username_empty(self):

# 测试用例TC001:用户名为空

payload = {

"username": "", # 空用户名

"email": "test@example.com",

"password": "Pass1234" # 符合要求的密码

}

response = requests.post("http://localhost:5000/register", json=payload)

self.assertEqual(response.json()["code"], 400)

self.assertEqual(response.json()["message"], "用户名不能为空")

def test_tc002_email_invalid(self):

# 测试用例TC002:邮箱格式错误

payload = {

"username": "test_user",

"email": "invalid_email", # 无@符号

"password": "Pass1234"

}

response = requests.post("http://localhost:5000/register", json=payload)

self.assertEqual(response.json()["code"], 400)

self.assertEqual(response.json()["message"], "邮箱格式错误")

# 其他测试用例类似...

if __name__ == '__main__':

unittest.main()

代码解读与分析

AI生成用例:通过分析需求文档和代码分支(用户名非空、邮箱验证、密码验证),生成覆盖所有分支的测试用例;

自动化执行:用requests库调用接口,unittest框架断言结果是否符合预期;

覆盖率验证:运行coverage run -m unittest test_register.py,再用coverage report查看分支覆盖率(理论上可达100%)。

实际应用场景

AI生成测试用例已在多个领域落地,以下是常见场景:

1. Web应用测试

场景:测试电商网站的”购物车”功能(添加商品、修改数量、结算);

AI优势:自动生成”同时添加5件商品””修改数量为0″”使用优惠券后价格计算”等复杂用例(传统人工可能漏掉边界情况)。

2. 移动端应用测试

场景:测试社交App的”消息发送”功能(文字、图片、语音);

AI优势:结合移动端特性(网络切换、内存不足),生成”弱网环境下发送图片””后台运行时接收消息”等用例。

3. API接口测试

场景:测试金融系统的”转账接口”(金额、账户类型、手续费);

AI优势:分析接口参数的约束(如金额>0),生成”金额为0″“金额为负数””超大金额(超出数据库字段长度)”等异常用例。

工具和资源推荐

1. 商业工具

Testim:基于AI的端到端测试平台,支持自动生成测试用例并适应UI变化;

Applitools:AI驱动的视觉测试工具,能自动识别UI异常(如按钮错位);

Rainforest QA: crowdsourced测试平台+AI生成用例,覆盖真实设备和场景。

2. 开源工具

Atheris:Google开源的模糊测试(Fuzz Testing)工具,基于Python,用AI生成随机输入并检测崩溃;

Coverage.py:Python代码覆盖率工具,可结合AI优化用例生成策略;

LangChain:大语言模型应用框架,可自定义提示词优化测试用例生成质量。

3. 学习资源

书籍:《人工智能测试:从理论到实践》《自动化测试的艺术》;

课程:Coursera《AI in Software Testing》;

社区:GitHub的AI测试相关仓库(如AI-driven-testing)。

未来发展趋势与挑战

趋势1:多模态输入生成用例

未来AI不仅能分析代码和需求文档,还能”阅读”UI截图、视频(如用户操作录屏),生成更贴合实际使用场景的测试用例(例如:根据用户滑动屏幕的视频,生成”快速滑动时列表加载”的测试用例)。

趋势2:与CI/CD深度集成

AI生成的测试用例将直接嵌入持续集成/持续部署(CI/CD)流水线,实现”代码提交→自动生成用例→自动执行测试→反馈结果”的全自动化流程(例如:开发者提交代码后,AI立即生成新功能的测试用例并运行,5分钟内返回测试结果)。

趋势3:自适应测试(Adaptive Testing)

AI会根据历史测试结果动态调整生成策略:如果某个模块过去常出错,AI会生成更多针对该模块的用例;如果某个功能从未出错,AI会减少用例数量(类似”精准打击”)。

挑战1:生成用例的准确性

AI可能生成”无效用例”(例如:输入”邮箱@com”,虽然包含@但格式错误,但AI可能误判为有效),需要人工或规则校验补充。

挑战2:隐私与安全

生成用例可能包含敏感数据(如用户手机号),需要加密处理或用匿名数据训练模型。

挑战3:成本与门槛

使用大语言模型(如GPT-4)生成用例需要API调用费用,中小企业可能面临成本压力;同时,需要测试工程师具备一定的AI知识(如提示词工程)。

总结:学到了什么?

核心概念回顾

测试用例:软件的”考试题”,包含输入、步骤、预期结果;

自动化测试:测试用例的”自动判卷机”,用程序代替人工执行;

AI生成测试用例:测试用例的”智能出题老师”,通过分析代码、需求、历史缺陷,生成高覆盖率的用例。

概念关系回顾

三者形成”智能出题→自动考试→高效判卷”的闭环:AI优化了”出题”环节,让测试用例更全面;自动化测试加速了”考试”环节,让验证更高效;最终共同提升软件质量。

思考题:动动小脑筋

假设你要测试一个”外卖下单”功能(包含选餐、支付、配送状态更新),你会让AI生成哪些类型的测试用例?(提示:考虑边界条件、异常场景)

AI生成的测试用例可能存在哪些缺陷?如何验证它们的有效性?(提示:结合覆盖率工具、人工抽查)

如果你的团队要引入AI生成测试用例,需要做哪些准备?(提示:数据准备、工具选型、人员培训)

附录:常见问题与解答

Q1:AI生成的测试用例能完全替代人工吗?

A:目前不能。AI擅长生成覆盖广、逻辑复杂的用例,但人工测试在”用户体验测试”“探索性测试”(随机尝试新操作)中仍不可替代。建议采用”AI生成基础用例+人工补充复杂用例”的混合模式。

Q2:AI生成用例的成本高吗?

A:取决于工具选择。使用开源工具(如Atheris)成本较低;使用商业工具(如Testim)需订阅费用,但能节省人工编写用例的时间(人工编写100个用例需2天,AI生成仅需几小时)。

Q3:如何评估AI生成用例的质量?

A:主要看两个指标:

覆盖率(用Coverage.py等工具验证);

缺陷发现率(统计用例执行后发现的新缺陷数量)。

扩展阅读 & 参考资料

论文:《Automated Test Case Generation Using Machine Learning》(IEEE)

博客:《How AI is Transforming Software Testing》(Medium)

工具文档:OpenAI API官方文档、Testim用户手册

暂无评论内容