时隔4年重新回到技术岗位,让我身心倍感轻松很喜爱很享受

在看这个文章之前先看下这个表,看看自己显卡是否支持然后再看后续文章

查看本机显卡参数

我的就是2020年买的笔记本,还是2060的卡基本计算能力在7.5左右所以还是可以再站几年的

输入命令 nvidia-smi

第一步 安装cuda toolkit 点击此链接打开网站

下载相关文件,请记住流程安装选local而非network 具体请问网上更多大模型会描述的很清楚为什么选local

安装完后验证是否安装成功

打开cmd 输入 nvcc –version 显示版本号表明下载成功

到此安装部分全部结束,再次使用cmd命令查看 nvidia-smi 就会发现cuda version也做了更改

设置ollama 环境变量

到这里还没有安装ollama,去自行安装ollama傻瓜式安装即可

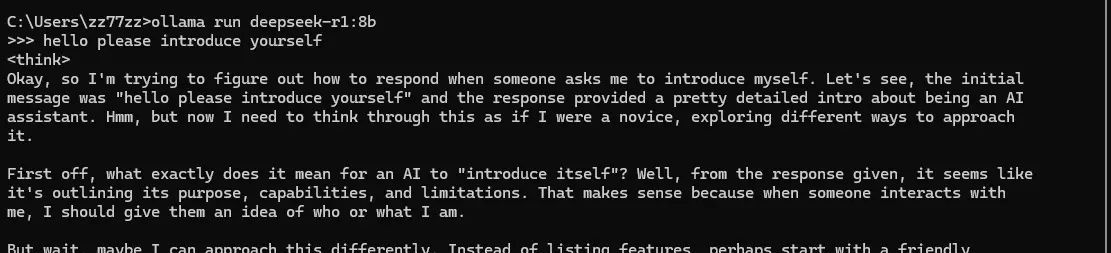

目前就可以设置ollama使用deepseek r1模型跑在gpu上了,就不会出现ppt一样回答问题的情况了

昨天我跑了一次,同一个问题 gpu运行时间11s,cpu运行时间3分钟

第一步打开系统变量,无法新增编辑就已管理员身份运行即可

- 添加以下环境变量:

- 变量名:OLLAMA_GPU_LAYER

- 变量值:cuda

- 指定特定的 GPU,可以添加以下环境变量:

- 变量名:CUDA_VISIBLE_DEVICES

-

变量值:GPU的UUID(按编号有时找不到,所以使用UUID,下文提到了本机gpu查UUID的命令)

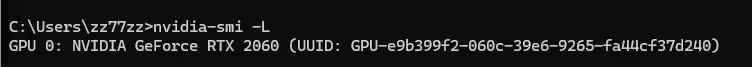

GPU的UUID查看方法 继续用命令行输入 nvidia-smi -L

所以我的UUID是GPU-e9b399f2-060c-39e6-9265-fa44cf37d240

把你的UUID输入进去

验证是否使用gpu

- 先运行你的大模型(我用的是deepseek r1:8b)

- 然后再起一个命令行 输入 ollama ps 就可以看到 processor里面有cpu与gpu运行百分比

后续 可以查看日志文件查看大模型的运行情况

- 打开ollama的server.log 将内容粘贴近大模型直接会帮你总结

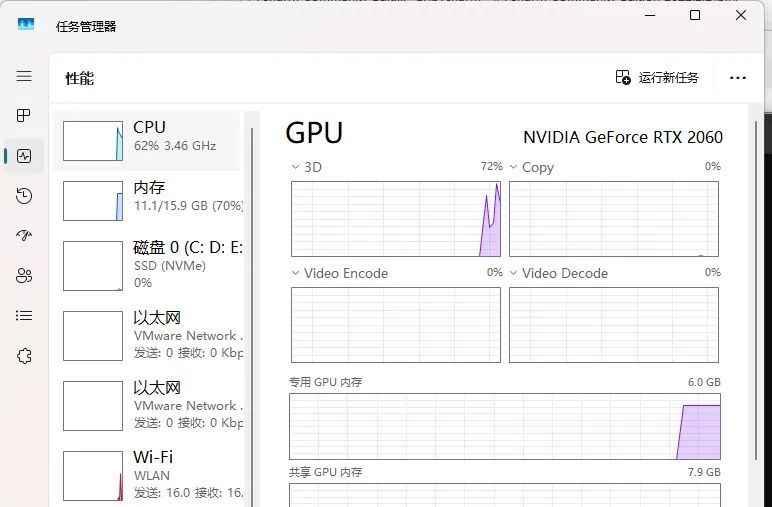

- 观察的内容里体现了 ollama在cpu还是gpu上运行,当时花费了我将近4G的CPU 所以很卡(虽然我是16G内存这周末就去扩内存)

- 最后打开任务管理器查看你的性能 GPU CPU使用率 就可以直观的感受到GPU运算跟CPU运算的差别。到这一步算是彻底结束了

- 最后感谢所有GitHub的大佬提供的各种解决方法 我也只是拿来测试了一下没想到真的可行

- 想学习的小伙伴请擦亮双眼 卖课的卖课件的人比较多 鱼龙混杂 我们得有辨别的能力,推荐上github上搜索真正有用的信息 不然天天处理垃圾信息太浪费时间

© 版权声明

文章版权归作者所有,未经允许请勿转载。如内容涉嫌侵权,请在本页底部进入<联系我们>进行举报投诉!

THE END

暂无评论内容