大数据领域数据工程的安全漏洞检测

关键词:大数据安全、数据工程、漏洞检测、安全审计、数据隐私、访问控制、加密技术

摘要:本文深入探讨大数据领域数据工程中的安全漏洞检测问题。我们将从大数据安全的基本概念出发,分析数据工程中常见的安全漏洞类型,介绍先进的检测方法和工具,并通过实际案例展示如何实施有效的安全审计。文章还将探讨大数据环境下的特殊安全挑战,以及应对这些挑战的最佳实践和未来发展趋势。

1. 背景介绍

1.1 目的和范围

随着大数据技术的广泛应用,数据工程已成为企业数字化转型的核心。然而,大规模数据处理的复杂性也带来了前所未有的安全挑战。本文旨在全面分析大数据环境下的安全漏洞检测方法,为数据工程师和安全专家提供实用的技术指导和解决方案。

1.2 预期读者

本文适合以下读者:

大数据工程师和数据架构师

信息安全专家和网络安全分析师

数据隐私合规专员

技术决策者和CTO

对大数据安全感兴趣的研究人员和学生

1.3 文档结构概述

本文将首先介绍大数据安全的基本概念,然后深入分析常见漏洞类型。接着探讨检测方法和工具,并通过实际案例展示应用。最后讨论未来趋势和挑战。

1.4 术语表

1.4.1 核心术语定义

数据工程:设计、构建和维护数据处理系统的工程实践

安全漏洞:系统中可能被利用来违反安全策略的弱点

漏洞检测:识别系统中潜在安全问题的过程

1.4.2 相关概念解释

数据脱敏:对敏感数据进行处理以保护隐私的技术

最小权限原则:用户只能访问完成工作所需的最小数据权限

纵深防御:多层安全防护策略

1.4.3 缩略词列表

IAM:Identity and Access Management (身份和访问管理)

DLP:Data Loss Prevention (数据丢失防护)

SIEM:Security Information and Event Management (安全信息和事件管理)

2. 核心概念与联系

大数据安全是一个多维度的挑战,涉及数据生命周期各个阶段的安全保障。以下是核心概念的关系图:

大数据安全漏洞检测的主要已关注点包括:

配置错误:不安全的默认配置或人为错误配置

认证缺陷:弱认证机制或凭证管理不当

授权问题:过度授权或权限提升漏洞

数据泄露:敏感数据暴露或不当传输

注入漏洞:代码注入或查询注入攻击面

日志不足:缺乏足够的审计跟踪能力

3. 核心算法原理 & 具体操作步骤

3.1 静态代码分析算法

静态代码分析是检测大数据处理代码中潜在安全漏洞的重要方法。以下是基于抽象语法树(AST)的分析算法:

import ast

from collections import defaultdict

class SecurityAnalyzer(ast.NodeVisitor):

def __init__(self):

self.vulnerabilities = defaultdict(list)

self.sensitive_sinks = {

'execute': 'SQL Injection',

'eval': 'Code Injection',

'open': 'File Access',

'pickle.loads': 'Deserialization'

}

def visit_Call(self, node):

# 检查函数调用是否存在敏感操作

if isinstance(node.func, ast.Name):

func_name = node.func.id

if func_name in self.sensitive_sinks:

self.report_vulnerability(

node.lineno,

self.sensitive_sinks[func_name],

f"Potential {

self.sensitive_sinks[func_name]} vulnerability"

)

self.generic_visit(node)

def visit_Assign(self, node):

# 检查敏感数据赋值

if isinstance(node.targets[0], ast.Name):

var_name = node.targets[0].id

if var_name.lower() in ['password', 'secret', 'key']:

if not self.is_properly_secured(node.value):

self.report_vulnerability(

node.lineno,

'Sensitive Data Exposure',

f"Potential sensitive data exposure in variable '{

var_name}'"

)

self.generic_visit(node)

def is_properly_secured(self, node):

# 简化示例:检查是否有加密或哈希操作

if isinstance(node, ast.Call):

if isinstance(node.func, ast.Name):

return node.func.id.lower() in ['encrypt', 'hash']

return False

def report_vulnerability(self, lineno, vuln_type, message):

self.vulnerabilities[lineno].append({

'type': vuln_type,

'message': message

})

def analyze_code(code):

tree = ast.parse(code)

analyzer = SecurityAnalyzer()

analyzer.visit(tree)

return analyzer.vulnerabilities

# 示例用法

code_sample = """

def process_data(user_input):

query = "SELECT * FROM users WHERE id = " + user_input

cursor.execute(query)

password = 'admin123'

"""

vulns = analyze_code(code_sample)

for line, issues in vulns.items():

for issue in issues:

print(f"Line {

line}: {

issue['type']} - {

issue['message']}")

3.2 动态数据流追踪算法

动态数据流追踪可以检测运行时数据流中的安全问题:

import sys

import inspect

class DataFlowTracker:

def __init__(self):

self.sensitive_sources = ['get_user_input', 'read_database', 'load_config']

self.sensitive_sinks = ['write_database', 'send_network', 'log_message']

self.tainted_data = set()

def trace_call(self, frame, event, arg):

if event != 'call':

return

func_name = frame.f_code.co_name

args = inspect.getargvalues(frame)

# 检查敏感源

if func_name in self.sensitive_sources:

return_value = arg

if return_value and isinstance(return_value, str):

self.tainted_data.add(id(return_value))

print(f"Tainted data from {

func_name}: {

return_value}")

# 检查敏感汇

if func_name in self.sensitive_sinks:

for arg_name, arg_value in args.locals.items():

if id(arg_value) in self.tainted_data:

print(f"WARNING: Tainted data passed to {

func_name} in argument {

arg_name}")

return self.trace_call

# 示例用法

def demo_usage():

tracker = DataFlowTracker()

sys.settrace(tracker.trace_call)

def get_user_input():

return "admin' OR '1'='1"

def write_database(query):

print(f"Executing query: {

query}")

user_input = get_user_input()

write_database(user_input)

sys.settrace(None)

demo_usage()

4. 数学模型和公式 & 详细讲解 & 举例说明

4.1 访问控制矩阵模型

访问控制可以用矩阵模型表示:

A C M = [ f 1 f 2 ⋯ f n u 1 p 11 p 12 ⋯ p 1 n u 2 p 21 p 22 ⋯ p 2 n ⋮ ⋮ ⋮ ⋱ ⋮ u m p m 1 p m 2 ⋯ p m n ] ACM = egin{bmatrix} & f_1 & f_2 & cdots & f_n \ u_1 & p_{11} & p_{12} & cdots & p_{1n} \ u_2 & p_{21} & p_{22} & cdots & p_{2n} \ vdots & vdots & vdots & ddots & vdots \ u_m & p_{m1} & p_{m2} & cdots & p_{mn} \ end{bmatrix} ACM=

u1u2⋮umf1p11p21⋮pm1f2p12p22⋮pm2⋯⋯⋯⋱⋯fnp1np2n⋮pmn

其中:

u i u_i ui 表示用户或角色

f j f_j fj 表示数据文件或资源

p i j p_{ij} pij 表示权限,可以是:

0 0 0: 无权限

1 1 1: 读权限

2 2 2: 写权限

3 3 3: 执行权限

4 4 4: 完全控制

4.2 信息熵与数据敏感性评估

数据敏感性可以通过信息熵来量化:

H ( X ) = − ∑ i = 1 n P ( x i ) log b P ( x i ) H(X) = -sum_{i=1}^{n} P(x_i) log_b P(x_i) H(X)=−i=1∑nP(xi)logbP(xi)

其中:

X X X 是数据字段

x i x_i xi 是字段的可能取值

P ( x i ) P(x_i) P(xi) 是取值概率

对于敏感数据检测,我们可以计算字段值的熵值,高熵值可能指示敏感信息:

import math

from collections import Counter

def calculate_entropy(data):

if not data:

return 0

counter = Counter(data)

length = len(data)

entropy = 0.0

for count in counter.values():

p = count / length

entropy -= p * math.log(p, 2)

return entropy

# 示例

normal_data = ['user1', 'user2', 'user3', 'user1', 'user2']

sensitive_data = ['password123', 'admin', 'secretKey', '123456', 'qwerty']

print(f"Normal data entropy: {

calculate_entropy(normal_data):.2f}")

print(f"Sensitive data entropy: {

calculate_entropy(sensitive_data):.2f}")

4.3 异常检测的统计模型

使用Z-score检测异常访问模式:

z = x − μ σ z = frac{x – mu}{sigma} z=σx−μ

其中:

x x x 是当前观测值

μ mu μ 是历史均值

σ sigma σ 是历史标准差

实现示例:

import numpy as np

class AccessPatternMonitor:

def __init__(self, window_size=100):

self.window_size = window_size

self.access_counts = []

def add_access(self, count):

self.access_counts.append(count)

if len(self.access_counts) > self.window_size:

self.access_counts.pop(0)

def detect_anomaly(self, current_count):

if len(self.access_counts) < 10: # 最少需要10个样本

return False

mean = np.mean(self.access_counts)

std = np.std(self.access_counts)

if std == 0:

return current_count != mean

z_score = (current_count - mean) / std

return abs(z_score) > 3 # 3σ阈值

# 示例用法

monitor = AccessPatternMonitor()

for _ in range(100):

monitor.add_access(np.random.poisson(10)) # 正常访问模式

print(monitor.detect_anomaly(10)) # 正常

print(monitor.detect_anomaly(30)) # 异常

5. 项目实战:代码实际案例和详细解释说明

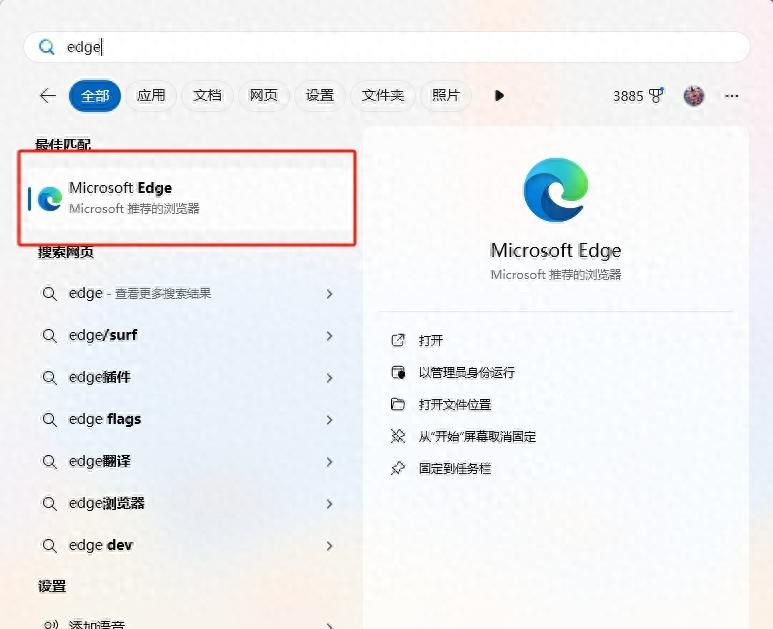

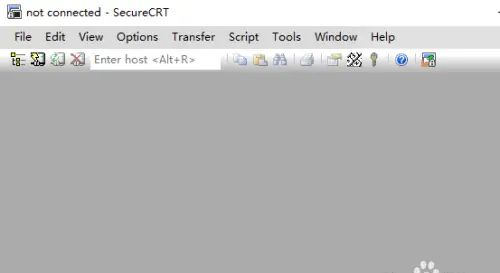

5.1 开发环境搭建

大数据安全检测平台环境

基础设施:

Hadoop 3.x 集群

Spark 3.x 用于分布式处理

Elasticsearch 用于日志存储和分析

Kibana 用于可视化

安全工具集成:

Apache Ranger 用于访问控制

Apache Atlas 用于数据血缘追踪

OpenSCAP 用于配置合规检查

开发环境:

# 使用Docker快速搭建测试环境

docker pull sequenceiq/hadoop-docker:2.7.1

docker pull docker.elastic.co/elasticsearch/elasticsearch:7.9.0

docker pull docker.elastic.co/kibana/kibana:7.9.0

5.2 源代码详细实现和代码解读

大数据配置审计工具实现

import xml.etree.ElementTree as ET

import json

import difflib

from pathlib import Path

class HadoopConfigAuditor:

def __init__(self, baseline_file='baseline.json'):

self.baseline = self.load_baseline(baseline_file)

self.important_props = [

'hadoop.security.authentication',

'hadoop.security.authorization',

'dfs.namenode.acls.enabled',

'dfs.permissions.enabled'

]

def load_baseline(self, filename):

try:

with open(filename) as f:

return json.load(f)

except FileNotFoundError:

return {

}

def audit_config(self, config_path):

findings = []

# 解析XML配置文件

try:

tree = ET.parse(config_path)

root = tree.getroot()

# 检查重要属性

for prop in root.findall('property'):

name = prop.find('name').text

value = prop.find('value').text

if name in self.important_props:

baseline_value = self.baseline.get(name, '')

if value != baseline_value:

findings.append({

'property': name,

'current_value': value,

'baseline_value': baseline_value,

'severity': 'high' if 'security' in name else 'medium'

})

except ET.ParseError:

findings.append({

'error': f"Invalid XML format in {

config_path}"

})

return findings

def generate_diff_report(self, old_config, new_config):

"""生成配置变更差异报告"""

with open(old_config) as f:

old_lines = f.readlines()

with open(new_config) as f:

new_lines = f.readlines()

diff = difflib.unified_diff(

old_lines, new_lines,

fromfile=old_config,

tofile=new_config,

lineterm=''

)

return '

'.join(diff)

# 示例用法

if __name__ == "__main__":

auditor = HadoopConfigAuditor()

# 模拟核心配置文件路径

core_site = 'core-site.xml'

hdfs_site = 'hdfs-site.xml'

# 执行审计

print("Auditing core-site.xml:")

for finding in auditor.audit_config(core_site):

print(json.dumps(finding, indent=2))

print("

Auditing hdfs-site.xml:")

for finding in auditor.audit_config(hdfs_site):

print(json.dumps(finding, indent=2))

# 生成差异报告

print("

Configuration diff:")

print(auditor.generate_diff_report('core-site-old.xml', 'core-site-new.xml'))

5.3 代码解读与分析

配置审计核心逻辑:

使用XML解析器读取Hadoop配置文件(core-site.xml, hdfs-site.xml等)

对比当前配置与安全基线配置

识别关键安全属性的不一致

差异检测功能:

使用difflib生成可读的配置变更差异

帮助追踪配置变更历史和安全影响

扩展性设计:

支持自定义安全基线文件

可灵活添加新的重要属性检查

模块化设计便于集成到CI/CD流程

安全考虑:

配置文件解析时进行错误处理

敏感属性特别标记和高亮显示

支持多种输出格式(JSON, 文本差异)

6. 实际应用场景

6.1 金融行业数据仓库安全审计

挑战:

高度敏感的客户财务数据

严格的合规要求(GDPR, PCI-DSS)

复杂的数据流转路径

解决方案:

实施端到端数据血缘追踪

自动化敏感数据发现和分类

细粒度的访问控制策略

实时异常检测系统

技术架构:

6.2 医疗健康大数据平台

特殊需求:

HIPAA合规要求

患者隐私数据保护

研究数据共享与安全的平衡

关键技术:

差异化隐私保护技术

基于属性的加密(ABE)

安全多方计算

去标识化与k-匿名算法

6.3 电子商务用户行为分析

安全考量:

用户行为数据价值与隐私的平衡

防止数据滥用和二次销售

保护商业敏感分析模型

实施策略:

数据最小化原则

数据使用契约和策略

模型逆向工程防护

数据访问水印技术

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

《大数据安全: 技术与实践》- 王晓峰

《Data Privacy: Principles and Practice》- George Danezis

《Hadoop Security》- Ben Spivey, Joey Echeverria

7.1.2 在线课程

Coursera: “Big Data Security” – University of California

edX: “Cybersecurity for Big Data Systems” – MIT

Udemy: “Apache Ranger for Hadoop Security”

7.1.3 技术博客和网站

Cloudera Security Blog

Apache Security Advisories

OWASP Big Data Security Project

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

IntelliJ IDEA with Big Data Tools插件

VS Code with Data Science扩展

Jupyter Notebook for数据分析

7.2.2 调试和性能分析工具

Apache Knox Gateway

HashiCorp Vault

Wireshark for network analysis

7.2.3 相关框架和库

Apache Ranger (访问控制)

Apache Atlas (元数据管理)

OpenSCAP (配置合规)

Presto SQL (安全查询)

7.3 相关论文著作推荐

7.3.1 经典论文

“Security in Big Data: A Survey” – 2017

“A Taxonomy of Vulnerabilities in Big Data Systems” – 2018

7.3.2 最新研究成果

“Federated Learning for Privacy-Preserving Big Data Analytics” – 2022

“Zero Trust Architecture for Data Lakes” – 2023

7.3.3 应用案例分析

“GDPR Compliance in Hadoop Ecosystem” – Case Study

“Securing Healthcare Data Lakes” – Implementation Report

8. 总结:未来发展趋势与挑战

8.1 发展趋势

隐私增强技术(PETs)的普及:

同态加密

安全多方计算

联邦学习

AI驱动的安全分析:

异常检测模型

预测性漏洞管理

自动化修复建议

零信任架构的扩展:

微隔离技术

持续认证

最小权限的精细化

8.2 持续挑战

性能与安全的权衡:

加密开销

审计日志存储

实时检测延迟

多云环境复杂性:

跨云数据流追踪

一致的安全策略

密钥管理

合规性碎片化:

不同地区的隐私法规

行业特定标准

不断变化的合规要求

8.3 技术演进路线

9. 附录:常见问题与解答

Q1: 如何平衡大数据分析的开放性和安全性?

A: 建议采用”数据网格”(Data Mesh)架构,将数据作为产品管理,每个数据产品有明确的所有者和使用策略。结合数据契约(Data Contracts)和细粒度访问控制,可以在保持数据流动性的同时确保安全。

Q2: 处理PB级数据时如何实施有效的安全检测?

A: 采用分层检测策略:

元数据层:快速扫描配置和权限设置

采样分析:对大数据集进行统计采样检测

分布式处理:利用Spark等框架并行化检测任务

增量检测:只对新数据或变更部分进行深度扫描

Q3: 如何证明我们的数据工程符合GDPR要求?

A: 需要建立完整的合规证据链:

数据血缘和流转文档

访问控制策略和日志

数据主体权利处理流程

数据保护影响评估报告

第三方处理者的合规证明

10. 扩展阅读 & 参考资料

NIST Big Data Interoperability Framework

ISO/IEC 27017:2015 云计算安全指南

Cloud Security Alliance Big Data Working Group 研究报告

Apache 软件基金会安全公告

欧盟数据保护委员会(EDPB)大数据处理指南

通过本文的系统性探讨,我们全面了解了大数

暂无评论内容