Stable Diffusion生成壁纸:个性化手机/电脑背景

关键词:Stable Diffusion、壁纸生成、个性化、手机背景、电脑背景

摘要:本文围绕Stable Diffusion技术展开,深入探讨了如何利用其生成个性化的手机和电脑壁纸。详细介绍了Stable Diffusion的核心概念、算法原理,结合数学模型进行了原理剖析。通过项目实战,给出了完整的开发环境搭建、代码实现及解读。同时,阐述了该技术在壁纸生成领域的实际应用场景,推荐了相关的学习资源、开发工具和论文著作。最后,对Stable Diffusion在壁纸生成方面的未来发展趋势与挑战进行了总结,并提供了常见问题解答和扩展阅读参考资料。

1. 背景介绍

1.1 目的和范围

在当今数字化时代,人们对于个性化的追求愈发强烈,手机和电脑作为日常使用频率极高的设备,其壁纸的个性化需求也日益增长。Stable Diffusion作为一种强大的图像生成模型,为满足这一需求提供了绝佳的解决方案。本文的目的在于详细介绍如何使用Stable Diffusion技术生成个性化的手机和电脑壁纸,涵盖从基础概念到实际操作的全过程,包括核心原理的讲解、代码实现的演示以及实际应用场景的探讨。

1.2 预期读者

本文预期读者包括对图像生成技术感兴趣的初学者、希望通过代码实现个性化壁纸生成的程序员、从事设计工作并想借助AI技术拓展创意的设计师,以及对Stable Diffusion技术有进一步研究需求的科研人员。

1.3 文档结构概述

本文将按照以下结构展开:首先介绍Stable Diffusion的核心概念和相关联系,包括其原理和架构;接着深入讲解核心算法原理,并给出具体的操作步骤,结合Python源代码进行详细阐述;然后介绍相关的数学模型和公式,并通过举例进行说明;之后进行项目实战,包括开发环境的搭建、源代码的实现和解读;再探讨Stable Diffusion在壁纸生成方面的实际应用场景;推荐相关的学习资源、开发工具和论文著作;最后总结未来发展趋势与挑战,提供常见问题解答和扩展阅读参考资料。

1.4 术语表

1.4.1 核心术语定义

Stable Diffusion:一种基于潜在扩散模型(Latent Diffusion Model)的文本到图像生成模型,能够根据输入的文本描述生成高质量的图像。

潜在扩散模型(Latent Diffusion Model):一种在低维潜在空间中进行扩散过程的模型,通过学习数据的潜在表示来生成图像,能够在计算资源和生成质量之间取得较好的平衡。

文本嵌入(Text Embedding):将文本信息转换为向量表示的过程,以便模型能够理解和处理文本信息。

去噪过程(Denoising Process):在扩散模型中,通过逐步去除图像中的噪声来生成清晰图像的过程。

1.4.2 相关概念解释

扩散模型(Diffusion Model):一种生成模型,通过在数据上逐步添加噪声,然后学习如何从噪声中恢复原始数据。在图像生成中,扩散模型从随机噪声开始,逐步生成清晰的图像。

生成对抗网络(GAN):另一种常见的图像生成模型,由生成器和判别器组成,通过对抗训练的方式生成图像。与扩散模型不同,GAN的训练过程相对不稳定,但生成速度较快。

1.4.3 缩略词列表

SD:Stable Diffusion

LDM:Latent Diffusion Model

CLIP:Contrastive Language-Image Pretraining

2. 核心概念与联系

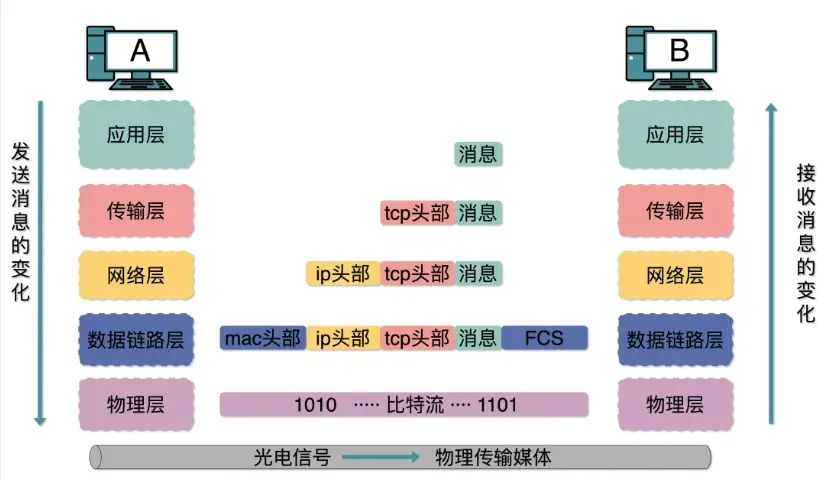

2.1 Stable Diffusion的原理

Stable Diffusion基于潜在扩散模型,其核心思想是在低维潜在空间中进行扩散过程,而不是直接在高维图像空间中进行。这样可以大大减少计算量,提高生成效率。具体来说,Stable Diffusion包括以下几个主要步骤:

文本编码:将输入的文本描述通过文本编码器转换为文本嵌入向量。常用的文本编码器是基于CLIP模型,它能够将文本信息转换为与图像特征空间兼容的向量表示。

潜在空间采样:从随机噪声开始,在潜在空间中进行采样。潜在空间是一个低维的向量空间,通过对潜在空间的操作可以生成不同风格和内容的图像。

去噪过程:利用扩散模型的去噪网络,逐步去除潜在空间中的噪声,同时结合文本嵌入向量的指导,生成与文本描述相符的潜在表示。

解码器解码:将生成的潜在表示通过解码器转换为最终的图像。

2.2 架构示意图

2.3 核心概念之间的联系

文本描述通过文本编码器转换为文本嵌入向量,为去噪过程提供语义信息。随机噪声在潜在空间中进行采样,作为去噪过程的起点。去噪网络结合文本嵌入向量和含噪潜在表示,逐步去除噪声,生成符合文本描述的潜在表示。最后,解码器将潜在表示转换为最终的图像。整个过程中,各个核心概念相互协作,共同实现了从文本到图像的生成。

3. 核心算法原理 & 具体操作步骤

3.1 核心算法原理

Stable Diffusion的核心算法基于潜在扩散模型,其核心是去噪过程。去噪过程可以看作是一个反向的扩散过程,通过逐步去除图像中的噪声来生成清晰的图像。具体来说,去噪过程可以用以下公式表示:

x t − 1 = 1 α t ( x t − 1 − α t 1 − α ˉ t ϵ θ ( x t , t , c ) ) + 1 − α ~ t z mathbf{x}_{t-1} = frac{1}{sqrt{alpha_t}} (mathbf{x}_t – frac{1 – alpha_t}{sqrt{1 – ar{alpha}_t}} epsilon_{ heta}(mathbf{x}_t, t, mathbf{c})) + sqrt{1 – ilde{alpha}_t} mathbf{z} xt−1=αt

1(xt−1−αˉt

1−αtϵθ(xt,t,c))+1−α~t

z

其中, x t mathbf{x}_t xt 是第 t t t 步的含噪潜在表示, α t alpha_t αt 是第 t t t 步的扩散系数, α ˉ t = ∏ i = 1 t α i ar{alpha}_t = prod_{i=1}^t alpha_i αˉt=∏i=1tαi, ϵ θ ( x t , t , c ) epsilon_{ heta}(mathbf{x}_t, t, mathbf{c}) ϵθ(xt,t,c) 是去噪网络 θ heta θ 在输入 x t mathbf{x}_t xt、时间步 t t t 和文本嵌入向量 c mathbf{c} c 下的输出, z mathbf{z} z 是随机噪声, α ~ t = 1 − α ˉ t − 1 1 − α ˉ t α t ilde{alpha}_t = frac{1 – ar{alpha}_{t-1}}{1 – ar{alpha}_t} alpha_t α~t=1−αˉt1−αˉt−1αt。

3.2 具体操作步骤

以下是使用Python和Diffusers库实现Stable Diffusion生成壁纸的具体操作步骤:

# 步骤1:安装必要的库

!pip install diffusers transformers accelerate ftfy

# 步骤2:导入必要的库

import torch

from diffusers import StableDiffusionPipeline

# 步骤3:加载Stable Diffusion模型

model_id = "runwayml/stable-diffusion-v1-5"

device = "cuda" if torch.cuda.is_available() else "cpu"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to(device)

# 步骤4:定义文本描述

prompt = "A beautiful landscape with a mountain and a lake, in the style of oil painting"

# 步骤5:生成图像

image = pipe(prompt).images[0]

# 步骤6:保存图像

image.save("wallpaper.png")

3.3 代码解释

安装必要的库:使用 pip 安装 diffusers、transformers、accelerate 和 ftfy 库,这些库是使用Stable Diffusion模型所必需的。

导入必要的库:导入 torch 和 StableDiffusionPipeline 库,用于加载和运行Stable Diffusion模型。

加载Stable Diffusion模型:使用 StableDiffusionPipeline.from_pretrained 方法加载预训练的Stable Diffusion模型,并将其移动到GPU(如果可用)上。

定义文本描述:定义一个文本描述,用于指导图像的生成。

生成图像:使用 pipe(prompt) 方法生成图像,并通过 images[0] 获取生成的图像。

保存图像:使用 image.save 方法将生成的图像保存为 wallpaper.png 文件。

4. 数学模型和公式 & 详细讲解 & 举例说明

4.1 扩散过程的数学模型

扩散过程可以看作是一个马尔可夫链,通过逐步添加噪声将原始数据转换为噪声数据。具体来说,扩散过程可以用以下公式表示:

x t = α ˉ t x 0 + 1 − α ˉ t z t mathbf{x}_t = sqrt{ar{alpha}_t} mathbf{x}_0 + sqrt{1 – ar{alpha}_t} mathbf{z}_t xt=αˉt

x0+1−αˉt

zt

其中, x 0 mathbf{x}_0 x0 是原始图像, x t mathbf{x}_t xt 是第 t t t 步的含噪图像, α ˉ t = ∏ i = 1 t α i ar{alpha}_t = prod_{i=1}^t alpha_i αˉt=∏i=1tαi, α i alpha_i αi 是第 i i i 步的扩散系数, z t mathbf{z}_t zt 是高斯噪声。

4.2 去噪过程的数学模型

去噪过程是扩散过程的反向过程,通过逐步去除图像中的噪声来生成原始图像。具体来说,去噪过程可以用以下公式表示:

x t − 1 = 1 α t ( x t − 1 − α t 1 − α ˉ t ϵ θ ( x t , t , c ) ) + 1 − α ~ t z mathbf{x}_{t-1} = frac{1}{sqrt{alpha_t}} (mathbf{x}_t – frac{1 – alpha_t}{sqrt{1 – ar{alpha}_t}} epsilon_{ heta}(mathbf{x}_t, t, mathbf{c})) + sqrt{1 – ilde{alpha}_t} mathbf{z} xt−1=αt

1(xt−1−αˉt

1−αtϵθ(xt,t,c))+1−α~t

z

其中, ϵ θ ( x t , t , c ) epsilon_{ heta}(mathbf{x}_t, t, mathbf{c}) ϵθ(xt,t,c) 是去噪网络 θ heta θ 在输入 x t mathbf{x}_t xt、时间步 t t t 和文本嵌入向量 c mathbf{c} c 下的输出, α ~ t = 1 − α ˉ t − 1 1 − α ˉ t α t ilde{alpha}_t = frac{1 – ar{alpha}_{t-1}}{1 – ar{alpha}_t} alpha_t α~t=1−αˉt1−αˉt−1αt。

4.3 详细讲解

扩散过程的目的是将原始图像转换为噪声数据,以便模型能够学习数据的分布。去噪过程则是从噪声数据中恢复原始图像,通过逐步去除噪声来生成清晰的图像。在去噪过程中,去噪网络 ϵ θ epsilon_{ heta} ϵθ 学习预测噪声,然后根据预测的噪声来更新含噪图像。

4.4 举例说明

假设我们有一个原始图像 x 0 mathbf{x}_0 x0,我们希望通过扩散过程将其转换为噪声数据。我们可以设置扩散系数 α i alpha_i αi,并根据扩散过程的公式逐步添加噪声,得到含噪图像 x t mathbf{x}_t xt。然后,我们可以使用去噪过程的公式,从含噪图像 x t mathbf{x}_t xt 中恢复原始图像 x 0 mathbf{x}_0 x0。

例如,假设我们设置扩散步数 T = 1000 T = 1000 T=1000,扩散系数 α i = 0.999 alpha_i = 0.999 αi=0.999。我们可以使用以下代码实现扩散过程和去噪过程:

import torch

import numpy as np

# 定义扩散系数

T = 1000

alpha = 0.999

alphas = torch.tensor([alpha] * T)

alphas_bar = torch.cumprod(alphas, dim=0)

# 生成原始图像

x0 = torch.randn(1, 3, 64, 64)

# 扩散过程

t = 500

z = torch.randn_like(x0)

xt = torch.sqrt(alphas_bar[t]) * x0 + torch.sqrt(1 - alphas_bar[t]) * z

# 去噪过程

# 假设我们已经训练好了去噪网络 epsilon_theta

epsilon_theta = torch.randn_like(xt)

alpha_t = alphas[t]

alpha_bar_t = alphas_bar[t]

alpha_bar_t_prev = alphas_bar[t-1] if t > 0 else 1

tilde_alpha_t = (1 - alpha_bar_t_prev) / (1 - alpha_bar_t) * alpha_t

z = torch.randn_like(xt)

x_t_minus_1 = (1 / torch.sqrt(alpha_t)) * (xt - ((1 - alpha_t) / torch.sqrt(1 - alpha_bar_t)) * epsilon_theta) + torch.sqrt(1 - tilde_alpha_t) * z

print("原始图像形状:", x0.shape)

print("含噪图像形状:", xt.shape)

print("去噪后图像形状:", x_t_minus_1.shape)

在上述代码中,我们首先定义了扩散系数 α alpha α 和扩散步数 T T T,然后生成了一个随机的原始图像 x 0 mathbf{x}_0 x0。接着,我们进行了扩散过程,得到了含噪图像 x t mathbf{x}_t xt。最后,我们进行了去噪过程,得到了去噪后的图像 x t − 1 mathbf{x}_{t-1} xt−1。

5. 项目实战:代码实际案例和详细解释说明

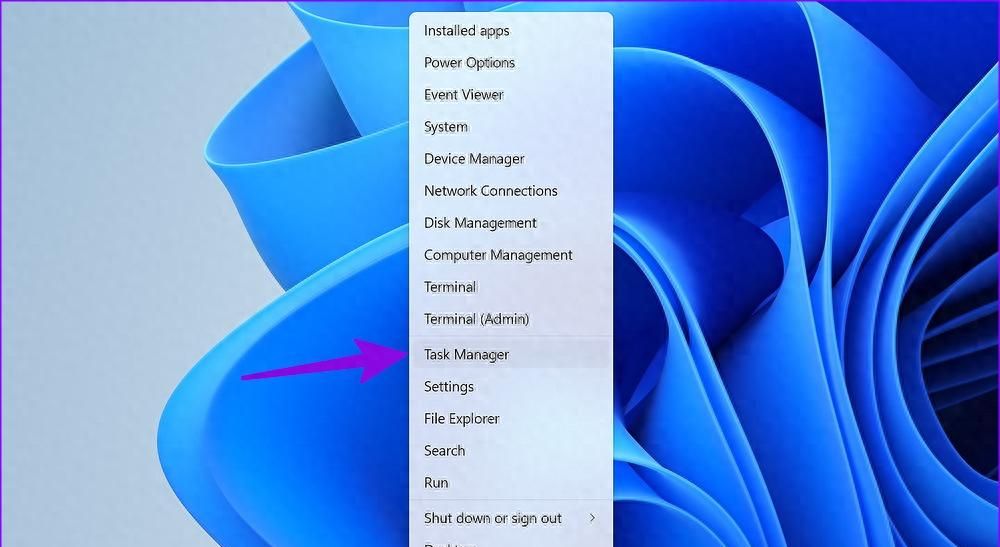

5.1 开发环境搭建

5.1.1 操作系统

推荐使用Linux或Windows操作系统,其中Linux系统在深度学习开发中更为常用,因为其具有更好的开源软件支持和稳定性。

5.1.2 Python环境

安装Python 3.7及以上版本,可以使用Anaconda或Miniconda来管理Python环境。以下是创建一个新的Python环境的示例命令:

conda create -n stable_diffusion python=3.8

conda activate stable_diffusion

5.1.3 安装必要的库

在激活的Python环境中,安装以下必要的库:

pip install diffusers transformers accelerate ftfy

5.1.4 GPU支持(可选)

如果你的计算机具有NVIDIA GPU,建议安装CUDA和cuDNN以加速模型的运行。安装完成后,确保PyTorch支持CUDA。

pip install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu113

5.2 源代码详细实现和代码解读

以下是一个完整的Python代码示例,用于生成个性化的手机壁纸:

import torch

from diffusers import StableDiffusionPipeline

import matplotlib.pyplot as plt

# 检查GPU是否可用

device = "cuda" if torch.cuda.is_available() else "cpu"

# 加载Stable Diffusion模型

model_id = "runwayml/stable-diffusion-v1-5"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to(device)

# 定义文本描述

prompt = "A cute cat sitting on a fluffy cloud, with a rainbow in the background, 8k resolution"

# 生成图像

image = pipe(prompt).images[0]

# 显示图像

plt.imshow(image)

plt.axis('off')

plt.show()

# 保存图像

image.save("phone_wallpaper.png")

5.2.1 代码解读

导入必要的库:导入 torch、StableDiffusionPipeline 和 matplotlib.pyplot 库,分别用于深度学习计算、加载Stable Diffusion模型和显示图像。

检查GPU是否可用:使用 torch.cuda.is_available() 检查GPU是否可用,并将设备设置为 cuda 或 cpu。

加载Stable Diffusion模型:使用 StableDiffusionPipeline.from_pretrained 方法加载预训练的Stable Diffusion模型,并将其移动到指定的设备上。

定义文本描述:定义一个文本描述,用于指导图像的生成。在这个例子中,我们希望生成一个可爱的猫坐在蓬松的云上,背景有彩虹的图像,并且要求图像具有8k分辨率。

生成图像:使用 pipe(prompt) 方法生成图像,并通过 images[0] 获取生成的图像。

显示图像:使用 matplotlib.pyplot 库显示生成的图像,并关闭坐标轴。

保存图像:使用 image.save 方法将生成的图像保存为 phone_wallpaper.png 文件。

5.3 代码解读与分析

5.3.1 文本描述的重要性

文本描述是Stable Diffusion生成图像的关键,它决定了生成图像的内容和风格。在编写文本描述时,应该尽可能详细和具体,包括图像的主题、场景、风格、颜色等信息。例如,在上述代码中,我们使用了 “A cute cat sitting on a fluffy cloud, with a rainbow in the background, 8k resolution” 这样的文本描述,明确了图像的主题(猫)、场景(坐在云上,背景有彩虹)、风格(可爱)和分辨率(8k)。

5.3.2 模型选择

在代码中,我们使用了 “runwayml/stable-diffusion-v1-5” 这个预训练模型。Stable Diffusion有多个版本的预训练模型可供选择,不同的模型在生成质量、风格和速度上可能会有所差异。在实际应用中,可以根据具体需求选择合适的模型。

5.3.3 内存管理

Stable Diffusion模型通常比较大,运行时需要占用大量的内存。在GPU内存有限的情况下,可以通过以下方法进行内存管理:

使用半精度浮点数:在加载模型时,使用 torch_dtype=torch.float16 将模型参数转换为半精度浮点数,这样可以减少内存占用。

释放不必要的变量:在代码中,及时释放不再使用的变量,避免内存泄漏。

6. 实际应用场景

6.1 个性化手机壁纸

用户可以根据自己的喜好和心情,使用Stable Diffusion生成个性化的手机壁纸。例如,用户可以输入 “A beautiful beach at sunset, with palm trees and a clear sky” 这样的文本描述,生成一张美丽的日落海滩壁纸。这种个性化的壁纸可以让用户的手机更加独特和个性化。

6.2 电脑桌面背景

在电脑上,用户也可以使用Stable Diffusion生成个性化的桌面背景。例如,用户可以输入 “A cyberpunk cityscape at night, with neon lights and flying cars” 这样的文本描述,生成一张充满未来感的赛博朋克城市夜景壁纸。这样的壁纸可以为用户的电脑桌面增添一份科技感和艺术感。

6.3 设计素材生成

设计师可以使用Stable Diffusion生成各种设计素材,如海报、宣传册、名片等。例如,设计师可以输入 “A minimalist logo for a coffee shop, with a coffee bean and a cup” 这样的文本描述,生成一个简约风格的咖啡店标志。这些生成的素材可以为设计师提供灵感,节省设计时间。

6.4 艺术创作

艺术家可以利用Stable Diffusion进行艺术创作,探索新的艺术风格和表现形式。例如,艺术家可以输入 “A surreal landscape inspired by Salvador Dali, with melting clocks and floating objects” 这样的文本描述,生成一幅具有超现实主义风格的艺术作品。这种结合AI技术的艺术创作方式可以为艺术家带来更多的创作可能性。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

《Deep Learning》:由Ian Goodfellow、Yoshua Bengio和Aaron Courville编写的深度学习经典教材,涵盖了深度学习的基本概念、算法和应用。

《Generative Adversarial Networks》:详细介绍了生成对抗网络(GAN)的原理和应用,对于理解图像生成技术有很大的帮助。

《Hands-On Machine Learning with Scikit-Learn, Keras, and TensorFlow》:一本实践导向的机器学习书籍,通过大量的代码示例介绍了机器学习和深度学习的应用。

7.1.2 在线课程

Coursera上的 “Deep Learning Specialization”:由Andrew Ng教授授课的深度学习专项课程,涵盖了深度学习的各个方面,包括神经网络、卷积神经网络、循环神经网络等。

Udemy上的 “Stable Diffusion Masterclass”:专门介绍Stable Diffusion技术的课程,包括模型原理、使用方法和实际应用案例。

Kaggle上的 “Image Generation with Stable Diffusion”:一个关于使用Stable Diffusion进行图像生成的实践项目,通过实际操作帮助学习者掌握Stable Diffusion的使用。

7.1.3 技术博客和网站

Hugging Face博客:提供了关于Stable Diffusion和其他深度学习模型的最新技术文章和研究成果。

Medium上的 “AI Generated Art”:一个专注于AI生成艺术的博客,分享了大量关于Stable Diffusion和其他图像生成技术的应用案例和创作经验。

Reddit上的 “r/StableDiffusion”:一个Stable Diffusion的社区,用户可以在这里交流使用经验、分享生成的图像和讨论技术问题。

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

PyCharm:一个功能强大的Python集成开发环境,提供了代码编辑、调试、版本控制等功能,适合开发Python项目。

Visual Studio Code:一个轻量级的代码编辑器,支持多种编程语言和插件扩展,对于快速开发和调试Stable Diffusion项目非常方便。

7.2.2 调试和性能分析工具

TensorBoard:一个用于可视化深度学习模型训练过程和性能指标的工具,可以帮助开发者监控模型的训练进度和性能。

NVIDIA Nsight Systems:一个用于GPU性能分析的工具,可以帮助开发者优化模型在GPU上的运行效率。

7.2.3 相关框架和库

Diffusers:Hugging Face开发的一个用于扩散模型的库,提供了Stable Diffusion等模型的预训练权重和简单易用的API。

Transformers:Hugging Face开发的一个用于自然语言处理和深度学习的库,包含了大量的预训练模型和工具,可用于文本编码和模型加载。

Accelerate:Hugging Face开发的一个用于加速深度学习模型训练和推理的库,可以自动处理多GPU和分布式训练。

7.3 相关论文著作推荐

7.3.1 经典论文

“Denoising Diffusion Probabilistic Models”:扩散模型的经典论文,介绍了扩散模型的原理和训练方法。

“Latent Diffusion Models”:潜在扩散模型的论文,提出了在低维潜在空间中进行扩散过程的方法,为Stable Diffusion的发展奠定了基础。

“CLIP: Connecting Text and Images”:CLIP模型的论文,介绍了一种用于文本和图像对齐的方法,为文本到图像生成模型提供了强大的文本编码能力。

7.3.2 最新研究成果

关注ArXiv上关于Stable Diffusion和图像生成技术的最新研究论文,了解该领域的最新发展动态。

参加相关的学术会议,如NeurIPS、ICML等,获取最新的研究成果和技术趋势。

7.3.3 应用案例分析

分析一些使用Stable Diffusion进行图像生成的实际应用案例,了解其在不同领域的应用场景和效果。可以在Hugging Face的模型库和相关的技术博客上找到这些案例。

8. 总结:未来发展趋势与挑战

8.1 未来发展趋势

8.1.1 生成质量和多样性的提升

随着技术的不断发展,Stable Diffusion等图像生成模型的生成质量和多样性将不断提升。未来的模型可能能够生成更加逼真、细节丰富的图像,并且能够支持更多样化的风格和主题。

8.1.2 与其他技术的融合

Stable Diffusion可能会与其他技术,如虚拟现实(VR)、增强现实(AR)、3D建模等进行融合,创造出更加沉浸式和互动性的体验。例如,在VR环境中,用户可以使用Stable Diffusion生成个性化的虚拟场景。

8.1.3 应用领域的拓展

Stable Diffusion的应用领域将不断拓展,除了壁纸生成、设计素材生成和艺术创作等领域,还可能应用于游戏开发、影视制作、广告营销等更多领域。

8.2 挑战

8.2.1 计算资源需求

Stable Diffusion模型通常需要大量的计算资源来运行,特别是在生成高分辨率图像时。未来需要开发更加高效的算法和硬件,以降低计算资源的需求。

8.2.2 版权和道德问题

由于Stable Diffusion生成的图像可能与现有作品存在相似性,因此可能会引发版权和道德问题。未来需要建立相应的法律和道德准则,规范图像生成技术的使用。

8.2.3 模型可控性

虽然Stable Diffusion可以根据文本描述生成图像,但在某些情况下,模型的生成结果可能无法完全符合用户的预期。未来需要提高模型的可控性,让用户能够更加精确地控制生成图像的内容和风格。

9. 附录:常见问题与解答

9.1 问题1:Stable Diffusion生成的图像版权归谁所有?

解答:目前关于Stable Diffusion生成图像的版权归属问题还没有明确的法律规定。一般来说,如果用户使用自己的文本描述生成图像,并且没有侵犯他人的版权,那么用户可能对生成的图像拥有一定的权益。但在实际应用中,建议用户在使用生成的图像时,遵循相关的法律法规和道德准则。

9.2 问题2:Stable Diffusion生成图像的速度如何?

解答:Stable Diffusion生成图像的速度取决于多个因素,如模型的大小、生成图像的分辨率、计算资源的配置等。在使用GPU的情况下,生成一张普通分辨率的图像可能需要几秒钟到几十秒钟不等。如果使用CPU,生成速度会明显变慢。

9.3 问题3:如何提高Stable Diffusion生成图像的质量?

解答:可以通过以下方法提高Stable Diffusion生成图像的质量:

使用更详细和具体的文本描述,明确图像的主题、场景、风格等信息。

选择合适的预训练模型,不同的模型在生成质量上可能会有所差异。

调整生成参数,如步数、采样方法等,找到最适合的参数组合。

9.4 问题4:Stable Diffusion可以生成动画吗?

解答:目前Stable Diffusion主要用于生成静态图像,但可以通过一些方法将生成的静态图像转换为动画。例如,可以生成一系列相关的静态图像,然后使用动画制作软件将它们组合成动画。

10. 扩展阅读 & 参考资料

10.1 扩展阅读

《AI and the Future of Art》:探讨了AI技术对艺术创作的影响和未来发展趋势。

《The Art of Generative Design》:介绍了生成式设计的原理和应用,对于理解图像生成技术在设计领域的应用有很大的帮助。

10.2 参考资料

Hugging Face官方文档:https://huggingface.co/docs

Stable Diffusion官方GitHub仓库:https://github.com/CompVis/stable-diffusion

Diffusers库官方文档:https://huggingface.co/docs/diffusers/index

暂无评论内容