AI小脑模型开发:打造智能机器人的核心控制模块

关键词:AI小脑模型、机器人控制、运动规划、强化学习、神经网络、感知-行动循环、智能决策

摘要:本文将深入探讨AI小脑模型的开发过程,这是智能机器人系统的核心控制模块。我们将从生物学小脑的启发开始,逐步构建一个完整的智能控制架构,涵盖感知处理、运动规划、实时控制和自适应学习等关键功能。通过详细的原理讲解、代码实现和实际应用案例,帮助读者理解如何打造一个能够自主学习和适应环境的智能控制系统。

背景介绍

目的和范围

本文旨在为读者提供一个全面的AI小脑模型开发指南,从基础概念到实际实现,涵盖机器人智能控制的核心技术。我们将重点讨论如何将生物学原理与人工智能技术相结合,构建一个高效、灵活的控制系统。

预期读者

本文适合对机器人技术、人工智能和控制系统感兴趣的开发者、研究人员和学生。读者需要具备基础的编程知识和机器学习概念,但我们会尽量用通俗易懂的方式解释复杂概念。

文档结构概述

文章将从生物学小脑的启发开始,逐步介绍AI小脑模型的各个组成部分,包括感知处理、运动规划、控制执行和学习机制。随后我们将通过实际代码示例展示如何实现这些功能,并讨论在实际机器人中的应用案例。

术语表

核心术语定义

AI小脑模型:受生物小脑启发的计算模型,负责机器人的运动控制和协调

感知-行动循环:机器人从环境中获取信息并做出响应的连续过程

运动原语:基本的运动单元,可以组合成复杂动作

相关概念解释

前向模型:预测行动结果的内部模型

逆模型:将期望状态转换为相应动作的模型

误差反馈:系统根据实际结果与预期差异进行的调整

缩略词列表

ANN:人工神经网络(Artificial Neural Network)

RL:强化学习(Reinforcement Learning)

PID:比例-积分-微分控制器(Proportional-Integral-Derivative)

IMU:惯性测量单元(Inertial Measurement Unit)

核心概念与联系

故事引入

想象你正在学习骑自行车。刚开始时,你会摇晃不稳,需要全神贯注地控制车把和踏板。但随着练习,这些动作变得越来越自然,最终你甚至可以在骑车时聊天或欣赏风景。这种从有意识控制到自动化执行的转变,正是我们生物小脑的奇妙功能。现在,我们要为机器人打造一个类似的”AI小脑”,让它能够学会并自动化各种复杂动作。

核心概念解释

核心概念一:生物小脑与AI小脑模型

生物小脑是我们大脑中负责协调运动和维持平衡的部分。它就像一个经验丰富的杂技演员,能够精确控制肌肉的收缩和放松,确保我们能够平稳行走、抓取物体。AI小脑模型试图在计算机中复制这种能力,让机器人能够流畅地执行各种动作。

核心概念二:感知-行动循环

这就像玩捉迷藏游戏:你听到声音(感知),判断方向(处理),然后朝那个方向移动(行动)。机器人也需要这样的循环:通过传感器获取环境信息,处理后决定如何行动,然后执行动作并观察结果。

核心概念三:运动原语

就像乐高积木一样,运动原语是构建复杂动作的基本模块。例如,机器人手臂的”伸手”、”抓握”和”收回”可以组合成完整的”拿杯子”动作。AI小脑需要学会这些基本动作并知道如何组合它们。

核心概念之间的关系

概念一和概念二的关系

生物小脑正是通过不断的感知-行动循环来学习和优化运动控制的。AI小脑模型也采用同样的策略:通过反复尝试和观察结果来改进控制策略。

概念二和概念三的关系

感知-行动循环中,机器人需要选择合适的运动原语来响应感知到的环境变化。就像在电子游戏中,不同按键组合触发不同动作,机器人也需要根据情况选择和执行适当的运动原语。

概念一和概念三的关系

生物小脑通过协调肌肉群来执行复杂动作,AI小脑则通过协调运动原语来实现类似功能。两者都是将复杂任务分解为可管理的基本单元。

核心概念原理和架构的文本示意图

传感器数据 → 感知处理 → 状态估计

↓

任务目标 ← 决策系统 → 运动规划 → 控制执行 → 执行器

↑ ↓

学习系统 ← 性能评估 ← 传感器反馈

Mermaid 流程图

核心算法原理 & 具体操作步骤

AI小脑模型的核心算法通常结合了神经网络、控制理论和强化学习。下面我们用一个Python示例展示基本的控制架构:

import numpy as np

import tensorflow as tf

from typing import List, Tuple

class AICerebellum:

def __init__(self, state_dim: int, action_dim: int):

"""初始化AI小脑模型

参数:

state_dim: 状态空间维度

action_dim: 动作空间维度

"""

self.state_dim = state_dim

self.action_dim = action_dim

# 前向模型: 预测动作结果

self.forward_model = self._build_forward_model()

# 逆模型: 根据目标状态生成动作

self.inverse_model = self._build_inverse_model()

# 反馈控制器 (PID)

self.Kp = 0.8 # 比例增益

self.Ki = 0.1 # 积分增益

self.Kd = 0.2 # 微分增益

self.prev_error = 0

self.integral = 0

def _build_forward_model(self) -> tf.keras.Model:

"""构建前向预测神经网络"""

model = tf.keras.Sequential([

tf.keras.layers.Dense(64, activation='relu', input_shape=(self.state_dim + self.action_dim,)),

tf.keras.layers.Dense(64, activation='relu'),

tf.keras.layers.Dense(self.state_dim)

])

model.compile(optimizer='adam', loss='mse')

return model

def _build_inverse_model(self) -> tf.keras.Model:

"""构建逆模型神经网络"""

model = tf.keras.Sequential([

tf.keras.layers.Dense(64, activation='relu', input_shape=(self.state_dim * 2,)),

tf.keras.layers.Dense(64, activation='relu'),

tf.keras.layers.Dense(self.action_dim)

])

model.compile(optimizer='adam', loss='mse')

return model

def plan_movement(self, current_state: np.ndarray, target_state: np.ndarray) -> np.ndarray:

"""规划从当前状态到目标状态的动作序列

参数:

current_state: 当前状态向量

target_state: 目标状态向量

返回:

动作向量

"""

# 使用逆模型生成初始动作

input_state = np.concatenate([current_state, target_state])

action = self.inverse_model.predict(input_state[np.newaxis, :])[0]

# 使用前向模型验证和调整

predicted_state = self.forward_model.predict(

np.concatenate([current_state, action])[np.newaxis, :]

)[0]

# 计算误差并调整

error = target_state - predicted_state

adjusted_action = self._adjust_action(action, error)

return adjusted_action

def _adjust_action(self, action: np.ndarray, error: np.ndarray) -> np.ndarray:

"""使用PID控制器调整动作"""

# 比例项

proportional = self.Kp * error

# 积分项

self.integral += error

integral = self.Ki * self.integral

# 微分项

derivative = self.Kd * (error - self.prev_error)

self.prev_error = error

# 组合调整

adjustment = proportional + integral + derivative

return action + adjustment

def update_models(self, states: List[np.ndarray], actions: List[np.ndarray]):

"""使用新数据更新前向和逆模型"""

# 准备前向模型训练数据

X_forward = [np.concatenate([s, a]) for s, a in zip(states[:-1], actions)]

y_forward = states[1:]

# 准备逆模型训练数据

X_inverse = [np.concatenate([s1, s2]) for s1, s2 in zip(states[:-1], states[1:])]

y_inverse = actions

# 训练模型

self.forward_model.fit(np.array(X_forward), np.array(y_forward), epochs=10, verbose=0)

self.inverse_model.fit(np.array(X_inverse), np.array(y_inverse), epochs=10, verbose=0)

数学模型和公式

AI小脑模型的核心数学原理涉及控制系统理论和机器学习。以下是关键公式:

前向模型公式:

前向模型预测下一状态 s t + 1 s_{t+1} st+1 基于当前状态 s t s_t st 和动作 a t a_t at:

s t + 1 = f ( s t , a t ) + ϵ s_{t+1} = f(s_t, a_t) + epsilon st+1=f(st,at)+ϵ

其中 f f f 是前向模型函数, ϵ epsilon ϵ 是噪声项。

逆模型公式:

逆模型计算实现状态变化 s t → s t + 1 s_t

ightarrow s_{t+1} st→st+1 所需的动作:

a t = g ( s t , s t + 1 ) a_t = g(s_t, s_{t+1}) at=g(st,st+1)

PID控制公式:

控制信号 u ( t ) u(t) u(t) 由三部分组成:

u ( t ) = K p e ( t ) + K i ∫ 0 t e ( τ ) d τ + K d d e ( t ) d t u(t) = K_p e(t) + K_i int_0^t e( au) d au + K_d frac{de(t)}{dt} u(t)=Kpe(t)+Ki∫0te(τ)dτ+Kddtde(t)

其中 e ( t ) e(t) e(t) 是误差信号, K p K_p Kp, K i K_i Ki, K d K_d Kd 是增益参数。

强化学习价值函数:

在强化学习框架下,AI小脑学习最大化预期回报:

V π ( s ) = E π [ ∑ k = 0 ∞ γ k r t + k ∣ s t = s ] V^pi(s) = mathbb{E}_pi left[ sum_{k=0}^infty gamma^k r_{t+k} | s_t = s

ight] Vπ(s)=Eπ[k=0∑∞γkrt+k∣st=s]

其中 γ gamma γ 是折扣因子, π pi π 是策略。

项目实战:代码实际案例和详细解释说明

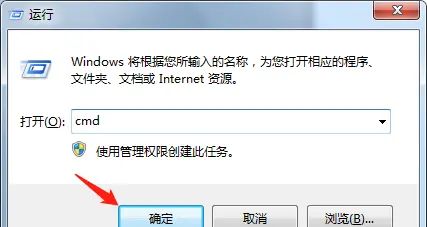

开发环境搭建

# 创建Python虚拟环境

python -m venv ai_cerebellum_env

source ai_cerebellum_env/bin/activate # Linux/Mac

ai_cerebellum_envScriptsactivate # Windows

# 安装依赖

pip install numpy tensorflow matplotlib pybullet

源代码详细实现和代码解读

我们将实现一个简单的机器人手臂控制示例:

import pybullet as p

import pybullet_data

import time

import matplotlib.pyplot as plt

class RobotArmEnv:

def __init__(self, render=False):

"""初始化机器人手臂仿真环境"""

self.physicsClient = p.connect(p.GUI if render else p.DIRECT)

p.setAdditionalSearchPath(pybullet_data.getDataPath())

p.setGravity(0, 0, -9.8)

# 加载平面和机器人

self.planeId = p.loadURDF("plane.urdf")

self.armId = p.loadURDF("kuka_iiwa/model.urdf", [0, 0, 0], useFixedBase=True)

# 设置仿真参数

self.time_step = 1./240.

p.setTimeStep(self.time_step)

# 初始化关节状态

self.num_joints = p.getNumJoints(self.armId)

self.joint_indices = [i for i in range(self.num_joints) if p.getJointInfo(self.armId, i)[2] == p.JOINT_REVOLUTE]

def get_state(self) -> np.ndarray:

"""获取当前状态"""

joint_states = p.getJointStates(self.armId, self.joint_indices)

positions = [state[0] for state in joint_states]

velocities = [state[1] for state in joint_states]

# 获取末端执行器位置

end_effector_state = p.getLinkState(self.armId, self.joint_indices[-1])

end_effector_pos = end_effector_state[0]

return np.concatenate([positions, velocities, end_effector_pos])

def apply_action(self, action: np.ndarray):

"""应用动作到机器人"""

for i, joint_idx in enumerate(self.joint_indices):

p.setJointMotorControl2(

bodyIndex=self.armId,

jointIndex=joint_idx,

controlMode=p.POSITION_CONTROL,

targetPosition=action[i],

force=500,

positionGain=0.5,

velocityGain=1.0

)

def step(self, action: np.ndarray) -> Tuple[np.ndarray, float, bool]:

"""执行一步仿真"""

self.apply_action(action)

p.stepSimulation()

time.sleep(self.time_step)

new_state = self.get_state()

# 计算奖励: 末端执行器到目标的距离

target_pos = np.array([0.5, 0.2, 0.8]) # 示例目标位置

end_effector_pos = new_state[-3:]

distance = np.linalg.norm(end_effector_pos - target_pos)

reward = -distance # 距离越小,奖励越大

done = distance < 0.05 # 当足够接近目标时结束

return new_state, reward, done

def reset(self) -> np.ndarray:

"""重置环境"""

p.resetSimulation()

self.__init__(render=False)

return self.get_state()

def close(self):

"""关闭环境"""

p.disconnect()

def train_ai_cerebellum():

"""训练AI小脑控制机器人手臂"""

env = RobotArmEnv(render=True)

state_dim = len(env.get_state())

action_dim = len(env.joint_indices)

cerebellum = AICerebellum(state_dim, action_dim)

num_episodes = 100

episode_length = 200

history = {

'rewards': [], 'distances': []}

for episode in range(num_episodes):

state = env.reset()

target_state = np.concatenate([

np.random.uniform(-1, 1, size=action_dim), # 随机目标关节位置

np.zeros(action_dim), # 零速度

np.random.uniform([-0.5, -0.5, 0.2], [0.5, 0.5, 1.0]) # 随机末端位置

])

states = [state]

actions = []

total_reward = 0

for step in range(episode_length):

# 规划动作

action = cerebellum.plan_movement(state, target_state)

# 执行动作

new_state, reward, done = env.step(action)

# 记录数据

states.append(new_state)

actions.append(action)

total_reward += reward

# 更新状态

state = new_state

if done:

break

# 更新模型

cerebellum.update_models(states, actions)

# 记录性能

final_distance = np.linalg.norm(state[-3:] - target_state[-3:])

history['rewards'].append(total_reward)

history['distances'].append(final_distance)

print(f"Episode {

episode+1}, Reward: {

total_reward:.2f}, Distance: {

final_distance:.4f}")

# 绘制学习曲线

plt.figure(figsize=(12, 5))

plt.subplot(1, 2, 1)

plt.plot(history['rewards'])

plt.title('Episode Rewards')

plt.xlabel('Episode')

plt.ylabel('Total Reward')

plt.subplot(1, 2, 2)

plt.plot(history['distances'])

plt.title('Final Distance to Target')

plt.xlabel('Episode')

plt.ylabel('Distance')

plt.tight_layout()

plt.show()

env.close()

if __name__ == "__main__":

train_ai_cerebellum()

代码解读与分析

这个实现展示了AI小脑模型在机器人手臂控制中的应用:

RobotArmEnv类:封装了PyBullet物理仿真环境,提供了机器人手臂的仿真平台。它包含:

状态获取:读取关节角度、速度和末端执行器位置

动作执行:将目标关节角度应用到机器人

奖励计算:基于末端执行器与目标的距离

训练过程:

每个回合开始时设置随机目标状态

AI小脑使用逆模型规划初始动作

使用前向模型预测结果并调整动作

执行动作后收集数据用于模型更新

学习机制:

前向模型学习状态-动作到新状态的映射

逆模型学习状态变化到所需动作的映射

PID控制器提供实时调整

可视化:

训练过程中记录奖励和最终距离

绘制学习曲线展示性能改进

实际应用场景

AI小脑模型在机器人领域有广泛应用:

工业机器人:

精确的装配和焊接操作

自适应抓取不同形状的物体

与人类协作时的安全控制

服务机器人:

家庭助手的物品抓取和递送

医院中的患者辅助和物品搬运

餐厅中的食物准备和服务

自动驾驶:

车辆在复杂环境中的精确控制

紧急情况下的避障和稳定控制

自适应不同驾驶条件和车辆特性

医疗机器人:

手术机器人的精确操作

康复辅助设备的自适应控制

假肢的自然运动控制

太空和深海探索:

极端环境下的自适应控制

通信延迟情况下的自主操作

设备故障时的容错控制

工具和资源推荐

仿真工具:

PyBullet:开源的物理仿真引擎

Gazebo:机器人仿真平台

Mujoco:高精度物理仿真

机器学习框架:

TensorFlow/PyTorch:神经网络实现

Stable Baselines3:强化学习算法实现

Ray RLlib:分布式强化学习

机器人控制库:

ROS (Robot Operating System):机器人中间件

OROCOS:实时控制库

Drake:机器人建模和控制工具

数据集:

KITTI:自动驾驶数据集

RLBench:机器人学习基准

DLR Hand Arm Dataset:机器人手臂运动数据

学习资源:

“Robotics: Modelling, Planning and Control”教科书

Coursera机器人专项课程

IEEE Robotics and Automation Letters期刊

未来发展趋势与挑战

发展趋势:

更高效的在线学习算法

多模态感知融合

分层控制架构

人机协作的适应性增强

技术挑战:

实时性与计算效率的平衡

在不确定环境中的鲁棒性

长期自主操作的安全性

从少量样本中快速学习

研究前沿:

神经形态计算在机器人控制中的应用

基于Transformer的运动规划

世界模型在机器人控制中的使用

模仿学习与强化学习的结合

伦理与社会影响:

自主决策的责任归属

隐私保护的感知系统

人机交互的安全标准

就业市场的影响评估

总结:学到了什么?

核心概念回顾:

AI小脑模型:受生物启发的机器人控制架构,负责协调和优化运动

感知-行动循环:机器人通过持续感知环境、处理信息并采取行动的闭环过程

运动原语:构建复杂动作的基本单元,可以灵活组合

概念关系回顾:

AI小脑通过感知-行动循环不断学习和优化

运动原语是AI小脑控制的基本构建块

前向模型和逆模型协同工作实现精确控制

思考题:动动小脑筋

思考题一:

如果想让机器人学会打乒乓球,AI小脑模型需要哪些额外的功能模块?如何设计训练过程?

思考题二:

在极端环境(如深海或太空)中,AI小脑模型面临哪些特殊挑战?如何增强其适应性?

思考题三:

如何设计一个AI小脑模型,使其能够同时控制机器人的多个子系统(如移动底盘和机械臂)?

附录:常见问题与解答

Q1:AI小脑模型与传统控制方法(如PID)有何不同?

A1:传统PID控制器需要精确建模和参数调整,而AI小脑模型能够通过学习适应不同任务和环境,具有更强的通用性和适应性。

Q2:训练AI小脑模型需要多少数据?

A2:这取决于任务复杂度。简单任务可能只需几百个样本,而复杂任务可能需要数百万次的交互。使用迁移学习和模拟环境可以显著减少真实世界的数据需求。

Q3:如何确保AI小脑控制的安全性?

A3:可以采用多种策略:设置动作限制、使用安全验证网络、实现人类监督机制、设计紧急停止功能等。

扩展阅读 & 参考资料

Kawato, M. (1999). “Internal models for motor control and trajectory planning”. Current Opinion in Neurobiology.

Wolpert, D.M., & Ghahramani, Z. (2000). “Computational principles of movement neuroscience”. Nature Neuroscience.

Levine, S., et al. (2016). “End-to-end training of deep visuomotor policies”. JMLR.

Lillicrap, T.P., et al. (2016). “Continuous control with deep reinforcement learning”. ICLR.

OpenAI Robotics Team (2018). “Learning Dexterous In-Hand Manipulation”. arXiv.

官方文档:

PyBullet: https://pybullet.org/

TensorFlow: https://www.tensorflow.org/

ROS: https://www.ros.org/

开源项目:

Facebook’s ReBel: https://github.com/facebookresearch/rebel

DeepMind’s Control Suite: https://github.com/deepmind/dm_control

NVIDIA’s Isaac Gym: https://developer.nvidia.com/isaac-gym

暂无评论内容