前言

MLOps挑战简介

在将机器学习(ML)从实验性研究转化为可带来商业价值的生产级应用的过程中,企业面临着巨大的复杂性。机器学习运营(MLOps)的出现正是为了应对这一挑战,它旨在将DevOps的原则应用于ML生命周期,以实现流程的自动化、标准化和可重复性。一个强大的MLOps平台对于管理从数据准备、模型训练、验证到部署、监控和再训练的整个工作流至关重要。选择正确的平台是一项关键的战略决策,它将深刻影响团队的生产力、运营成本以及技术栈的长期演进。

参评平台概览

本报告对六个业界领先的开源MLOps平台进行了详尽的分析,每个平台都代表了一种独特的理念和架构范式:

ZenML:一个灵活的抽象层框架,其核心价值在于实现ML代码与底层基础设施的解耦,从而提供极致的可移植性。

Kubeflow:一个基础性的、Kubernetes原生的MLOps工具套件,为在Kubernetes上构建自定义AI平台提供了一套可组合的构建模块。

Metaflow:一个以人为本的框架,极度已关注数据科学家的工作体验和生产力,旨在提供无缝、符合直觉的代码优先工作流。

Polyaxon:一个企业级的ML平台,专为在Kubernetes上进行可复现、大规模的实验而设计,强调严格的治理和控制。

MLRun:一个以自动化为中心的框架,建立在无服务器原则之上,旨在通过高度集成的功能(如特征存储和模型监控)实现端到端的自动化编排。

Pachyderm:一个以数据为中心的引擎,其工作流由不可变的数据版本控制和血缘驱动,彻底颠覆了传统的计算范式。

核心发现概要

本报告的核心发现揭示了开源MLOps领域的基本权衡。一方面是高度集成、意见明确的平台(如MLRun和Metaflow),它们通过内置功能和简化的工作流来优化特定用户(通常是数据科学家)的体验,但可能牺牲了一定的灵活性。另一方面是灵活、可组合的工具套件(如Kubeflow和ZenML),它们提供了更大的定制空间和工具选择自由度,但通常需要更强的工程能力来集成和维护。

其中,Pachyderm以其独特的数据优先方法论成为一个关键的差异化因素,它将数据变更视为触发计算的核心事件,这对于数据密集型和动态变化的应用场景具有革命性意义。

读者指南

本报告的结构旨在为技术决策者提供清晰的指引。报告首先对每个平台进行深入剖析(第1至6部分),详细阐述其核心理念、架构、功能、用户体验、生态系统和社区成熟度。随后,在第7部分,报告将这些深度分析综合成一个多维度的横向比较。最后,第8部分提供了一个战略决策框架,通过一系列关键问题和基于场景的建议,帮助读者根据自身组织的具体需求、技术能力和战略目标,做出明智的平台选择。

第一部分:深度解析:ZenML – 可扩展的MLOps框架

1.1 核心理念:将ML代码与基础设施解耦

中心思想

ZenML的使命是创建一个统一、可扩展的开源MLOps框架,用于构建可移植、生产就绪的MLOps流水线。其核心价值主张是充当一个抽象层,将ML工作流的逻辑代码与执行该工作流的底层基础设施完全解耦。这种理念允许数据科学家编写一次代码,然后可以在任何执行环境中运行,无论是本地开发环境还是生产级的云集群。

“编排器的编排器”

ZenML的一个基本哲学区别在于,它并非Airflow或Kubeflow等编排器的直接竞争者;相反,它是一个更高层次的框架,可以将这些工具作为其执行后端。用户使用ZenML的Pythonic接口定义一个流水线,之后可以选择在本地Docker容器中运行,或在无需修改任何代码的情况下,将其部署到由Kubeflow驱动的大规模Kubernetes集群上执行。

已关注“三大主线”

ZenML的理念围绕着MLOps生命周期的三个不同方面来组织其概念:开发、执行和管理。这种结构化的方法确保了从代码编写到生产运维的每一个环节都在其设计模型中得到充分考虑。

ZenML的哲学方法使其成为连接数据科学团队与MLOps/平台团队的战略桥梁。数据科学团队倾向于使用Python专注于模型和业务逻辑,而MLOps团队则负责管理像Kubernetes这样复杂的底层基础设施。将数据科学家的笔记本或脚本代码转化为生产就绪、容器化的工作流(例如Kubeflow流水线)是实践中一个主要的摩擦点。ZenML通过其设计直接解决了这个问题。数据科学家可以使用简单的Python装饰器(如@step和@pipeline)来定义流水线逻辑。而MLOps团队则可以配置一个“堆栈(Stack)”,指示ZenML在运行时将该Python代码动态转换为Kubeflow流水线所需的DAG(有向无环图)定义,整个过程数据科学家无需了解Kubernetes或Kubeflow的任何具体实现细节。这种已关注点分离的机制,使得组织能够采纳功能强大但复杂的后端技术(如Kubeflow),而无需对整个数据科学部门进行陡峭的学习曲线培训,从而显著降低了技术债并提升了团队的敏捷性。

1.2 架构与部署

客户端-服务器架构

ZenML采用了一个稳健的客户端-服务器架构模式。ZenML客户端是用户与系统交互的接口,而ZenML服务器(一个FastAPI应用)则作为中央枢纽,负责管理所有流水线、运行、堆栈和配置的元数据。

堆栈(Stacks)

“堆栈”是支撑ZenML可移植性的架构基石。一个“堆栈”是多个MLOps工具(即堆栈组件)的集合,它们共同定义了一个完整的执行环境。

核心组件:每个堆栈都必须包含一个编排器(Orchestrator)和一个工件存储(Artifact Store)。编排器是执行流水线中所有步骤的工作引擎(例如Kubeflow),而工件存储则负责存放流水线运行过程中产生的所有数据输入和输出(例如AWS S3)。

可扩展性:用户可以从ZenML提供的广泛集成中自由组合组件(例如,使用MLflow进行实验跟踪,使用Seldon进行模型部署)来创建自定义堆栈。ZenML甚至鼓励用户通过其基础抽象创建自己的自定义组件“风格(Flavors)”。

部署模式

ZenML提供了一系列灵活的部署选项,以满足从个人开发者到大型企业的不同需求:

本地部署:整个ZenML系统在用户的本地机器上运行,使用一个本地SQLite数据库存储元数据。这是入门和实验的理想选择。

自托管开源(OSS)版:用户可以在自己的基础设施(本地或私有云)上部署一个中央的ZenML服务器和仪表板,并使用生产级数据库(如MySQL)进行持久化存储。

ZenML Pro(SaaS/混合/自托管):这是企业级版本,增加了如基于角色的访问控制(RBAC)、单点登录(SSO)和托管控制平面等高级功能。其架构明确区分了元数据和数据工件:在SaaS模式下,流水线元数据存储在ZenML的服务器上,而所有敏感的数据工件(如模型、数据集)始终保留在客户自己的云存储中。这种混合架构对于注重数据主权和安全性的企业极具吸引力。

依赖关系

ZenML的核心依赖是一个Python环境。对于部署版本,它需要一个数据库后端(SQLite、MySQL或PostgreSQL),以及所选堆栈组件的相应依赖(例如,如果使用Kubeflow作为编排器,则需要一个可用的Kubernetes集群)。

1.3 功能分析

流水线与步骤

工作流在ZenML中通过Python代码和@pipeline、@step装饰器进行定义。这种方式为开发者提供了纯粹、代码原生的体验,易于理解和维护。

工件与模型管理

ZenML会自动对每个步骤的输入和输出进行版本控制和跟踪,并将它们作为“工件”存储在配置的工件存储中。此外,它还提供了一个一等公民的模型(Model)抽象,该抽象将训练好的模型、其不同版本以及产生它们的流水线运行关联起来,为模型治理提供了一个统一的视图。

仪表板与可观察性

ZenML的仪表板提供了流水线的可视化DAG、运行历史记录、工件可视化(包括对Pandas DataFrame等常见数据类型的自动渲染)以及日志访问功能。其Pro版本还增加了更高级的模型控制平面和实验比较工具,增强了可观察性。

密钥管理

ZenML包含一个集中的密钥存储,可以与主流云提供商的密钥管理服务(如AWS Secrets Manager、GCP Secret Manager和Azure Key Vault)无缝集成,从而安全地处理访问堆栈组件所需的凭据。

1.4 用户体验与学习曲线

对于数据科学家

ZenML的学习曲线相对平缓。其体验是高度Pythonic和熟悉的,允许数据科学家在他们偏爱的IDE和笔记本环境中工作,专注于ML逻辑本身,而不是基础设施的配置细节。

对于MLOps工程师

MLOps工程师的核心工作转变为定义和管理“堆栈”。虽然生产级堆栈的初始设置(例如,部署ZenML服务器、配置Kubeflow集群)需要基础设施专业知识,但一旦设置完成,管理流水线就变成了应用这些标准化堆栈的问题,这极大地简化了日常运维工作。

1.5 生态系统与集成

广泛的集成

ZenML的主要优势之一是其庞大且不断增长的生态系统,提供了超过50个跨所有MLOps类别的集成:编排器(Kubeflow、Airflow、Tekton)、实验跟踪器(MLflow、Weights & Biases)、数据验证工具(Great Expectations)、模型部署器等等。

集成哲学

ZenML的设计理念是成为连接各种“同类最佳”工具的“粘合剂”,而不是试图取代它们。它提供了一个标准化的接口,使不同的工具能够无缝协同工作,从而避免了供应商锁定。例如,用户只需注册一个新的堆栈,就可以轻松地将实验跟踪器从MLflow更换为Weights & Biases。

社区与成熟度

作为一个相对年轻的项目,ZenML正在迅速成长,拥有一个活跃的Slack社区和清晰的贡献路径。该项目由一家商业公司支持,该公司还提供企业支持和托管的云产品,这表明其拥有可持续的商业模式。GitHub的指标显示,其开发活动频繁,并通过各种使用ZenML的社区项目获得了积极的参与。

第二部分:深度解析:Kubeflow – Kubernetes原生的MLOps基础

2.1 核心理念:成为Kubernetes上ML的标准

中心思想

Kubeflow的使命是让在Kubernetes上部署和扩展ML工作流变得“尽可能简单”。它并非一个单一的工具,而是一个为Kubernetes生态系统构建的“工具基础”或“参考平台”。

可组合性与模块化

Kubeflow由多个松散耦合的开源项目组成(例如,Pipelines、Katib、KServe),这些项目既可以独立使用,也可以作为一套完整的解决方案进行部署。这种模块化设计允许平台团队在Kubeflow提供的构建模块之上,构建满足其特定需求的自定义AI平台。

善用Kubernetes的优势

Kubeflow的理念是让Kubernetes发挥其核心优势:实现简单、可重复、可移植的部署;管理松散耦合的微服务;以及根据需求进行弹性伸缩。Kubeflow通过添加ML特定的功能来扩展Kubernetes的能力。

2.2 架构与部署

与Kubernetes深度集成

Kubeflow的架构与Kubernetes从根本上绑定在一起。它的每个组件都通过Kubernetes自定义资源定义(CRDs)和控制器来运作。例如,一个Profile CRD用于管理多租户的用户命名空间,而一个InferenceService CRD则用于管理模型的部署。

关键架构组件

控制平面:包括中央仪表板、用于多租户管理的Profile控制器,以及认证服务(通常集成Dex和Istio)。

应用层:由核心的Kubeflow项目组成:

Kubeflow Pipelines (KFP):工作流编排引擎,其底层通常使用Argo Workflows来执行基于容器的DAG步骤。

Kubeflow Trainer:用于使用各种框架(如TensorFlow、PyTorch)进行分布式模型训练。

Katib:用于AutoML,特别是超参数调优和神经架构搜索。

KServe (前身为KFServing):一个用于大规模部署模型的无服务器推理框架.

Kubeflow Notebooks:提供在集群内部作为Pod运行的托管Jupyter笔记本服务器。

依赖关系与安装复杂性

Kubeflow的主要依赖是一个正在运行的Kubernetes集群。其安装过程以复杂著称。尽管存在一些打包好的发行版(如Charmed Kubeflow、Kubeflow on AWS)可以简化这一过程,但要建立和维护一个生产级的Kubeflow集群,仍然需要深厚的Kubernetes和DevOps专业知识。

2.3 功能分析

端到端能力

Kubeflow旨在覆盖整个ML生命周期,从在笔记本中进行交互式开发,到大规模分布式训练、自动超参数调优、流水线编排,以及可扩展的模型服务。

Kubeflow Pipelines (KFP)

这是Kubeflow一个非常强大的功能,用于定义复杂的多步骤ML工作流。流水线通过KFP SDK在Python中定义,然后编译成YAML格式,最终在集群上运行。其UI为流水线运行提供了出色的可视化、跟踪和工件管理功能。

可扩展性与性能

通过充分利用Kubernetes,Kubeflow在处理大规模分布式工作负载方面表现出色。它可以高效地管理GPU等资源,并能轻松地对作业进行水平扩展。

模型注册表

这是一个较新的组件,为管理模型版本和元数据提供了一个中心化的场所,弥合了实验与生产之间的差距。

2.4 用户体验与学习曲线

对于数据科学家

数据科学家的体验可能好坏参半。Jupyter笔记本为他们提供了一个熟悉的环境。然而,要创建流水线或定义训练作业,他们通常需要与Kubernetes的概念(如容器、YAML、资源请求)打交道,如果他们没有工程背景,这将构成一个巨大的学习曲线。可以说,这个平台讲的是“工程师的语言”。

对于MLOps工程师

对于熟悉Kubernetes的MLOps工程师来说,Kubeflow是一个强大的工具箱。它让他们能够对整个ML基础设施堆栈进行细粒度的控制。中央仪表板为管理所有组件提供了一个统一的视图。其主要挑战在于管理平台本身的运营开销。

2.5 生态系统与集成

云原生生态系统

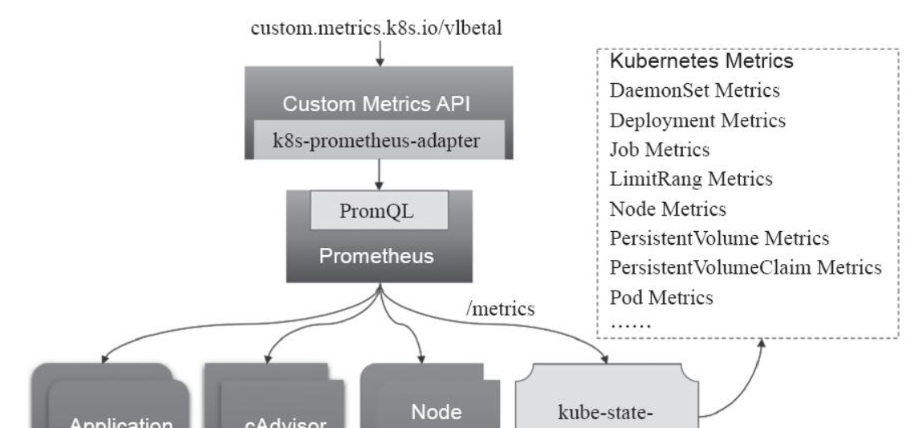

作为CNCF(云原生计算基金会)的项目,Kubeflow深度植根于云原生世界。它与其他CNCF工具(如用于服务网格的Istio和用于监控的Prometheus)集成良好。

可扩展性

其基于组件的特性使其具有很高的可扩展性。组织可以添加自己的工具,或者只使用他们需要的Kubeflow部分。它与众多其他平台(如ZenML、Union Cloud (Flyte)和Camunda)都有集成。

社区与成熟度

Kubeflow是一个成熟的项目,拥有一个由谷歌、红帽和苹果等大公司支持的庞大而活跃的社区。它有一个正式的治理结构,每个组件都有相应的工作组。GitHub的统计数据显示,其众多仓库拥有数以万计的星标和复刻,并且活动持续不断。2022年的用户调查显示了其强大的采用率,但也指出了在文档、安装和升级方面存在的挑战。

第三部分:深度解析:Metaflow – 以人为本的工作流工具

3.1 核心理念:极度已关注数据科学家的生产力

中心思想

Metaflow是一个“对人友好的Python库”,旨在通过最小化摩擦来帮助数据科学家提高生产力,使他们能够轻松地构建、部署和操作数据密集型应用。它诞生于Netflix,旨在支持各种现实生活中的ML用例,而不仅仅是那些奇特的、大规模的场景。

“用代码管理熵”

Metaflow摒弃了复杂的图形用户界面(GUI)和配置文件,坚信通用的编程语言(Python/R)是管理ML工作流固有复杂性的最有效工具。

人体工程学与易用性

其核心哲学是通过减少认知开销和避免“意外的复杂性”来优化数据科学家的生产力。工具本身应该退居幕后,让用户专注于解决他们的问题。

Metaflow的设计理念是有意为之的“意见明确”,旨在保护数据科学家的“心流状态”。Metaflow的创造者们认为,在不同工具(IDE、终端、GUI等)之间频繁切换会打断数据科学家的注意力和生产力。通过为整个基础设施堆栈(数据、计算、编排、版本控制)提供一个统一的、以代码为中心的API,Metaflow允许数据科学家在从原型到生产的整个过程中,始终停留在他们熟悉的Python/R环境中。这种设计使其成为一个“意见明确”的框架。它对于如何完成工作有强烈的偏好(例如,与AWS服务的深度集成)。这是一个深思熟虑的权衡:它牺牲了像ZenML那样的通用可插拔性,以换取在其支持的生态系统内更无缝、更集成、更符合人体工程学的体验。

3.2 架构与部署

本地优先开发

一个关键的架构原则是从本地开发到云规模执行的平滑过渡。用户首先在自己的笔记本电脑上运行一个Metaflow的“流(flow)”,所有数据都存储在本地。

扩展到云端

通过一个简单的装饰器(例如@batch),同样的代码可以在可扩展的计算后端(如AWS Batch或Kubernetes)上执行,而无需任何代码更改。

服务架构

一个完整的Metaflow部署由几个关键服务组成:

数据存储:使用云对象存储(主要是AWS S3,但也支持Azure Blob Storage和GCS)作为所有工件的内容可寻址存储。

元数据服务:一个中央服务(通常是在Fargate上运行的Docker容器,后端是Postgres数据库),用于跟踪所有执行,并通过客户端API使其可访问。

计算后端:AWS Batch或Kubernetes集群(EKS、AKS、GKE),用于提供可扩展的按需计算。

生产调度器:与生产级的编排器(如AWS Step Functions、Argo Workflows或Airflow)集成,以实现可靠的、定时的执行。

部署

对于本地使用,可以通过简单的pip install metaflow进行安装。部署完整的云堆栈通常通过Terraform或CloudFormation模板完成,大约需要15-30分钟。

3.3 功能分析

Pythonic DAGs

工作流(Flows)被定义为有向无环图(DAGs),使用简单的Python类和@step装饰器来构建。

自动版本控制

Metaflow会自动且不可变地对每一次运行的所有内容进行版本控制:代码、数据工件和依赖项。这确保了完全的可复现性。

命名空间和客户端API

所有的运行都有命名空间,防止用户相互干扰。客户端API允许以编程方式访问任何过去运行的结果,这对于调试、分析和协作非常强大。

可扩展性装饰器

简单的装饰器,如@batch(cpu=8, memory=16000)或@gpu,允许数据科学家为一个步骤请求特定的资源,从而抽象了底层计算后端的复杂性。

Metaflow Cards

这是一项用于从流水线步骤创建可视化报告(UI)的功能,有助于更好地记录和传达结果。

3.4 用户体验与学习曲线

对于数据科学家

用户体验至上。它被设计成对任何熟悉Python或R的人来说都直观易用。学习曲线主要集中在Metaflow的概念上,而不是像Docker或Kubernetes这样的底层基础设施工具。

对于MLOps工程师

MLOps工程师的角色主要是“赋能者”。他们负责云基础设施的初始设置和维护(数据存储、元数据服务、计算后端)。一旦设置完成,该平台对于数据科学家来说基本上是自助式的。

3.5 生态系统与集成

深度AWS集成

Metaflow与AWS生态系统的集成是其最成熟和经过实战检验的功能集,充分利用了S3、Batch、Step Functions和SageMaker等服务。

多云支持

它也提供了对Azure(AKS、Blob Storage)和GCP(GKE、GCS)的支持,主要通过基于Kubernetes的部署来实现。

意见明确的集成模型

与ZenML或Polyaxon相比,Metaflow不太已关注于一个广泛的可插拔集成生态系统。它提供与一组精选工具的深度、高质量集成,而不是与许多工具的浅层集成。

社区与成熟度

Metaflow最初在Netflix开发并经过实战考验,是一个非常成熟和稳定的项目。它在Slack上拥有一个庞大而活跃的社区,现在由其原始创作者成立的公司Outerbounds提供商业支持。GitHub的统计数据显示,其主仓库和相关服务拥有健康的星标和复刻数量。

第四部分:深度解析:Polyaxon – 可复现、可扩展的ML平台

4.1 核心理念:为企业级ML提供严谨性与控制力

中心思想

Polyaxon的使命是为ML应用解决可复现性、自动化和可扩展性问题,尤其适用于对严谨性和控制力有极高要求的企业或研究环境。

框架无关性

它被设计成可以与任何主流的ML框架(TensorFlow、PyTorch等)和库协同工作,为团队提供了极大的灵活性。

已关注全生命周期

Polyaxon提供了一套完整的工具来管理AI/ML实验的整个生命周期,从实验跟踪、工作流编排到模型管理和基础设施自动化。

4.2 架构与部署

Kubernetes原生的微服务

与Kubernetes类似,Polyaxon也是一个在Kubernetes上原生运行的、解耦的、面向微服务的架构。它完全依赖Kubernetes进行资源管理和调度。

核心依赖

一个Polyaxon部署有几个第三方依赖,包括一个PostgreSQL数据库、Redis和RabbitMQ。与轻量级工具相比,这增加了其运营的复杂性。

部署最佳实践

Polyaxon的文档非常强调生产就绪性,提供了关于如何为数据库设置高可用性、如何使用节点选择器将核心组件与用户工作负载分离、以及如何配置持久化存储和网络安全(SSL)的详细指南。

部署模式

Polyaxon CE (社区版):免费的开源版本。

Polyaxon EE (企业版):一个自托管的企业版本,提供SSO和RBAC等高级功能。

Polyaxon Cloud:一个完全托管的控制平面,但工作负载仍然在客户自己的集群上运行。这种模式融合了SaaS的便利性和数据的自主权,其架构与ZenML Pro的混合模式相似。

4.3 功能分析

强大的实验跟踪

这是Polyaxon的核心优势之一。它提供了一个集中的元数据存储,用于记录超参数、指标、工件、代码版本等。其仪表板提供了丰富的可视化和比较工具。

通过Polyaxonfile实现可复现性

工作流在一个名为Polyaxonfile的YAML规范中定义。这个文件打包了所有的依赖、输入、输出和运行时环境,确保任何操作都是完全可复现的。

工作流编排与自动化

Polyaxon拥有自己强大的DAG引擎,用于编排复杂的、带依赖关系、并发控制和缓存的流水线。它还可以原生集成并调度Kubeflow的组件,如TFJob和PytorchJob。

超参数优化

它包括一个内置的优化引擎,类似于Google Vizier,支持多种搜索算法(网格搜索、随机搜索、贝叶斯优化、Hyperband),用于自动化的模型调优。

模型注册表与组件中心

Polyaxon提供了用于版本化和管理已训练模型及可复用流水线组件的注册表,这极大地促进了协作和治理。

4.4 用户体验与学习曲线

目标用户画像

Polyaxon明确地为其用户体验针对不同角色进行了定制:数据科学家、团队负责人、架构师和高管。

对于数据科学家

体验的重点是“无痛的实验过程”,只需最少的基础设施工作。他们可以通过强大的CLI、SDK或全面的仪表板与平台进行交互。

对于MLOps工程师

他们可以获得对基础设施、安全性(RBAC、SSO)和资源分配(队列、调度)的细粒度控制。该平台专为需要强大治理和审计能力的架构师设计。学习曲线涉及理解Polyaxon的概念(如Polyaxonfile、组件等)以及管理其基于Kubernetes的部署。

4.5 生态系统与集成

广泛的集成目录

Polyaxon拥有最广泛且文档最完善的集成列表之一,涵盖了从数据存储(S3、GCS、Azure)、容器注册表、Git提供商到通知工具(Slack、PagerDuty)和ML工具(Jupyter、VSCode、Tensorboard、Kubeflow Operators)的方方面面。

原生Kubeflow集成

Polyaxon不仅仅是与Kubeflow协同工作,它还对其组件进行了原生集成,将这两个平台视为互补的。

社区与成熟度

Polyaxon是一个成熟的项目,稳定运行在众多初创公司和财富500强企业的生产环境中。它有清晰的贡献指南和社区渠道。该项目由一家商业实体支持,提供企业版本,确保了其长期可行性。GitHub的统计数据显示,它拥有3.7k的星标和活跃的开发活动,表明其拥有强大的追随者。

第五部分:深度解析:MLRun – 端到端MLOps自动化框架

5.1 核心理念:通过无服务器功能自动化生产之路

中心思想

MLRun是一个开源的AI编排框架,旨在自动化从数据准备到生产管理的整个应用生命周期。其关键理念是利用无服务器函数技术实现“一次编写,随处运行”的范式。

打破孤岛

它旨在为数据工程师、数据科学家和ML工程师提供一个统一的技术栈,促进代码和组件的重用与协作。

已关注GenAI/LLMOps

MLRun正大力将自己定位为生产化GenAI和LLM应用的领先框架,提供了模型定制(RAG、微调)、监控和负责任AI等功能。

5.2 架构与部署

核心概念

MLRun的架构围绕几个关键抽象构建:

项目(Project):一个用于组织ML应用所有资产(代码、函数、工作流、工件、密钥)的容器。项目可通过Git集成进行版本控制。

函数(Function):一个带有运行时属性的软件包。这是MLRun无服务器方法的核心。代码只需编写一次,MLRun便会负责将其打包成一个可扩展的无服务器函数(通常使用高性能的无服务器框架Nuclio)。

运行(Run):一个函数的执行实例,其所有元数据、输入和输出都会被自动跟踪。

集成组件

MLRun不仅仅是一个流水线编排器;它是一个更全面的平台,紧密集成了在其他生态系统中通常是独立工具的组件:

集成特征存储:一个内置的、集中的目录,用于工程化、存储、共享和提供用于训练和实时推理的特征。

实时服务流水线:利用无服务器函数构建可扩展的图,用于实时数据丰富和模型服务。

内置模型监控:提供实时监控数据、模型和资源使用的能力,并带有自动警报和再训练触发器。

部署

MLRun可以部署在任何地方——本地、多云或混合环境。它既作为一个开源项目提供,也由Iguazio提供为一个受管的企业平台。

5.3 功能分析

自动化生产化

这是MLRun的突出特点。它旨在自动化从用于训练的CI/CD到实时应用流水线部署的整个流程,且只需最少的工程“胶水代码”。

无服务器弹性

通过利用无服务器函数,MLRun可以根据需求自动扩展资源,从而优化计算成本。

端到端可观察性

可观察性是MLRun的一等公民,它能自动跟踪数据、血缘、实验和模型,并为生产应用提供内置监控。

特征存储

集成的特征存储是一个显著的差异化优势。它通过为批量训练和实时服务使用相同的转换逻辑解决了在线/离线偏差问题,并自动化了整个生命周期中的特征管理。

5.4 用户体验与学习曲线

对于数据科学家

目标是让数据科学家在他们偏爱的IDE(如Jupyter)中工作,并抽象出生产部署的复杂性。他们可以用最少的努力将代码转换成可扩展的、受管的服务。

对于MLOps工程师

MLRun提供了一个强大的编排层,自动化了许多原本需要手动完成的任务。重点是通过UI或代码定义和管理项目及流水线,而平台则负责底层的无服务器执行和扩展。

以UI为中心的管理

MLRun拥有一个全面的UI仪表板,用于管理项目、实验、工件和工作流,使其对技术性较弱的用户也易于访问。

5.5 生态系统与集成

开放和可插拔的架构

MLRun被设计为开放的,并能与其他工具集成。它可以使用Kubeflow Pipelines作为工作流引擎,也可以与外部工具(如用于跟踪的MLflow或用于训练的Databricks)集成。

监控集成

它具有一个通用的、模块化的设计,可以通过定义一个简单的Python类来与任何外部监控应用(如Evidently)集成,这对于拥有现有监控解决方案的企业来说是一个强大的功能。

社区与成熟度

MLRun是一个成熟的开源项目,最初由Iguazio(现为麦肯锡的一部分)开发和支持。这为其提供了强大的企业背景和明确的支持路径。社区拥有Slack频道和可用资源。GitHub的统计数据显示,它拥有稳固的追随者(1.6k星标)和大量的相关仓库用于演示和功能,表明其生态系统活跃。

第六部分:深度解析:Pachyderm – 以数据为中心的MLOps引擎

6.1 核心理念:数据即代码

中心思想

Pachyderm的理念与其他平台截然不同。它从根本上是以数据为中心的。流水线不是由时间表或手动命令触发,而是由数据驱动的——当输入数据发生变化时,它们会自动执行。

“数据的Git”

Pachyderm的核心是其数据版本控制系统,它为数据提供了类似Git的语义(提交、分支、回滚)。这与代码版本控制相结合,保证了端到端的可复现性和不可变的数据血缘。每一个输出结果都可以追溯到产生它的确切数据和代码版本。

数据的民主化

其目标是为数据提供一个版本控制的、集中的事实来源,允许团队安全地协作和实验,同时保持强大的治理和访问控制。

Pachyderm颠覆了传统的CI/CD范式。传统的CI/CD是以代码为中心的:代码的变更会触发构建、测试和部署流水线。而Pachyderm认为,在ML领域,数据是变革的主要驱动力。通常,需要一个新模型是因为有了新的数据或数据被重新标注。Pachyderm的架构直接模拟了这一现实。对数据仓库的一次“提交”会自动触发依赖于该数据的下游流水线阶段。这种设计使得Pachyderm在处理持续演变的数据集(例如,流式数据、持续标注)的用例中异常强大。它自动化了MLOps循环中一个在其他系统中通常是手动的关键部分。然而,这也要求习惯了以代码为中心的工作流的团队进行范式转变,这可能会影响其学习曲线。

6.2 架构与部署

Kubernetes原生基础

Pachyderm构建在Kubernetes之上,利用其实现可扩展性和并行化。

核心架构概念

Pachyderm文件系统(PFS):一个分布式的、版本控制的文件系统,它建立在对象存储(如S3)之上。数据被组织在仓库(repositories)中,变更被捕获为不可变的提交(commits)。

Pachyderm流水线(PPS):定义了要完成的“工作”。一个流水线就是一个Docker容器,它从一个或多个输入PFS仓库中读取数据,并将其输出写入相应的输出仓库。

数据单元(Datums):为了实现并行化,Pachyderm将输入数据分解成称为数据单元的原子工作单元。然后,它会启动多个工作Pod来并行处理这些数据单元。

DAGs:通过将一个流水线的输出仓库链接到另一个流水线的输入,流水线被连接成一个有向无环图(DAG)。

依赖关系

Pachyderm需要一个Kubernetes集群和一个对象存储(S3、GCS等)。它还使用etcd和PostgreSQL来管理自己的元数据。

部署

它可以部署在任何主流云平台或本地环境。交互主要通过pachctl命令行工具和Console图形用户界面进行。

6.3 功能分析

数据版本控制与血缘

这是Pachyderm的杀手级功能。它为所有数据及其转换提供了一个不可变的、可审计的记录。全局ID允许任何结果都能追溯到其确切的输入。这对于合规性、调试和可复现性至关重要。

数据驱动的自动化

流水线由新的数据提交自动触发,为数据创建了一个CI/CD系统。

增量处理

Pachyderm在计算方面非常智能。它只重新处理在提交之间发生变化的数据,这可以为大型数据集节省大量的计算时间和成本。

语言和框架无关

因为流水线只是Docker容器,所以数据科学家可以使用他们想要的任何语言、框架或库(Python、R、Spark等)。

6.4 用户体验与学习曲线

对于数据科学家

这种体验需要适应一种新的、以数据为中心的思维方式。他们不是运行一个脚本,而是向一个仓库提交数据。学习曲线涉及理解Pachyderm的概念(仓库、提交、流水线、数据单元),以及如何组织他们的代码以在容器化的流水线中工作。然而,这也使他们不必编写特定于扩展的代码,因为Pachyderm会自动处理并行化。

对于MLOps工程师

MLOps工程师的角色涉及在Kubernetes上管理Pachyderm的部署,并帮助团队定义他们的流水线规范(即YAML文件)。pachctl命令行工具是管理的主要工具。

6.5 生态系统与集成

基础数据层

Pachyderm通常被定位为MLOps堆栈的数据基础,与处理生命周期不同部分的其他工具集成,例如实验跟踪器(Comet、W&B)和模型服务器(Seldon)。

AI基础设施联盟(AIIA)

Pachyderm是AIIA的创始成员,该联盟旨在为AI创建一个规范的堆栈。这表明了其对互操作性和社区标准的承诺。

社区与成熟度

Pachyderm是一个成熟的项目,背后有商业实体提供企业版,具有RBAC和专门支持等功能。其开源社区版可在GitHub上获得。社区在Slack上很活跃,GitHub仓库显示出显著的活动(6.2k星标)。

第七部分:综合比较分析

本部分将前述的深度剖析综合成一个直接的、多维度的比较,旨在揭示六个平台之间的关键差异和权衡。

7.1 架构哲学与核心范式

这些平台可以被放置在一个抽象的光谱上进行理解。一端是Kubeflow,它本身就是基础设施——功能强大但极其复杂。中间是ZenML,它抽象了基础设施,提供了灵活性和可移植性。另一端是Metaflow,它在基础设施之上提供了高度集成且意见明确的体验,将人体工程学置于灵活性之上。

与此同时,Pachyderm和MLRun提供了完全不同的正交范式。Pachyderm是以数据为中心的,数据变更驱动计算。MLRun是以自动化为中心的,专注于无服务器函数和完全集成的端到端托管生命周期。Polyaxon则介于Kubeflow和更具意见的平台之间,它在Kubernetes上提供了一套全面的、企业就绪的工具,并特别强调可复现性和治理。

7.2 MLOps生命周期中的功能能力

对于决策者而言,快速了解哪个平台对关键功能提供原生支持,哪个依赖于集成,是至关重要的。例如,如果一个内置的特征存储是不可或缺的需求,下表能立即突出MLRun的优势。该表提供了一个高层次的“清单式”视图,为后续的定性分析奠定基础。

表1:MLOps功能矩阵

| 功能 | ZenML | Kubeflow | Metaflow | Polyaxon | MLRun | Pachyderm |

| 工作流编排 | 外部(使用其他工具作后端) | 内置(KFP/Argo) | 内置(集成Step Functions, Argo) | 内置DAG引擎 | 内置(KFP或原生) | 内置(数据驱动) |

| 实验跟踪 | 通过集成(MLflow, W&B) | 内置(KFP元数据) | 内置(客户端API) | 内置(功能强大) | 内置 | 通过集成(Comet等) |

| 模型注册表 | 内置 | 内置 | 通过外部工具 | 内置 | 内置 | 通过外部工具 |

| 特征存储 | 通过集成 | 否(需外部工具) | 否(需外部工具) | 否(需外部工具) | 内置(核心功能) | 否(PFS是数据版本控制) |

| 超参数优化 | 通过用户代码/集成 | 内置(Katib) | 通过用户代码 | 内置(优化引擎) | 内置 | 通过用户代码 |

| 模型服务 | 通过集成(Seldon, KServe) | 内置(KServe) | 通过用户代码/部署模式 | 通过集成(KFServing等) | 内置(无服务器) | 通过用户代码 |

| 数据版本控制 | 通过集成(Pachyderm, DVC) | 否(跟踪工件,非数据版本) | 否(版本化工件,非数据) | 否(版本化工件,非数据) | 内置(工件/数据) | 内置(核心功能) |

分析:

一体化 vs. 最佳组合:MLRun(拥有原生特征存储和监控)和Polyaxon(强大的跟踪和HPO)的高度集成特性与ZenML的“自带工具”哲学形成了鲜明对比。

Kubeflow的优势:Kubeflow拥有成熟的、专门用于HPO(Katib)和服务(KServe)的组件,这些在其他平台中通常是通过集成实现的。

Pachyderm的专注点:Pachyderm有意地专注于数据版本控制和流水线,期望用户集成其他工具来进行实验跟踪和服务。

7.3 部署、可扩展性与基础设施

基础设施成本和运营复杂性是任何技术领导者首要已关注的问题。下表直接比较了每个平台的基础要求和扩展模型,揭示了与每个选择相关的隐性成本和所需专业知识。

表2:架构与部署比较

| 方面 | ZenML | Kubeflow | Metaflow | Polyaxon | MLRun | Pachyderm |

| 核心范式 | 抽象层 | K8s原生工具套件 | 以人为本 | 企业级K8s套件 | 自动化/无服务器 | 以数据为中心 |

| 主要依赖 | Python, 后端堆栈 | Kubernetes | Python, AWS/K8s | Kubernetes, 数据库 | Kubernetes, Nuclio | Kubernetes |

| 部署模型 | 本地, 自托管, SaaS/混合 | 自托管, 托管发行版 | 本地, 自托管云 | 自托管, 云 | 自托管, 托管(Iguazio) | 自托管, 企业版 |

| 扩展机制 | 继承自后端编排器 | K8s水平扩展 | 垂直扩展, AWS Batch/K8s foreach |

K8s水平扩展 | 无服务器自动扩展 | K8s并行化(Datums) |

| 安装复杂性 | 低(本地)到高(堆栈) | 非常高 | 低(本地)到中(云) | 高 | 中到高 | 高 |

分析:

Kubernetes的共同点:六个平台中有五个从根本上是Kubernetes原生的,这是一个主要趋势。Metaflow是例外,它通过AWS Batch/Step Functions提供了一条强大的、非Kubernetes的路径,这对于希望避免K8s复杂性的团队很有吸引力。

扩展性哲学:Pachyderm的数据并行化(datums)与Metaflow的任务并行化(foreach)以及Kubeflow/Polyaxon的通用Pod扩展形成了对比。MLRun独特的无服务器自动扩展方法也值得已关注。

复杂性 vs. 控制力:这再次体现了权衡。Kubeflow以最高的复杂性换取了最大的控制力。Metaflow和ZenML提供了更简单的路径,但分别带有更多的意见(Metaflow)或对其他工具的依赖(ZenML)。

7.4 用户体验与目标受众

数据科学家视角

最高人体工程学:Metaflow 在此方面胜出,它极度专注于让用户停留在Python/R的代码流中。

高度灵活性:ZenML 由于其纯Python、基于装饰器的方法,也对数据科学家非常友好。

集成能力:MLRun 和 Polyaxon 提供了强大的UI和SDK,抽象了大量复杂性,但需要学习平台自身的概念。

需要范式转变:Pachyderm 和 Kubeflow 的学习曲线最陡峭。Pachyderm需要向以数据为中心的思维方式转变,而Kubeflow通常需要理解容器/K8s的概念。

MLOps工程师视角

工具箱:Kubeflow 是MLOps工程师的游乐场,提供了一套丰富的、可组合的、强大的工具来构建一个平台。

控制面板:Polyaxon 和 MLRun 为管理整个生命周期提供了更结构化、企业就绪的控制面板,并具有强大的治理能力。

集成者:ZenML 将MLOps工程师定位为“堆栈架构师”,负责定义和标准化数据科学家将要使用的工具链。

数据治理者:Pachyderm 将MLOps工程师定位为数据基础设施的治理者,确保可复现性和血缘。

7.5 项目成熟度、社区与企业可行性

在选择一个开源工具时,其长期可行性与功能同样重要。下表提供了关于项目健康状况、社区规模和商业支持可用性的量化和定性数据,这些都是衡量一个项目持久性和可靠性的关键指标。

表3:社区与成熟度记分卡

| 因素 | ZenML | Kubeflow | Metaflow | Polyaxon | MLRun | Pachyderm |

| GitHub星标 | ~2k+ (跨仓库) | ~15k+ (跨多个仓库) | ~7k+ | ~3.7k | ~1.6k | ~6.2k |

| 许可证 | Apache 2.0 | Apache 2.0 | Apache 2.0 | Apache 2.0 | Apache 2.0 | Apache 2.0 |

| 主要支持者 | ZenML GmbH | CNCF, Google, Red Hat | Netflix, Outerbounds | Polyaxon Inc. | Iguazio/McKinsey | Pachyderm Inc. |

| 社区 | 活跃、增长中的Slack | 庞大、结构化的工作组, Slack | 庞大、活跃的Slack | 活跃的社区频道 | 活跃的Slack社区 | 活跃的Slack社区 |

| 企业支持 | 是 (ZenML Pro) | 通过发行版 (AWS, Red Hat) | 是 (Outerbounds) | 是 (Polyaxon EE/Cloud) | 是 (Iguazio平台) | 是 (企业版) |

分析:

成熟度与稳定性:Kubeflow、Metaflow 和 Pachyderm 可以说是最成熟的,它们都在大型科技公司经过了多年的实战检验。Polyaxon 和 MLRun 也非常成熟且专注于企业。ZenML 是最年轻的,但增长迅速并有强大的商业支持。

社区健康状况:所有六个项目都拥有健康、活跃的社区,并有商业实体支持,这是其长期可行性的一个强烈积极信号。Kubeflow在CNCF下的治理为其提供了额外的供应商中立的稳定性。

可行性:所有六个平台都非常适合企业使用,并有明确的付费支持和高级功能路径。

第八部分:战略决策框架与建议

本部分从分析转向可操作的建议。它将提出一系列问题,帮助读者将自身需求与平台的优势相匹配。

关键决策轴

你与Kubernetes的关系是什么?(拥抱它,容忍它,还是避免它?)

你的主要用户是谁?(需要简单性的数据科学家,还是需要控制力的MLOps工程师?)

你的核心MLOps哲学是什么?(灵活性/可插拔性,集成的一体化方案,还是以数据为中心?)

你当前技术栈中最关键的缺失部分是什么?(编排、跟踪、数据版本控制,还是特征存储?)

基于场景的建议

选择Kubeflow,如果:你是一个深度投资于Kubernetes生态系统的大型组织,拥有强大的DevOps/MLOps专业知识,并且需要一个强大、可组合、可扩展的基础来构建自定义的ML平台。

选择Metaflow,如果:你的主要目标是最大化数据科学家的生产力和幸福感。你的团队重视符合人体工程学的、以代码为中心的工作流,并且你乐于接受一个意见明确的框架,尤其是在AWS生态系统内。

选择ZenML,如果:你需要一个灵活、可移植的解决方案,以弥合数据科学和MLOps之间的鸿沟。你希望使用来自不同供应商的最佳工具,并需要能够在不重写ML代码的情况下更换基础设施组件。

选择Polyaxon,如果:你是一个需要一个健壮的、端到端的平台,并对Kubernetes上的治理、可复现性以及超参数优化和多租户管理等高级功能有强烈需求的企业。

选择MLRun,如果:你专注于快速自动化和缩短产品上市时间。你需要一个一体化的解决方案,具有内置的无服务器执行、特征存储和集成监控,尤其适用于实时和GenAI应用。

选择Pachyderm,如果:你的ML工作流从根本上是由庞大且不断变化的数据集驱动的。端到端的数据血缘、可复现性和可审计性是你的绝对首要任务,并且你愿意采用以数据为中心的开发范式。

混合方法

需要强调的是,这些工具并非总是相互排斥的。例如:

使用ZenML来编排Kubeflow流水线,以简化用户体验。

在由Kubeflow或Airflow编排的流水线中,使用Pachyderm处理数据处理阶段。

将MLflow的跟踪组件与任何其他编排器一起使用。

第九部分:结论与未来展望

最终总结

本报告对六个领先的开源MLOps平台进行了全面比较。每个平台都有其独特的身份和核心权衡。Kubeflow是Kubernetes上的基础构建层;Metaflow是数据科学家的生产力引擎;ZenML是连接代码与基础设施的灵活桥梁;Polyaxon是企业级的可复现性平台;MLRun是端到端的自动化和无服务器框架;而Pachyderm则是数据驱动的、以血缘为核心的引擎。最终的选择并非寻找一个“最好”的工具,而是深入理解组织自身的文化、技能和战略重点。

新兴趋势与未来展望

LLMOps的兴起:MLRun和ZenML等平台正明确地将其能力扩展到GenAI和LLMOps领域。这是一个关键趋势,那些为微调、RAG流水线和LLM监控提供强大支持的平台将拥有优势。

抽象层 vs. 基础层之争:像ZenML这样的抽象层与像Kubernetes这样的基础平台之间的张力将继续定义市场。企业将在“易用性”和“控制力”之间寻找平衡。

以数据为中心的AI:Pachyderm的哲学正处于“以数据为中心的AI”运动的核心。随着这一运动获得更多已关注,Pachyderm的方法可能会变得越来越有影响力。

对集成体验的需求:MLRun和Metaflow等平台的成功表明,市场对能够减少认知负荷并提供无缝集成体验的工具有强烈需求,即使这意味着要接受更“意见明确”的设计。

结束语

开源MLOps领域充满活力且日趋成熟,提供了一系列强大、企业就绪的解决方案。成功的关键不在于找到一个万能的工具,而在于对组织的具体需求进行诚实评估,并选择一个最能赋能其团队、加速其创新并保障其长期成功的平台。

暂无评论内容