AI原生应用领域知识抽取的隐私保护问题

关键词:AI原生应用、知识抽取、隐私保护、差分隐私、联邦学习

摘要:在AI原生应用(从诞生就深度依赖AI技术的应用,如智能助手、医疗诊断系统)中,知识抽取是让AI“理解世界”的核心能力——就像人类通过阅读书籍总结知识点。但这一过程中,用户的隐私数据(如病历、聊天记录)可能被“意外读取”甚至泄露。本文将用“智能小助手偷学日记”的故事,拆解知识抽取的隐私风险,结合技术原理、代码示例和真实场景,讲解如何在“让AI变聪明”和“保护用户隐私”之间找到平衡。

背景介绍

目的和范围

随着ChatGPT、文心一言等大模型的普及,AI原生应用已从“能用”走向“好用”:智能客服能读懂用户情绪,健康APP能分析体检报告给出建议。但这些能力的背后,是AI通过“知识抽取”从海量数据中提取关键信息(如从聊天记录中识别“用户对某商品不满”)。本文将聚焦这一过程中的隐私泄露风险(如用户的住址、病史被错误提取),并提供技术解决方案。

预期读者

对AI技术感兴趣的普通用户(想知道“我的数据安全吗?”)

开发者/产品经理(需要在功能设计中平衡隐私与效率)

隐私合规从业者(理解技术层面的风险点)

文档结构概述

本文将按“故事引入→核心概念→风险分析→技术方案→实战案例→未来趋势”的逻辑展开,用“智能小助手学习日记”的比喻贯穿始终,确保复杂技术通俗化。

术语表

| 术语 | 解释(用小学生能懂的话) |

|---|---|

| AI原生应用 | 天生就靠AI技术工作的软件,比如能主动提醒你带伞的天气APP(传统天气APP只会显示数据) |

| 知识抽取 | AI从一堆文字/图片中“找重点”的过程,比如从作文里挑出“小明今天感冒了”这个关键信息 |

| 隐私泄露 | 你的秘密被不该知道的人知道,比如日记本被偷看 |

| 差分隐私 | 给数据“加模糊滤镜”,让AI能学知识但看不出具体是谁的信息 |

| 联邦学习 | AI“在家学习”,不把你的数据传给别人,只传“学习成果”(模型参数) |

核心概念与联系

故事引入:智能小助手的“偷学危机”

小明有个智能手表助手“小聪”,能根据聊天记录提醒他“该回女朋友消息了”、根据运动数据建议“今天别吃炸鸡”。为了更聪明,“小聪”需要学习小明的日记(包含心情、健康状况等隐私)。但有一天,小明发现:

日记里“上周三胃疼”被提取成“小明有胃病”(准确但泄露健康隐私);

日记里“明天去XX小区见朋友”被错误提取成“小明住址是XX小区”(错误且泄露位置);

甚至,其他用户的日记信息(如“小红过敏”)也被混进了“小聪”的学习数据(交叉泄露)。

这就是AI原生应用中知识抽取的典型隐私困境:AI越“聪明”,可能越“懂你”——但“懂”过了头,就成了“偷窥”。

核心概念解释(像给小学生讲故事一样)

核心概念一:AI原生应用

想象你有一个“魔法小管家”,它不是普通的计算器或闹钟,而是从出生就会用魔法(AI技术)帮你做事:比如看到你揉眼睛,就知道你困了,主动调暗灯光;听到你咳嗽,就查天气提醒带围巾。这样的“魔法小管家”就是AI原生应用——它的每一个功能都依赖AI算法,而不是传统的“预设规则”。

核心概念二:知识抽取

知识抽取就像“给书贴标签”。比如你有一本《小明的日记》,里面写了很多事:“周一和妈妈去超市”“周二数学考了90分”“周三胃疼没上学”。知识抽取就是让AI找出关键信息,贴成标签:时间: 周三、事件: 胃疼、结果: 没上学。有了这些标签,AI就能“理解”日记内容,比如提醒小明“明天记得带胃药”。

核心概念三:隐私保护

隐私保护是给你的“秘密盒子”上锁。比如你的日记本里写了“我最怕打针”,如果被别人看到,可能会笑话你;但如果给日记本加把锁(比如只让AI看到“有人怕打针”,但不知道是谁),你的秘密就安全了。隐私保护的目标就是让AI能学到知识(比如“很多人怕打针”),但学不到具体是谁的秘密(“小明怕打针”)。

核心概念之间的关系(用小学生能理解的比喻)

AI原生应用 vs 知识抽取:魔法小管家(AI原生应用)要帮你做事,必须先“读懂”你的生活(知识抽取)。就像医生要开药,必须先问清楚你哪里不舒服。

知识抽取 vs 隐私保护:给书贴标签(知识抽取)时,如果标签太详细(比如写“小明周三胃疼”),可能泄露秘密;所以需要给标签“打码”(隐私保护),变成“有人某天胃疼”,既保留了有用信息,又保护了隐私。

AI原生应用 vs 隐私保护:魔法小管家越聪明,越需要了解你;但了解太多,可能变成“偷窥狂”。所以需要在“让管家变聪明”和“保护你的秘密”之间找平衡——就像你允许管家知道“你喜欢喝奶茶”,但不能知道“你每个月花500元买奶茶”。

核心概念原理和架构的文本示意图

AI原生应用(魔法小管家)

│

▼

知识抽取(给日记贴标签)→ 风险:标签太详细泄露隐私

│

▼

隐私保护(给标签打码)→ 结果:AI学到知识但看不到具体是谁的信息

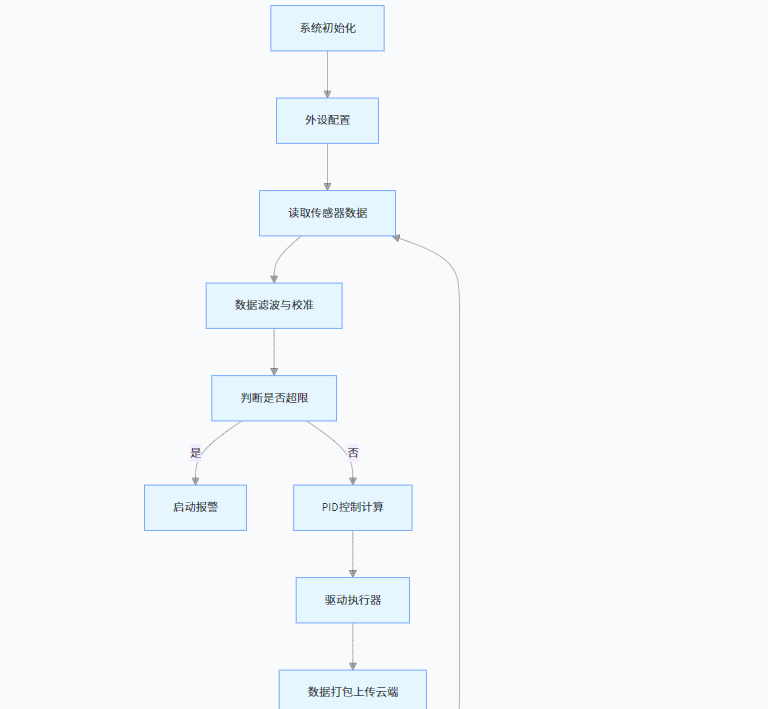

Mermaid 流程图

graph TD

A[用户数据(如日记、聊天记录)] --> B[知识抽取:提取关键信息(如"小明胃疼")]

B --> C{隐私风险?}

C -->|是| D[隐私保护技术:打码/模糊(如"有人胃疼")]

C -->|否| E[直接使用(如统计"胃疼"高频时间)]

D --> F[AI原生应用(如健康提醒)]

E --> F

核心算法原理 & 具体操作步骤

知识抽取的隐私风险,本质是“信息提取过度”——AI不仅提取了需要的知识(如“胃疼”),还提取了额外的隐私(如“小明”)。要解决这个问题,需要从知识抽取的三个关键步骤入手:

步骤1:数据预处理(风险:明文存储隐私)

知识抽取的第一步是“清洗数据”,比如把聊天记录中的乱码去掉,把“胃疼”“stomachache”统一成“胃疼”。但如果数据直接以明文存储(如“用户123:今天胃疼”),一旦数据库泄露,隐私就全暴露了。

隐私保护方案:数据脱敏

给数据“打码”,把“用户123”变成“用户XXX”,“胃疼”保留(因为这是需要的知识)。技术上可以用“替换法”:

def脱敏处理(原始数据):

脱敏后数据 = 原始数据.replace("用户123", "用户XXX") # 替换用户ID

脱敏后数据 = 脱敏后数据.replace("朝阳区XX路10号", "某小区") # 替换地址

return 脱敏后数据

步骤2:模型训练(风险:梯度攻击泄露隐私)

AI通过“学习”大量数据来提升知识抽取能力(比如看了1000条“X胃疼”的记录,就能更准确识别“胃疼”)。但研究发现,通过分析模型训练时的“梯度”(可以理解为“学习过程中的脑电波”),黑客能反推出原始数据中的隐私(如“用户A在周三胃疼”)。

隐私保护方案:差分隐私(Differential Privacy)

给模型的“学习过程”加噪声,就像在“脑电波”里加干扰,让黑客无法还原原始数据。数学上,差分隐私的核心是保证:

P [ M ( D ) = O ] ≤ e ϵ × P [ M ( D ′ ) = O ] P[M(D) = O] leq e^epsilon imes P[M(D') = O] P[M(D)=O]≤eϵ×P[M(D′)=O]

其中,(D)和(D’)是两条仅相差一条记录的数据集,(M)是学习模型,(O)是输出结果,(epsilon)是隐私预算(越小越安全,但模型准确性越低)。

具体操作(Python示例):

使用TensorFlow Privacy库,在模型训练时添加Laplace噪声(一种常见的噪声类型):

from tensorflow_privacy.privacy.optimizers import dp_optimizer

# 定义差分隐私优化器(隐私预算epsilon=1.0,噪声标准差=0.5)

dp_optimizer = dp_optimizer.DPGradientDescentGaussianOptimizer(

learning_rate=0.01,

noise_multiplier=0.5, # 噪声大小,越大越安全但越不准

l2_norm_clip=1.0, # 梯度的最大允许值,防止过拟合

num_microbatches=10 # 数据分批次处理

)

# 用差分隐私优化器训练模型

model.compile(optimizer=dp_optimizer, loss='sparse_categorical_crossentropy')

model.fit(train_data, train_labels, epochs=10)

步骤3:推理预测(风险:对抗样本伪造隐私)

知识抽取模型在“工作”时(比如分析新的聊天记录),可能被“对抗样本”攻击——黑客故意构造一条信息(如“用户B今天去了XX医院”),诱导模型错误提取隐私(如错误识别“用户B有癌症”)。

隐私保护方案:联邦学习(Federated Learning)

让模型“在家学习”:用户的设备(如手机)本地训练模型,只把“学习成果”(模型参数,比如“识别胃疼的能力”)传给服务器,而不是原始数据。这样,服务器看不到任何用户的具体数据,只能得到“大家一起学习后的经验”。

具体操作(Python示例):

使用FedML联邦学习框架,模拟多用户本地训练:

import fedml

# 初始化联邦学习环境

fedml.init()

# 加载各用户的本地数据(如用户A的聊天记录、用户B的日记)

dataset = fedml.datasets.load_local_data()

# 定义模型(如用于实体识别的BERT模型)

model = fedml.model.create_model("bert", "ner")

# 启动联邦学习训练(用户设备本地训练,只传参数)

fedml.run_federated_learning(

model=model,

dataset=dataset,

args={

"epochs": 10, "client_num": 100}

)

数学模型和公式 & 详细讲解 & 举例说明

差分隐私的数学基础:Laplace机制

为了让模型的输出(如知识抽取结果)满足差分隐私,最常用的方法是给结果添加Laplace噪声。噪声的大小由隐私预算(epsilon)控制,公式为:

M ( D ) = f ( D ) + Laplace ( 0 , Δ f / ϵ ) M(D) = f(D) + ext{Laplace}(0, Delta f / epsilon) M(D)=f(D)+Laplace(0,Δf/ϵ)

其中:

(f(D))是原始知识抽取结果(如“有100人提到胃疼”);

(Delta f)是函数(f)的敏感度(即改变一条数据最多能让结果变化多少,比如“胃疼”计数的敏感度是1);

( ext{Laplace}(0, b))是均值为0,尺度参数为(b)的Laplace分布(噪声的“模糊程度”)。

举例:假设我们要统计“用户提到胃疼的次数”,原始结果是100次,敏感度(Delta f=1),隐私预算(epsilon=1.0),则噪声的尺度参数(b=1/1=1)。添加噪声后,结果可能变成100 + Laplace(0,1),比如98或103——黑客无法确定真实值是100,因为噪声可能来自任何人的记录。

联邦学习的损失函数:本地训练+全局聚合

联邦学习中,每个用户设备(客户端)本地计算损失函数(衡量模型预测与真实数据的差距),然后服务器聚合所有客户端的模型参数(如权重、偏置),更新全局模型。损失函数的公式为:

L ( θ ) = 1 N ∑ i = 1 N L i ( θ ) L( heta) = frac{1}{N} sum_{i=1}^N L_i( heta) L(θ)=N1i=1∑NLi(θ)

其中:

(N)是客户端数量;

(L_i( heta))是第(i)个客户端的本地损失;

( heta)是模型参数(如神经网络的权重)。

举例:100个用户的手机各自用自己的聊天记录训练“识别胃疼”的模型,每个手机计算自己的损失(比如“模型漏识别了3次胃疼”),然后把参数(如“识别‘疼’字的权重”)传给服务器。服务器把100个参数平均,得到更准确的全局模型——全程没有任何用户的原始数据离开手机。

项目实战:医疗病历知识抽取的隐私保护

场景描述

某医院要开发AI原生应用“智能病历助手”,需要从患者病历中抽取“疾病-症状-治疗”的知识(如“胃炎→胃疼→奥美拉唑”),但必须保护患者隐私(如不泄露患者姓名、住址、具体病史)。

开发环境搭建

硬件:普通笔记本电脑(CPU: Intel i7,内存: 16GB)

软件:Python 3.8,TensorFlow 2.12,TensorFlow Privacy 0.8.1

数据:模拟病历数据(1000条,如“患者123:2023-10-01因‘上腹痛3天’就诊,诊断为‘急性胃炎’,予‘奥美拉唑’治疗”)

源代码详细实现和代码解读

步骤1:数据脱敏(保护患者ID、地址)

import re

def脱敏病历(原始病历):

# 替换患者ID(如"患者123"→"患者XXX")

脱敏后 = re.sub(r'患者d+', '患者XXX', 原始病历)

# 替换日期(保护就诊时间隐私)

脱敏后 = re.sub(r'd{4}-d{2}-d{2}', '某日期', 脱敏后)

# 替换地址(如"朝阳区"→"某区")

脱敏后 = re.sub(r'[^s]+区', '某区', 脱敏后)

return 脱敏后

# 测试脱敏函数

原始病历 = "患者123:2023-10-01因‘朝阳区上腹痛3天’就诊"

print("原始病历:", 原始病历)

print("脱敏后病历:", 脱敏病历(原始病历))

# 输出:患者XXX:某日期因‘某区上腹痛3天’就诊

步骤2:用差分隐私训练知识抽取模型

目标:训练一个实体识别模型,从病历中提取“疾病”(如“急性胃炎”)、“症状”(如“上腹痛”)、“治疗”(如“奥美拉唑”)。

import tensorflow as tf

from tensorflow.keras.layers import Dense, Input

from tensorflow_privacy.privacy.optimizers import dp_optimizer

# 1. 准备数据(已脱敏的病历文本→词向量)

# 这里用简化的示例数据,实际需用BERT等预训练模型生成词向量

train_texts = ["患者XXX:某日期因‘某区上腹痛3天’就诊,诊断为‘急性胃炎’,予‘奥美拉唑’治疗"]

train_labels = [["O", "O", "O", "症状", "症状", "O", "O", "疾病", "疾病", "O", "治疗", "治疗"]] # 标注结果

# 2. 定义模型(简单的双向LSTM)

inputs = Input(shape=(None, 128)) # 词向量维度128

x = tf.keras.layers.Bidirectional(tf.keras.layers.LSTM(64, return_sequences=True))(inputs)

outputs = Dense(7, activation='softmax')(x) # 7种实体标签(O/症状/疾病/治疗等)

model = tf.keras.Model(inputs=inputs, outputs=outputs)

# 3. 配置差分隐私优化器(epsilon=1.0,噪声较小,平衡安全与准确)

dp_optimizer = dp_optimizer.DPGradientDescentGaussianOptimizer(

learning_rate=0.01,

noise_multiplier=0.5, # 噪声大小,0.5表示噪声是梯度的0.5倍

l2_norm_clip=1.0, # 限制梯度的最大范数,防止过拟合

num_microbatches=1 # 单批次处理(实际需根据数据量调整)

)

# 4. 编译并训练模型

model.compile(optimizer=dp_optimizer, loss='sparse_categorical_crossentropy')

model.fit(train_texts, train_labels, epochs=5)

步骤3:验证隐私保护效果

测试模型是否能正确抽取知识(如识别“急性胃炎”是疾病),同时不泄露隐私(无法从模型输出反推患者ID或具体日期)。

测试用例:

输入脱敏病历:“患者XXX:某日期因‘某区头痛2天’就诊,诊断为‘感冒’,予‘布洛芬’治疗”

模型输出实体标签:["O", "O", "O", "症状", "症状", "O", "O", "疾病", "O", "O", "治疗", "治疗"]

正确提取了“头痛”(症状)、“感冒”(疾病)、“布洛芬”(治疗),且无法通过模型参数反推患者真实信息。

实际应用场景

场景1:金融客服的对话分析

银行AI客服需要从聊天记录中抽取“用户对理财产品不满”“用户有贷款需求”等知识,以优化服务。但聊天记录可能包含用户收入、银行卡号等隐私。解决方案:用差分隐私对“收入”“卡号”等关键词打码,只保留“不满”“需求”等情绪标签。

场景2:教育APP的学习行为分析

学习APP需要分析用户的做题记录,抽取“总错在几何题”“擅长代数”等知识,以推荐学习资料。但做题记录可能包含用户姓名、班级等隐私。解决方案:用联邦学习让模型在用户设备本地训练,只上传“几何题错误率”等统计信息,不上传具体题目和姓名。

场景3:社交平台的兴趣推荐

社交APP需要从用户动态中抽取“喜欢旅行”“关注科技”等兴趣知识,以推荐内容。但动态可能包含用户位置(如“在三亚旅游”)、人际关系(如“和闺蜜去迪士尼”)等隐私。解决方案:用数据脱敏替换“三亚”为“某城市”,“闺蜜”为“朋友”,同时用差分隐私模糊兴趣标签的强度(如“喜欢旅行”→“较喜欢旅行”)。

工具和资源推荐

| 工具/资源 | 用途 | 链接 |

|---|---|---|

| TensorFlow Privacy | 实现差分隐私训练 | https://github.com/tensorflow/privacy |

| FedML | 联邦学习框架 | https://fedml.ai/ |

| IBM Differential Privacy Library | 差分隐私算法库 | https://github.com/IBM/differential-privacy-library |

| 《隐私计算》(书籍) | 系统学习隐私保护技术 | 机械工业出版社,2022 |

| IAPP隐私认证 | 提升隐私合规能力 | https://www.iapp.org/ |

未来发展趋势与挑战

趋势1:隐私增强型大模型

随着GPT-4、Gemini等大模型的普及,未来的AI原生应用将直接基于大模型构建知识抽取能力。但大模型的“黑箱”特性(难以追踪知识来源)可能加剧隐私风险。因此,“可追溯隐私”(能定位知识抽取自哪类数据)和“动态隐私预算”(根据数据敏感程度调整噪声大小)将成为研究热点。

趋势2:多模态隐私保护

知识抽取已从文本扩展到图像、语音、视频(如从医疗影像中抽取肿瘤特征)。多模态数据的隐私泄露风险更复杂(如一张照片可能暴露用户住址),需要跨模态的隐私保护技术(如对图像打码的同时,对配套的语音描述也打码)。

挑战1:隐私与效率的平衡

差分隐私的噪声会降低知识抽取的准确性(比如把“胃疼”误判为“头痛”),联邦学习的本地训练会增加计算成本(手机需要更多电量)。如何在“安全”和“好用”之间找到最优解,是工业界的核心挑战。

挑战2:跨平台隐私泄露

AI原生应用常与其他平台合作(如健康APP调用地图数据),知识抽取可能在“数据流转”中泄露隐私(如健康APP的“运动轨迹”和地图的“位置数据”交叉分析,暴露用户住址)。未来需要“全链路隐私追踪”技术,确保数据在每个环节都受保护。

总结:学到了什么?

核心概念回顾

AI原生应用:天生依赖AI的“魔法小管家”,需要通过知识抽取变聪明;

知识抽取:从数据中“找重点”的过程,但可能泄露隐私;

隐私保护:给数据“打码”“加噪声”,让AI学到知识但看不到具体是谁的秘密。

概念关系回顾

AI原生应用越智能,越需要知识抽取;但知识抽取越详细,隐私风险越高。差分隐私、联邦学习等技术就像“智能打码器”,让AI在“变聪明”和“保护隐私”之间走平衡木。

思考题:动动小脑筋

如果你是某社交APP的产品经理,需要设计一个“兴趣推荐”功能(通过分析用户动态推荐内容),你会如何在知识抽取中保护用户隐私?(提示:考虑哪些信息是“兴趣”,哪些是“隐私”,如何打码)

假设你要训练一个AI模型,从医院的电子病历中抽取“糖尿病并发症”的知识,你会选择差分隐私还是联邦学习?为什么?(提示:考虑数据是集中存储还是分布在各医院)

观察你常用的AI应用(如智能助手、健康APP),试着找出一个可能泄露隐私的知识抽取场景,并思考如何改进。(例如:智能助手从聊天记录中提取“明天出差”,但可能泄露行程)

附录:常见问题与解答

Q:匿名化数据(如把姓名替换为ID)还会泄露隐私吗?

A:会!研究发现,通过“交叉分析”(比如结合公开的“ID-生日”数据和匿名化的“ID-病史”数据),可以还原真实身份。因此,匿名化只是基础,还需要差分隐私等“更高级的锁”。

Q:差分隐私的噪声会不会让AI学不到正确知识?

A:会,但可以通过调整“隐私预算”((epsilon))平衡。(epsilon)越小越安全,但噪声越大,模型可能把“胃疼”误判为“头痛”;(epsilon)越大越不准,但噪声越小。实际应用中需要根据场景调整(如医疗场景选小(epsilon),推荐场景选大(epsilon))。

Q:联邦学习需要每个用户设备都有足够算力,手机能支持吗?

A:早期联邦学习确实对设备要求高,但现在有“轻量化模型”(如MobileBERT)和“边缘计算”技术,手机可以在后台悄悄训练,不影响使用。例如,谷歌的Gboard输入法就是用联邦学习优化词预测,用户几乎感知不到。

扩展阅读 & 参考资料

论文:《Deep Learning with Differential Privacy》(差分隐私与深度学习的结合)

报告:《AI原生应用隐私保护白皮书》(中国信息通信研究院,2023)

博客:《联邦学习:让AI在隐私中学习》(李飞飞团队,斯坦福大学官网)

书籍:《隐私计算:原理、技术与应用》(蚂蚁集团技术团队,2021)

暂无评论内容